🥴The previous v3 version was unveiled in 2018 and the v4 is claimed to be twice as fast.

🌽TPU v4 combines in a 4096 chips sumercomputer that reaches 1 exaFLOPs (10**18) of performance

Read more on [hpcwire] and watch the video Google I/O ‘21

Size: a a a

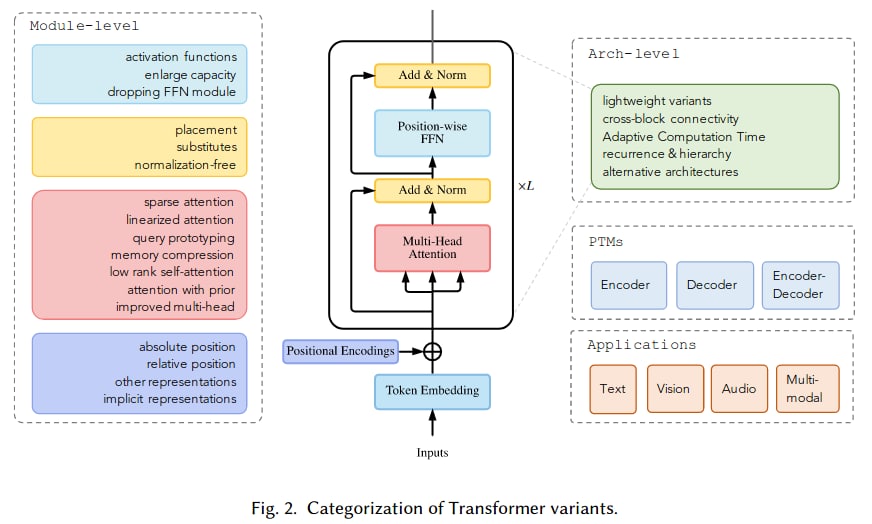

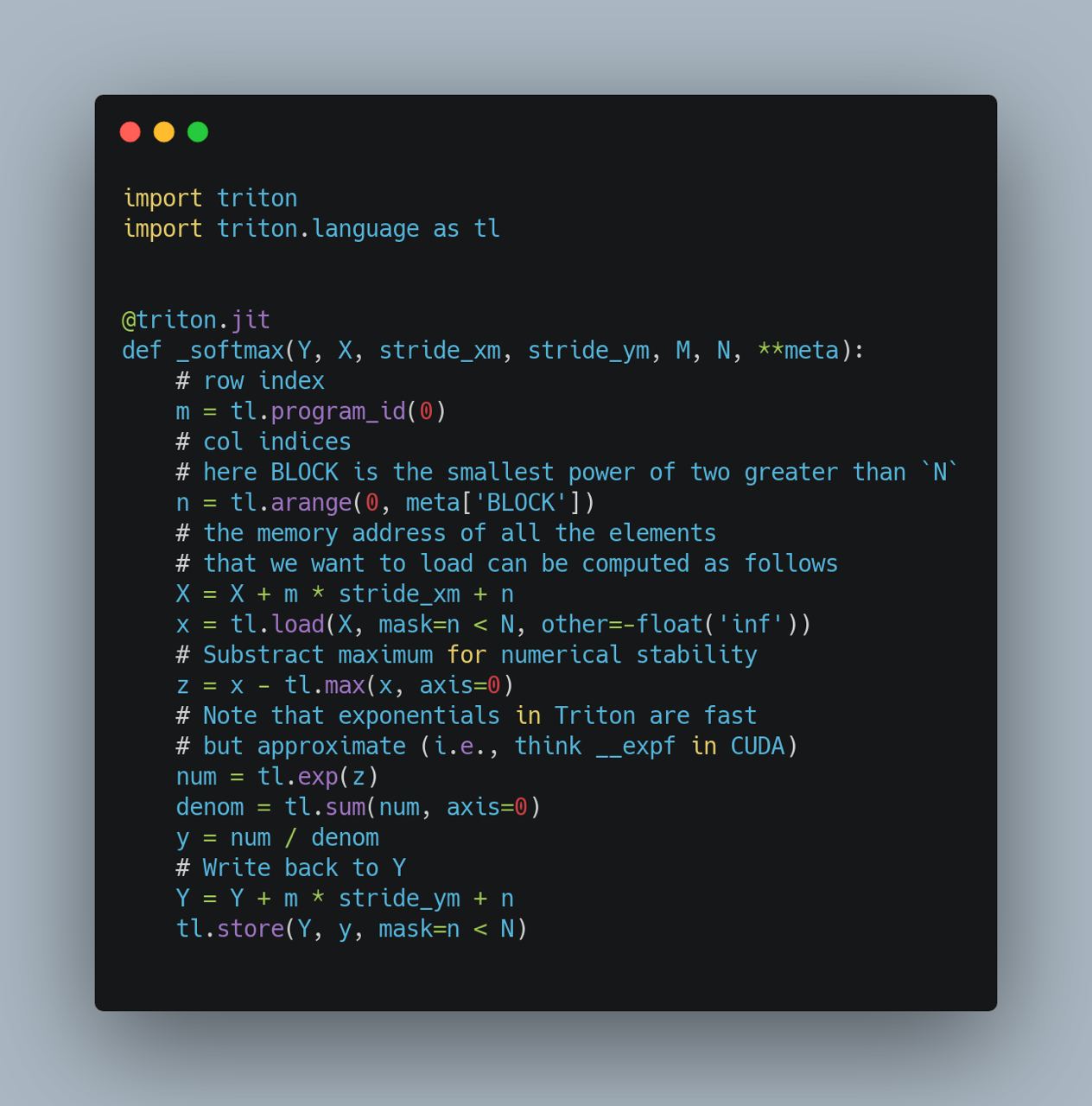

[seq_len, hidden] @ W, а тут будем применять его по пространственной [hidden, seq_len] @ W, да ещё и гейт добавим и получим GeLU(x) * [x @ W], где * — поэлементное произведение, а @ - матричное умножение по пространственной размерности seq_len.W = seq_len * seq_len, и что никакой тебе вариативной длины текста. Зафиксировали 128 (или 512) и только на такой длине и работаем.

query = W @ x, заменим его на латентные (не зависящие от инпута x) обучаемые вектора query = Q. Тогда первый слой будет потреблять seq x queries времени и памяти, а все остальные queries x queries, делая трансформер линейным по длине последовательности в первом слое и константным в остальных слоях.seq x hidden) и считают attention с ней. На выходе получаются вектора, которые можно ассоциировать с токенами, архитектура есть на картинке выше. Дальше с этими векторами можно делать то же, что мы делаем с аутпутом трансформера.