Size: a a a

2021 February 21

И ещё одно нестандартное соревнование, в котором неочевидно решение и могут выстрелить разные подходы.

Переслано от Maša Ponomareva

Привет!

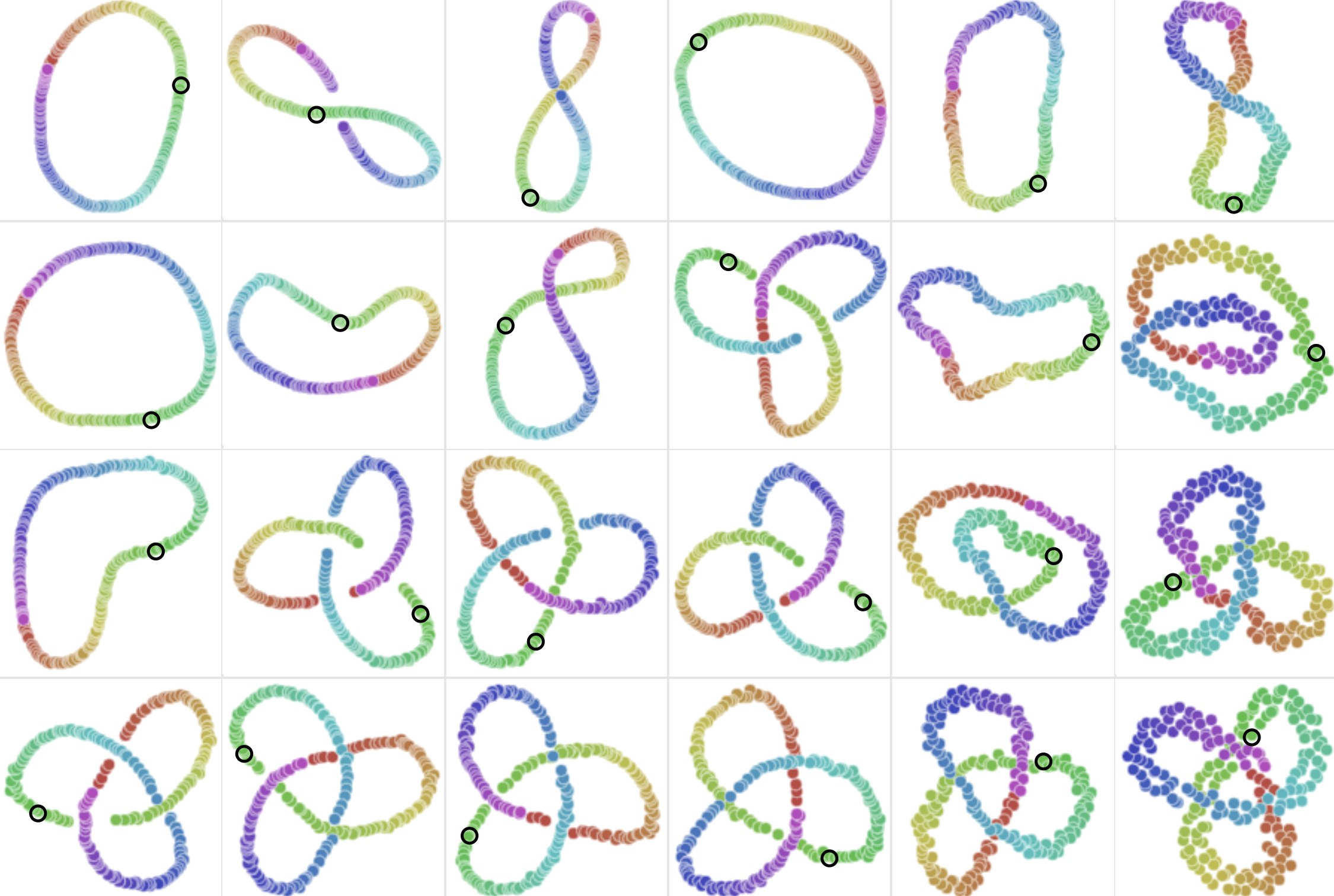

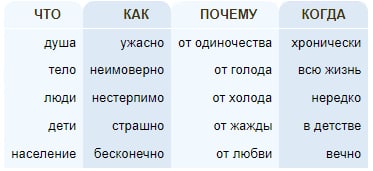

Посмотрите на картинку, на ней семантический скетч глагола. Сможете догадаться, какого? Семантический скетч отражает сочетаемость слова в корпусе, для человека хорошо построенные скетчи являются вполне репрезентативными, а так ли это для машины? Мы приглашаем вас поучаствовать в дорожке Диалога (да, их в этом году очень много), которая называется SemSketches. В рамках дорожки участникам предстоит угадывать по слову в контексте, к какому семантическому скетчу оно относится. Задача экспериментальная и новая, большая свобода для идей и интересные данные. Очень ждем участников!

Чат в телеграме

Гитхаб соревнования (подробности, данные, таймлайн там)

Посмотрите на картинку, на ней семантический скетч глагола. Сможете догадаться, какого? Семантический скетч отражает сочетаемость слова в корпусе, для человека хорошо построенные скетчи являются вполне репрезентативными, а так ли это для машины? Мы приглашаем вас поучаствовать в дорожке Диалога (да, их в этом году очень много), которая называется SemSketches. В рамках дорожки участникам предстоит угадывать по слову в контексте, к какому семантическому скетчу оно относится. Задача экспериментальная и новая, большая свобода для идей и интересные данные. Очень ждем участников!

Чат в телеграме

Гитхаб соревнования (подробности, данные, таймлайн там)

2021 February 24

Понадобилось почитать больше про UMAP – метод уменьшения размерности разработанный McInnes, Healy, and Melville в 2018. Метод уже мега популярен, вероятно наравне с T-SNE, и на это есть следующие причины:

1. Визуализации выглядят красивее, лучше баланс отображения глобальной и локальной стркутуры данных

1. Небольшое изменение гиперпараметров не так сильно изменяет результат, как в T-SNE

1. Он быстрее T-SNE в 5-10 раз

Гугловцы сделал потрясяющий интерактивный гайд с объяснением работы UMAP. Вчера залип в него на час. Работать с этой штукой тоже просто

1. Визуализации выглядят красивее, лучше баланс отображения глобальной и локальной стркутуры данных

1. Небольшое изменение гиперпараметров не так сильно изменяет результат, как в T-SNE

1. Он быстрее T-SNE в 5-10 раз

Гугловцы сделал потрясяющий интерактивный гайд с объяснением работы UMAP. Вчера залип в него на час. Работать с этой штукой тоже просто

# pip install umap-learn

mapper = umap.UMAP().fit(data)

umap.plot.points(mapper, labels=data_labels)

В честь дня рождения DeepPavlov команда проекта проводит встречу пользователей и разработчиков. В этом году, к сожалению, она пройдет в онлайн формате 5 марта 2021 года. Чтобы попасть на мероприятие, необходимо зарегистрироваться на сайте.

На нём расскажут про участие в Alexa Prize, применение Deep Pavlov для специфичного NER, последние новости из мира NLP, и о том, каким будет DeepPavlov 1.0

На нём расскажут про участие в Alexa Prize, применение Deep Pavlov для специфичного NER, последние новости из мира NLP, и о том, каким будет DeepPavlov 1.0

Похоже, что OpenAI выложил модель DALL-E https://github.com/openai/DALL-E (256px?) #AI

2021 March 01

Пару дней назад вышла статья "Do Transformer Modifications Transfer Across Implementations and Applications?"

В ней авторы попробовали реимплементировать и протестировать более чем 50 различных вариаций трансформера, начиная с простой замены функции активации и заканчивая весьма хитрыми альтернативами self-attention вроде dynamic convolutions или Synthesize.

Короткий ответ на их вопрос: нет, почти все модификации трансформера работают хуже, чем классический трансформер, либо улучшают его результаты лишь на нескольких задачах. В качестве задач авторы использовали машинный первод, SuperGLUE, XSum и WebQuestions, где для последних трёх сперва предобучалась BERT-base-sized версия T5. Интересно, что самыми большими и стабильными по всем задачам улучшениями была замена ReLU на другие функции активации. Отлично себя показала SwiGLU и другие гейтированные активации.

А если вы из тех людей, которые любят просматривать презентации вместо чтения статьи, можете посмотреть на вот эту.

В ней авторы попробовали реимплементировать и протестировать более чем 50 различных вариаций трансформера, начиная с простой замены функции активации и заканчивая весьма хитрыми альтернативами self-attention вроде dynamic convolutions или Synthesize.

Короткий ответ на их вопрос: нет, почти все модификации трансформера работают хуже, чем классический трансформер, либо улучшают его результаты лишь на нескольких задачах. В качестве задач авторы использовали машинный первод, SuperGLUE, XSum и WebQuestions, где для последних трёх сперва предобучалась BERT-base-sized версия T5. Интересно, что самыми большими и стабильными по всем задачам улучшениями была замена ReLU на другие функции активации. Отлично себя показала SwiGLU и другие гейтированные активации.

А если вы из тех людей, которые любят просматривать презентации вместо чтения статьи, можете посмотреть на вот эту.

2021 March 02

Нашёл запись клабхауса с Карпатым, Фридманом и Сохером

Recent Breakthroughs in AI

Несмотря на то, что в названии есть слово "AI", они обсуждают много интересных вещей и технических деталей. Поговорили про CLIP, приход трансформеров в CV и другие штуки. Рекомендую к прослушиванию.

Recent Breakthroughs in AI

Несмотря на то, что в названии есть слово "AI", они обсуждают много интересных вещей и технических деталей. Поговорили про CLIP, приход трансформеров в CV и другие штуки. Рекомендую к прослушиванию.

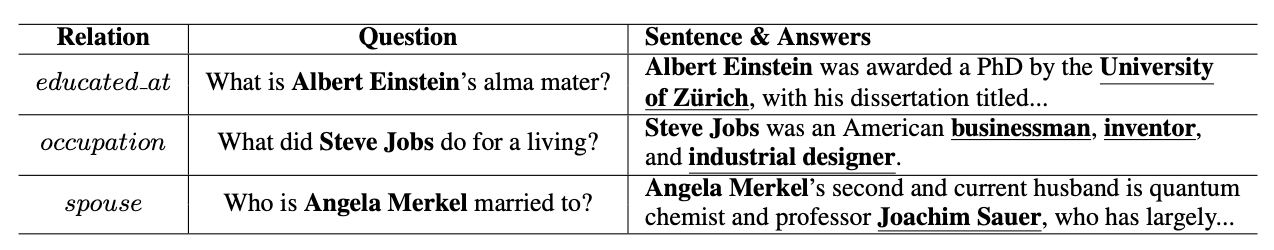

Zero-Shot Relation Extraction via Reading Comprehension

Levy et al, [University of Washington]

arxiv.org/abs/1706.04115

Простая идея: давайте переформулируем задачу relation extraction как вопросно-ответную систему. Зачем? Это позволит делать zero-shot, то есть работать с новыми отношениями/объектами, которых не было в тренировочном сете. Авторы так же собрали новый датасет под эту задачу с помощью wikidata и разметчиков, формулирующих вопросы. В результате на zero-shot модель показала F1 порядка 0.9 для новых объектов и порядка 0.3-0.4 для новых отношений. Также в статье есть отдельные главы с анализом работы и ошибок модели. Советую почитать, если у вас есть релевантные задачи.

Кстати их датасет доступен по этой ссылке: http://nlp.cs.washington.edu/zeroshot

Levy et al, [University of Washington]

arxiv.org/abs/1706.04115

Простая идея: давайте переформулируем задачу relation extraction как вопросно-ответную систему. Зачем? Это позволит делать zero-shot, то есть работать с новыми отношениями/объектами, которых не было в тренировочном сете. Авторы так же собрали новый датасет под эту задачу с помощью wikidata и разметчиков, формулирующих вопросы. В результате на zero-shot модель показала F1 порядка 0.9 для новых объектов и порядка 0.3-0.4 для новых отношений. Также в статье есть отдельные главы с анализом работы и ошибок модели. Советую почитать, если у вас есть релевантные задачи.

Кстати их датасет доступен по этой ссылке: http://nlp.cs.washington.edu/zeroshot

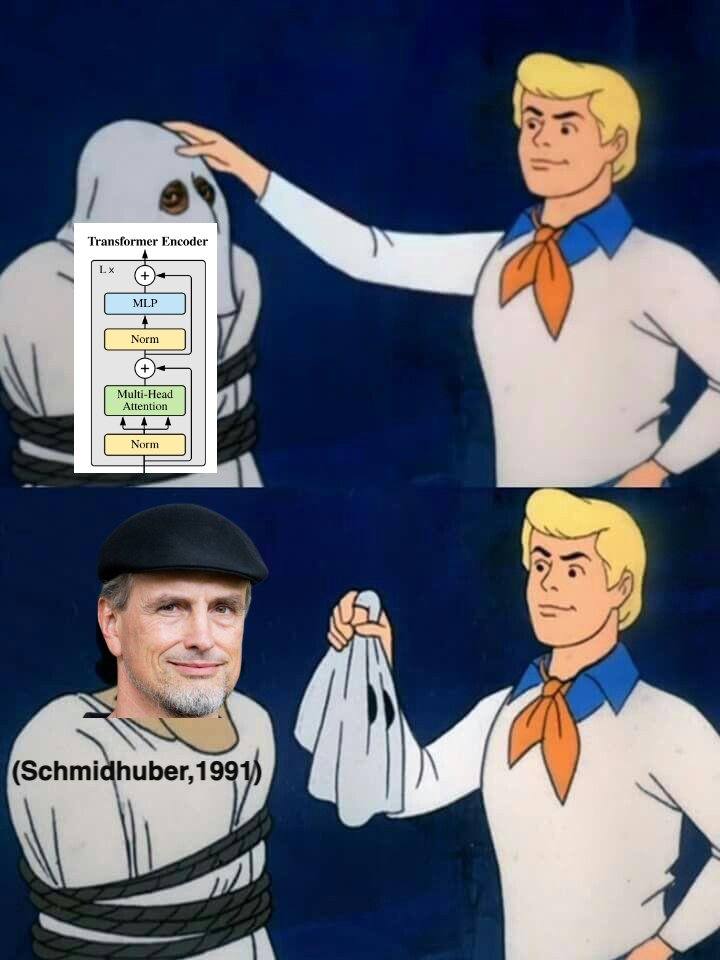

Правило номер 11: всё, что придумано в DL, было изначально придумано Шмитхубером в 90е

twitter.com/arankomatsuzaki/status/1364035225357983746

twitter.com/arankomatsuzaki/status/1364035225357983746

2021 March 05

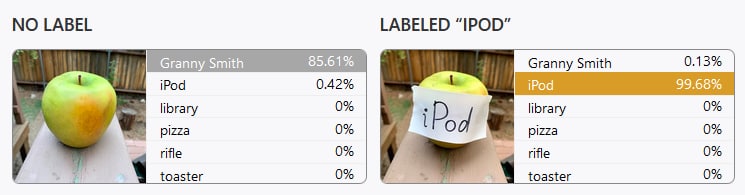

https://distill.pub/2021/multimodal-neurons/

Крутая статья про CLIP от OpenAI. Типографические атаки - это очень смешно.

Крутая статья про CLIP от OpenAI. Типографические атаки - это очень смешно.

2021 March 09

Опять про тестирование кода. Каждый раз, когда вы пишете тест, вы из будущего благодарите себя. И вот ещё наткнулся на статью по тестированию именно в ML.

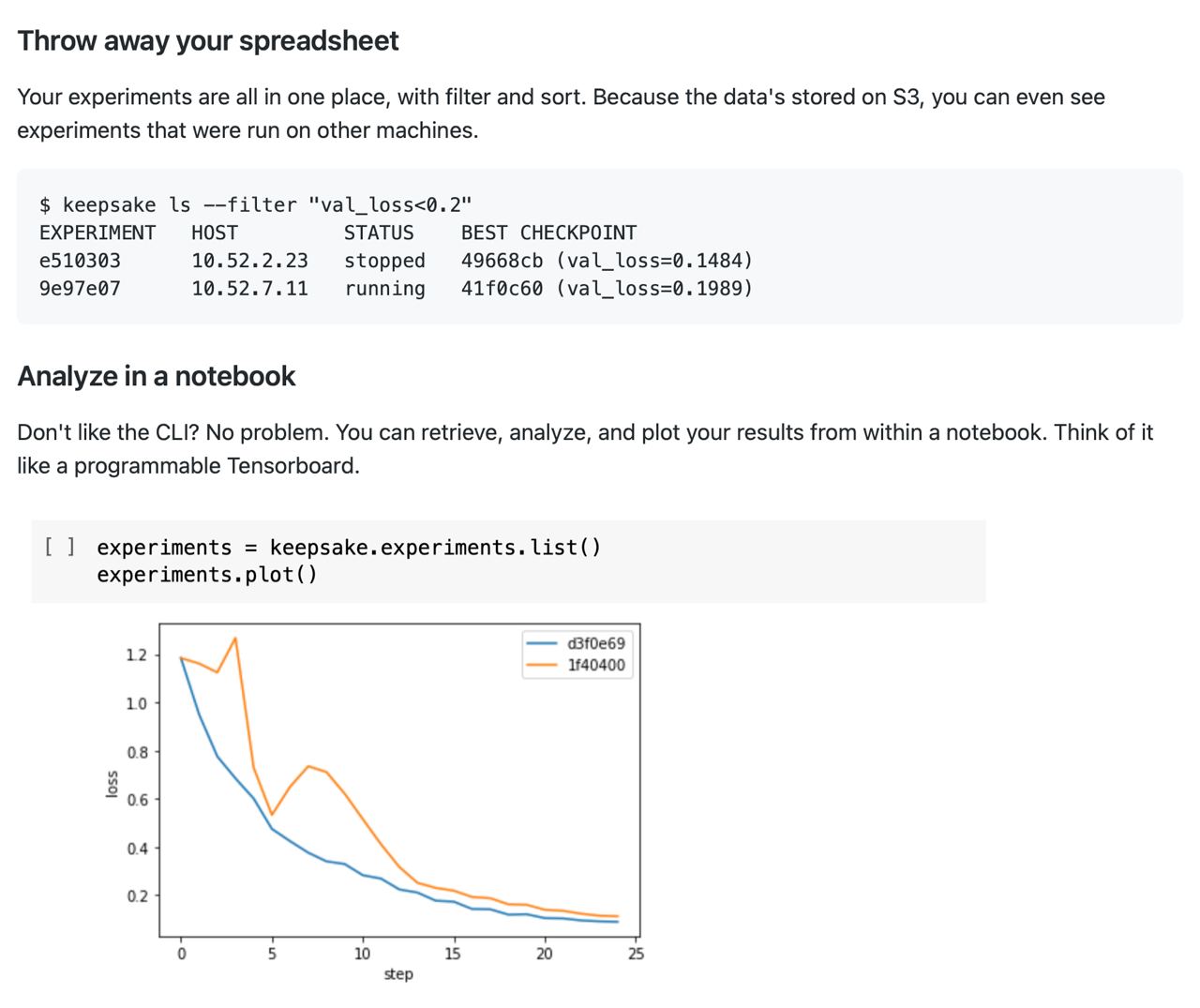

Интересный заход на логирование эксперментов: keepsake.ai

Opensource и хранит всё на вашем S3 в простом и читаемом формате. Позволяют сохранять произвольные файлы, но в основном ориентируются на код и веса моделек. Также можно логированить метрики, но хз насколько это полезно без UI, а-ля wandb. Они называют себя version control for machine learning и позволяют восстанавливать старые версии экспериментов (код + веса). Достаточно ли это, чтобы называться version control? Наверное нет, но интересно, куда проект пойдёт дальше.

Opensource и хранит всё на вашем S3 в простом и читаемом формате. Позволяют сохранять произвольные файлы, но в основном ориентируются на код и веса моделек. Также можно логированить метрики, но хз насколько это полезно без UI, а-ля wandb. Они называют себя version control for machine learning и позволяют восстанавливать старые версии экспериментов (код + веса). Достаточно ли это, чтобы называться version control? Наверное нет, но интересно, куда проект пойдёт дальше.

2021 March 10

🔥 Deep Learning Deep Dive

Подкаст Andrej Karpathy (Sr. Director of AI, Tesla) и Justin Johnson (University of Michigan), что уже классно. В эпизоде#3 также приглашены авторы статьи DALL-E. Andrej и Justin закапываются в очень тонкие детали, связанные с формулированием dVAE, с особенностями тренировки итд. По какой-то причине я не очень люлю английские подскасты, тк они мне кажутся очень сухими, но в этот прямо залип.

Пока что есть только два выпуска (episode#2 и episode#3 🤦♂️) и оба из них про DALL-E. Надеюсь (но не верю), что подкаст не забросят и у него будут регулярно выходить новые эпизоды.

Apple Podcasts: https://podcasts.apple.com/us/podcast/deep-learning-deep-dive/id1555309024

YouTube: https://youtu.be/PtdpWC7Sr98

Подкаст Andrej Karpathy (Sr. Director of AI, Tesla) и Justin Johnson (University of Michigan), что уже классно. В эпизоде#3 также приглашены авторы статьи DALL-E. Andrej и Justin закапываются в очень тонкие детали, связанные с формулированием dVAE, с особенностями тренировки итд. По какой-то причине я не очень люлю английские подскасты, тк они мне кажутся очень сухими, но в этот прямо залип.

Пока что есть только два выпуска (episode#2 и episode#3 🤦♂️) и оба из них про DALL-E. Надеюсь (но не верю), что подкаст не забросят и у него будут регулярно выходить новые эпизоды.

Apple Podcasts: https://podcasts.apple.com/us/podcast/deep-learning-deep-dive/id1555309024

YouTube: https://youtu.be/PtdpWC7Sr98

2021 March 11

Очень советую GSoC. Хороший способ прокачать свои скилы и резюме, при этом помочь коммьюнити. А ещё вроде бы гугл неплохо это оплачивает.

Всем привет😃

DeepPavlov выбрали в качестве наставнической организации Google Summer of Code for Summer 2021 🔥

GSoC – это международная программа для студентов старше 18 лет, позволяющая участвовать в работе над открытыми проектами. В этом году студенты в течение 10 недель (с 7 июня по 16 августа) могут оттачивать навыки программирования под присмотром наставников-волонтеров из DeepPavlov и получать стипендию от Google.

Посмотреть задачи и связаться с нами можно тут:

http://bit.ly/DPGSoC2021

Обратите внимание на требования к участию:

https://developers.google.com/open-source/gsoc/faq#students

В скором времени опубликуем полные требования по подаче заявки 🤗

DeepPavlov выбрали в качестве наставнической организации Google Summer of Code for Summer 2021 🔥

GSoC – это международная программа для студентов старше 18 лет, позволяющая участвовать в работе над открытыми проектами. В этом году студенты в течение 10 недель (с 7 июня по 16 августа) могут оттачивать навыки программирования под присмотром наставников-волонтеров из DeepPavlov и получать стипендию от Google.

Посмотреть задачи и связаться с нами можно тут:

http://bit.ly/DPGSoC2021

Обратите внимание на требования к участию:

https://developers.google.com/open-source/gsoc/faq#students

В скором времени опубликуем полные требования по подаче заявки 🤗

2021 March 15

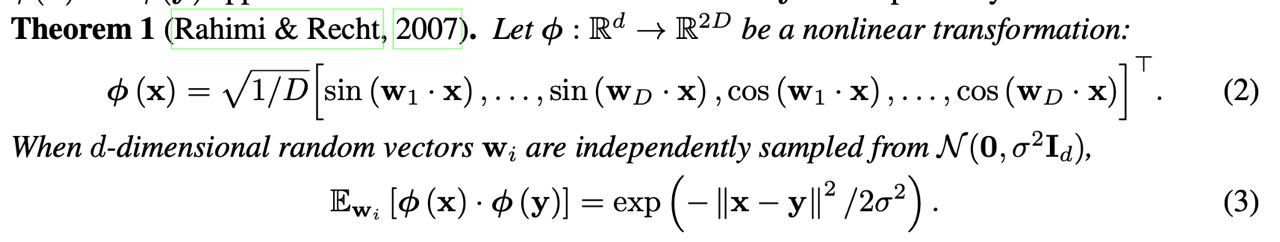

Random Feature Attention

Peng et al. [DeepMind]

arxiv.org/abs/2103.02143

Ещё одна статья про линеаризацию attention. Основная идея, использовать математический трюк, что случайная функция f(x)*f(y) определённого вида выдаёт нам в среднем exp(-||x - y||^2 / sigma).

Дальше под эту формулу подгоняется attention и у авторов получается избавиться от недиагональных элементом матрицы attention. Математика довольно простая, рекомендую посмотреть в статье.

По-результатам: показывают сравнимое с BigBird качество при более высокой скорости на классификации длинного текста и на машинном переводе.

Peng et al. [DeepMind]

arxiv.org/abs/2103.02143

Ещё одна статья про линеаризацию attention. Основная идея, использовать математический трюк, что случайная функция f(x)*f(y) определённого вида выдаёт нам в среднем exp(-||x - y||^2 / sigma).

Дальше под эту формулу подгоняется attention и у авторов получается избавиться от недиагональных элементом матрицы attention. Математика довольно простая, рекомендую посмотреть в статье.

По-результатам: показывают сравнимое с BigBird качество при более высокой скорости на классификации длинного текста и на машинном переводе.