Size: a a a

2020 October 05

2020 October 08

Посмотрел в свои сохранённые сообщения и оказалось, что есть много интересного. Поэтому одной стокой.

NLP:

1. The ultimate guide to encoder-decoder models (part1, part2, part3, part4)

1. Миникурс по вариационному выводу в NLP от Wilker Aziz

1. Long Range Arena : A Benchmark for Efficient Transformers - статья, где сравнивают между собой длинные трансформеры (спойлер: используйте Big Bird если не важна скорость и Performer если важна, не используйте Reformer вообще)

1. Nearest Neighbor Machine Translation - +2 BLEU почти бесплатно к вашей уже натренированной модели. Вы предварительно создаёте базу переводов (на основе вашего тренировочного сета) и примешиваете её хиддены к своим во время инференса.

1. RL + NLP + текстовые игры = ❤️, в статье учили бота, обусловленного некой мотивацией, заданной описанием персоны, проходить квесты

1. Multi-Modal Open-Domain Dialogue - статья от группы Jason Weston в FAIR в которой фьюзят огромные языковые модели и Faster R-CNN. Очень подробно описано как тестировали модель, что очень сложно в диалоговых задачах.

not NLP:

1. Вышла новая версия курса по RL от Thomas Simonini, теперь есть более весёлые environment'ы на Unity и UE4

1. Как делать ограничения на параметры в вашей моделе на торче (вдруг вы заходите, чтобы ваши матрицы были строго положительными). Чтение поста гарантирует улучшение вашего скила на pytorch (или нет)

1. An Image is Worth 16x16 Words - Полностью трансформерная сетка для computer vision (совсем без свёрток), которая не только работает лучше, но и тренируется в 5 раз быстрее

NLP:

1. The ultimate guide to encoder-decoder models (part1, part2, part3, part4)

1. Миникурс по вариационному выводу в NLP от Wilker Aziz

1. Long Range Arena : A Benchmark for Efficient Transformers - статья, где сравнивают между собой длинные трансформеры (спойлер: используйте Big Bird если не важна скорость и Performer если важна, не используйте Reformer вообще)

1. Nearest Neighbor Machine Translation - +2 BLEU почти бесплатно к вашей уже натренированной модели. Вы предварительно создаёте базу переводов (на основе вашего тренировочного сета) и примешиваете её хиддены к своим во время инференса.

1. RL + NLP + текстовые игры = ❤️, в статье учили бота, обусловленного некой мотивацией, заданной описанием персоны, проходить квесты

1. Multi-Modal Open-Domain Dialogue - статья от группы Jason Weston в FAIR в которой фьюзят огромные языковые модели и Faster R-CNN. Очень подробно описано как тестировали модель, что очень сложно в диалоговых задачах.

not NLP:

1. Вышла новая версия курса по RL от Thomas Simonini, теперь есть более весёлые environment'ы на Unity и UE4

1. Как делать ограничения на параметры в вашей моделе на торче (вдруг вы заходите, чтобы ваши матрицы были строго положительными). Чтение поста гарантирует улучшение вашего скила на pytorch (или нет)

1. An Image is Worth 16x16 Words - Полностью трансформерная сетка для computer vision (совсем без свёрток), которая не только работает лучше, но и тренируется в 5 раз быстрее

2020 October 11

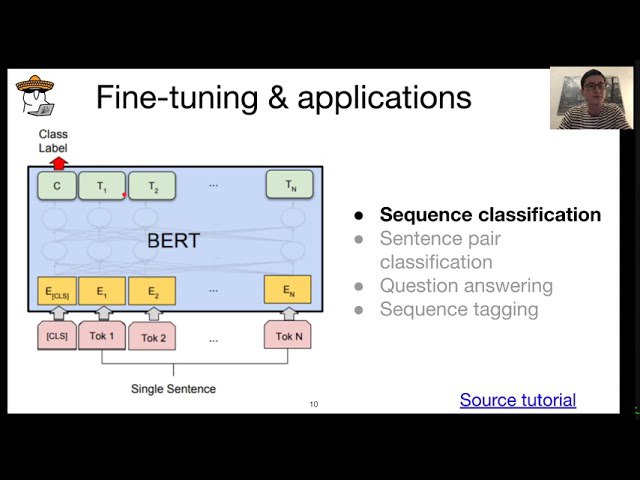

Хороший и объемный туториал по файнтюнингу моделек в NLP.

• Loading data, single or multiple files, csv, txt or dataframes, train/test splits

• Processing data with 11 text processing functions

• Tokenizing data for use with MobileBERT

• Saving processed data to disk

• Datasets tips and tricks along the way

Comprehensive Language Model Fine Tuning

• Loading data, single or multiple files, csv, txt or dataframes, train/test splits

• Processing data with 11 text processing functions

• Tokenizing data for use with MobileBERT

• Saving processed data to disk

• Datasets tips and tricks along the way

Comprehensive Language Model Fine Tuning

2020 October 14

Firing a cannon at sparrows: BERT vs. logreg (DataFest 2020)

Презентация от Юры Кашницкого по BERT и тому как использовать его с Catalyst. А так же о том, что логрег всё ещё тащит для простых задач классификации.

Презентация от Юры Кашницкого по BERT и тому как использовать его с Catalyst. А так же о том, что логрег всё ещё тащит для простых задач классификации.

Рубрика «Читаем статьи за вас». Июль — август 2020 года

Статьи из подборки:

1 High-Resolution Neural Face Swapping for Visual Effects

2. Beyond Accuracy: Behavioral Testing of NLP Models with CheckList

3. Thieves on Sesame Street! Model Extraction of BERT-based APIs

4. Time-Aware User Embeddings as a Service

5. Are Labels Necessary for Neural Architecture Search?

6. GShard: Scaling Giant Models with Conditional Computation and Automatic Sharding

7. Data Shapley: Equitable Valuation of Data for Machine Learning

8. Language-agnostic BERT Sentence Embedding

9. Self-Supervised Learning for Large-Scale Unsupervised Image Clustering

10. Batch-Channel Normalization and Weight Standardization

Статьи из подборки:

1 High-Resolution Neural Face Swapping for Visual Effects

2. Beyond Accuracy: Behavioral Testing of NLP Models with CheckList

3. Thieves on Sesame Street! Model Extraction of BERT-based APIs

4. Time-Aware User Embeddings as a Service

5. Are Labels Necessary for Neural Architecture Search?

6. GShard: Scaling Giant Models with Conditional Computation and Automatic Sharding

7. Data Shapley: Equitable Valuation of Data for Machine Learning

8. Language-agnostic BERT Sentence Embedding

9. Self-Supervised Learning for Large-Scale Unsupervised Image Clustering

10. Batch-Channel Normalization and Weight Standardization

2020 October 15

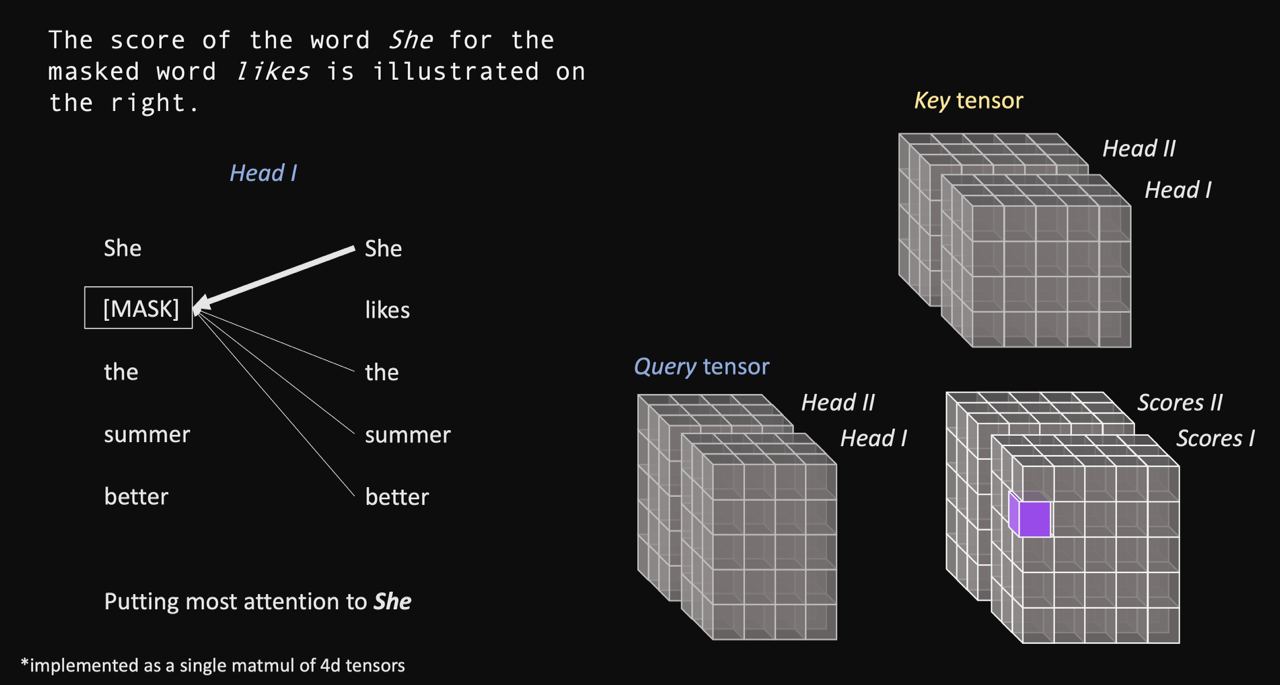

Возможно, лучшая визуализация того, как работает трансформер. Во всех примерах визуализировано в том числе и батч-измерение. И ноутбучек прилагается.

https://github.com/mertensu/transformer-tutorial

https://github.com/mertensu/transformer-tutorial

2020 October 17

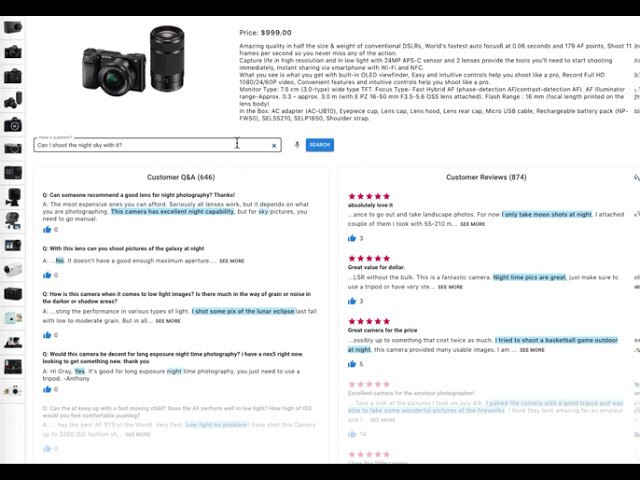

QA модельки очень интересные, и классно, что они всё больше просачиваются в реальную жизнь. @sparakhin рассказывает как они разрабатывали такую модель для магазина фотовидеотехники. Собирание датасета, USE, берты, дисстиляция - всё как вы любите. Думаю если будут вопросы, можете даже поспрашивать автора в нашем чате.

Его словами про пост:

"Мы тут рассказываем про то, как применяли QA (MRC) модельки для своего домена — photo & video cameras online store. Рассказываем немного про модельку, как размечали данные, файнтюнили, и ускоряли (деталей возможно не так много как хотелось бы, так как статья в корпоративном блоге).

Возможно что-то будет интересно, например, как мы использовали knowledge distillation для неразмеченных данных + в конце полезные ссылки по теме."

https://blog.griddynamics.com/question-answering-system-using-bert

Его словами про пост:

"Мы тут рассказываем про то, как применяли QA (MRC) модельки для своего домена — photo & video cameras online store. Рассказываем немного про модельку, как размечали данные, файнтюнили, и ускоряли (деталей возможно не так много как хотелось бы, так как статья в корпоративном блоге).

Возможно что-то будет интересно, например, как мы использовали knowledge distillation для неразмеченных данных + в конце полезные ссылки по теме."

https://blog.griddynamics.com/question-answering-system-using-bert

2020 October 20

Is it possible for language models to achieve language understanding? My current answer is, essentially, “Well, we don’t currently have compelling reasons to think they can’t.”

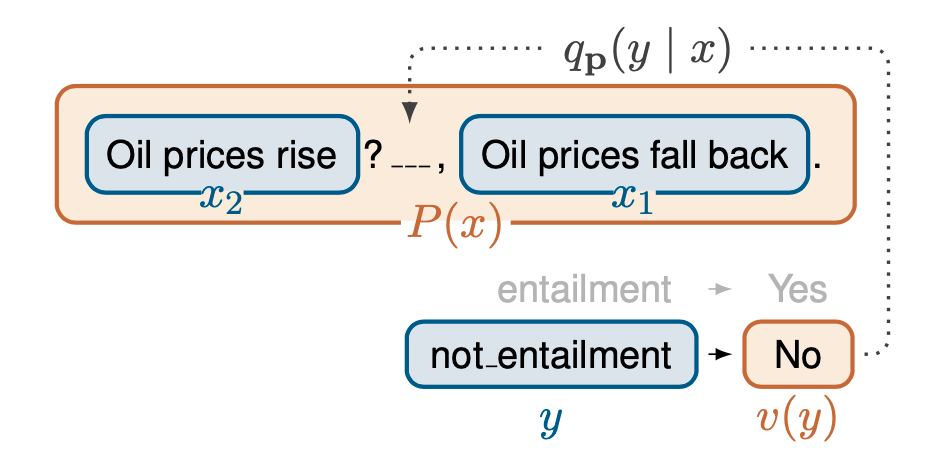

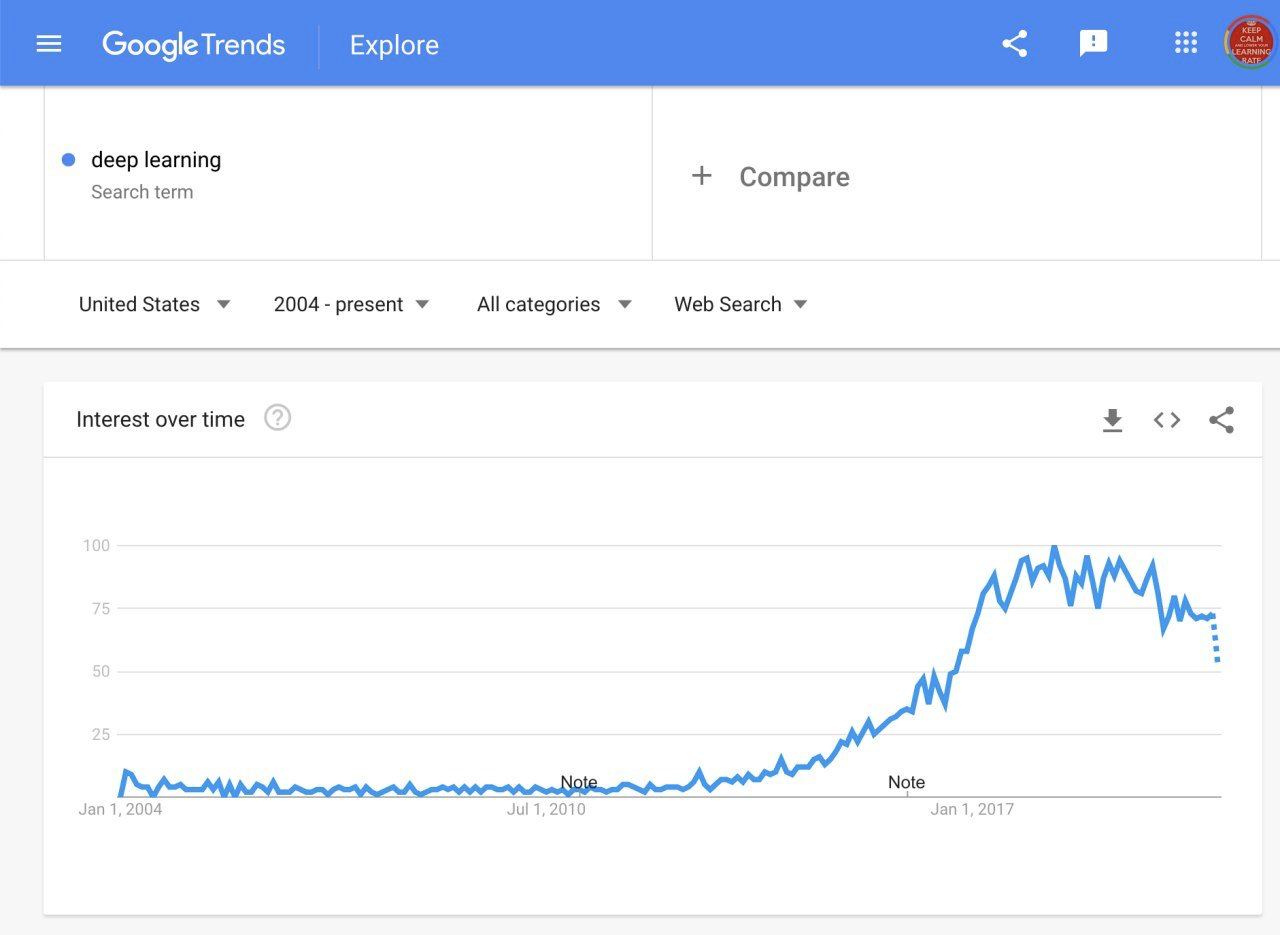

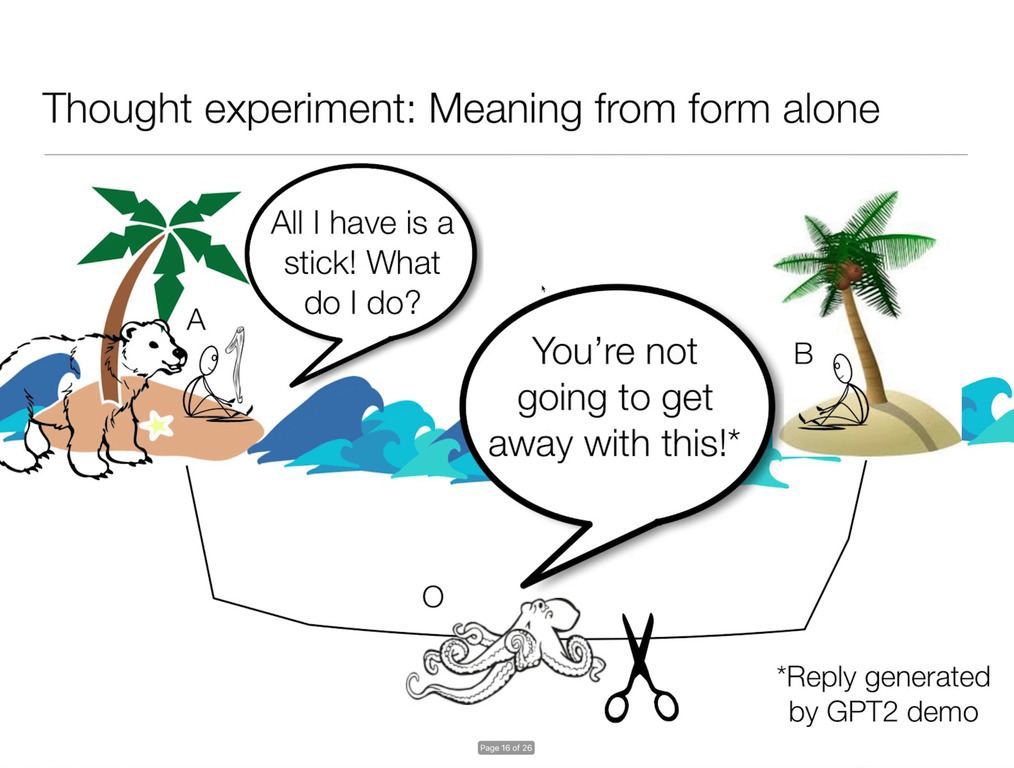

То ли это происходит из-за хайпа, то ли из-за действительно необычных результатов BERT и GPT-2, но стало появляться всё больше и больше рассуждений на тему того, могут ли эти модели добиться "понимания языка". Как всегда проблема тут в определениях – мы не знаем, что такое "понимать".

Раньше у нас были какие-то мысленные эксперименты типа теста тьюринга, или китайской комнаты, но сейчас обе эти задачи если и не решены, то довольно хорошо сходятся к своим решениям. GLUE был очередной попыткой оценивать то, насколько модели "понимают" язык, но BERT его досольно быстро сломал, и сейчас датасет по сути просто используется как стандартный бенчмарк. Потом пришёл GPT-2 и выполнил фаталити, тк показал, что в принципе просто большая языковая модель может решать любые NLP задачи без дополнительной тренировки. GPT-3 показал, что мы даже можем добиваться около-SOTA результатов, опять же – без какой-либо дополнительной тренировки.

Сегодня, в ruder newsletter #53 я наткнулся на две интересных статьи. Первая из них (ACL) очень громко утверждает, что языковые модели не могут понимать смысл и приводит мысленный эксперимент, который иллюстрирует их идею. Вторая (Medium) говорит, что у нас может быть и есть какие-то представления о том, что такое "смысл" и понимание, но они слишком расплывчатые и противоречивые, чтобы мы могли утверждать, что язык это что-то большее, чем языковая модель. Например в первой статье авторы сделали то, что я бы назвал "доказательство определением", где сами термины форма и смысл были подобраны так, чтобы языковые модели (которые тренируются только на форме, по опредлению) не могут понять смысл, который в свою очередь (по определению) что-то что нельзя получить из формы.

Несмотря на это странное начало, я бы рекомендовал почитать обе статьи - будет ещё одна тема, на которую можно пофилософствовать за чашечкой кофе или не кофе.

То ли это происходит из-за хайпа, то ли из-за действительно необычных результатов BERT и GPT-2, но стало появляться всё больше и больше рассуждений на тему того, могут ли эти модели добиться "понимания языка". Как всегда проблема тут в определениях – мы не знаем, что такое "понимать".

Раньше у нас были какие-то мысленные эксперименты типа теста тьюринга, или китайской комнаты, но сейчас обе эти задачи если и не решены, то довольно хорошо сходятся к своим решениям. GLUE был очередной попыткой оценивать то, насколько модели "понимают" язык, но BERT его досольно быстро сломал, и сейчас датасет по сути просто используется как стандартный бенчмарк. Потом пришёл GPT-2 и выполнил фаталити, тк показал, что в принципе просто большая языковая модель может решать любые NLP задачи без дополнительной тренировки. GPT-3 показал, что мы даже можем добиваться около-SOTA результатов, опять же – без какой-либо дополнительной тренировки.

Сегодня, в ruder newsletter #53 я наткнулся на две интересных статьи. Первая из них (ACL) очень громко утверждает, что языковые модели не могут понимать смысл и приводит мысленный эксперимент, который иллюстрирует их идею. Вторая (Medium) говорит, что у нас может быть и есть какие-то представления о том, что такое "смысл" и понимание, но они слишком расплывчатые и противоречивые, чтобы мы могли утверждать, что язык это что-то большее, чем языковая модель. Например в первой статье авторы сделали то, что я бы назвал "доказательство определением", где сами термины форма и смысл были подобраны так, чтобы языковые модели (которые тренируются только на форме, по опредлению) не могут понять смысл, который в свою очередь (по определению) что-то что нельзя получить из формы.

Несмотря на это странное начало, я бы рекомендовал почитать обе статьи - будет ещё одна тема, на которую можно пофилософствовать за чашечкой кофе или не кофе.

2020 October 22

Сбер обучил русский GPT 🎉

Большие модельки потихоньку продвигаются и в русский язык. О цифрах:

1. 600Гб текстов – Omnia Russica+пикабу+22centry+banki.ru

1. GPT-Large на 700млн параметров. Кстати это меньше, чем самый большой GPT-2, но зато помещается в память.

1. 128 V100, тренировали 2 недели на Christophari. В Google Cloud такое стоило бы примерно $100 тысяч.

Из статьи интересно, что оказывается, сбер уже использует GPT в проде для болталки. Очень смело, но зато теперь можно ждать лулзов и историй про то, как кого-то очень изощнённо куда-то послала колонка сбера.

Что грустно, это то, что модельку не поэвалюировали на прикладных задачах классификации/перевода итд (в чём собственно и заключается вся соль GPT-N, N>1).

Пример генерации:

Context: на словах ты лев толстой

ruGPT3Large: а в сущности, - ты тоже не дурак, просто так же, как и твой человек, то есть твоя "жизнь", а также как и ты думаешь по-настоящему "ты" и есть твои "жизнь" или "выбор" в отношении твоего положения.

Всё это добро доступно через Transformers (huggingface.co/sberbank-ai), код есть на гитхабе, в посте ещё сказали про то, что почищенный датасет тоже должен быть доступен, но я его не нашёл.

Большие модельки потихоньку продвигаются и в русский язык. О цифрах:

1. 600Гб текстов – Omnia Russica+пикабу+22centry+banki.ru

1. GPT-Large на 700млн параметров. Кстати это меньше, чем самый большой GPT-2, но зато помещается в память.

1. 128 V100, тренировали 2 недели на Christophari. В Google Cloud такое стоило бы примерно $100 тысяч.

Из статьи интересно, что оказывается, сбер уже использует GPT в проде для болталки. Очень смело, но зато теперь можно ждать лулзов и историй про то, как кого-то очень изощнённо куда-то послала колонка сбера.

Что грустно, это то, что модельку не поэвалюировали на прикладных задачах классификации/перевода итд (в чём собственно и заключается вся соль GPT-N, N>1).

Пример генерации:

Context: на словах ты лев толстой

ruGPT3Large: а в сущности, - ты тоже не дурак, просто так же, как и твой человек, то есть твоя "жизнь", а также как и ты думаешь по-настоящему "ты" и есть твои "жизнь" или "выбор" в отношении твоего положения.

Всё это добро доступно через Transformers (huggingface.co/sberbank-ai), код есть на гитхабе, в посте ещё сказали про то, что почищенный датасет тоже должен быть доступен, но я его не нашёл.

tokenizer = AutoTokenizer.from_pretrained("sberbank-ai/rugpt3large_based_on_gpt2")

model = AutoModel.from_pretrained("sberbank-ai/rugpt3large_based_on_gpt2")2020 October 24

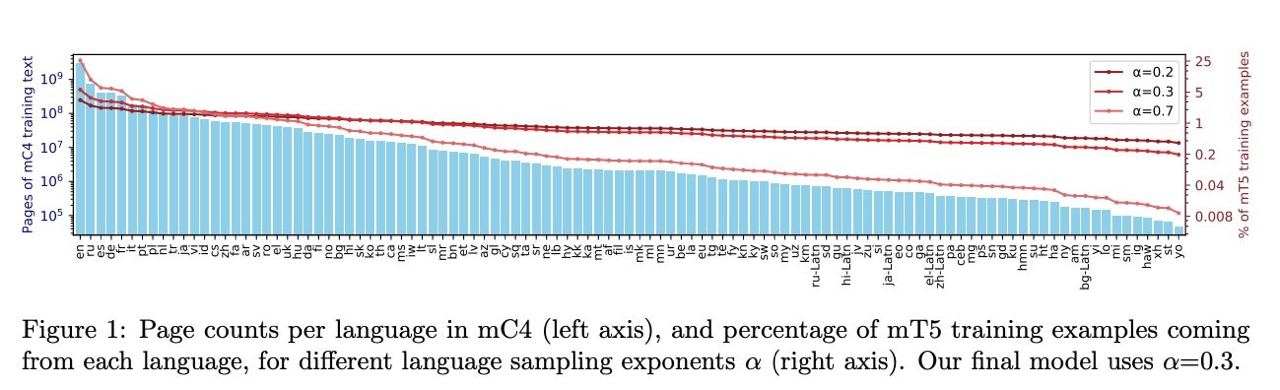

mT5: A massively multilingual pre-trained text-to-text transformer

Xue et al. [Google]

arxiv.org/abs/2010.11934

Продолжение идей T5, но теперь не только для английского. Напомним, что T5 это seq2seq моделька обученная на вариации MLM (SpanBERT), которая при файнтюнинге всё ещё остаётся seq2seq даже для задач классификации (моделька учится предсказывать слово, обозначающее класс). Ещё она огромная, до этого уже можно было догадаться.

Так вот для mT5 - мультиязычной версии T5 собрали датасет mC4 размером в 6 триллионов слов, что вроде бы должно весить около 12Tb (а помните, когда One Billion Words считался большим датасетом?). Что важно, это то, что в этом датасете содержится более 100 языков и что там на удивление много неанглийского, а русский вообще стоит на втором месте. В результате на всём этом обучается новая моделька в 13 миллиардов параметров и она обходит все текущие модели на мультиязычных датасетах, даже включая XLM(-R), при тренировке которых использовались параллельные данные и обходит довольно значительно (в среднем на 2-3 пункта).

Сама статья довольно скучная, по сути в этом TL;DR она вся и описана. Зато код выложен и модельки тоже, жалко что не в 🤗-формате. Где вы правда будете их запускать - это отдельный вопрос.

За наводку на статью спасибо @someotherusername

Xue et al. [Google]

arxiv.org/abs/2010.11934

Продолжение идей T5, но теперь не только для английского. Напомним, что T5 это seq2seq моделька обученная на вариации MLM (SpanBERT), которая при файнтюнинге всё ещё остаётся seq2seq даже для задач классификации (моделька учится предсказывать слово, обозначающее класс). Ещё она огромная, до этого уже можно было догадаться.

Так вот для mT5 - мультиязычной версии T5 собрали датасет mC4 размером в 6 триллионов слов, что вроде бы должно весить около 12Tb (а помните, когда One Billion Words считался большим датасетом?). Что важно, это то, что в этом датасете содержится более 100 языков и что там на удивление много неанглийского, а русский вообще стоит на втором месте. В результате на всём этом обучается новая моделька в 13 миллиардов параметров и она обходит все текущие модели на мультиязычных датасетах, даже включая XLM(-R), при тренировке которых использовались параллельные данные и обходит довольно значительно (в среднем на 2-3 пункта).

Сама статья довольно скучная, по сути в этом TL;DR она вся и описана. Зато код выложен и модельки тоже, жалко что не в 🤗-формате. Где вы правда будете их запускать - это отдельный вопрос.

За наводку на статью спасибо @someotherusername

2020 October 27

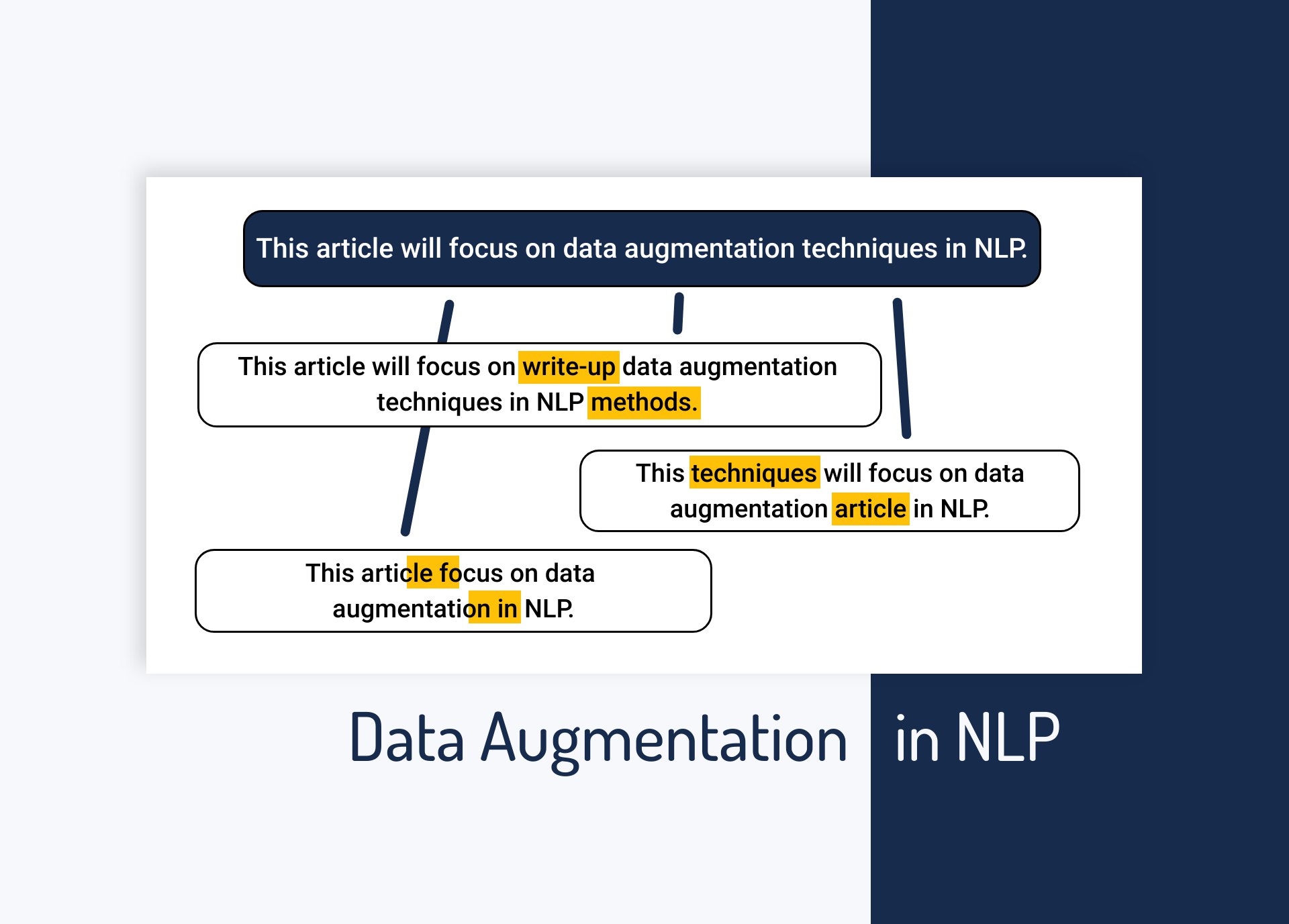

Data Augmentation in NLP: Best Practices From a Kaggle Master

Очень давно ждал чего-то такого. Готовая библиотека для аугментаций в NLP. Как правило завести аугментации текстов сложно и эффект от них слишком малый, чтобы прямо заниматься этим. А теперь вроде бы можно в пару строчек кода.

Например, если вы хотите докинуть контекстных синонимов с помощью берта, то можете сделать так:

Это может выдать что-то такое:

Так что давайте все выполняем

Ссылка на гитхаб библиотеки

Ссылка на документацию

Очень давно ждал чего-то такого. Готовая библиотека для аугментаций в NLP. Как правило завести аугментации текстов сложно и эффект от них слишком малый, чтобы прямо заниматься этим. А теперь вроде бы можно в пару строчек кода.

Например, если вы хотите докинуть контекстных синонимов с помощью берта, то можете сделать так:

import nlpaug.augmenter.word as naw

aug = naw.ContextualWordEmbsAug(model_path='bert-base-uncased', action='insert')

augmented_text = aug.augment('this is a text')Это может выдать что-то такое:

this is currently a text

Что довольно неплохо с учётом того, что вы сделали это в три строчки кода включая импорт.Так что давайте все выполняем

pip install nlpaug и играемся с этим.Ссылка на гитхаб библиотеки

Ссылка на документацию

2020 October 28

Example-Driven Intent Prediction with ObserversExample-Driven Intent Prediction with Observers

Mehri et al. [Amazon]

arxiv.org/abs/2010.08684

Интересная статья по классификации текста. В статье две идеи: example-driven prediction и observers.

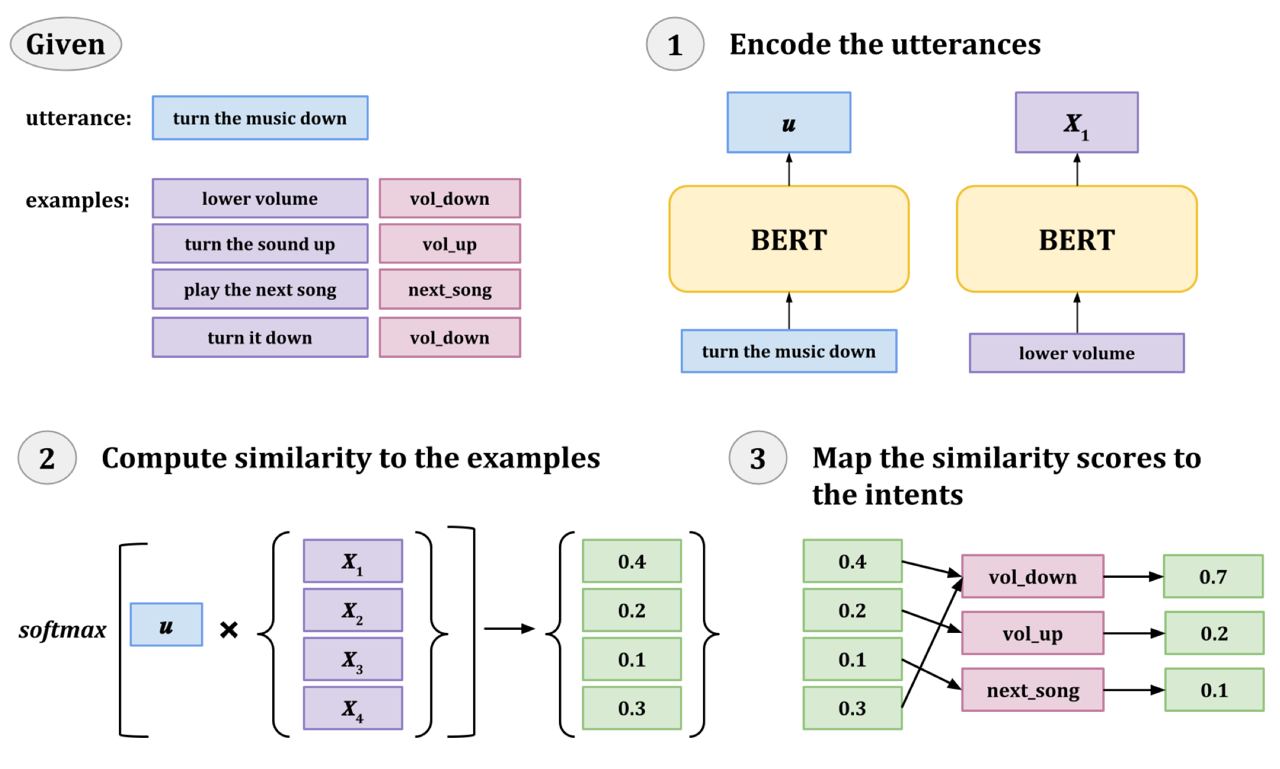

Example-driven prediction: давайте не будем делать выходной слой сетки (голову BERT) и вместо этого возьмём представление CLS токена и посравниваем его с небольшим числом примеров из нашего датасета. Получим similarity scores, потом засофтмаксим их - таким образом мы получим вероятности того, что input имеет тот же класс, что и каждый из примеров. А классы примеров мы знаем. Последний шаг - сложить one-hot вектора классов каждого примера с весами вероятностей из предыдушего шага. На выходе получим вероятность каждого класса. Идея изображена на картинке снизу.

Почему это интересно, это потому что мы не добавляем параметры в BERT и трениуем только сам трансформер, что забавно. Но вторая причина ещё интереснее - после такого обучения сетки мы можем делать инференс на классах, которых в обучающей выборке не было. По сути сетка ведь просто учит хорошую метрику. Идея подхода похожа на такой "гладкий" KNN.

Observers: мы знаем, что CLS часто смотрит сам на себя. Мы также знаем, что токены слов часто смотрят на CLS (возможно, в случаях, когда они хотят проигнорировать инпут). В результате каждый смотрит на каждого и как то это всё сложно. Авторы предлагают добавить новых вспомогательных токенов в BERT, которые будут как СLS, но, в отличие от CLS токенам слов будет запрещено на них смотреть. Таким образом observers занимаются только аггрегацией информации из векторов слов.

Результаты: используя оба метода вместе получаем SOTA на нескольких intent prediction датасетах в стандартном сетапе и в 10-shot сетапе. Не очень большое улучшение, но стабильное. Более интересные реузльтаты в предсказании интентов, отсутствующих в обучающей выборке - улучшение на десятки пунктов относительно бейзлайнов (хотя бейзлайны, конечно, кривые - нужно было сравнивать с каким-нибудь metric-learning подходом).

Mehri et al. [Amazon]

arxiv.org/abs/2010.08684

Интересная статья по классификации текста. В статье две идеи: example-driven prediction и observers.

Example-driven prediction: давайте не будем делать выходной слой сетки (голову BERT) и вместо этого возьмём представление CLS токена и посравниваем его с небольшим числом примеров из нашего датасета. Получим similarity scores, потом засофтмаксим их - таким образом мы получим вероятности того, что input имеет тот же класс, что и каждый из примеров. А классы примеров мы знаем. Последний шаг - сложить one-hot вектора классов каждого примера с весами вероятностей из предыдушего шага. На выходе получим вероятность каждого класса. Идея изображена на картинке снизу.

Почему это интересно, это потому что мы не добавляем параметры в BERT и трениуем только сам трансформер, что забавно. Но вторая причина ещё интереснее - после такого обучения сетки мы можем делать инференс на классах, которых в обучающей выборке не было. По сути сетка ведь просто учит хорошую метрику. Идея подхода похожа на такой "гладкий" KNN.

Observers: мы знаем, что CLS часто смотрит сам на себя. Мы также знаем, что токены слов часто смотрят на CLS (возможно, в случаях, когда они хотят проигнорировать инпут). В результате каждый смотрит на каждого и как то это всё сложно. Авторы предлагают добавить новых вспомогательных токенов в BERT, которые будут как СLS, но, в отличие от CLS токенам слов будет запрещено на них смотреть. Таким образом observers занимаются только аггрегацией информации из векторов слов.

Результаты: используя оба метода вместе получаем SOTA на нескольких intent prediction датасетах в стандартном сетапе и в 10-shot сетапе. Не очень большое улучшение, но стабильное. Более интересные реузльтаты в предсказании интентов, отсутствующих в обучающей выборке - улучшение на десятки пунктов относительно бейзлайнов (хотя бейзлайны, конечно, кривые - нужно было сравнивать с каким-нибудь metric-learning подходом).

Пост с мотивацией. У OpenAI есть программа OpenAI Scholars, где они набирают около десятка людей каждые полгода, чтобы учить их делать рисёч в DL. Причём людей без опыта в ML.

На страничке OpenAI Scholars Spring 2020: Final Projects можно посмотреть какие проекты можно получить за полгода изучения ML. И они довольно классные, не уровня статей на топовых конференциях, но именно то, что достижимо как отличный курсовой проект. Например probing GPT-2 на синтаксис или получение GraphQL query из описания на английском. Советую посмотреть блогпосты/видео и начинать фигачить что-то такое же, потому что если люди без знания ML смогли выучить всё и сделать такие классные проекты, вы тоже можете.

На страничке OpenAI Scholars Spring 2020: Final Projects можно посмотреть какие проекты можно получить за полгода изучения ML. И они довольно классные, не уровня статей на топовых конференциях, но именно то, что достижимо как отличный курсовой проект. Например probing GPT-2 на синтаксис или получение GraphQL query из описания на английском. Советую посмотреть блогпосты/видео и начинать фигачить что-то такое же, потому что если люди без знания ML смогли выучить всё и сделать такие классные проекты, вы тоже можете.

2020 October 29

DeepPavlov Product Roadmap — 2020H2 and Look At 2021

Думаю с диппавловым в той или иной степени знакомы почти все NLP разрабы в России. Так вот, они представили свой роадмап на 2021 и там есть интересные штуки.

1. GUI для создания интентов

1. Дашбоард для аналитики диалогов вашего бота

1. Улучшение поддержки конфигов RASA

1. Упрощение конфигов Agent

1. Миграция кучи всего разработанного для Alexa Challange в либу

Думаю с диппавловым в той или иной степени знакомы почти все NLP разрабы в России. Так вот, они представили свой роадмап на 2021 и там есть интересные штуки.

1. GUI для создания интентов

1. Дашбоард для аналитики диалогов вашего бота

1. Улучшение поддержки конфигов RASA

1. Упрощение конфигов Agent

1. Миграция кучи всего разработанного для Alexa Challange в либу

2020 November 01

The story behind Paranoid Transformer 🔥🔥

GPT generator + BERT filter + hand-writing generation RNN

https://medium.com/altsoph/paranoid-transformer-80a960ddc90a

GPT generator + BERT filter + hand-writing generation RNN

https://medium.com/altsoph/paranoid-transformer-80a960ddc90a