Memory TransformerBurtsev and Sapunov

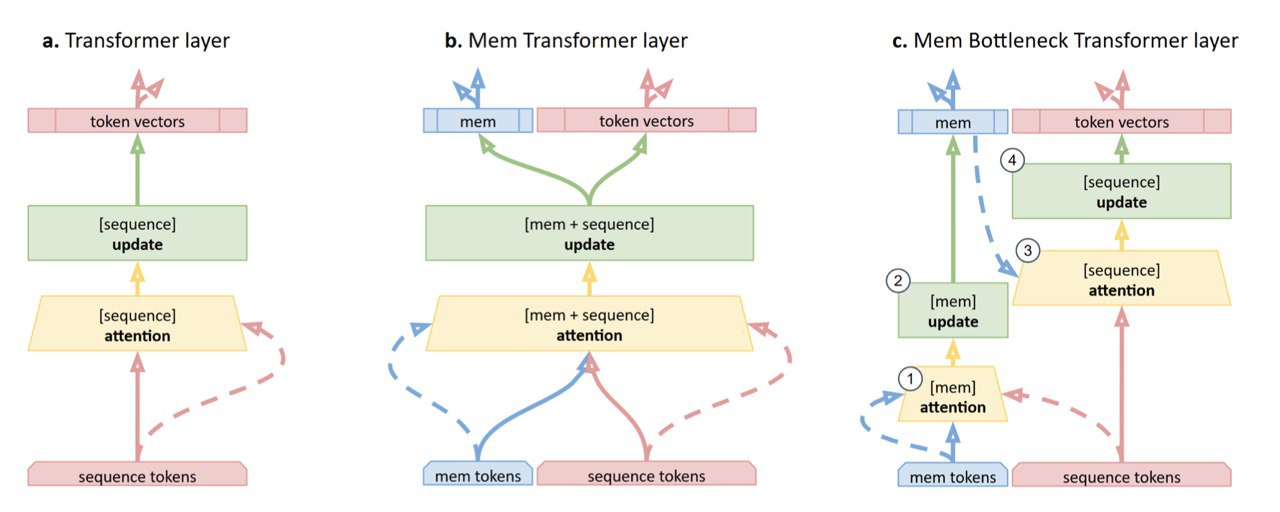

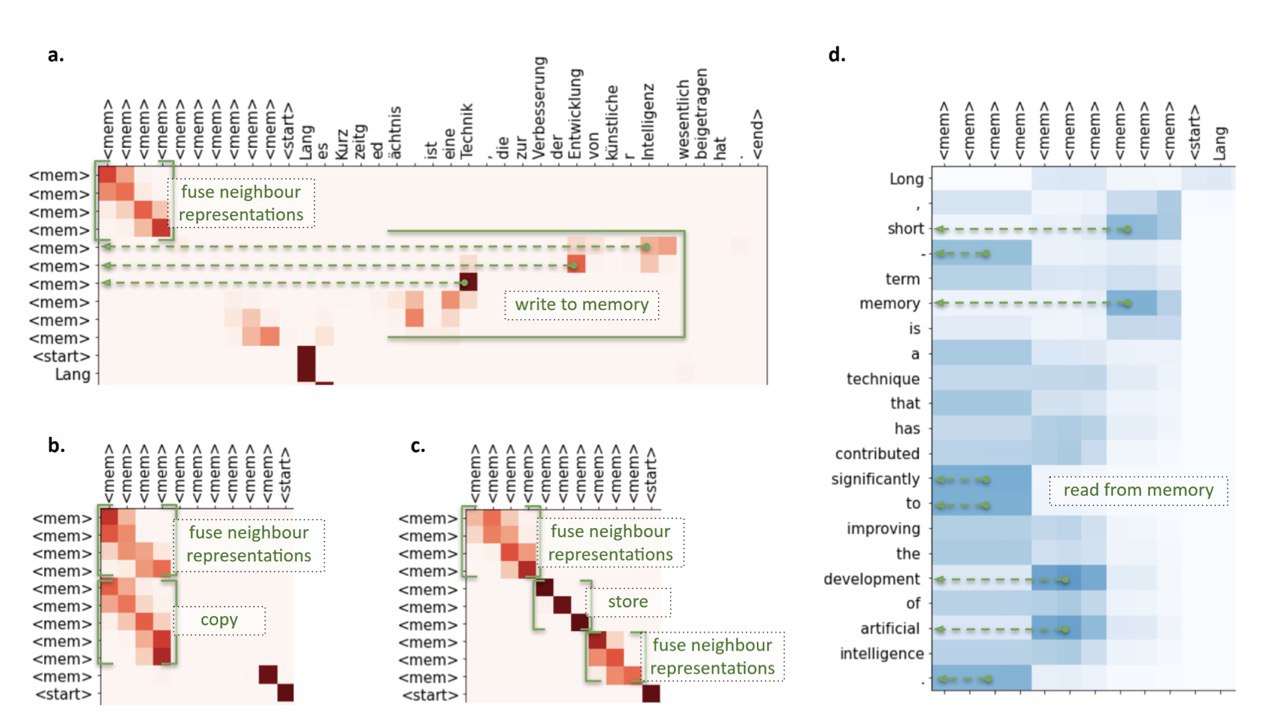

arxiv.org/abs/2006.11527Cтатья от iPavlov и Intento в которой экспериентирют с пустыми токенами в трансформерах. По аналогии с SEP токенами, добавляют по 10-30 MEM токенов. Интуиция тут такая, что потенциально туда трансформер может складывать полезную инфоормацию, например какое-то сжатое описание всего текста. В экспериментах с WMT14 en-de смогло докинуть 1 BLEU к ванильному трансформеру в Base версии. Визуализация attention MEM токенов намекает на то, что они действительно хранят глобальный контекст а так же выполняют с ними операции типа чтения, записи и копирования.

В том числе экспериментировали с более сложным подходом в котором key и value использюется эмбеддинги памяти, а не эмбеддинги токенов, но не зашло.

Результаты довольно неожиданные в контексте свежих статей по интерпретации attention, которые показали, что CLS и SEP используются как своеобразные "выключатели" голов. Было бы интересно посмотреть не только на веса attention, но и на нормы аутпутов, как в статье Atteniton Module is Not Only a Weight.