Language Models are Few-Shot Learners

Brown, Mann, Ryder, Subbiah et al. [OpenAI]

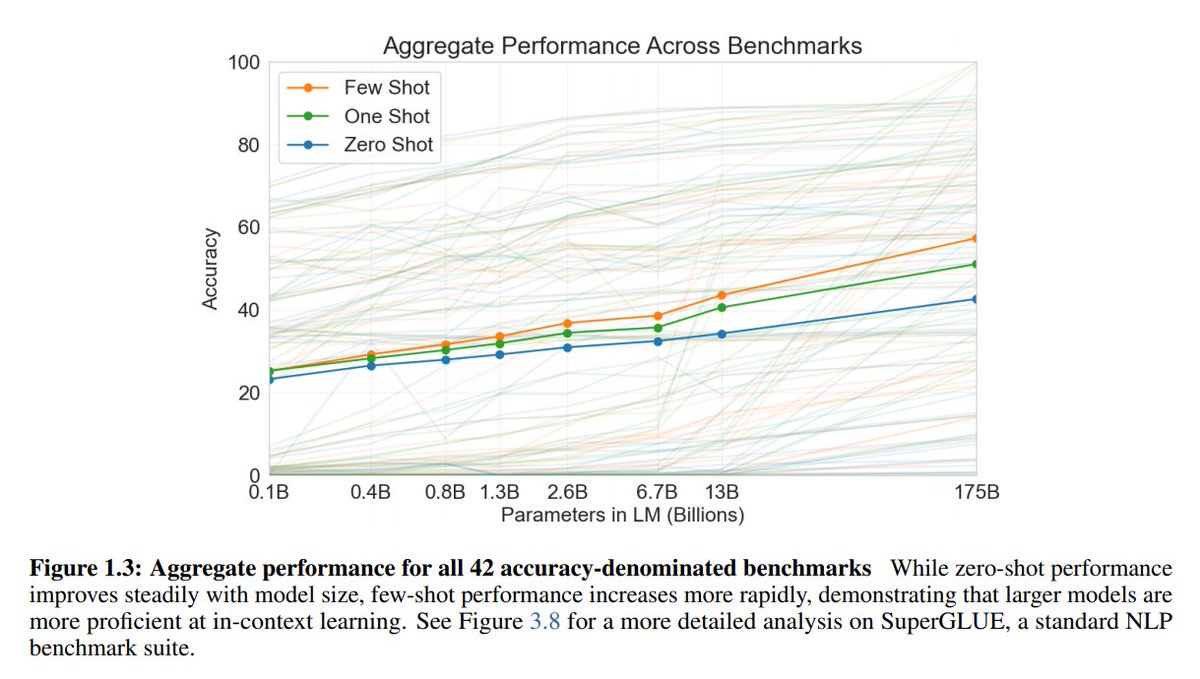

arxiv.org/abs/2005.14165Очевидный результат, про который все и так будут говорить - натренировали модель в 175B параметров. Для сравнения, в BERT large 340M, а в GPT2 - 1.5B. Генерит ещё более правдоподобные тексты, которые люди уже не могут отличить от настоящих (accuracy 52%), даже не смотря на то, что они тратят больше времени на ответ, чем с маленькими моделями (на ~20% больше относительно 1B).

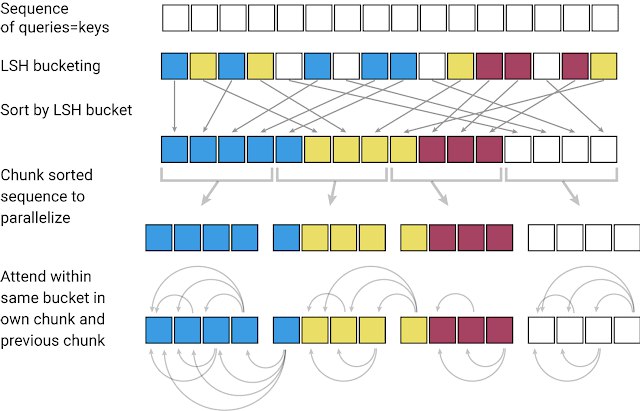

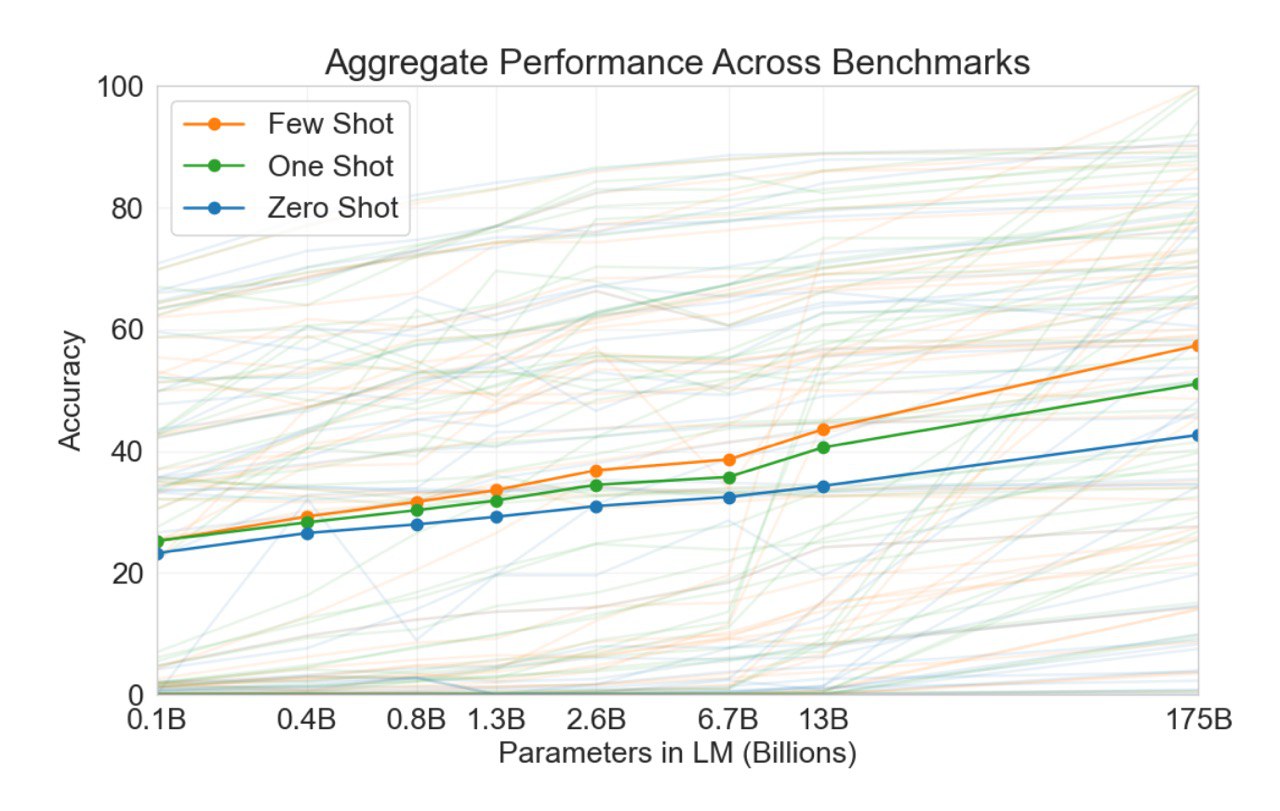

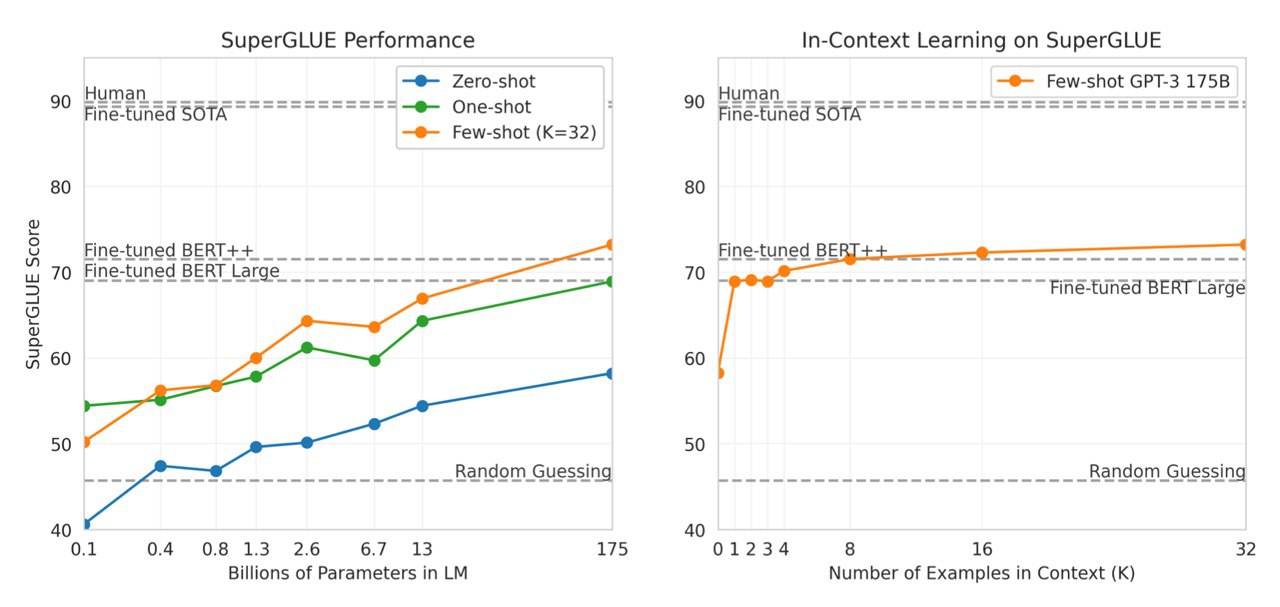

А теперь про неочевидные результаты. Мы знаем, что языковые модели могут решать прикладные задачи без обучения. Однако для адекватного качества нужны очень большие модели (возможно, в тысячи раз больше GPT-3). Новые результаты показывают, что в few-shot сеттинге метрика от размера модели растёт несколько быстрее. Получается, LM с увеличеннием размера (модели и датасета) не только учат common sence, но и учатся быстрее

генерализовывать по нескольким примерам. Также интересно то, что в статье имеется в виду под few-shot - это не обучение/файнтюнинг модели, в том виде, как мы привыкли. Это просто подача текста вида "x

1 : y1, x

2:y2, x3: ", где вся небольшая "обучающая выборка" подаётся на вход модели и она должна продолжить её. Такой подход позволил получить SOTA на TriviaQA (настоящий SOTA, в сравнении с моделями обученными на всём датасете) и в срееднем результаты не хуже зафайтнюненого BERT Large.

Но есть одно но. 175B параметров - это 700Гб (350Гб в fp16), так что скорее всего она не поместится в твою *080Ti ещё лет так 5.

Статья очень большая и интересная, советую заглянуть в секцию results, чтобы посмотреть на них подробнее или хотя бы глянуть графики.

Также зарилизили

репозиторий, но в нём ничего полезного нет