Fine-Tuning Pretrained Language Models: Weight Initializations, Data Orders, and Early Stopping

Dodge et al.

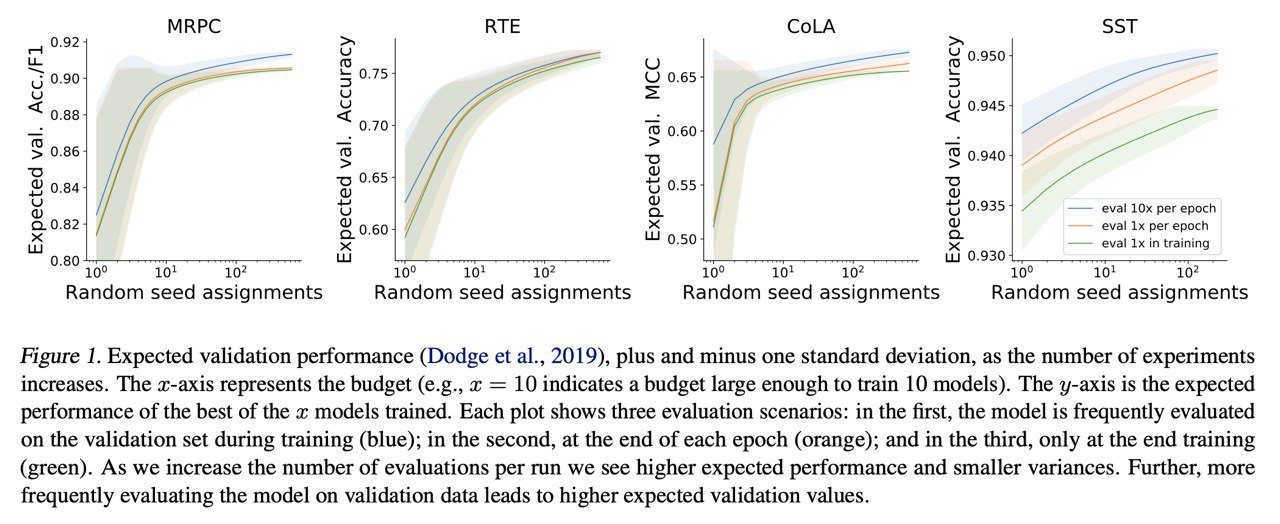

arxiv.org/abs/2002.06305Мы с другом шутили, что random seed - это тоже гиперпараметр. Ещё никогда мы не были так правы.

Взяв обычный BERT и правильно подобрав random seed (на valid) можно получить результаты лучше, чем у RoBERTa, XLNet и др (на valid ???). Давайте допустиим, что авторы не просто переобучились (что вообще весьма вероятно - статьи с Архива такие статьи с Ахрива). Random seed определяет две важные вещи - инициализацию и порядок данных при обучении. Мы издревле знаем, что инициализация критически важна для нейросеток - если инициализируете из неправильного распределения может вообще не сойтись, а если из правильного - сможете обучить хоть CNN в 10 000 слоёв без skip-connection. По важности порядка данных гуглите curriculum learning. Также, если использовать seed только для инициализации, можно найти такие, которые будут трансфериться (показывать хорошие результататы) между датасетами, что забавно и даже логично.