Size: a a a

2020 January 21

2020 January 22

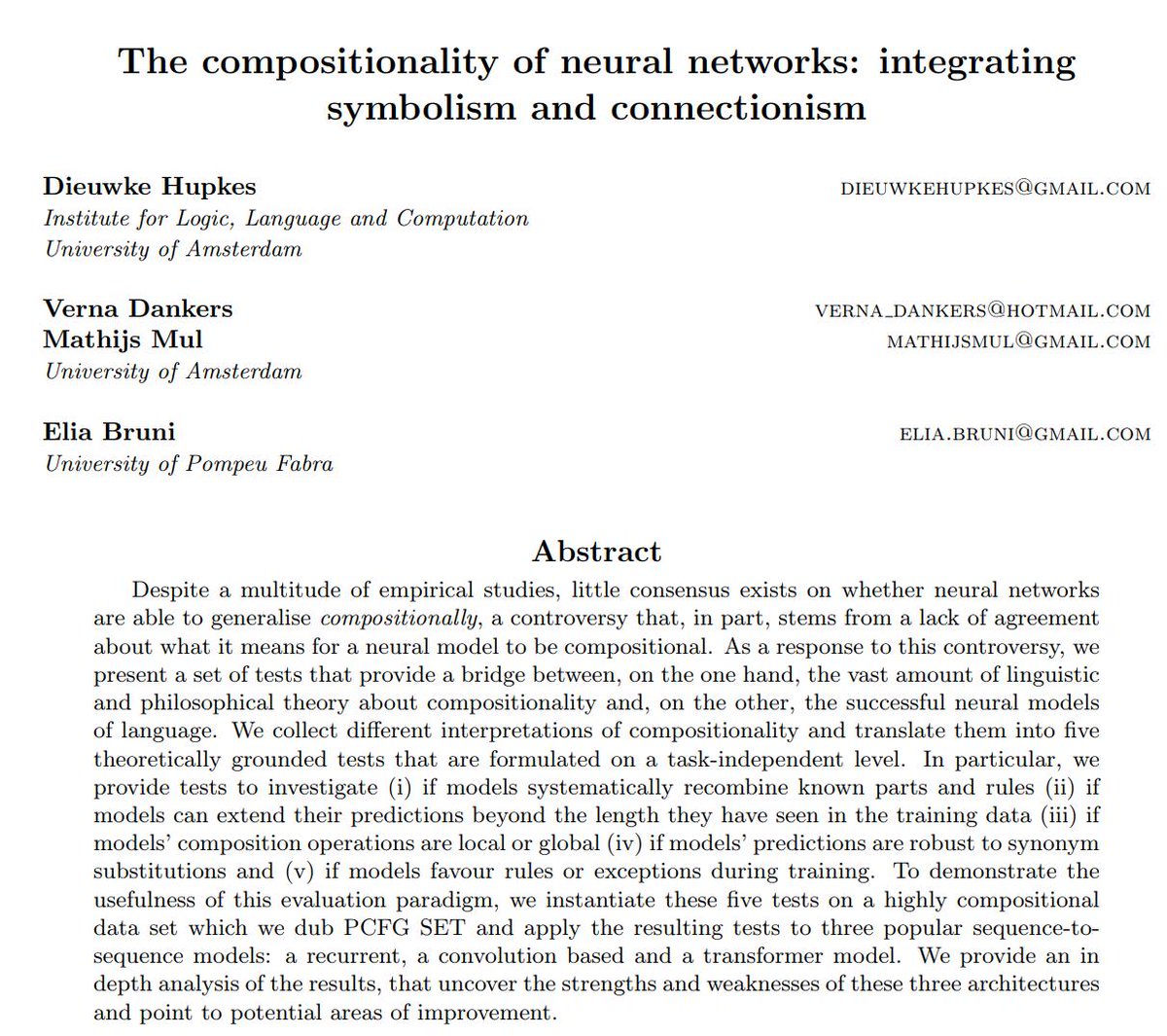

The compositionality of neural networks: integrating symbolism and connectionism

Hupkes et al.

arxiv.org/abs/1908.08351

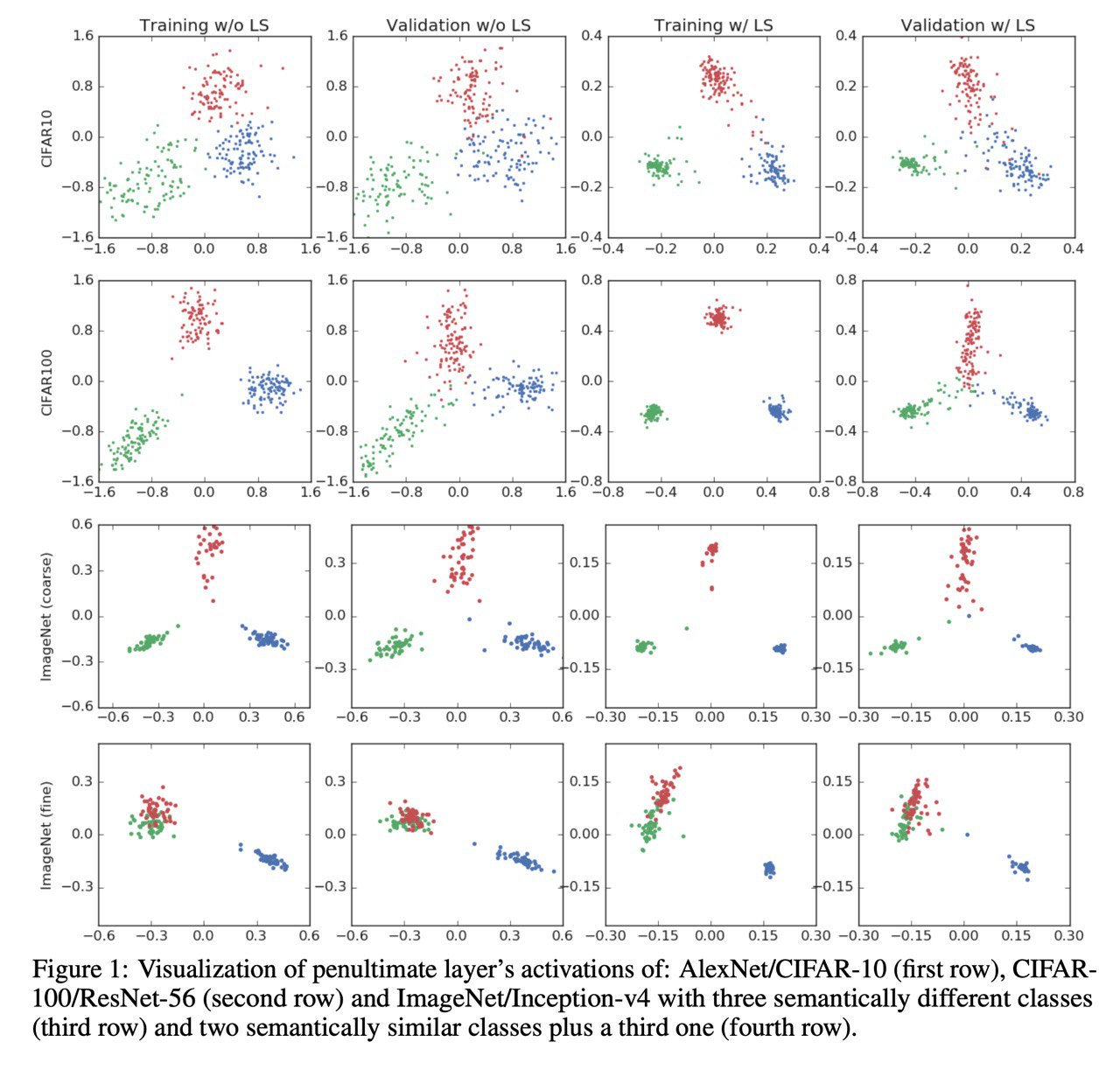

Больше статей про то, что нейронные сети могут больше, чем мы думаем. В этой тестируют могут ли сети в композициональность. Конкретно авторы проверяют:

(i) ability to systematically recombine known parts and rules

(ii) ability to extend predictions beyond the length they have seen in the training data

(iii) if predictions are robust to synonym substitutions

(iv) composition operations are local or global

(v) network favour rules or exceptions during training

Спойлер: трансформер рвёт LSTM и CNN. Результаты намекают на то, что в общем сети скорее могут в композициональность, чем нет, что несколько противоречит нашим текущим представлениям о них.

Более подробное саммари от автора:

twitter.com/_dieuwke_/status/1164875248283656192

Hupkes et al.

arxiv.org/abs/1908.08351

Больше статей про то, что нейронные сети могут больше, чем мы думаем. В этой тестируют могут ли сети в композициональность. Конкретно авторы проверяют:

(i) ability to systematically recombine known parts and rules

(ii) ability to extend predictions beyond the length they have seen in the training data

(iii) if predictions are robust to synonym substitutions

(iv) composition operations are local or global

(v) network favour rules or exceptions during training

Спойлер: трансформер рвёт LSTM и CNN. Результаты намекают на то, что в общем сети скорее могут в композициональность, чем нет, что несколько противоречит нашим текущим представлениям о них.

Более подробное саммари от автора:

twitter.com/_dieuwke_/status/1164875248283656192

Вы, наверное, можете спросить: “А зачем это вообще надо? Научите меня, как правильно тюнить берта и как лучше решать мою прикладную задачу”. В принципе верно - тема далека от приложений - но именно такие исследования могут в долгосрочной перспективе позволить нам решать задачи, которые сейчас принципиально невозможны.

Зарелижен код реформера. Правда зарелижен как кусок библиотеки (вот зачем так?), но зато хорошая причина посмотреть внимательнее на JAX (и TRAX), который может оказаться the next big thing после PyTorch.

UPD: посмотрел на код, почувствовал себя в 2016 и TF1.0. Не хочу такого будущего.

UPD: посмотрел на код, почувствовал себя в 2016 и TF1.0. Не хочу такого будущего.

Reformer: The Efficient Transformer

Kitaev et al. [Google]

openreview.net/forum?id=rkgNKkHtvB

Улучшение асимптотик трансформера (и памяти и времени) до логлинейных. Авторы смогли добиться этого с помощью хитрого хеширования и расчёта только кусков attention-матрицы плюс идеи reversible residual networks, которая позволяет делать хитрый backward-pass, занимающий меньше памяти. Идея пока не очень применимая, потому что начинает обходить трансформеры по скорости только при длинах > 2K, но во-первых такие задачи вполне существуют в этом мире, а во-вторых, кажется, мы начинаем выкарабкиваться от ограничения на 512 токенов, что хорошо.

В статье очень хороший анализ того, как работает dot-product attention и что в нём можно улучшить, советую к прочтению.

Ещё хочу добавить: нет смысла надеяться, что топовые модели в этом году будут требовать меньше вычислений. Так не бывает, SOTA почти всегда находится на грани вычислительных возможностей. Но подобные этой статьи позволят использовать более ёмкие модели при +- тех же ресурсах, что в общем неплохо. Остаётся ждать, когда 1080Ti будут сопоставимы по стоимости с чашкой кофе и воткнуты в Raspberry PI (на самом деле нет).

Kitaev et al. [Google]

openreview.net/forum?id=rkgNKkHtvB

Улучшение асимптотик трансформера (и памяти и времени) до логлинейных. Авторы смогли добиться этого с помощью хитрого хеширования и расчёта только кусков attention-матрицы плюс идеи reversible residual networks, которая позволяет делать хитрый backward-pass, занимающий меньше памяти. Идея пока не очень применимая, потому что начинает обходить трансформеры по скорости только при длинах > 2K, но во-первых такие задачи вполне существуют в этом мире, а во-вторых, кажется, мы начинаем выкарабкиваться от ограничения на 512 токенов, что хорошо.

В статье очень хороший анализ того, как работает dot-product attention и что в нём можно улучшить, советую к прочтению.

Ещё хочу добавить: нет смысла надеяться, что топовые модели в этом году будут требовать меньше вычислений. Так не бывает, SOTA почти всегда находится на грани вычислительных возможностей. Но подобные этой статьи позволят использовать более ёмкие модели при +- тех же ресурсах, что в общем неплохо. Остаётся ждать, когда 1080Ti будут сопоставимы по стоимости с чашкой кофе и воткнуты в Raspberry PI (на самом деле нет).

2020 January 27

Думаю, если статью продолжают обсуждать через практически полгода после публикации - то она точно интересная. Запись выступления Елены Войты об Evolution of Representations in the Transformer.

youtu.be/h5N7sbAKBhA

youtu.be/h5N7sbAKBhA

The Bottom-up Evolution of Representations in the Transformer:

A Study with Machine Translation and Language Modeling Objectives

Voita et al.

arxiv.org/abs/1909.01380

Статья про теоретикоинформационный анализ трансформера при различных способах его тренировки. Сравнивают машинный перевод, языковое моделирование и masked language modelling. Анализ делают с помощью измерения mutual information и PWCCA.

К статье есть отличный блогпост от одного из авторов - Елены Войты из Яндекса

Evolution of Representations in the Transformer

ссылка

TL;DR

1. with the LM objective, as you go from bottom to top layers, information about the past gets lost and predictions about the future get formed;

1. for MLMs, representations initially acquire information about the context around the token, partially forgetting the token identity and producing a more generalized token representation; the token identity then gets recreated at the top layer;

1. for MT, though representations get refined with context, less processing is happening and most information about the word type does not get lost.

A Study with Machine Translation and Language Modeling Objectives

Voita et al.

arxiv.org/abs/1909.01380

Статья про теоретикоинформационный анализ трансформера при различных способах его тренировки. Сравнивают машинный перевод, языковое моделирование и masked language modelling. Анализ делают с помощью измерения mutual information и PWCCA.

К статье есть отличный блогпост от одного из авторов - Елены Войты из Яндекса

Evolution of Representations in the Transformer

ссылка

TL;DR

1. with the LM objective, as you go from bottom to top layers, information about the past gets lost and predictions about the future get formed;

1. for MLMs, representations initially acquire information about the context around the token, partially forgetting the token identity and producing a more generalized token representation; the token identity then gets recreated at the top layer;

1. for MT, though representations get refined with context, less processing is happening and most information about the word type does not get lost.

Scaling Laws for Neural Language Models

Kaplan, McCandlish et al. [OpenAI]

arxiv.org/abs/2001.08361

Интересный пример “физического” подхода к анализу нейросетей: проведём много экспериментов и установим законы зависимостей.

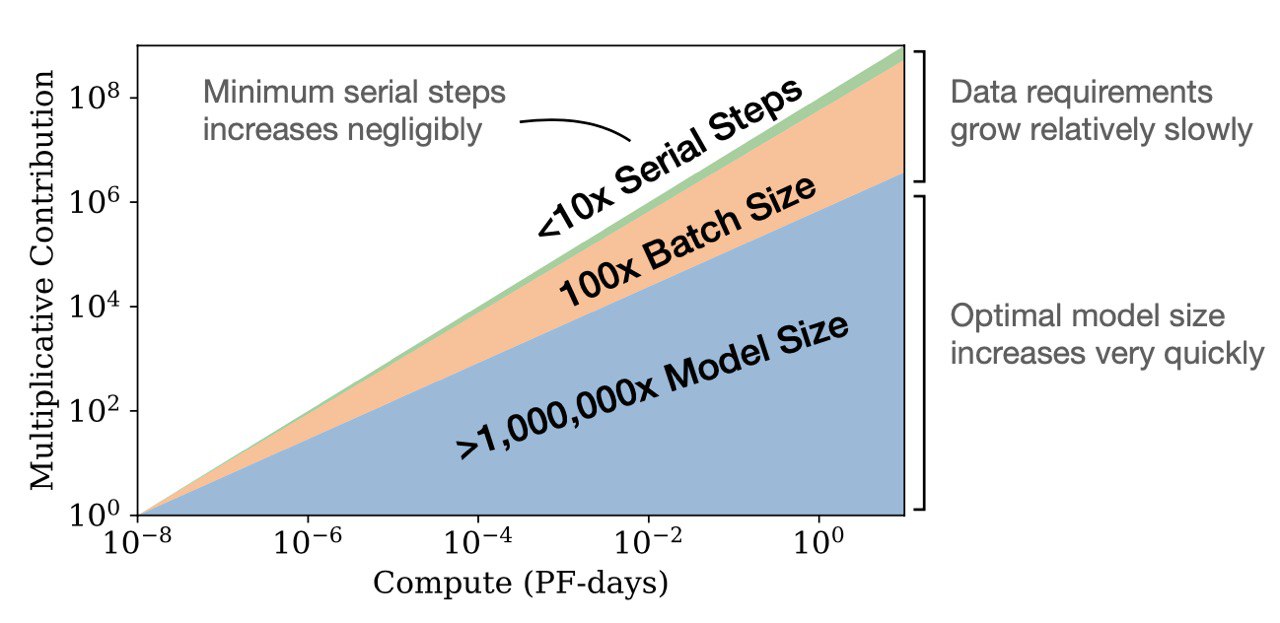

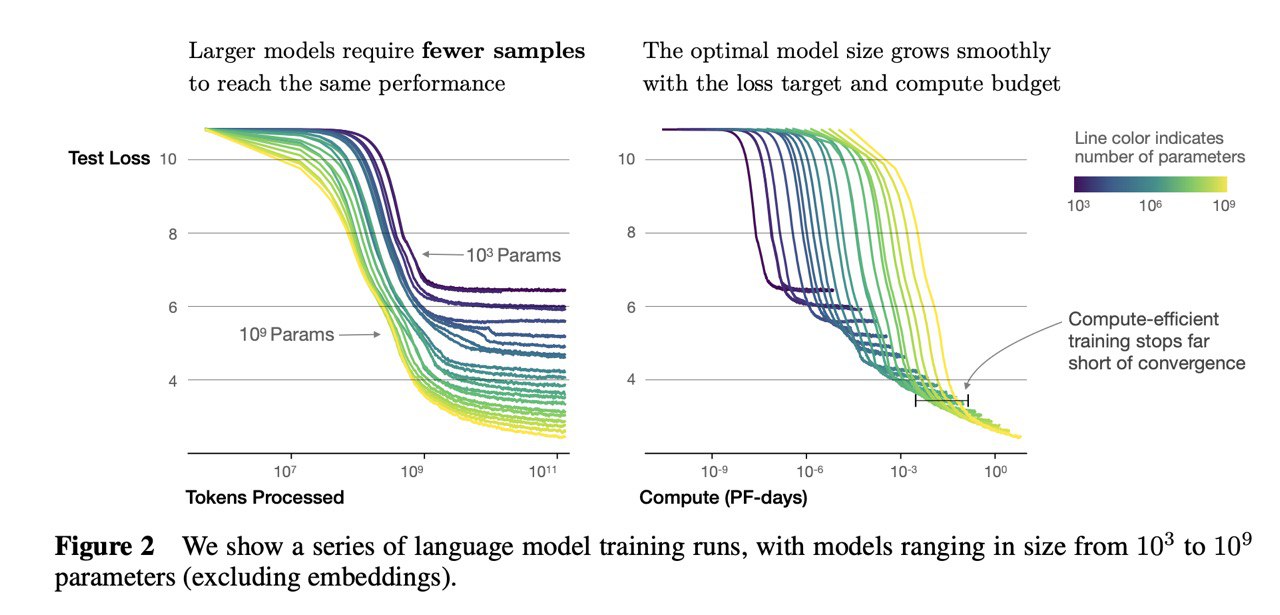

Все результаты в короткий ltdr не уложишь - советую почитать статью. Из необычных результатов:

1. Если вы ограниченны в compute и хотите натренировать самую лучшую LM, выгоднее взять очень большую модель и остановить тренировку очень рано (задолго до сходимости), чем взять модель поменьше и тренировать до конца

1. По compute, размеру датасета и числу параметров test loss скейлится как степенная функциия:

1. Увеличив модель в ~8 раз, увеличьте датасет в ~5 раз, чтобы не переобучиться

1. Сингулярности стоит ожидать, когда размер моделей будет в 10 000 раз больше текущих, так что продолжаем упарываться 🙃

За ссылку на статью спасибо @Cookie_thief

Kaplan, McCandlish et al. [OpenAI]

arxiv.org/abs/2001.08361

Интересный пример “физического” подхода к анализу нейросетей: проведём много экспериментов и установим законы зависимостей.

Все результаты в короткий ltdr не уложишь - советую почитать статью. Из необычных результатов:

1. Если вы ограниченны в compute и хотите натренировать самую лучшую LM, выгоднее взять очень большую модель и остановить тренировку очень рано (задолго до сходимости), чем взять модель поменьше и тренировать до конца

1. По compute, размеру датасета и числу параметров test loss скейлится как степенная функциия:

a*x^-k (i.e. power law)1. Увеличив модель в ~8 раз, увеличьте датасет в ~5 раз, чтобы не переобучиться

1. Сингулярности стоит ожидать, когда размер моделей будет в 10 000 раз больше текущих, так что продолжаем упарываться 🙃

За ссылку на статью спасибо @Cookie_thief

2020 January 29

Переслано от Cookie Thief

RL + Knowledge graphs + NLP, всё как мы любим.

тык

Если у кого есть возможность\время разобрать, было бы мега круто)

тык

Если у кого есть возможность\время разобрать, было бы мега круто)

«Читаем статьи за вас». Октябрь — Декабрь 2019

Переслано от b b

Переслано от b b

from thinc.api import PyTorchWrapper, TensorFlowWrapper

pt_model = PyTorchWrapper(create_pytorch_model())

tf_model = TensorFlowWrapper(create_tensorflow_model())

# You can even stitch together strange hybrids

# (not efficient, but possible)

frankenmodel = chain(add(pt_model, tf_model), Linear(128), logistic())

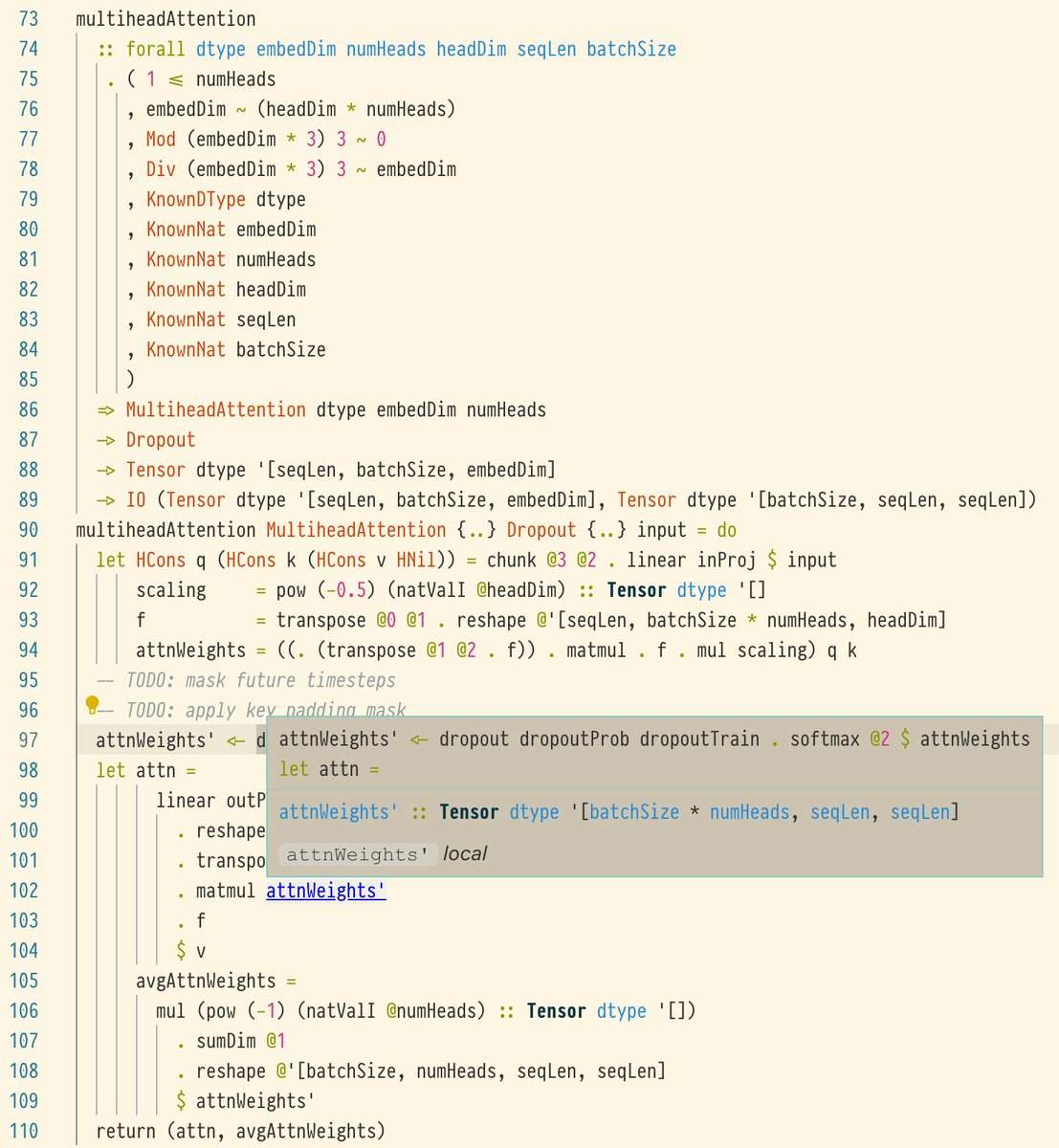

Раз уж мы занялись эзотерикой, то держите ещё и DL-фреймворк на Haskell