На неделе совсем не было времени на канал, но я собрал много интересных штук, в том числе с NeurIPS. Далеко не всё про NLP, но хорошие художники копируют, а лучшие применяют метод к новой области и подают статью на воркшоп <think_about_it_meme.png>

1. Normalizing Flows - очень интересный класс генеративных моделей. Их можно применять в VAE для использования более сложных, чем multivariate gaussian априорных распределений. Если хотите с ними поиграться, есть довольно понятная

имплементация от Андрея Карпатого (директор AI в Tesla) на богоугодном PyTorch.

1.

Your Classifier is Secretly an Energy Based Model and You Should Treat it Like One, Grathwohl et al. - совершенно неочевидная статья, которая говорит, что ваш классификатор кошечек и собачек не только учит разделять два вида картинок, но и генерировать новые. Трэд в твиттере с TL;DR:

twitter.com/DavidDuvenaud/status/12041436788658667521. Немного странный туториал по

energy-efficient deep learning1. Top-6 проектов студентов

fast.ai twitter.com/jeremyphoward/status/1204170758512988160Много из них просто классифицируют звук работая со спектрограммой как с изображением и результаты довольно неплохие. А

вот в этом проекте студент визуализировал SGD с различным LR.

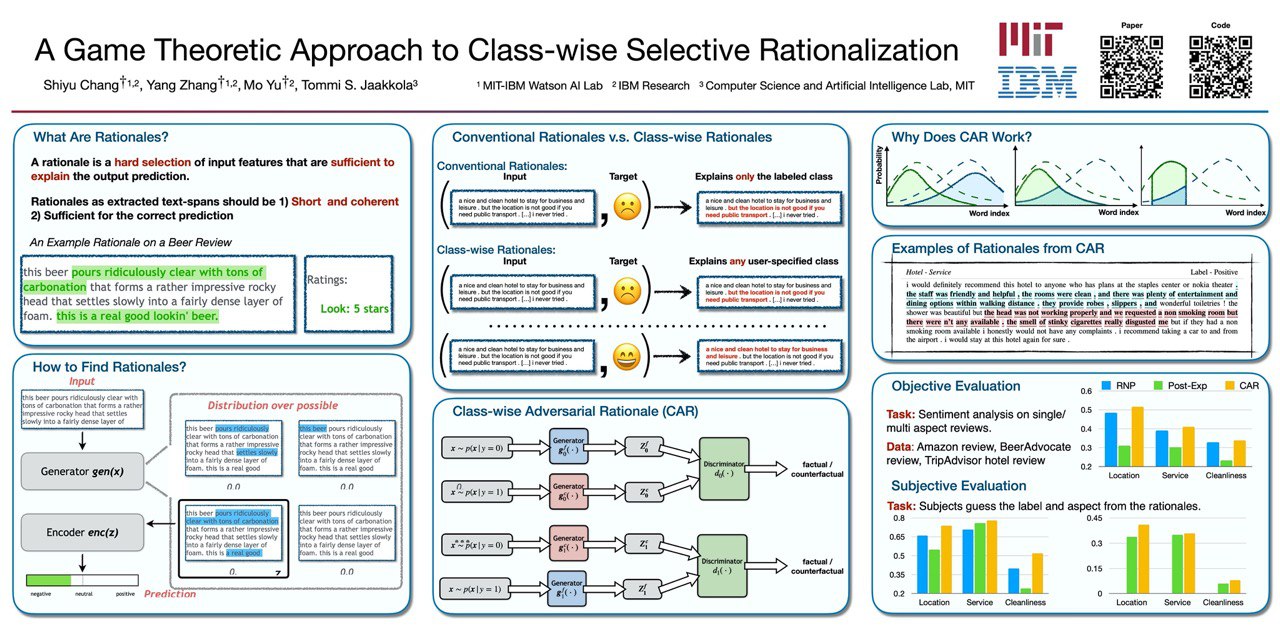

1. Завезли

новый метод интерпретации классификаторов текста, который а) выделяет слова

бинарно б) выделенные слова

достаточны для классификации в) основан на теории игр

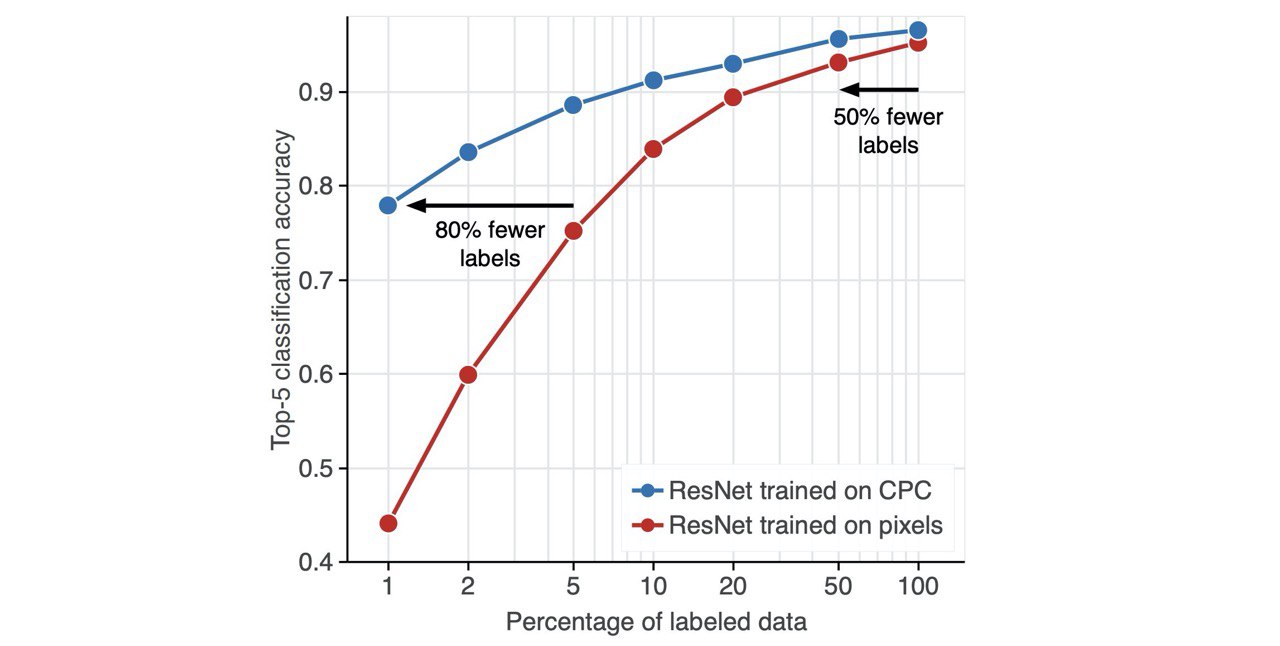

1. Contrastive Predictive Coding восстал из могилы и получил SOTA на линейной классификации ImageNet. Self-supervised learning начал работать в CV. Да и просто это понятная статья от DeepMind, что нечасто увидишь

arxiv.org/abs/1905.09272v21.

Туториал по Interpretable Comparison of Distributions and Models для любителей матана

1. Забавный

TL;DR ALBERT от Hugging Face (но лучше почитайте полноценный тут в канале)

1.

Weight Agnostic Neural Networks, Gaier & Ha - неросети, которые работают с любыми весами и как их искать. Мегадичь, поэтому и забавно посмотреть

1.

Mixtape: Breaking the Softmax Bottleneck Efficiently, Yang et al. - не очень дорогой способ получить +1 BLEU на ваших задачах машинного перевода. Идея в модификации софтмакса, который заставляет распределения быть низкогарновыми, а мы этого не хотим.

1.

Ревью текущего состояния NLU от исследователей Stanford, DeepMind, Google Research, Bosch AI (wat?) и LMU Munich