Size: a a a

2019 October 22

2019 October 23

Переслано от Boris Zubarev

из твиттера рудера:

Most of the world’s text is not in English. We are releasing MultiFiT to train and fine-tune language models efficiently in any language.

Post: http://nlp.fast.ai/classification/2019/09/10/multifit.html

Paper: https://arxiv.org/abs/1909.04761

Abstract

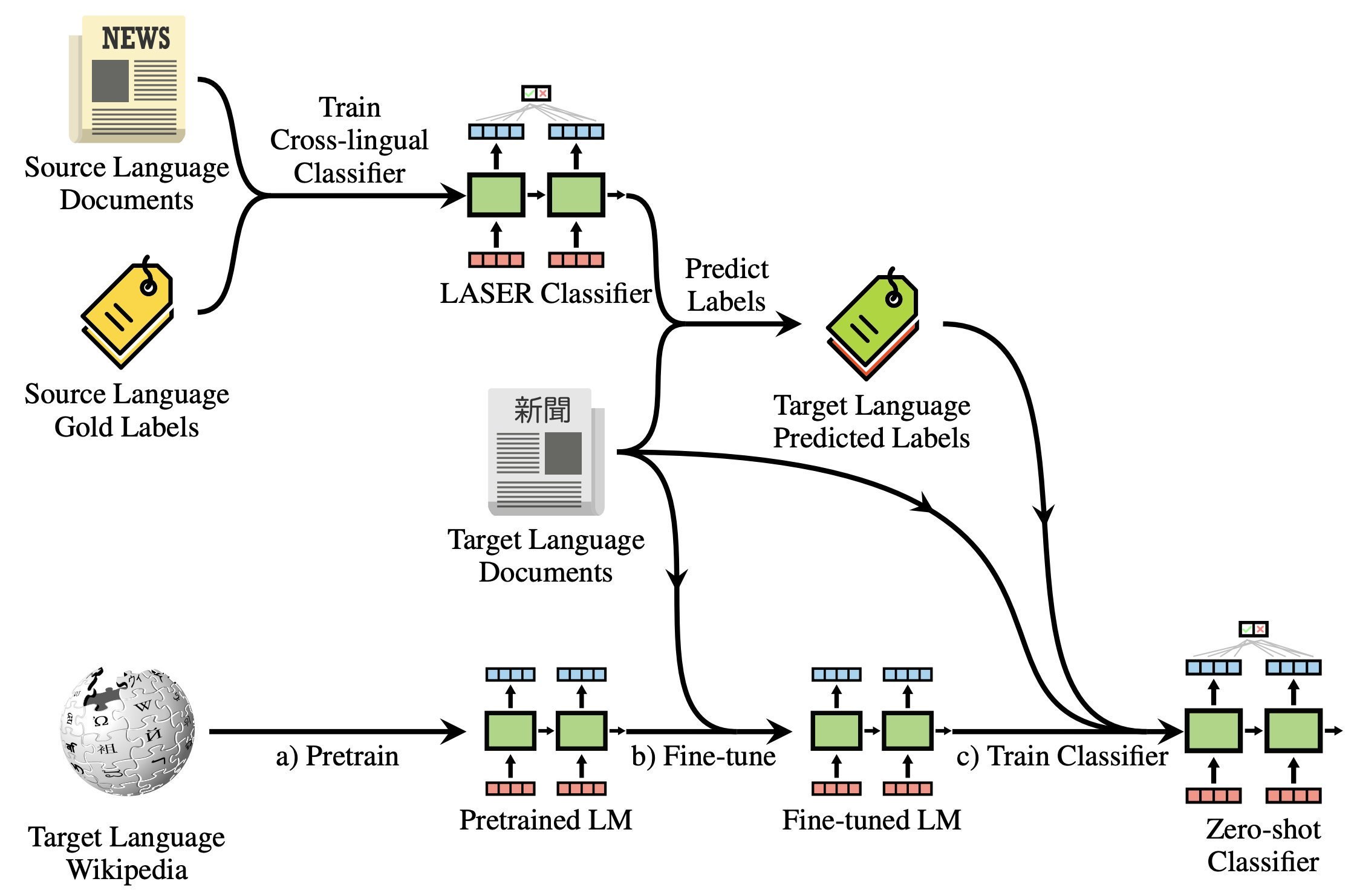

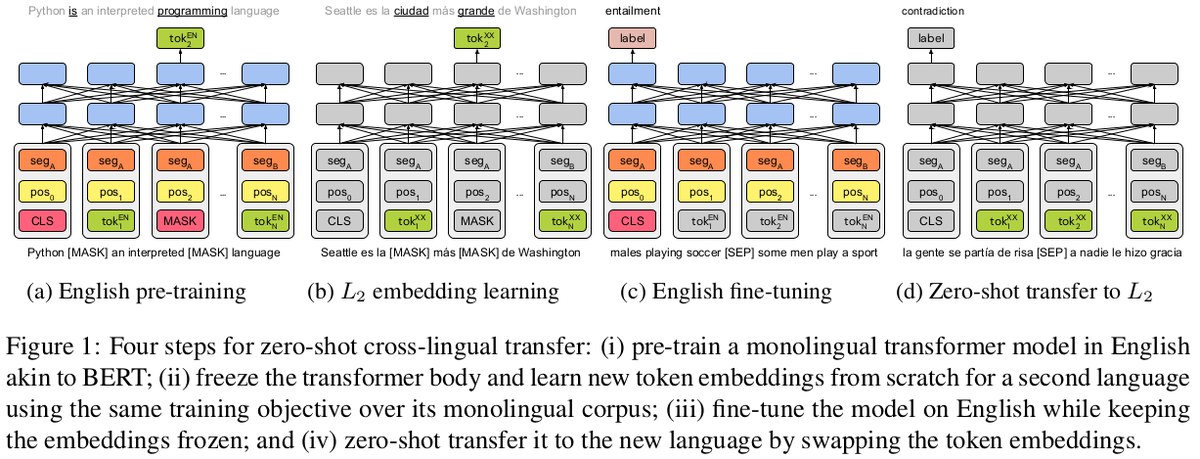

Pretrained language models are promising particularly for low-resource languages as they only require unlabelled data. However, training existing models requires huge amounts of compute, while pretrained cross-lingual models often underperform on low-resource languages. We propose Multi lingual language model Fine-Tuning (MultiFiT) to enable practitioners to train and fine-tune language models efficiently in their own language. In addition, we propose a zero-shot method using an existing pretrained cross-lingual model. We evaluate our methods on two widely used cross-lingual classification datasets where they outperform models pretrained on orders of magnitude more data and compute. We release all models and code.

Most of the world’s text is not in English. We are releasing MultiFiT to train and fine-tune language models efficiently in any language.

Post: http://nlp.fast.ai/classification/2019/09/10/multifit.html

Paper: https://arxiv.org/abs/1909.04761

Abstract

Pretrained language models are promising particularly for low-resource languages as they only require unlabelled data. However, training existing models requires huge amounts of compute, while pretrained cross-lingual models often underperform on low-resource languages. We propose Multi lingual language model Fine-Tuning (MultiFiT) to enable practitioners to train and fine-tune language models efficiently in their own language. In addition, we propose a zero-shot method using an existing pretrained cross-lingual model. We evaluate our methods on two widely used cross-lingual classification datasets where they outperform models pretrained on orders of magnitude more data and compute. We release all models and code.

Хорошая статья от Skynet Today про последнее громкое достижение OpenAI - роборука, умеющая манипулировать кубиком Рубика и хайп вокруг этого.

TL;DR

OpenAI делает очень крутые вещи, но их маркетинг зачастую искривляет их достижения. Хайп возникает вместе с недопониманием результатов и OpenAI на это никак не реагирует.

От себя хочу добавить, что маркетинг OpenAI и правда странный, хоть и эффективный. К примеру статья про GPT-2 была совсем не про генерацию реалистичного текста, однако даже большинство исследователей не знают об этом.

skynettoday.com/briefs/openai-rubiks-cube

TL;DR

OpenAI делает очень крутые вещи, но их маркетинг зачастую искривляет их достижения. Хайп возникает вместе с недопониманием результатов и OpenAI на это никак не реагирует.

От себя хочу добавить, что маркетинг OpenAI и правда странный, хоть и эффективный. К примеру статья про GPT-2 была совсем не про генерацию реалистичного текста, однако даже большинство исследователей не знают об этом.

skynettoday.com/briefs/openai-rubiks-cube

2019 October 24

https://twitter.com/colinraffel/status/1187161460033458177

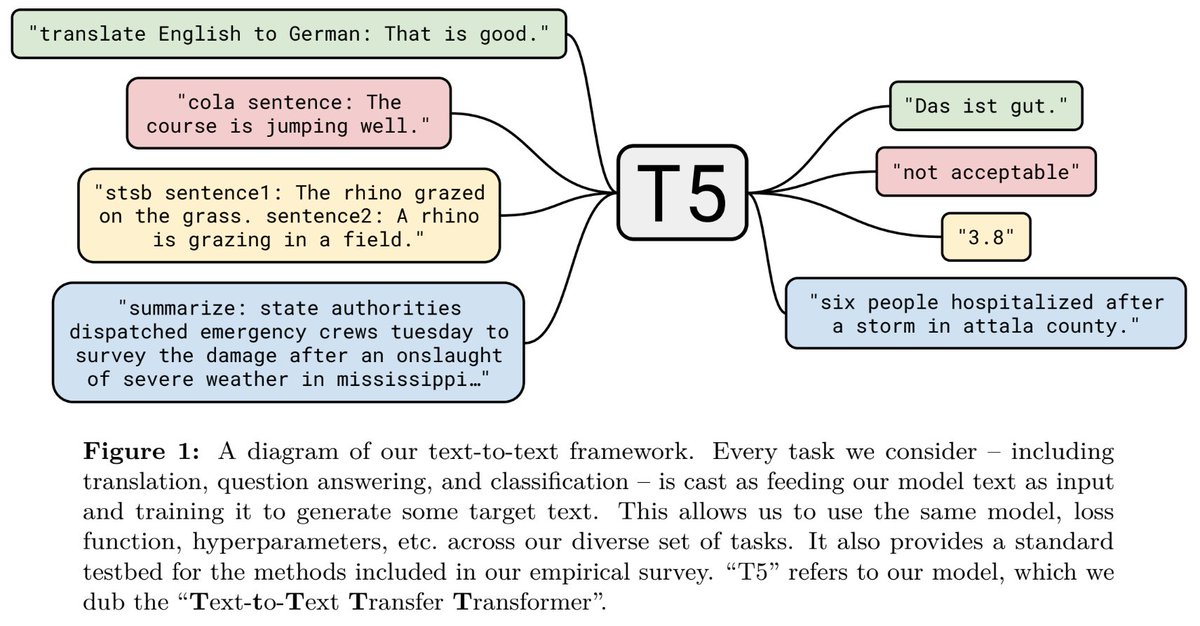

C4 и T5

За твитом большой тред с саммари статьи. Выглядит интересно.

C4 и T5

За твитом большой тред с саммари статьи. Выглядит интересно.

2019 October 25

BERT теперь есть в основном продукте гугла - поиске.

Очень крутая новость. Год назад, когда статья только-только вышла, я был уверен, что это слишком тяжёлая модель для прода. Однако вот как оно вышло.

Интересно, как они решили проблемы ранжирования с помощью берта:

1. Получение качественного хэша <— дообучение CLS-токена с помощью tiplet loss?

1. Обновление хэша всего интернета при обновлении модели <— ??

Очень крутая новость. Год назад, когда статья только-только вышла, я был уверен, что это слишком тяжёлая модель для прода. Однако вот как оно вышло.

Интересно, как они решили проблемы ранжирования с помощью берта:

1. Получение качественного хэша <— дообучение CLS-токена с помощью tiplet loss?

1. Обновление хэша всего интернета при обновлении модели <— ??

Переслано от b b

Открою немного внутренних презентаций нашей лабы в мир.

Две отличных презентации от @guacamolia про интерпретацию и анализ BERT и вообще transfer learning в NLP. Более 10 статей!

Раз, два

Две отличных презентации от @guacamolia про интерпретацию и анализ BERT и вообще transfer learning в NLP. Более 10 статей!

Раз, два

2019 October 26

Переслано от Mikhail Burtsev

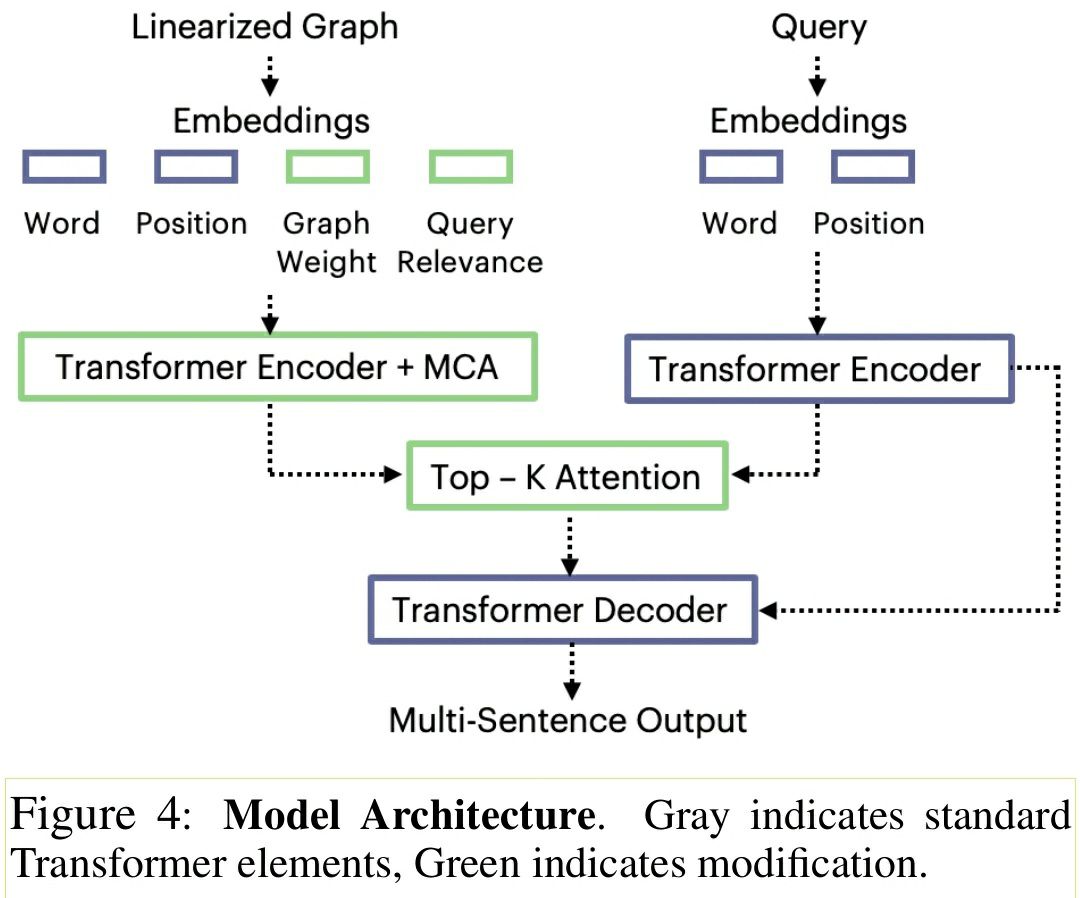

Интересная статья по супер перспективному направлению комбинации языковых моделей и графов знаний. Рассматривается задача суммаризации, например, на вход подаётся топ 100 документов поисковой выдачи, а на выходе генерируется аннотация длиной 150 токенов.

Задача решается в два этапа. Сначала, из выдачи выделяются триплеты - (субъект, предикат, объект), которые объединяют в общий граф с сущностями вершинами и предикатами ребрами. Полученный граф лианиризуется - представляется в виде строки.

На втором этапе, запрос и лианиризованное представление графа по отдельности кодируются трансформером. Результаты прогоняются через иерархический аттеншн. Векторное представление после аттеншна используется seq2seq трансформером для генерации ответа.

Важной частью обучения модели является multi-task trainig. Система тренируется не только для суммаризации, но и для восстановления графа знаний (по принципу маскирования при обучении языковых моделей). Подобный подход можно использовать и для совместной тренировки знание-языковой модели.

PS: мы в iPavlov как раз сейчас ищем людей, кто может или чувствует себя готовым делать подобные штуки для Q&A пишите мне @MBurtsev

https://research.fb.com/publications/using-local-knowledge-graph-construction-to-scale-seq2seq-models-to-multi-document-inputs/

Задача решается в два этапа. Сначала, из выдачи выделяются триплеты - (субъект, предикат, объект), которые объединяют в общий граф с сущностями вершинами и предикатами ребрами. Полученный граф лианиризуется - представляется в виде строки.

На втором этапе, запрос и лианиризованное представление графа по отдельности кодируются трансформером. Результаты прогоняются через иерархический аттеншн. Векторное представление после аттеншна используется seq2seq трансформером для генерации ответа.

Важной частью обучения модели является multi-task trainig. Система тренируется не только для суммаризации, но и для восстановления графа знаний (по принципу маскирования при обучении языковых моделей). Подобный подход можно использовать и для совместной тренировки знание-языковой модели.

PS: мы в iPavlov как раз сейчас ищем людей, кто может или чувствует себя готовым делать подобные штуки для Q&A пишите мне @MBurtsev

https://research.fb.com/publications/using-local-knowledge-graph-construction-to-scale-seq2seq-models-to-multi-document-inputs/

2019 October 27

We have released code for computing Convolutional Neural Tangent Kernel (CNTK) used in our paper "On Exact Computation with an Infinitely Wide Neural Net", which will appear in NeurIPS 2019.

Paper: https://arxiv.org/abs/1904.11955

Code: https://github.com/ruosongwang/CNTK

Via twitter.com/RuosongW/status/1188107700342788096

Paper: https://arxiv.org/abs/1904.11955

Code: https://github.com/ruosongwang/CNTK

Via twitter.com/RuosongW/status/1188107700342788096

So true...

2019 October 29

Переслано от viktor

2019 October 30

Sesame Street hash function collision

ERNIE by Baidu

ERNIE by Tsinghua University and Huawei

It’s funny that both papers are about knowledge graph integration to transformer pre-training and both from Chinese research groups.

ERNIE by Baidu

ERNIE by Tsinghua University and Huawei

It’s funny that both papers are about knowledge graph integration to transformer pre-training and both from Chinese research groups.

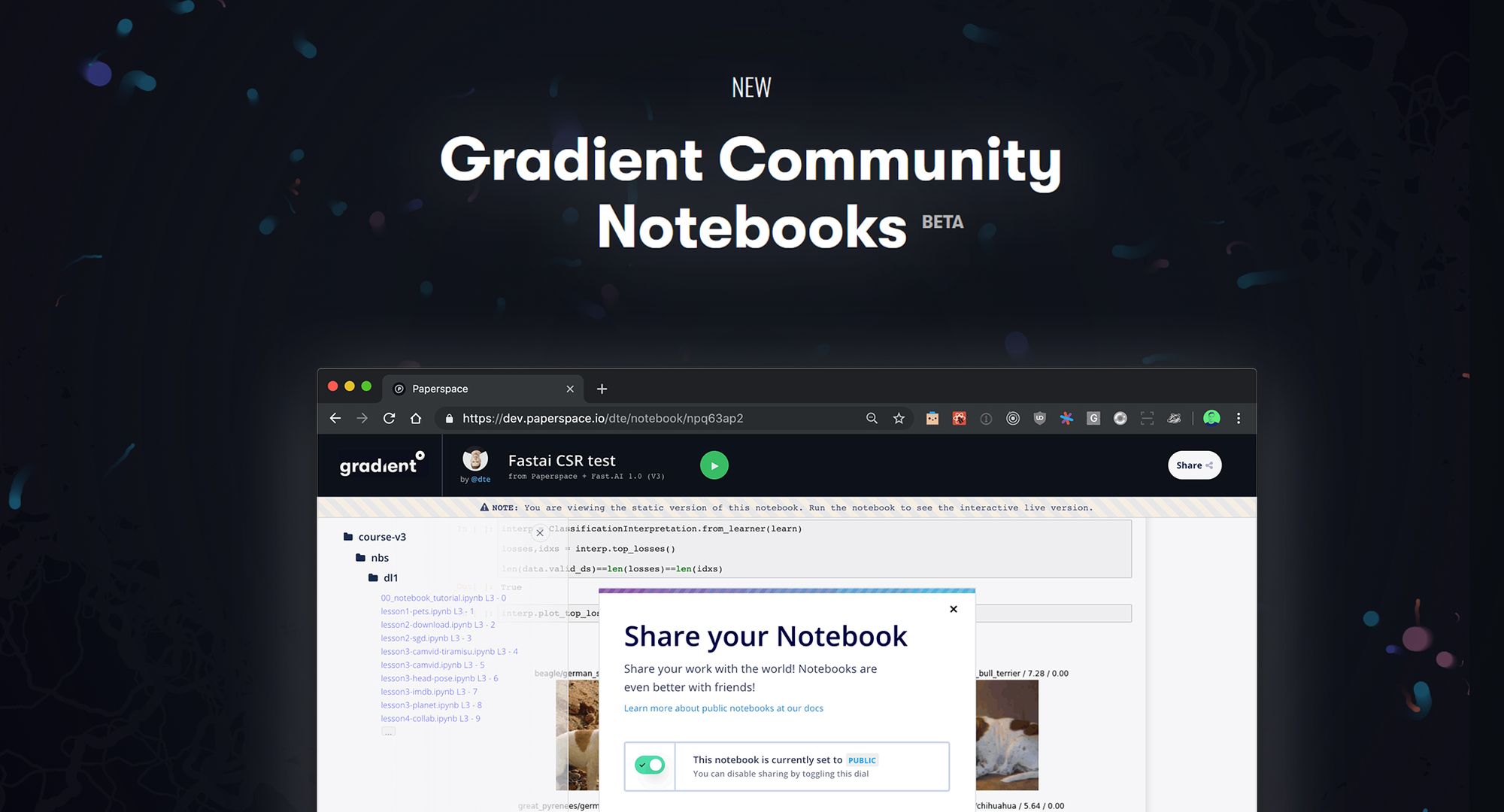

Free GPUs with a standard Jupyter Interface (bye colab!)