AS

Size: a a a

2020 February 02

Appa

Я вот как-то нарыл библиотеку Nvidia NCCL, типа она для multi-gpu вычислений, и может распараллеливать даже по нескольким узлам, по сети. Но опять же, это я так понимаю , примочка работающая в связке с cuda, TF уже поверх них обоих работает.

Так и в чем проблема?

AS

Она единое адресное пространство создает?

A

У меня такая же проблема, похоже что нельзя, линки между видяхами просто ускоряют копирование памяти между ними судя по всему. Хоровод єто к слову дата паралелізм, а не модел. Торч вроде имеет готовіе механізмі паралелизации

А что там у торча, что за мезанизмы? Дата параллелизация, типо аналог хоровода, или оно как-то автоматизирует разнесение слоёв по gpu чтоб не долбаться с чем-то вроде with tf.device?

A

Так и в чем проблема?

Проблема в том что это примочка к cuda, с ней должно идти взаимодействие через TF, а как там поддержка таких финтов реализованна - я не знаю.

AS

смотрю вот NVSwitch. везде увы только реклама без конкретики

Конкретика в том что у тебе память между устройствами копируется бістрее

AS

Appa

А что там у торча, что за мезанизмы? Дата параллелизация, типо аналог хоровода, или оно как-то автоматизирует разнесение слоёв по gpu чтоб не долбаться с чем-то вроде with tf.device?

Похоже что модел. https://github.com/NVIDIA/Megatron-LM/blob/master/README.md раздел model parallel

СВ

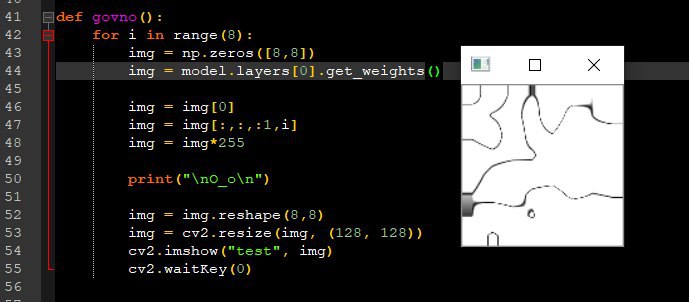

ребят, как вывести выход нейрона сверточного слоя. В прикрепе вывел карты признаков сверточного слоя. Теперь хочу подать на вход картинку и посмотреть что зажигается на карте признаков

LP

Всем привет! Подскажите, пожалуйста, существует ли датасет старого кириллистического алфавита? (Который применялся при печати до 1917 года, гражданский шрифт)

Может быть кто-то сталкивался?

Может быть кто-то сталкивался?

D🐈

Lubov Podkolzina

Всем привет! Подскажите, пожалуйста, существует ли датасет старого кириллистического алфавита? (Который применялся при печати до 1917 года, гражданский шрифт)

Может быть кто-то сталкивался?

Может быть кто-то сталкивался?

Датасет алфавита?

LP

Датасет алфавита?

Образцов написания букв из алфавита

y

Тут все ответы неверные

Т.е. ничего не нужно было выбирать?

y

Тут второй неверный

Почему второй не верен?

y

@Lepusculus И спасибо за ответ )

Λ

Т.е. ничего не нужно было выбирать?

1. добавить если линейно-зависимую фичу от имеющейся, например, что получится?

3. регуляризация штрафует веса; очень частая ситуация, что при добавлении её сильно снижаем метрику на трейне, но на тесте метрика тоже немного падает (оверфиттинг при этом сильно падает)

3. регуляризация штрафует веса; очень частая ситуация, что при добавлении её сильно снижаем метрику на трейне, но на тесте метрика тоже немного падает (оверфиттинг при этом сильно падает)

Λ

я не знаю, что имелось ввиду в этих вопросах, может, что-то из лекции следовало

Λ

Почему второй не верен?

Ну потому что аутпут -- это логистическая функция от линейной.

А регуляризацию мы добавляем в критерий качества.

А регуляризацию мы добавляем в критерий качества.

y

По первому вопросу, я не поверил, что все варианты неправильны, поэтому решил принять их логику: "Все делать как надо".

1. При добавлении еще одного показателя (фичи), всегда будет давать эквивалентный результат или лучше.

Как я понимаю - таких гарантий нельзя дать

3. Аналогично первому, нет гарантий

1. При добавлении еще одного показателя (фичи), всегда будет давать эквивалентный результат или лучше.

Как я понимаю - таких гарантий нельзя дать

3. Аналогично первому, нет гарантий

Λ

По первому вопросу, я не поверил, что все варианты неправильны, поэтому решил принять их логику: "Все делать как надо".

1. При добавлении еще одного показателя (фичи), всегда будет давать эквивалентный результат или лучше.

Как я понимаю - таких гарантий нельзя дать

3. Аналогично первому, нет гарантий

1. При добавлении еще одного показателя (фичи), всегда будет давать эквивалентный результат или лучше.

Как я понимаю - таких гарантий нельзя дать

3. Аналогично первому, нет гарантий

Я так подозреваю, что они имели ввиду п.1 всё-таки

Λ

логика может быть такая: мы добавляем как угодно распределённую дополнительную степень свободы, это позволяет искать в т.ч. несуществующие зависимости, увеличивает переподгонку и увеличивает качество на трейне

y

Даже, если так, то добавление фичи не гарантирует же нам, что результат тестовой модели будет лучше?