I

Size: a a a

2020 February 02

Скидывай посмотрим)

GG

Пошли советчики. Пандас умеет читать чанками, так что все вполне можно уместить в память, причем с ростом датасета затраты памяти будут статичны.

mmap нужен

GG

а вот с пандасми и нумпи там нюансы

R

Кому нужен датасет 2019-ncov?

Что за датасет?

IM

Что за датасет?

Количество зараженных погибших и прочее на которой строят модель для сайтега

R

Херня это. Надо по дням

R

И больше столбцов

IM

Там как раз по дням)

R

А да не заметил страницы

IM

Инфу еще таскают с министерств но это самые оперативные данные

A

Посоны, хотел бы опять поднять тему model parallelism-а. Пытаюсь файнтюнить модель, и мне не хватает 16 гигов на одной видюхе. Опчитавшись про модненькие GPU V100, что для них на серверах предусмотрены NVSwitch для межпроцессорной коммуникации, у меня в голове сложилось мнение, что несколько GPU V100 работают и видимы для процесса как одна большая видеокарта, и никаких дополнительных телодвижений делать не надо чтоб модель жила сразу на нескольких видюхах. Но недавний эксперимент с aws инстансом на 4 видеокарты показал что это не так. В nvtop я вижу 4 отдельных видюхи. Из них грузится под завязку только одна, и потом процесс вылетает на memory_allocation. Есть ли возможность реализовать параллелизм без плясок с бубном, ручным разбиением модели по GPU с помощью with tf.device или всяких хороводов? При том что ни то ни другое не реализует настоящий параллелизм.

A

Ах да, использую TF2.1

Λ

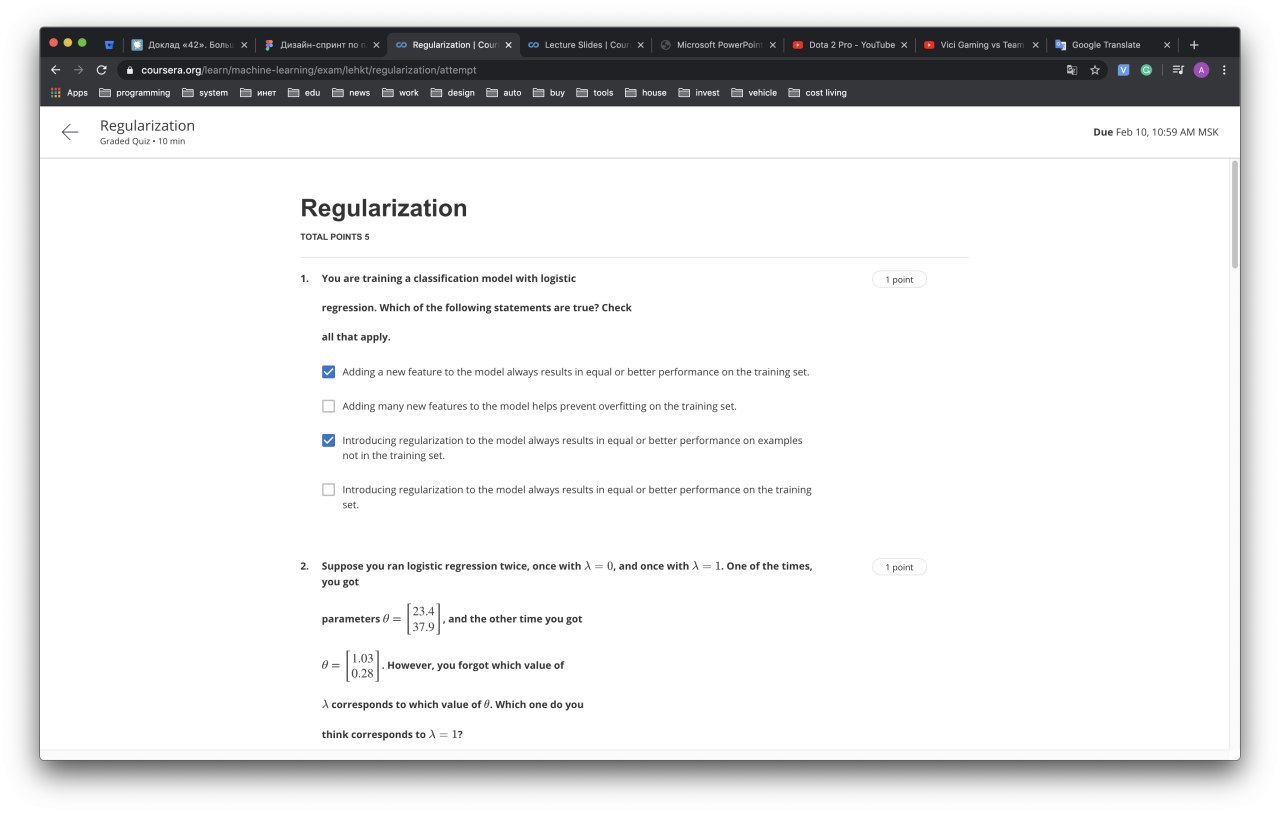

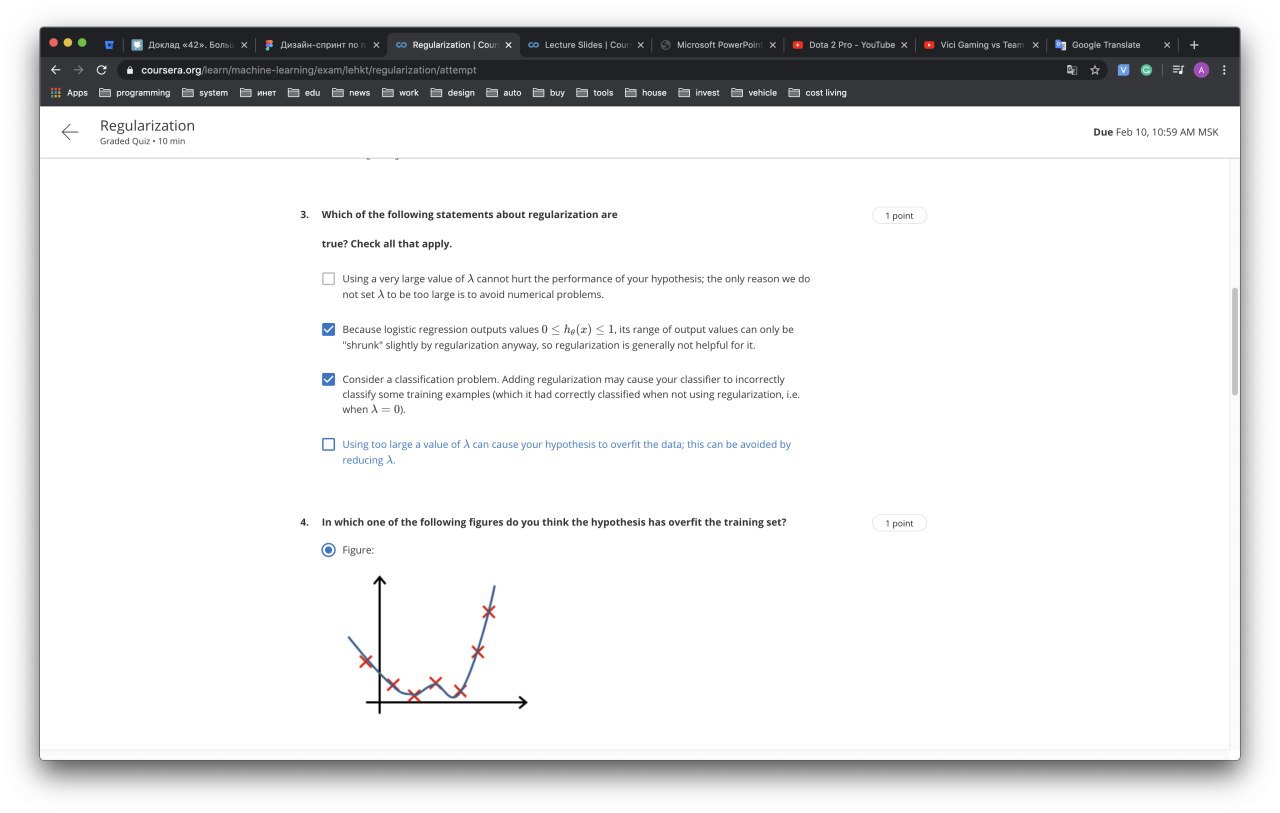

Тут все ответы неверные

Λ

Второй не верный, т.к. нормализацию мы делаем до того, как регресию будем делать? И соотвественно выравнивание не имеет смысла?

Тут второй неверный

DB

Appa

Посоны, хотел бы опять поднять тему model parallelism-а. Пытаюсь файнтюнить модель, и мне не хватает 16 гигов на одной видюхе. Опчитавшись про модненькие GPU V100, что для них на серверах предусмотрены NVSwitch для межпроцессорной коммуникации, у меня в голове сложилось мнение, что несколько GPU V100 работают и видимы для процесса как одна большая видеокарта, и никаких дополнительных телодвижений делать не надо чтоб модель жила сразу на нескольких видюхах. Но недавний эксперимент с aws инстансом на 4 видеокарты показал что это не так. В nvtop я вижу 4 отдельных видюхи. Из них грузится под завязку только одна, и потом процесс вылетает на memory_allocation. Есть ли возможность реализовать параллелизм без плясок с бубном, ручным разбиением модели по GPU с помощью with tf.device или всяких хороводов? При том что ни то ни другое не реализует настоящий параллелизм.

я на 100% не скажу конечно. но мне кажется что такое невозможно - так как нужен доступ любым ядром любой видюхи к любому куску общей памяти иначе не будет работать. насколько мне представляется, то железо во всяком случае пока не заточено под такое

DB

могу ошибаться. далеко не эксперт. но вот так думается

AS

Appa

Посоны, хотел бы опять поднять тему model parallelism-а. Пытаюсь файнтюнить модель, и мне не хватает 16 гигов на одной видюхе. Опчитавшись про модненькие GPU V100, что для них на серверах предусмотрены NVSwitch для межпроцессорной коммуникации, у меня в голове сложилось мнение, что несколько GPU V100 работают и видимы для процесса как одна большая видеокарта, и никаких дополнительных телодвижений делать не надо чтоб модель жила сразу на нескольких видюхах. Но недавний эксперимент с aws инстансом на 4 видеокарты показал что это не так. В nvtop я вижу 4 отдельных видюхи. Из них грузится под завязку только одна, и потом процесс вылетает на memory_allocation. Есть ли возможность реализовать параллелизм без плясок с бубном, ручным разбиением модели по GPU с помощью with tf.device или всяких хороводов? При том что ни то ни другое не реализует настоящий параллелизм.

У меня такая же проблема, похоже что нельзя, линки между видяхами просто ускоряют копирование памяти между ними судя по всему. Хоровод єто к слову дата паралелізм, а не модел. Торч вроде имеет готовіе механізмі паралелизации

DB

смотрю вот NVSwitch. везде увы только реклама без конкретики

A

смотрю вот NVSwitch. везде увы только реклама без конкретики

Я вот как-то нарыл библиотеку Nvidia NCCL, типа она для multi-gpu вычислений, и может распараллеливать даже по нескольким узлам, по сети. Но опять же, это я так понимаю , примочка работающая в связке с cuda, TF уже поверх них обоих работает.