VY

Size: a a a

2021 February 28

Роман Жарков

Пардон за удаление части дискуссии, но я не смог отказать хаму(хамке?) в просьбе забанить.

правильно. сразу надо было сделать, это совсем не красит ни дискуссию, ни канал.

М

Ребята привет

Я из командной строки делаю апдейт и returning

Дальше хочу в баше работать с ответом

Но он мне пишет (UPDATED 10) в конце.

Как убрать все кроме данных?

Хедеры убрал -t

А как это убрать?

Я из командной строки делаю апдейт и returning

Дальше хочу в баше работать с ответом

Но он мне пишет (UPDATED 10) в конце.

Как убрать все кроме данных?

Хедеры убрал -t

А как это убрать?

VY

Ребята привет

Я из командной строки делаю апдейт и returning

Дальше хочу в баше работать с ответом

Но он мне пишет (UPDATED 10) в конце.

Как убрать все кроме данных?

Хедеры убрал -t

А как это убрать?

Я из командной строки делаю апдейт и returning

Дальше хочу в баше работать с ответом

Но он мне пишет (UPDATED 10) в конце.

Как убрать все кроме данных?

Хедеры убрал -t

А как это убрать?

psql -qAtX ?М

psql -qAtX ?Огонь

Бальшое спасибо

Бальшое спасибо

AL

есть разница, сегодняшние которые идут учится по ИТ - они в основном хорошо мотивированные, и не только те кто платит деньги а и бюджетники тоже.

> всё сильно поменялось.

качествено может быть студенты и поменялись (думаю это все же зависит от региона), но чтобы стать хорошим специлистом - что сейчас, что 20 лет назад - нужна мотивация. В этом плане ничего не поменялось)) хочешь быть специалистом - учись, развивайся, вкалывай.

Сегодня учиться стало проще, есть интернет, есть сообщества.

качествено может быть студенты и поменялись (думаю это все же зависит от региона), но чтобы стать хорошим специлистом - что сейчас, что 20 лет назад - нужна мотивация. В этом плане ничего не поменялось)) хочешь быть специалистом - учись, развивайся, вкалывай.

Сегодня учиться стало проще, есть интернет, есть сообщества.

OB

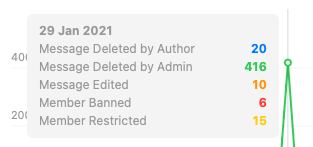

Админы, что за бойня была 29 января ?

AT

Коллеги, а можно соцопрос? :)

Есть таблица на 30 полей и 150М строк. Одно из полей - date, индексов на нем нет.

Таблицу постоянно кто-то читает, некоторые читатели забирают и это самое поле, но таких меньшинство. И в таблицу раз 10-20 в минуту приходит либо insert, который про это конкретное поле date ничего не знает (default null), либо update, который про поле тоже ничего не знает и не трогает. Нужно обновить этому полю 50М значений из внешней таблицы не потеряв набегающие данные писателей и не ввергнув читателей в коматоз ожидания io, например.

Есть два доступных пути решения:

1. Клонировать таблицу, накатывать изменения поля из внешней таблицы, подменять таблицу и доливать в нее изменения, которые успели произойти в оригинале. Так уже пару раз делали, опыт есть.

2. Сделать update в лоб из внешней таблицы.

Соцопрос в следующем: что бы выбрать?

Есть таблица на 30 полей и 150М строк. Одно из полей - date, индексов на нем нет.

Таблицу постоянно кто-то читает, некоторые читатели забирают и это самое поле, но таких меньшинство. И в таблицу раз 10-20 в минуту приходит либо insert, который про это конкретное поле date ничего не знает (default null), либо update, который про поле тоже ничего не знает и не трогает. Нужно обновить этому полю 50М значений из внешней таблицы не потеряв набегающие данные писателей и не ввергнув читателей в коматоз ожидания io, например.

Есть два доступных пути решения:

1. Клонировать таблицу, накатывать изменения поля из внешней таблицы, подменять таблицу и доливать в нее изменения, которые успели произойти в оригинале. Так уже пару раз делали, опыт есть.

2. Сделать update в лоб из внешней таблицы.

Соцопрос в следующем: что бы выбрать?

VY

Andrey Tatarnikov

Коллеги, а можно соцопрос? :)

Есть таблица на 30 полей и 150М строк. Одно из полей - date, индексов на нем нет.

Таблицу постоянно кто-то читает, некоторые читатели забирают и это самое поле, но таких меньшинство. И в таблицу раз 10-20 в минуту приходит либо insert, который про это конкретное поле date ничего не знает (default null), либо update, который про поле тоже ничего не знает и не трогает. Нужно обновить этому полю 50М значений из внешней таблицы не потеряв набегающие данные писателей и не ввергнув читателей в коматоз ожидания io, например.

Есть два доступных пути решения:

1. Клонировать таблицу, накатывать изменения поля из внешней таблицы, подменять таблицу и доливать в нее изменения, которые успели произойти в оригинале. Так уже пару раз делали, опыт есть.

2. Сделать update в лоб из внешней таблицы.

Соцопрос в следующем: что бы выбрать?

Есть таблица на 30 полей и 150М строк. Одно из полей - date, индексов на нем нет.

Таблицу постоянно кто-то читает, некоторые читатели забирают и это самое поле, но таких меньшинство. И в таблицу раз 10-20 в минуту приходит либо insert, который про это конкретное поле date ничего не знает (default null), либо update, который про поле тоже ничего не знает и не трогает. Нужно обновить этому полю 50М значений из внешней таблицы не потеряв набегающие данные писателей и не ввергнув читателей в коматоз ожидания io, например.

Есть два доступных пути решения:

1. Клонировать таблицу, накатывать изменения поля из внешней таблицы, подменять таблицу и доливать в нее изменения, которые успели произойти в оригинале. Так уже пару раз делали, опыт есть.

2. Сделать update в лоб из внешней таблицы.

Соцопрос в следующем: что бы выбрать?

3-й вариант: выбирать пачки записей ограниченного размера (10 000) вдоль какого-нить индекса (PK) у котороых искомое поле IS NULL, менять. повторять пока всё не измените

YS

Andrey Tatarnikov

Коллеги, а можно соцопрос? :)

Есть таблица на 30 полей и 150М строк. Одно из полей - date, индексов на нем нет.

Таблицу постоянно кто-то читает, некоторые читатели забирают и это самое поле, но таких меньшинство. И в таблицу раз 10-20 в минуту приходит либо insert, который про это конкретное поле date ничего не знает (default null), либо update, который про поле тоже ничего не знает и не трогает. Нужно обновить этому полю 50М значений из внешней таблицы не потеряв набегающие данные писателей и не ввергнув читателей в коматоз ожидания io, например.

Есть два доступных пути решения:

1. Клонировать таблицу, накатывать изменения поля из внешней таблицы, подменять таблицу и доливать в нее изменения, которые успели произойти в оригинале. Так уже пару раз делали, опыт есть.

2. Сделать update в лоб из внешней таблицы.

Соцопрос в следующем: что бы выбрать?

Есть таблица на 30 полей и 150М строк. Одно из полей - date, индексов на нем нет.

Таблицу постоянно кто-то читает, некоторые читатели забирают и это самое поле, но таких меньшинство. И в таблицу раз 10-20 в минуту приходит либо insert, который про это конкретное поле date ничего не знает (default null), либо update, который про поле тоже ничего не знает и не трогает. Нужно обновить этому полю 50М значений из внешней таблицы не потеряв набегающие данные писателей и не ввергнув читателей в коматоз ожидания io, например.

Есть два доступных пути решения:

1. Клонировать таблицу, накатывать изменения поля из внешней таблицы, подменять таблицу и доливать в нее изменения, которые успели произойти в оригинале. Так уже пару раз делали, опыт есть.

2. Сделать update в лоб из внешней таблицы.

Соцопрос в следующем: что бы выбрать?

Неважно же, забирают читатели это поле, и "трогают" ли его UPDATE — в PostgreSQL всё происходит на уровне записей, грубо говоря.

> не потеряв набегающие данные писателей и не ввергнув читателей в коматоз ожидания io

Тут уже от "железа" зависит. А точно стоит "заморачиваться" на таких объёмах?

Т.е. какой там размер этой таблицы / индексов, в самом деле — может, всё это будет достаточно быстро и не "тяжело" и так?

> не потеряв набегающие данные писателей и не ввергнув читателей в коматоз ожидания io

Тут уже от "железа" зависит. А точно стоит "заморачиваться" на таких объёмах?

Т.е. какой там размер этой таблицы / индексов, в самом деле — может, всё это будет достаточно быстро и не "тяжело" и так?

AT

3-й вариант: выбирать пачки записей ограниченного размера (10 000) вдоль какого-нить индекса (PK) у котороых искомое поле IS NULL, менять. повторять пока всё не измените

Нет гарантии, что где у целевого Pk есть обновлённое значение, в изначальной таблице null

AT

Yaroslav Schekin

Неважно же, забирают читатели это поле, и "трогают" ли его UPDATE — в PostgreSQL всё происходит на уровне записей, грубо говоря.

> не потеряв набегающие данные писателей и не ввергнув читателей в коматоз ожидания io

Тут уже от "железа" зависит. А точно стоит "заморачиваться" на таких объёмах?

Т.е. какой там размер этой таблицы / индексов, в самом деле — может, всё это будет достаточно быстро и не "тяжело" и так?

> не потеряв набегающие данные писателей и не ввергнув читателей в коматоз ожидания io

Тут уже от "железа" зависит. А точно стоит "заморачиваться" на таких объёмах?

Т.е. какой там размер этой таблицы / индексов, в самом деле — может, всё это будет достаточно быстро и не "тяжело" и так?

40Гб данных и столько же индексов

AT

Какая часть индексных данных есть мусор так сходу не сказать

YS

Andrey Tatarnikov

40Гб данных и столько же индексов

Ну так это немного, при нормальном "железе".

Вам должно быть виднее, сколько там ресурсов и сколько это примерно займёт.

Вам должно быть виднее, сколько там ресурсов и сколько это примерно займёт.

VY

Andrey Tatarnikov

Нет гарантии, что где у целевого Pk есть обновлённое значение, в изначальной таблице null

что?

вам надо обновить всё. идёте вдоль индекса по всей таблице. потом обновляете то, что навставляли/наизменяли другие сессии.

кстати, какой конечный результат требуется?

вам надо обновить всё. идёте вдоль индекса по всей таблице. потом обновляете то, что навставляли/наизменяли другие сессии.

кстати, какой конечный результат требуется?

AT

что?

вам надо обновить всё. идёте вдоль индекса по всей таблице. потом обновляете то, что навставляли/наизменяли другие сессии.

кстати, какой конечный результат требуется?

вам надо обновить всё. идёте вдоль индекса по всей таблице. потом обновляете то, что навставляли/наизменяли другие сессии.

кстати, какой конечный результат требуется?

Я, видимо, не до конца понял про is null. В целевой таблице значение есть у ~70М строк. В патче - 50М. Для части строк целевой таблице в патче изменения существующего значения, для части сейчас null, но значение есть в патче

VY

Andrey Tatarnikov

Я, видимо, не до конца понял про is null. В целевой таблице значение есть у ~70М строк. В патче - 50М. Для части строк целевой таблице в патче изменения существующего значения, для части сейчас null, но значение есть в патче

я не понимаю, что значит “патч”.

также непонятен конечный результат: изменить все записи таблицы, проставив колонке "date" какое-то значение ( плохой выбор названия у колонки )?

также непонятен конечный результат: изменить все записи таблицы, проставив колонке "date" какое-то значение ( плохой выбор названия у колонки )?

AT

я не понимаю, что значит “патч”.

также непонятен конечный результат: изменить все записи таблицы, проставив колонке "date" какое-то значение ( плохой выбор названия у колонки )?

также непонятен конечный результат: изменить все записи таблицы, проставив колонке "date" какое-то значение ( плохой выбор названия у колонки )?

Есть таблица, у нее есть поле с типом date. В нем есть значения у 70М из 150М строк. Есть файлик, в котором для 50М строк лежат новые значения этого поля. Файлик через copy закинут во временную таблицу. Нужно обновить значения в поле в целевой значениями из файлика. В файлике, и соответственно во временной таблице, куда его закгрузило, для каждого значения рядом указано значение Pk строки целевой таблицы

кн

Andrey Tatarnikov

Есть таблица, у нее есть поле с типом date. В нем есть значения у 70М из 150М строк. Есть файлик, в котором для 50М строк лежат новые значения этого поля. Файлик через copy закинут во временную таблицу. Нужно обновить значения в поле в целевой значениями из файлика. В файлике, и соответственно во временной таблице, куда его закгрузило, для каждого значения рядом указано значение Pk строки целевой таблицы

кажется что без скрипта тут не обойтись в котором бачами апдейтить.

AT

Долго. Пока кажется, что подменить таблицу быстрее

ФГ

Andrey Tatarnikov

Есть таблица, у нее есть поле с типом date. В нем есть значения у 70М из 150М строк. Есть файлик, в котором для 50М строк лежат новые значения этого поля. Файлик через copy закинут во временную таблицу. Нужно обновить значения в поле в целевой значениями из файлика. В файлике, и соответственно во временной таблице, куда его закгрузило, для каждого значения рядом указано значение Pk строки целевой таблицы

Ну я б бежал и апдейтил или по одному ночью или батчами по 100.(1000,10000 )

Опытным путем

Хотя м.б долго

Надо смотреть скорость и насколько критично чтобы все было закончено скажем за ночь

Опытным путем

Хотя м.б долго

Надо смотреть скорость и насколько критично чтобы все было закончено скажем за ночь