SS

Size: a a a

2020 December 14

* грязный чан наполнился, чистый - нет, оффсеты откатились

SS

призываю гуру из Databricks!

e

через foreachBatch? нет гарантий атомарности... батрак черпанул один раз. влил в грязный чан и сдох от работы. чистый чан не дозаполнился, а оффсеты уже сдвинулись

Напилить партиций что бы гарантировать в размер памяти ? Читать чанками по 100к записей ?

R

> через foreachBatch не хочу - там нет атомарности двух df.write (или есть?)

нет атомарности, если посередине батча упадет, df2.write может не случиться

нет атомарности, если посередине батча упадет, df2.write может не случиться

R

но есть операция внутри foreachBatch идемпотентная, то все норм

SS

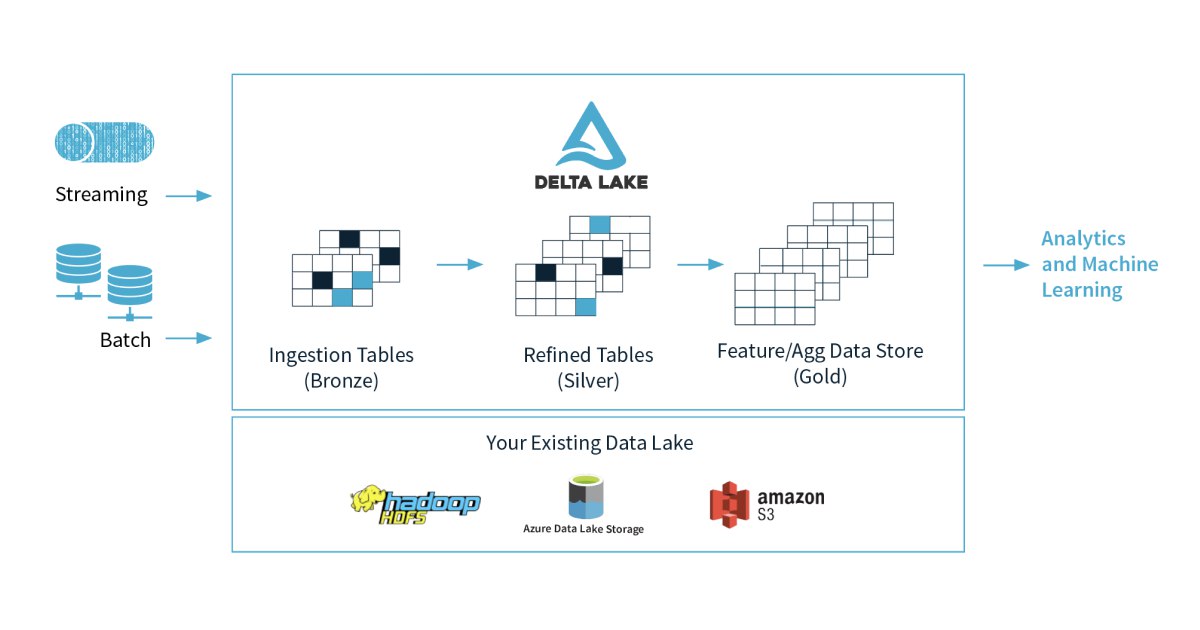

это вы к Delta-формату подводите? ))

SS

согласен. это бы решило проблему!

но на OSS версии не взлетает ((

но на OSS версии не взлетает ((

SS

или наплевать и допускать наличие дубликатов в бронзовом слое? их все равно можно определить по partition/offset из Кафки

S

Во всей истории, непонятно, почему эти процессы должны быть объединены.

Результат - разный, вычисления разные, взаимное влияние - нет и не должно быть, экономия ресурсов - нет

Результат - разный, вычисления разные, взаимное влияние - нет и не должно быть, экономия ресурсов - нет

S

Количество кода?

R

эмм, ну бронза она как бы по дизайну без трансформаций.

в идеальном мире она заполняется так:

в идеальном мире она заполняется так:

spark.readStream.format("kafka").load().writeStream.format("delta or your cool file format").save("/your/path")ME

Пс, а бронза и прочие металлы это что за модель?

ME

Спасибо)

А

Потом плохо от числа файлов не станет?

SS

Во всей истории, непонятно, почему эти процессы должны быть объединены.

Результат - разный, вычисления разные, взаимное влияние - нет и не должно быть, экономия ресурсов - нет

Результат - разный, вычисления разные, взаимное влияние - нет и не должно быть, экономия ресурсов - нет

а может действительно, пусть два разных черпаря работают. по разным сторонам реки

S

Потом плохо от числа файлов не станет?

Станет конеш

Ссд вникнуть и зажить

Ссд вникнуть и зажить

SS

Потом плохо от числа файлов не станет?

а мы их ночью скомпактим, сразу после ночного прогона заполнения batch layer (по lambda-архитектуре)

R

Потом плохо от числа файлов не станет?

внутри Databricks - OPTIMIZE, вне - .read.repartition(X).mode("overwrite")

А

внутри Databricks - OPTIMIZE, вне - .read.repartition(X).mode("overwrite")

Понятно, думал, совсем нельзя трогать бронзовый слой