DP

Size: a a a

2021 January 13

как с нейронками

DP

или с линрегрессией, которую используют именно чтобы получить легко трактуемые коэффициенты

i

Да вопрос что важнее

i

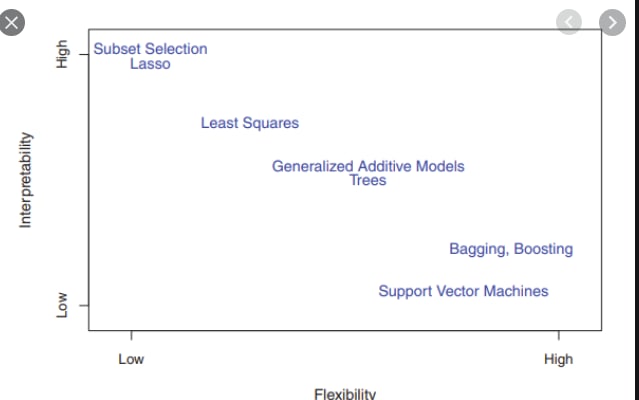

Interpretability or flexibility

АГ

или с линрегрессией, которую используют именно чтобы получить легко трактуемые коэффициенты

Ну тогда только простая селекция по R2, порог 0.9-0.95,и всё. А с бустингами и нейронками, которые на таблицы ориентированы, вопрос. Тут все перечисленные методы должны сгодиться, но тут лишь для уменьшения размерности признакового пространства и скорости работы модели. Вопрос, что быстрее. Но в качестве на тесте такая селекция не особо мне помогала, даже наоборот, ведь немного информации все же теряется, не строгая же мультиколлинеарность..

K

или с линрегрессией, которую используют именно чтобы получить легко трактуемые коэффициенты

Ну не всегда ее именно для интерпретации используют. Иногда данных настолько мало, что деревяшки и сети становятся почти недоступными. И конкурентами лин моделей могут быть такие же простые модельки по типу svm

DP

Ну не всегда ее именно для интерпретации используют. Иногда данных настолько мало, что деревяшки и сети становятся почти недоступными. И конкурентами лин моделей могут быть такие же простые модельки по типу svm

да, согласен. Есть кейсы.

i

Svm не такая же простая модель как линейная регрессия

АГ

Ну да, штука полезная для скорости сходимости град спуска в сетях. На практике, как я понимаю, ограничиваются лишь процедурой стандартизации инпута, ну и батч нормализацией в скрытых слоях глубоких сетей. Ну из того, что я видел и пробовал, конечно.

K

Svm не такая же простая модель как линейная регрессия

Что понимаем под простотой? Я имел в виду сложность разделяющей гиперплоскости. Если не учитывать Kernel trick, то в svm — она линейна, поэтому и назвал простой.

K

Артём Глазунов

Ну да, штука полезная для скорости сходимости град спуска в сетях. На практике, как я понимаю, ограничиваются лишь процедурой стандартизации инпута, ну и батч нормализацией в скрытых слоях глубоких сетей. Ну из того, что я видел и пробовал, конечно.

Ещё веса нормируют вроде тоже

i

i

SVM сложная по отношению к ЛР

i

разные углы

K

Тут очевидно учитывается kernel trick.

K

Но так-то я и в лин модели могу добавить всякие полиномы высоких порядков, перейти в спрямляющее пространство, и тогда лин модель тоже сможет восстанавливать не линейные зависимости до какой-то меры

K

Ну и картинка до какой-то меры спорная. Считать свм - неинтерпретируемой моделью странно. Как минимум мы узнаем объекты (опорные векторы), по которым проходит по сути разделение классов. Вполне себе тоже в некотором роде интерпретация

i

помне не спорная.

DP

очень сильно зависит от svm

DP

и ядра