J

Size: a a a

2020 September 21

Ivan

Что понимается под посещением точки? Что в нее приехали и из нее уехали (конец и начало маршрута) или что через нее проехали на маршруте?

конец

I

Тогда все еще проще. Делим город на сетку с некоторым шагом (размер шага выбираем исходя из требования "чтобы не повторялись), затем считаем количество точек в каждой ячейке сетки и количество ее посещений, получаем количество посещений всей ячейки. ЗАтем выбираем топ-н и рисуем их на карте

J

Ivan

Тогда все еще проще. Делим город на сетку с некоторым шагом (размер шага выбираем исходя из требования "чтобы не повторялись), затем считаем количество точек в каждой ячейке сетки и количество ее посещений, получаем количество посещений всей ячейки. ЗАтем выбираем топ-н и рисуем их на карте

thank u a lot)

J

КЧ

Знаю, что очень тупой вопрос, но можно ли корреляцию искать в задаче бинарной классификации ?

То есть если есть переменный и целевая переменная ?

То есть если есть переменный и целевая переменная ?

П

Можно. Более того, классификация это и есть поиск корреляции

КЧ

Павел

Можно. Более того, классификация это и есть поиск корреляции

Хм...круто

2020 September 22

СВ

Переслано от Сергей Васильев...

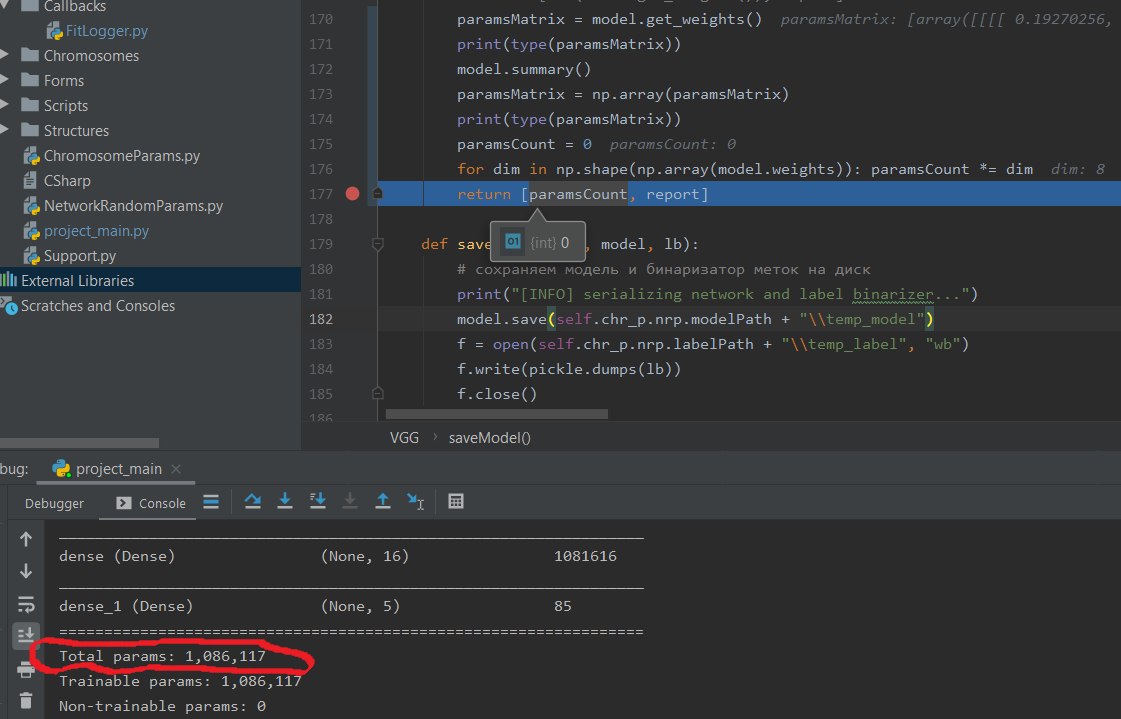

Как получить значение Total params(печатается при вызове model.summary()) у tf.keras.model.Sequential? Мне когда то советовали взять len(model.weights), я шел по этому пути и уткнулся в тупик(скрин)

VC

Привет, есть какая-нибудь статья, где все трансформеры описаны и их отличия, как по ганам.

CT

От гугла недавно была

CT

Efficient Transformers: A Survey

Tay et al. [Google Research]

arxiv.org/abs/2009.06732

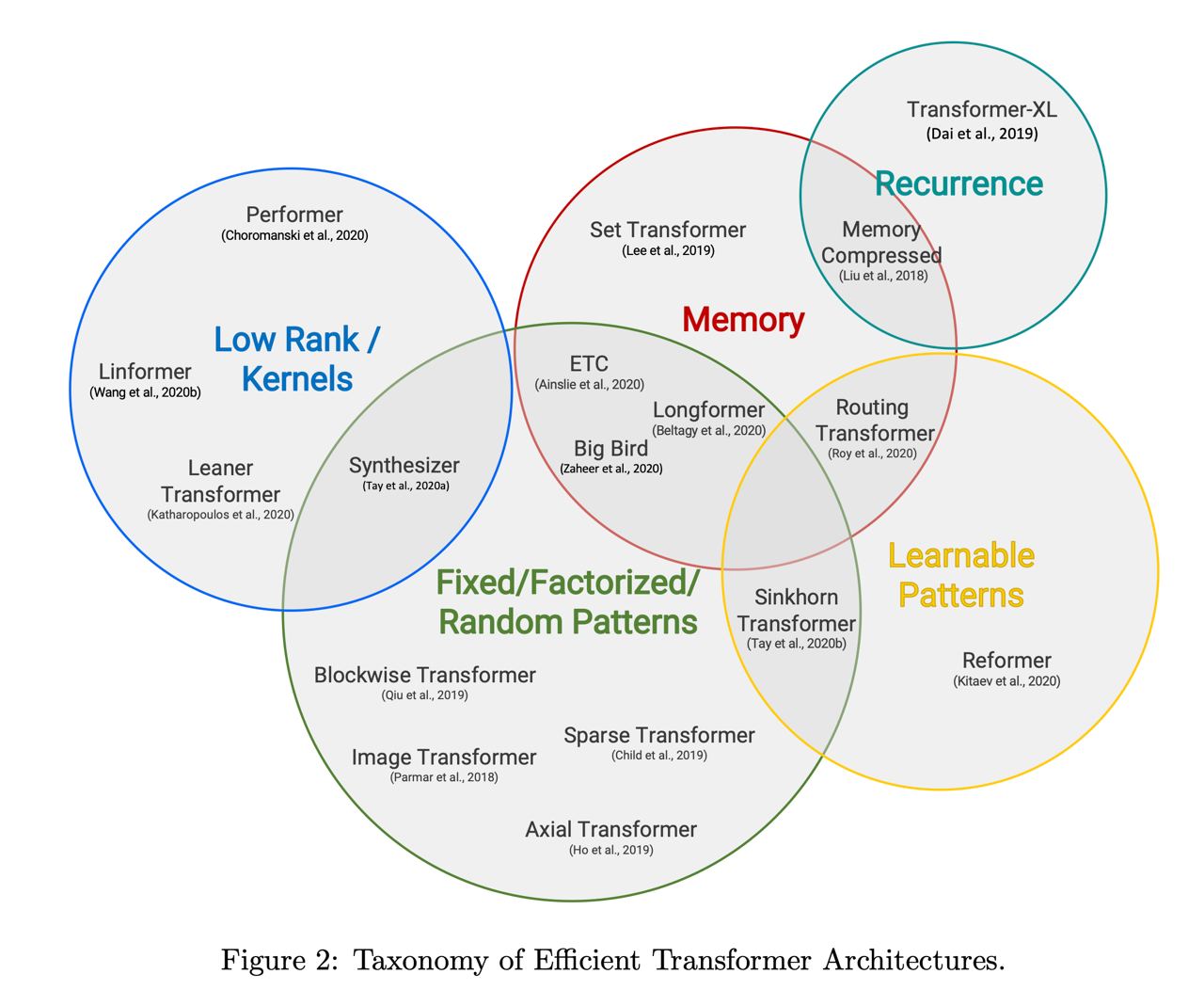

За прошлые два года число различных модификаций трансформера резко выросло. В частности была куча статей, которые пытаются адаптировать трансформеры для длинных текстов: reformer, longformer, linformer, ...

Google Research решил сделать небольшую статью с обзором этих X-former. Они суммаризируют, что изначально люди активно занимались фиксированными паттернами atttention (Sparse Transformer et al.), потом начали заниматься факторизацией этих паттернов (Axial transformer et al.) и постепенно сдвинулись в хитрые тренируемые паттерны (Reformer et al.). Сейчас же появляется всё больше работ, в которых пытаются использовать ризкоранговую аппроксимацию матриц attention (Linformer).

В параллель к этому появилось пара реккурентрых подходов удлинения трансформеров - Transformer-XL и Compressive Transformer.

Как всегда в таких обзорах, они заканчиваются тем, что нету никакого стандартного метода сравнения методов друг с другом, кто-то использует генеративные задачи (LM), кто-то GLUE и что в конце-концов не ясно какой подход работает лучше остальных.

Мне из статьи очень понравилась вот эта картинка, которая хорошо суммаризирует основные подходы.

Tay et al. [Google Research]

arxiv.org/abs/2009.06732

За прошлые два года число различных модификаций трансформера резко выросло. В частности была куча статей, которые пытаются адаптировать трансформеры для длинных текстов: reformer, longformer, linformer, ...

Google Research решил сделать небольшую статью с обзором этих X-former. Они суммаризируют, что изначально люди активно занимались фиксированными паттернами atttention (Sparse Transformer et al.), потом начали заниматься факторизацией этих паттернов (Axial transformer et al.) и постепенно сдвинулись в хитрые тренируемые паттерны (Reformer et al.). Сейчас же появляется всё больше работ, в которых пытаются использовать ризкоранговую аппроксимацию матриц attention (Linformer).

В параллель к этому появилось пара реккурентрых подходов удлинения трансформеров - Transformer-XL и Compressive Transformer.

Как всегда в таких обзорах, они заканчиваются тем, что нету никакого стандартного метода сравнения методов друг с другом, кто-то использует генеративные задачи (LM), кто-то GLUE и что в конце-концов не ясно какой подход работает лучше остальных.

Мне из статьи очень понравилась вот эта картинка, которая хорошо суммаризирует основные подходы.

VC

Efficient Transformers: A Survey

Tay et al. [Google Research]

arxiv.org/abs/2009.06732

За прошлые два года число различных модификаций трансформера резко выросло. В частности была куча статей, которые пытаются адаптировать трансформеры для длинных текстов: reformer, longformer, linformer, ...

Google Research решил сделать небольшую статью с обзором этих X-former. Они суммаризируют, что изначально люди активно занимались фиксированными паттернами atttention (Sparse Transformer et al.), потом начали заниматься факторизацией этих паттернов (Axial transformer et al.) и постепенно сдвинулись в хитрые тренируемые паттерны (Reformer et al.). Сейчас же появляется всё больше работ, в которых пытаются использовать ризкоранговую аппроксимацию матриц attention (Linformer).

В параллель к этому появилось пара реккурентрых подходов удлинения трансформеров - Transformer-XL и Compressive Transformer.

Как всегда в таких обзорах, они заканчиваются тем, что нету никакого стандартного метода сравнения методов друг с другом, кто-то использует генеративные задачи (LM), кто-то GLUE и что в конце-концов не ясно какой подход работает лучше остальных.

Мне из статьи очень понравилась вот эта картинка, которая хорошо суммаризирует основные подходы.

Tay et al. [Google Research]

arxiv.org/abs/2009.06732

За прошлые два года число различных модификаций трансформера резко выросло. В частности была куча статей, которые пытаются адаптировать трансформеры для длинных текстов: reformer, longformer, linformer, ...

Google Research решил сделать небольшую статью с обзором этих X-former. Они суммаризируют, что изначально люди активно занимались фиксированными паттернами atttention (Sparse Transformer et al.), потом начали заниматься факторизацией этих паттернов (Axial transformer et al.) и постепенно сдвинулись в хитрые тренируемые паттерны (Reformer et al.). Сейчас же появляется всё больше работ, в которых пытаются использовать ризкоранговую аппроксимацию матриц attention (Linformer).

В параллель к этому появилось пара реккурентрых подходов удлинения трансформеров - Transformer-XL и Compressive Transformer.

Как всегда в таких обзорах, они заканчиваются тем, что нету никакого стандартного метода сравнения методов друг с другом, кто-то использует генеративные задачи (LM), кто-то GLUE и что в конце-концов не ясно какой подход работает лучше остальных.

Мне из статьи очень понравилась вот эта картинка, которая хорошо суммаризирует основные подходы.

Спасибо

VC

Сейчас почитаю, и вот ещё один вопрос вброшу. Тестировали polynote и альтернативные Юпитеру редакторы

PS

Ребят помогите. Сказали сделать небольшую работу через excel. Суть такова есть два столба которые по некоторым значениям равны. К первому столбцу еще прикреплены некие значения. Нужно написать функцию на соответствие значений этих столбцов и вытащить при соответствие нужное значение. Прям хелп большой прошу

СВ

Переслано от Сергей Васильев...

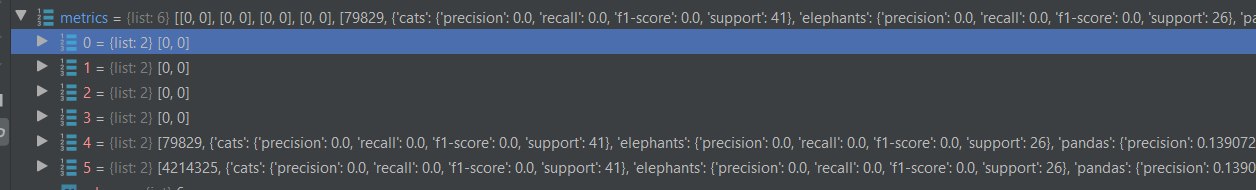

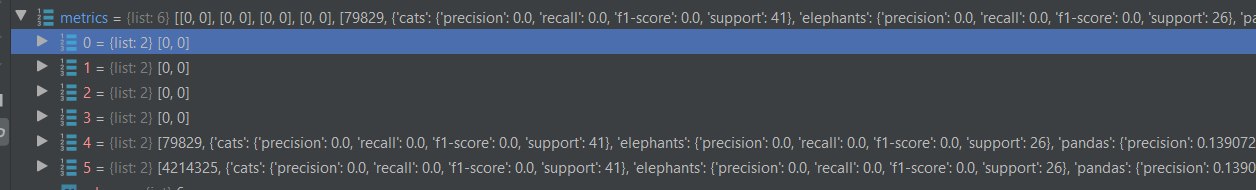

в каких случаях sklearn.metrics.cassification_report(..., output_dict=True) может возвращать 0?

З.Ы. На скрине report =

З.Ы. На скрине report =

metrics[i][1]DC

Переслано от Сергей Васильев

в каких случаях sklearn.metrics.cassification_report(..., output_dict=True) может возвращать 0?

З.Ы. На скрине report =

З.Ы. На скрине report =

metrics[i][1]Выглядит так, что он ничего не предсказывал. Confusion matrix можно посмотреть?

СВ

Выглядит так, что он ничего не предсказывал. Confusion matrix можно посмотреть?

забавно, что я каждый из этих репортов печатал в консоль - все dict

СВ

забавно, что я каждый из этих репортов печатал в консоль - все dict

ща допишу тогда матрицу

СВ

Выглядит так, что он ничего не предсказывал. Confusion matrix можно посмотреть?