EZ

Size: a a a

2020 March 02

какая тебе тогда кроссэнтропия

АP

Ну в задании написано её взять

AY

Коллеги, если интересно - про "новый" законопроект о bigdata 👇

АP

Надо разбить на 3 класса

EZ

ну кроссэнтропия это для синглкласса

EZ

она ж распределение по классам задает

АP

А для мультикласса что лучше взять как ошибку?

EZ

Артем Panda

А для мультикласса что лучше взять как ошибку?

ну видимо BCE

PO

Артем Panda

А для мультикласса что лучше взять как ошибку?

category crossentropy?)

АP

Спасибо

S

Здравствуйте! У меня задача генерации связного русского текста. На входе последовательность слов. В какую сторону копать, подскажите пожалуйста.

VC

2020 March 03

PO

Здравствуйте! У меня задача генерации связного русского текста. На входе последовательность слов. В какую сторону копать, подскажите пожалуйста.

Попробуй поиграться с gpt-2(но там английский) и BERT(разные языки), сам ты врят ли реализуешь подобное на нормальном уровне.

Так же есть тема цепей Маркова, но тут я хз.

Сам я как то пытался делать генератор связных описаний товаров в интернет магазинах по краткой инфе и это дело на данный момент оказалось совершенно невозможным. GPT-2 выдавало и норм текст и бредятину через раз, при этом генерировало текст по пол-часа.

Для работы с GPT-2 и BERT советую использовать видюху Google Colab , тогда ответ будет секунд 15.

Так же есть тема цепей Маркова, но тут я хз.

Сам я как то пытался делать генератор связных описаний товаров в интернет магазинах по краткой инфе и это дело на данный момент оказалось совершенно невозможным. GPT-2 выдавало и норм текст и бредятину через раз, при этом генерировало текст по пол-часа.

Для работы с GPT-2 и BERT советую использовать видюху Google Colab , тогда ответ будет секунд 15.

S

Копаю в сторону контекстно-свободных грамматик и построения предложения по выявленным правилам структуры предложения (подлежащее, сказуемое и т.д.)

AY

Попробуй поиграться с gpt-2(но там английский) и BERT(разные языки), сам ты врят ли реализуешь подобное на нормальном уровне.

Так же есть тема цепей Маркова, но тут я хз.

Сам я как то пытался делать генератор связных описаний товаров в интернет магазинах по краткой инфе и это дело на данный момент оказалось совершенно невозможным. GPT-2 выдавало и норм текст и бредятину через раз, при этом генерировало текст по пол-часа.

Для работы с GPT-2 и BERT советую использовать видюху Google Colab , тогда ответ будет секунд 15.

Так же есть тема цепей Маркова, но тут я хз.

Сам я как то пытался делать генератор связных описаний товаров в интернет магазинах по краткой инфе и это дело на данный момент оказалось совершенно невозможным. GPT-2 выдавало и норм текст и бредятину через раз, при этом генерировало текст по пол-часа.

Для работы с GPT-2 и BERT советую использовать видюху Google Colab , тогда ответ будет секунд 15.

кстати на GPT-2 делал бота, говорящего на разных языках. Там сначала через гугл апи определялся язык, через гугл же делался перевод на английский, и на выходе из GPT-2 обратно на язык оригинала. Качество страдало конечно, но в качестве скетча может пойти. А потом можно подумать об обучении на русском (но так глубоко не копал)

VZ

кстати на GPT-2 делал бота, говорящего на разных языках. Там сначала через гугл апи определялся язык, через гугл же делался перевод на английский, и на выходе из GPT-2 обратно на язык оригинала. Качество страдало конечно, но в качестве скетча может пойти. А потом можно подумать об обучении на русском (но так глубоко не копал)

Оригинально ) Главное работало

PO

кстати на GPT-2 делал бота, говорящего на разных языках. Там сначала через гугл апи определялся язык, через гугл же делался перевод на английский, и на выходе из GPT-2 обратно на язык оригинала. Качество страдало конечно, но в качестве скетча может пойти. А потом можно подумать об обучении на русском (но так глубоко не копал)

Ну если на обучение английскому GPT-2 ушли десятки гигабайт текста и над этим работал целый датацентр почти год то фиг ты его переобучишь на русский. Гугл перевод норм тема, но иногда банит или вовсе свое API меняет, сволочь

A

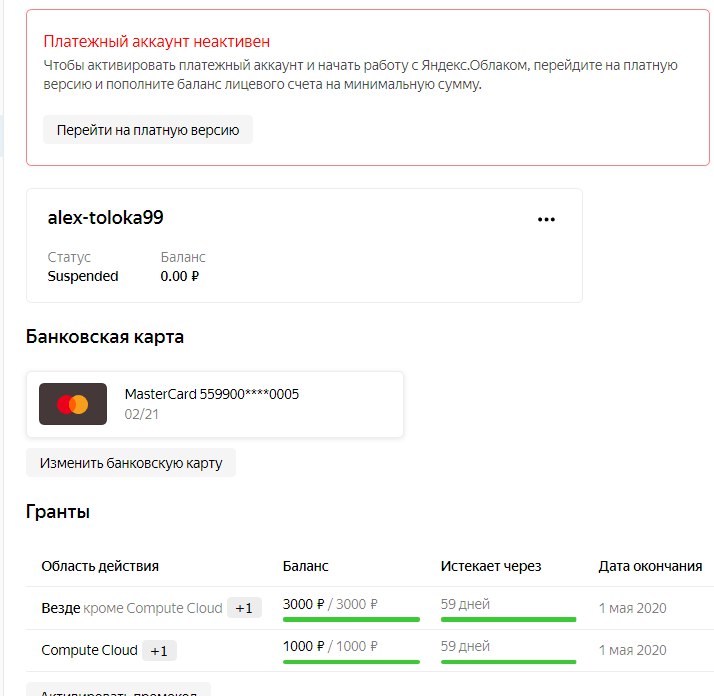

Подскажите, обязательно ли пополнять аккаунт яндекс облака чтобы воспользоваться грантом ?