r

Size: a a a

2020 September 13

Вот я и говорю - при включённой машине

Согласен. Но тут downtime буквально сотни милисекунд.

FK

Для офиса - норм 😁

СГ

riv1329

Вот вот попробуйте. Идея-то не плохая. Представьте, что у вас есть ноды с локальным ssd, а есть с ssd и емкими нжмд и вы на некоторые виртуальные машины выдаете с этих нжмд огромные терабайтные разделы... И вот наступил момент, вам не хватает оперативки и процессора для новой виртуальной машины с большим диском на нжмд - такая ситуация часто происходит гле-нилу в hetzner. Как бы было здорово разместить её на ноде с ssd а диск выдать с ноды со всеми видами накопителей...

Но proxmox должна уметь сождавать таджеты из zvol и консистентно создавать снимки на локальных хранилищах и на подлежащем под tardget zvol - вот это не делалось из-ща мораньно устаревшкго tardget в debian

Но proxmox должна уметь сождавать таджеты из zvol и консистентно создавать снимки на локальных хранилищах и на подлежащем под tardget zvol - вот это не делалось из-ща мораньно устаревшкго tardget в debian

Это вы про shared storage рассуждаете?

r

Это вы про shared storage рассуждаете?

Да. Про связку iscsi + zvol автоматически управляемый proxmox, когда каждый target в своем zvol

СГ

riv1329

Да. Про связку iscsi + zvol автоматически управляемый proxmox, когда каждый target в своем zvol

Это делается через zfs over iscsi. Proxmox будет создавать zvol на целевой системе, где targeted будет поднят. Есть отдельные дистрибутивы для создания таких хранилищ с нормальными реализациями targetd. например https://www.esos-project.com/

I

кстати, ethernus s2/s3 умеет в zfs over scsi ? я что-то в спеках нашел только как создавать фс на их полках.

r

Это делается через zfs over iscsi. Proxmox будет создавать zvol на целевой системе, где targeted будет поднят. Есть отдельные дистрибутивы для создания таких хранилищ с нормальными реализациями targetd. например https://www.esos-project.com/

А я хотел в качестве target использовать некоторые ноды кластера proxmox

До 6.х это было невозможно. Но (вроде) можно в 6.х

До 6.х это было невозможно. Но (вроде) можно в 6.х

СГ

riv1329

А я хотел в качестве target использовать некоторые ноды кластера proxmox

До 6.х это было невозможно. Но (вроде) можно в 6.х

До 6.х это было невозможно. Но (вроде) можно в 6.х

В проксе (штатной поставке) нет нормального targetd

1

Не помню как, но можно временно отключить ребут при панике

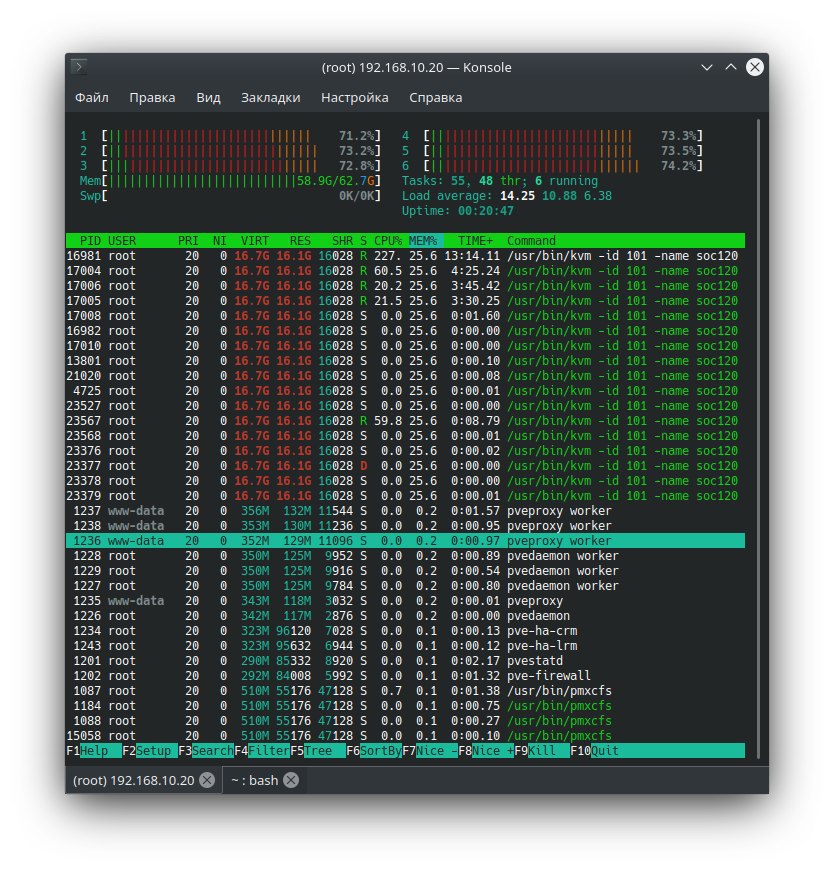

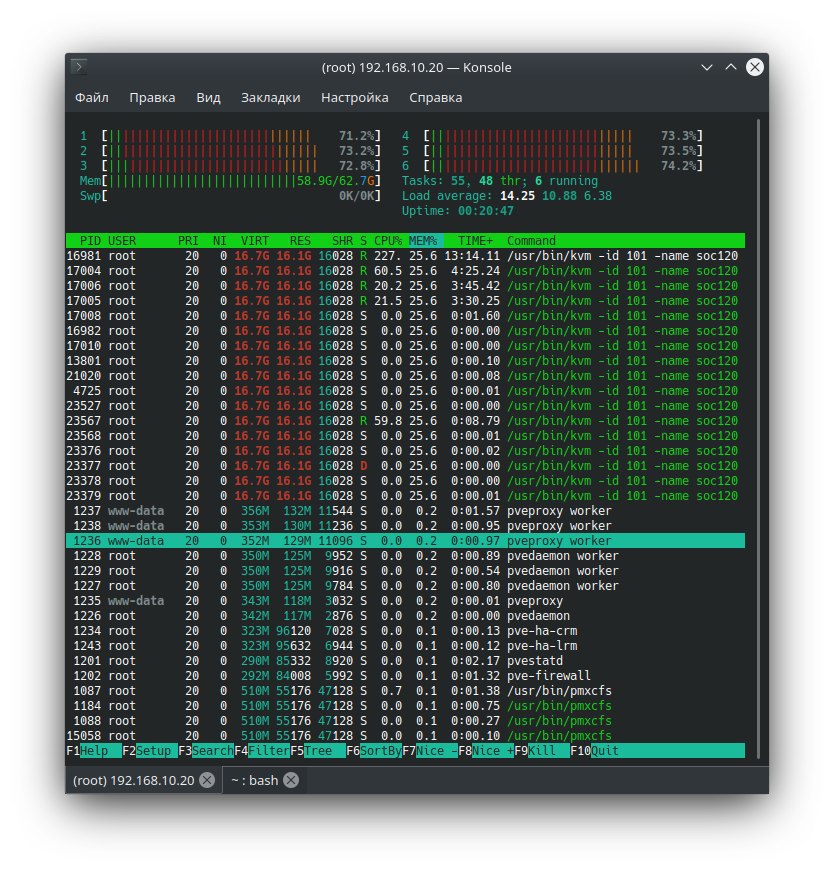

Отключил ребут. 18.7 htop показывает занято ОЗУ: 16 под вм + 2,7- сам прокс.

options zfs zfs_arc_max=2147483648тоже указано. Запускаю в вм тест crystaldiskmark: на чтении всё норм, 19.3-19.4 озу ест, как на запись тест идёт - сжирает всю свободную озу

1

И уходит в ребут

↺°

#вопрос

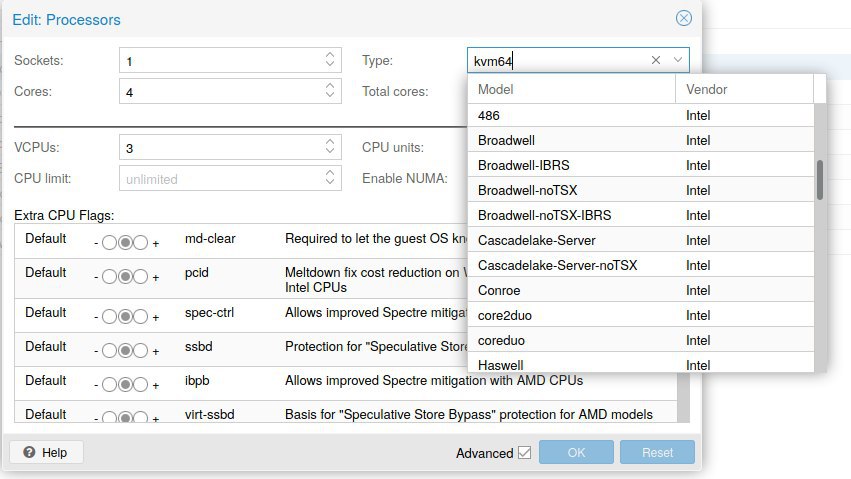

Подскажите пожалуйста, как сменить CoreID

Подскажите пожалуйста, как сменить CoreID

1

DS

112

Отключил ребут. 18.7 htop показывает занято ОЗУ: 16 под вм + 2,7- сам прокс.

options zfs zfs_arc_max=2147483648тоже указано. Запускаю в вм тест crystaldiskmark: на чтении всё норм, 19.3-19.4 озу ест, как на запись тест идёт - сжирает всю свободную озу

А почему ты думаешь что сам Линукс не кеширует?

↺°

112

Это?

Нет. Нумерация 0 1 2 3. А надо 1 2 3 4

↺°

Есть статья на Хабре, надо прибавить ядро. Т.е. физ ядер 4, ставим 5, и получаем что хотим. Но проксмокс не даёт запустить больше чем имеется ядер

1

1

Больше чем есть физ.ядер там не сделаешь же

↺°

Вобщем ругается лицуха 1с на coreid. Как его сменить хз.

r

112

И уходит в ребут

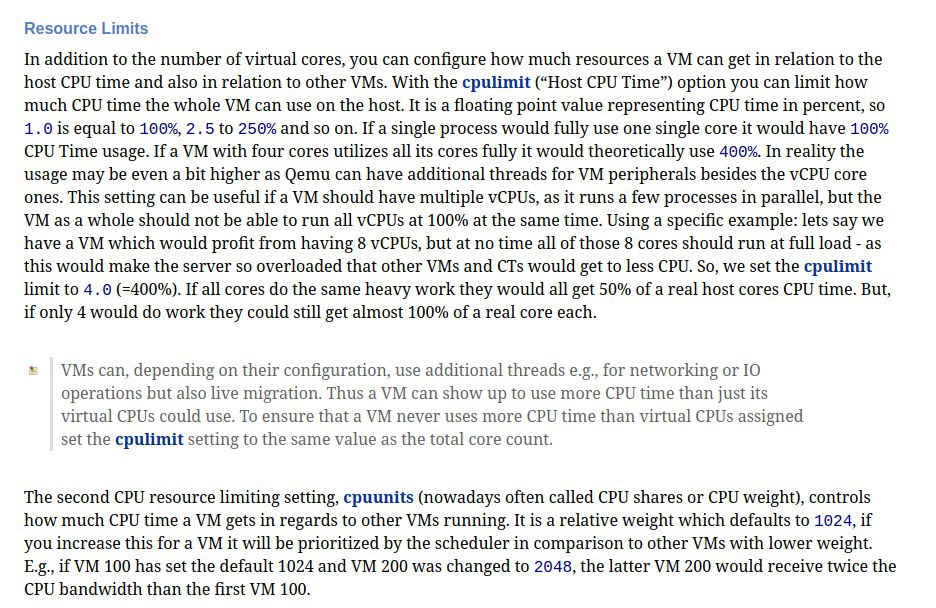

По моему, это память кончилась. kvm не будет отправлять виртуалки в своп, при недостатке памяти он ребутнет хост.

В качестве временной меры можно активировать механизм KSM (kernel same page sharing) нужно установить пакет ksmtuned и настроить его конфиг, чтобы он быстрее активировался. Тут дилема возникает: чем активнее ksm тем больше на него процессора тратится, и тем сильнее он утаптывает память, которая сама по себе постоянно разутаптывается назад.

Виртуалки нужно будет запускать по одной, когда 70% памяти будет занято, подождите, когда утопчется и запускайте остальные.

Это очень агрессивные настройки:

В качестве временной меры можно активировать механизм KSM (kernel same page sharing) нужно установить пакет ksmtuned и настроить его конфиг, чтобы он быстрее активировался. Тут дилема возникает: чем активнее ksm тем больше на него процессора тратится, и тем сильнее он утаптывает память, которая сама по себе постоянно разутаптывается назад.

Виртуалки нужно будет запускать по одной, когда 70% памяти будет занято, подождите, когда утопчется и запускайте остальные.

Это очень агрессивные настройки:

cat /etc/ksmtuned.conf

# Configuration file for ksmtuned.

# How long ksmtuned should sleep between tuning adjustments

KSM_MONITOR_INTERVAL=10

# Millisecond sleep between ksm scans for 16Gb server.

# Smaller servers sleep more, bigger sleep less.

# KSM_SLEEP_MSEC=10

KSM_NPAGES_BOOST=3000

# KSM_NPAGES_DECAY=-50

# KSM_NPAGES_MIN=64

KSM_NPAGES_MAX=12500

KSM_THRES_COEF=30

KSM_THRES_CONST=32768

# uncomment the following if you want ksmtuned debug info

LOGFILE=/var/log/ksmtuned

DEBUG=1

2020 September 14

FD

Всем привет

Как в включить KSM? Несовсем понятно по вики... Является ли частью baloon или нет.

#вопрос

Как в включить KSM? Несовсем понятно по вики... Является ли частью baloon или нет.

#вопрос