A

Size: a a a

2020 February 25

Almat Hissum

В этапе верификации и проксирования

Подробности будут?

LB

Считается неправильно - лимиты по системе ноды не равны сумме показателей по CPU для пода

Некропост засчитан :)

GG

Alexander

По моему опыту (с одной непубличной реализацией) производительность рафта с ростом количества нод в кластере падает. Потому лучше всего всегда держать кластер размером ровно в 3 ноды кроме случаев, когда нагрузка небольшая, но надежности хочется с большим запасом.

Ну, как бы это справедливо не только для рафта, а для любого алгоритма распределенного консенсуса

VR

Alexander

По моему опыту (с одной непубличной реализацией) производительность рафта с ростом количества нод в кластере падает. Потому лучше всего всегда держать кластер размером ровно в 3 ноды кроме случаев, когда нагрузка небольшая, но надежности хочется с большим запасом.

А чем меряется "производительность" алгоритма выбора лидера?

AH

Такая идея, стоит истио хочется чтоб когда запрос идёт в куб за сервисом что-то валидировала токен(то есть ходил в кейклоак) если ок дальше пускал к сервису куда он шел

LB

Ну, как бы это справедливо не только для рафта, а для любого алгоритма распределенного консенсуса

Алгоритм "нет консенсуса"' неуязвим впрочем :)

GG

Я уж не говорю, что когда у тебя все узлы равноценны, а один где-то далеко или тупит ( как выше коллега предлагал сделать)

A

Ну, как бы это справедливо не только для рафта, а для любого алгоритма распределенного консенсуса

Для eventual consistency с LWW не проблема :)

AH

Может группу для кейклоак создадим а что инфы совсем мало и там чисто будем обсуждать?

LB

Almat Hissum

Такая идея, стоит истио хочется чтоб когда запрос идёт в куб за сервисом что-то валидировала токен(то есть ходил в кейклоак) если ок дальше пускал к сервису куда он шел

Вам надо oauth proxy , умеет ли это istio незнаю

A

А чем меряется "производительность" алгоритма выбора лидера?

В скорости записи в рафтовый лог.

DO

Ребята а как работает metallb? есть непонятка.

16 кубер kubespray

установлен metallb в роли loadballancer

ingress-nginx получил у metlalb ипшник 10.5.0.50 который доступен на всех нодах

я думал что я смогу с любой ноды обращаться к этому единому ип 10.5.0.50 но по факту получается что я к портам nginx достучаться могу только с ноды на которой стоит ingress-nginx

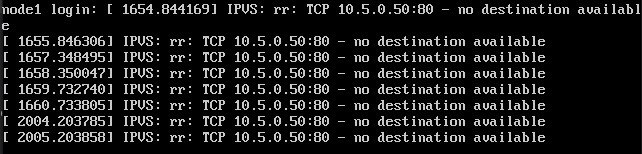

на всех остальных получаю

в ipmi сервака в консоле вижу IPVS no destination available

16 кубер kubespray

установлен metallb в роли loadballancer

ingress-nginx получил у metlalb ипшник 10.5.0.50 который доступен на всех нодах

я думал что я смогу с любой ноды обращаться к этому единому ип 10.5.0.50 но по факту получается что я к портам nginx достучаться могу только с ноды на которой стоит ingress-nginx

на всех остальных получаю

~# telnet 10.5.0.50 80

Trying 10.5.0.50...

telnet: Unable to connect to remote host: Connection refused

в ipmi сервака в консоле вижу IPVS no destination available

V

народ, в эвентах ноды OOM нет, но на ноде тупо все процессы убиваются, в syslog тож не вижу оомкиллера, что такое может быть?

LB

народ, в эвентах ноды OOM нет, но на ноде тупо все процессы убиваются, в syslog тож не вижу оомкиллера, что такое может быть?

А в dmesg есть OOM?

VR

Alexander

В скорости записи в рафтовый лог.

так понятно что это оно зависит от количества мемберов. Только это не так критично как время выбора нового лидера, при которой все коннекты кубового апи рвутся

A

так понятно что это оно зависит от количества мемберов. Только это не так критично как время выбора нового лидера, при которой все коннекты кубового апи рвутся

Время выборов, разумеется, тоже растет. Но это не постоянная операция

NG

Alexander

По моему опыту (с одной непубличной реализацией) производительность рафта с ростом количества нод в кластере падает. Потому лучше всего всегда держать кластер размером ровно в 3 ноды кроме случаев, когда нагрузка небольшая, но надежности хочется с большим запасом.

Что за опыт такой? Рекомендуется 5 нод.

GG

Что за опыт такой? Рекомендуется 5 нод.

Кем ?

GG

Если у тебя 1000 нод - да. Если полтора калеки - это избыточно