rG

Size: a a a

2021 July 07

да мне нужно на своё логическое дерево перевести).. экзекутор это процессор потока.. я так понял

rG

РДД это сам поток, распределённый.. в нём вообще всё.

rG

если тут кафка, то я бы предположил, что драйверы ориентируются по топикам, так?

ИК

Нет, так не получается. Драйвер создает один или несколько DAG, каждый из которых это Job, обработка RDD, перевод его из начального состояния в конечное состояние. Job делится на один или несколько Stage. Несколько стейджей будет, если есть перемешивание данных, «Shuffle». Стейдж это конкретное состояние RDD с известным числом партиций. Обработка каждой конкретной партиции - это Task, отдельное задание, которое делает что-то с весьма конкретным итератором по данным этой партиции RDD

rG

странно, но мне понятно)) не ожидал от себя такого) спасибо большое за ваше время)

ИК

Иногда драйверу нужно много информации о виде данных, к примеру, нужно прочитать миллионы файлов. Для начала драйвер может создать джобу для того, чтобы получить статус каждого файла, и экзекуторы сделают эту работу, передадут результат на драйвер, и дальше драйвер локально будет решать, читать этот файл отдельно, разделить его на несколько блоков, или наоборот, соединить несколько файлов в одну партицию RDD. Так что драйвер строит план, но не обходится без помощи, ведь это и есть фишка Spark - распределённость

ИК

А вот тут не подскажу, с JDBC и HDFS работал, с кафкой не пришлось

rG

звучит медленно.. это не для потока схема?

ИК

нет, не для стрима, это для файлов

rG

да, я уже понял. ТЗ на собесе: спарк, кафка, кассандра. а я на должность BI, и вот хочу разобраться что мне нужно лучше всего освоить, чтоб выдергивать данные из этого всего.

rG

Там ещё S3 как-то вчера приплели, до этого об этом речи не было.

rG

мне наверно интересно) раз я полез, чувствую, в глубже, чем нужно для BI

TC

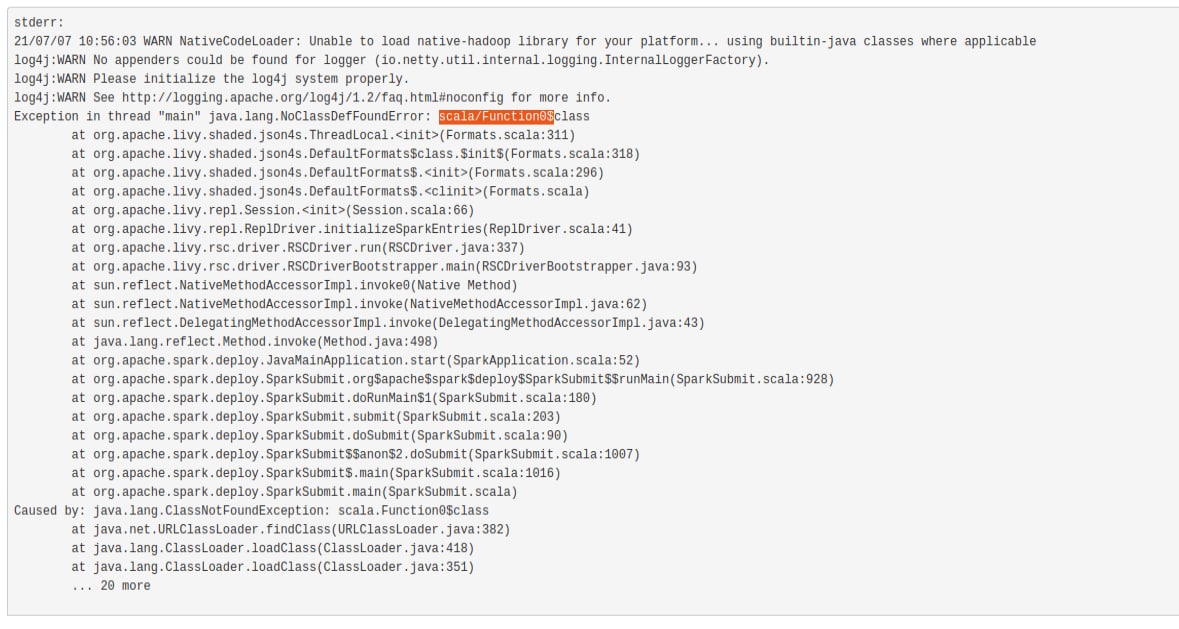

Всем привет. Такой вопрос: кто-то занимался настройкой Лайви (Livy) в докере? . Собрал свой контейнер с лайви (включил в сборку спарк), но при запуске простых приложений идет ошибка, что не найдены непонятно классы. Спарк-мастер стоит в другом контейнере. Понятно, что у меня не до конца настроена среда в контейнере, но не могу понять что именно -((((

ME

Я собирал, но не в docker.

А как docker image собирали? Там просто rsc jars надо в classpath добавлять

А как docker image собирали? Там просто rsc jars надо в classpath добавлять

ME

Выглядит так что вы их забыли

TC

нашел в гитхабе, немного доработал - заменил на более свежие версии дистрибутивы.

TC

спасибо за совет. сейчас займусь этим.

TC

сам имидж собирал так docker build -t tag/livy -f Dockerfile

ME

На всякий случай посоветую собирать его из master, потому что релиза давно не было, а там много интересного

ME

Включая spark3