ИК

Size: a a a

2020 August 31

Жмака

Юнион вроде тяжелая операция

fileList.grouped(128).par.map(spark.read.parquet).reduce(_ union _) - может с этого стоит начать попытки?

Ж

fileList.grouped(128).par.map(spark.read.parquet).reduce(_ union _) - может с этого стоит начать попытки?

А что за par? Не находит

ИК

это потому что я планировал, что .grouped будет параллельная коллекция, а это, походу, итератор, надо его .toList

ИК

Жмака

А что за par? Не находит

минутку, надо попробовать не в телеграмме это написать))

Ж

Я пробую. Выдал с toList датафрейм.

ИК

Жмака

Я пробую. Выдал с toList датафрейм.

ну вот, может быть, будет чуть быстрее))

Ж

Попробую тогда. Но чуть чуть не обнадеживает😞

Ж

Спасибо

ИК

Жмака

Спасибо

пожалуйста!

ИК

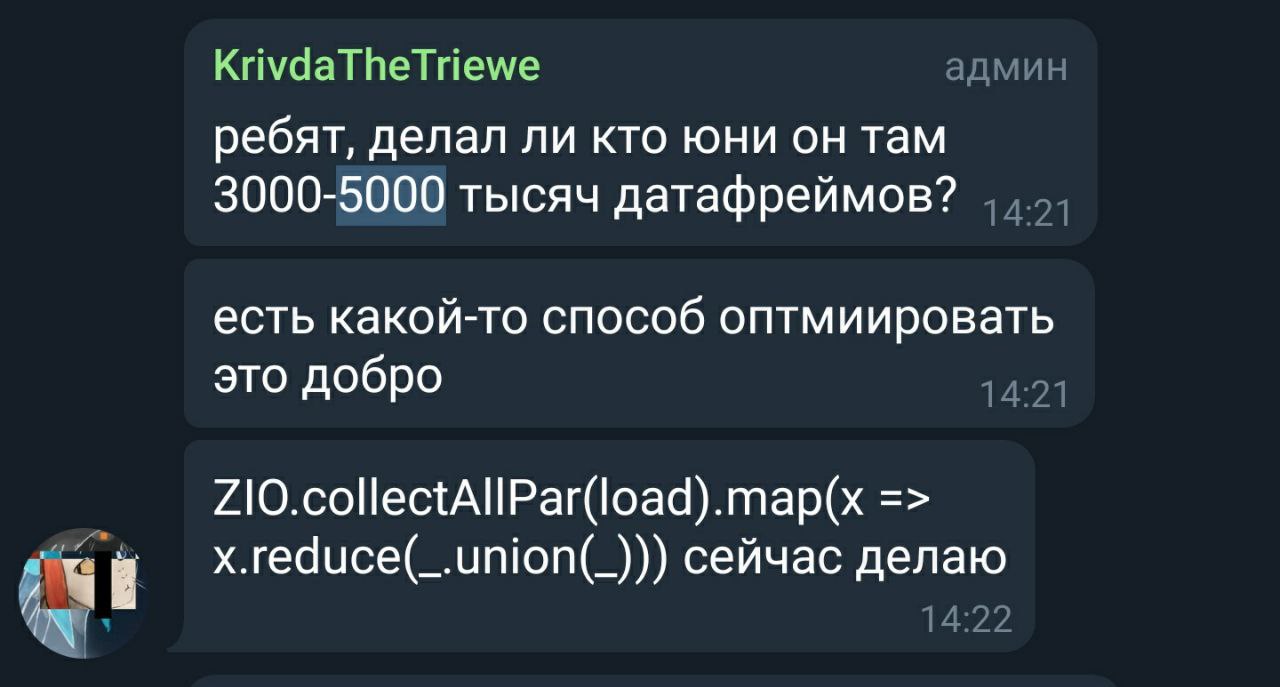

Пруф, что проблема большого числа union в dataframe API обсуждали в Moscow spark.

ИК

И даже если делать union на отдельных строках, если их больше тысячи, ждать бесполезно, проще .collect и преобразовать на драйвере как надо. Походу, там квадратичная сложность и на каждом шаге проверяются схемы всех предыдущих датафреймов. Впрочем, код я так и не посмотрел, так что это всего лишь предположение

AS

Жмака

В количество данных и последовательное чтение файлов

а пробовал читать с указанием схемы, в орках это точно поможет, как в паркете не знаю

Ж

И даже если делать union на отдельных строках, если их больше тысячи, ждать бесполезно, проще .collect и преобразовать на драйвере как надо. Походу, там квадратичная сложность и на каждом шаге проверяются схемы всех предыдущих датафреймов. Впрочем, код я так и не посмотрел, так что это всего лишь предположение

То есть юнион не решение и трогать его в моем случае нет смысла если у меня 25000 файлов?

Ж

а пробовал читать с указанием схемы, в орках это точно поможет, как в паркете не знаю

Не пробовал но читать будет все равно последовательно тысячи файлов

ИК

так я предложил сделать параллельный список списков, при этом количество юнионов снизится в 128 раз ))

AS

Жмака

Не пробовал но читать будет все равно последовательно тысячи файлов

он же не весь файл вычитывает, потом это разойдется по экзекютерам

AS

так я предложил сделать параллельный список списков, при этом количество юнионов снизится в 128 раз ))

но это все на драйвере будет выполняться?

ИК

но это все на драйвере будет выполняться?

нет, на драйвере это будет координироваться, выполняться чтение должно на экзекуторах

ИК

ну и небольшой дисклеймер, я на S3 ничего не делал, только HDFS и локальная ФС

Ж

так я предложил сделать параллельный список списков, при этом количество юнионов снизится в 128 раз ))

Не компилируется.