AS

Size: a a a

2019 December 05

нет коробочной поддержки zip-а, приходится костыли городить

а почему у вас зипы?

AS

нет коробочной поддержки zip-а, приходится костыли городить

а просто binaryFiles и flatMap чем не подходит?

A

а почему у вас зипы?

потому что есть некий sftp-сервер, на нем zip архивы, а внутри csv. И надо как-то это прочитать спарком. Либо придумать обходной путь

ME

потому что есть некий sftp-сервер, на нем zip архивы, а внутри csv. И надо как-то это прочитать спарком. Либо придумать обходной путь

а нельзя в hdfs распаковать?

AS

AS

гугл всемогущий

A

а нельзя в hdfs распаковать?

у нас нет hdfs :) у нас aws

ME

ME

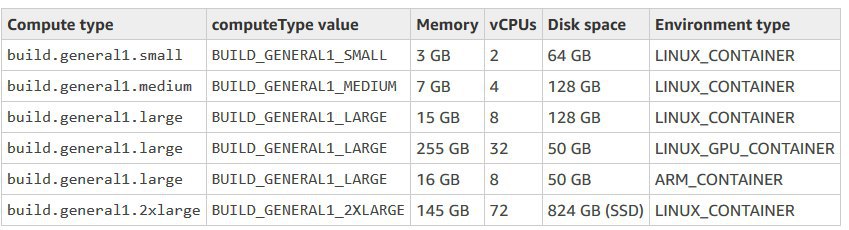

Можно распаковку на CodeBuild джобе запустить, через aws cli скопировать результаты в s3 и уже дальше через glue процессить

ME

CodeBuild можно заменить на EC2 инстанс или ещё что-то, по желанию

A

В соседней группе по aws тоже предложили codebuild использовать для распаковки. Надо будет попробовать, спасибо

ME

Вот такие варианты там, если влезет на диск, то норм

ME

У нас на CodeBuild происходит запаковка в архивы csv с S3 как раз)

A

окей, спасибо за помощь!

A

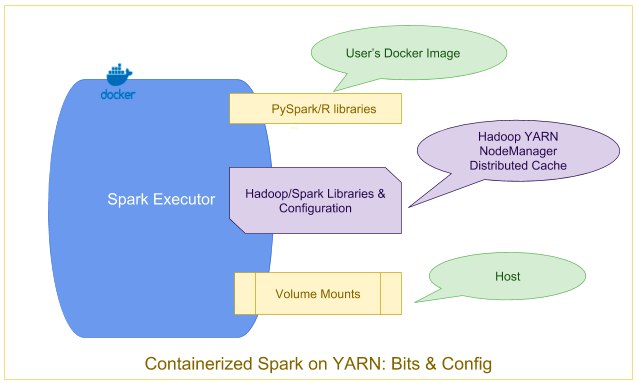

сомневаюсь что он это хотел, ну и там хортоны про свою платформу описывают, но не всё там так гладно

как минимум нормально спарк полетел только начиная с 3.2

до этого даже при использовании host network внутри контейнеры имели кривой hostname и спарк этому был совсем не рад

а вот на 3.2 я уже подымал спарк с драйвером и екзекутарами в докерах на ярне

как минимум нормально спарк полетел только начиная с 3.2

до этого даже при использовании host network внутри контейнеры имели кривой hostname и спарк этому был совсем не рад

а вот на 3.2 я уже подымал спарк с драйвером и екзекутарами в докерах на ярне

N

сомневаюсь что он это хотел, ну и там хортоны про свою платформу описывают, но не всё там так гладно

как минимум нормально спарк полетел только начиная с 3.2

до этого даже при использовании host network внутри контейнеры имели кривой hostname и спарк этому был совсем не рад

а вот на 3.2 я уже подымал спарк с драйвером и екзекутарами в докерах на ярне

как минимум нормально спарк полетел только начиная с 3.2

до этого даже при использовании host network внутри контейнеры имели кривой hostname и спарк этому был совсем не рад

а вот на 3.2 я уже подымал спарк с драйвером и екзекутарами в докерах на ярне

Про ваниль речь?

N

А то тут коллеги собрались бареметалл закупать. А оно вон как оказывается, в докерах нормально заработало.

A

да

ванишь хадуп 3.2.0 (уже поставил таск админам обновить до 3.2.1, там пару вещей в докере пофиксили, но вообще в 3.3.0 смержили ещё больше полезных вещей)

ваниль спарк 2.4.3 (наша пересборка с мелкими фиксами)

ванишь хадуп 3.2.0 (уже поставил таск админам обновить до 3.2.1, там пару вещей в докере пофиксили, но вообще в 3.3.0 смержили ещё больше полезных вещей)

ваниль спарк 2.4.3 (наша пересборка с мелкими фиксами)

A

докеры на хадупе уже регулярно гоняем, там у меня jupyter kernels крутятся питоновские и R

был ресерч чтобы и спарк запустить для pyspark в них же, меньше головняка с подготовкой окружения и всякими venv, что хочешь то и ставь

был ресерч чтобы и спарк запустить для pyspark в них же, меньше головняка с подготовкой окружения и всякими venv, что хочешь то и ставь