Size: a a a

2019 August 15

Как выяснилось не все знают о существовании discussion group для этого канала. Заходите поговорить.

2019 August 16

Всем доброе утречко! В это воскресенье (18.08.19) организуется NLP Reading Club. Обсуждаем тему dialogue state tracking.

Время: 12:00

Место: ШАД, Оксфорд

Форма для тех, у кого нету пропуска в ШАД (закроется в 12:00 сегодня)

https://forms.office.com/Pages/ResponsePage.aspx?id=DQSIkWdsW0yxEjajBLZtrQAAAAAAAAAAAAMAAKZ1i4JUMFVVMkVSOExNR1U3UVpHT0EyWEEyQzRVOC4u

Время: 12:00

Место: ШАД, Оксфорд

Форма для тех, у кого нету пропуска в ШАД (закроется в 12:00 сегодня)

https://forms.office.com/Pages/ResponsePage.aspx?id=DQSIkWdsW0yxEjajBLZtrQAAAAAAAAAAAAMAAKZ1i4JUMFVVMkVSOExNR1U3UVpHT0EyWEEyQzRVOC4u

Сори за такие быстрые формы, когда отладим процесс, будем заранее выкладывать.

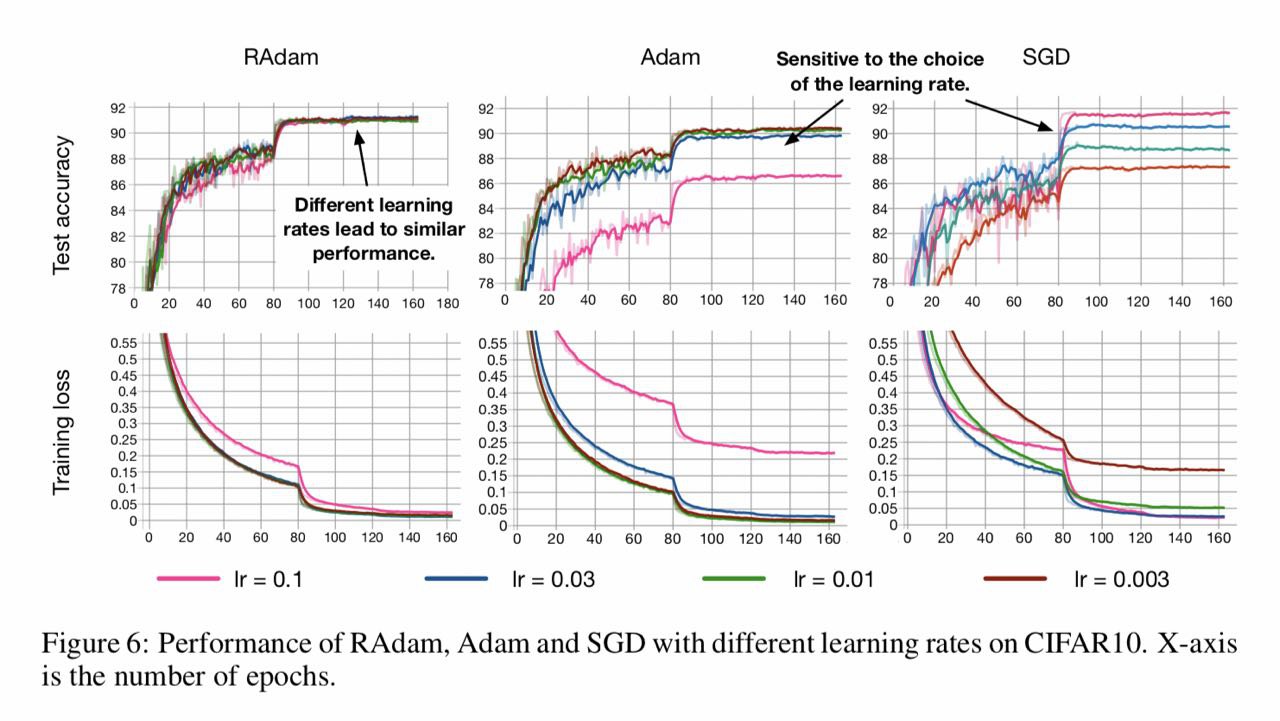

RAdam - Retctified ADAM. Новый оптимизатор, который менее чувствителен к lr и не требует прогрева (в отличие от ADAM).

Статья: arxiv.org/abs/1908.03265v1

Пост на медиуме: link.medium.com/72QVenv8bZ

Имплементация на PyTorch: github.com/LiyuanLucasLiu/RAdam

Статья: arxiv.org/abs/1908.03265v1

Пост на медиуме: link.medium.com/72QVenv8bZ

Имплементация на PyTorch: github.com/LiyuanLucasLiu/RAdam

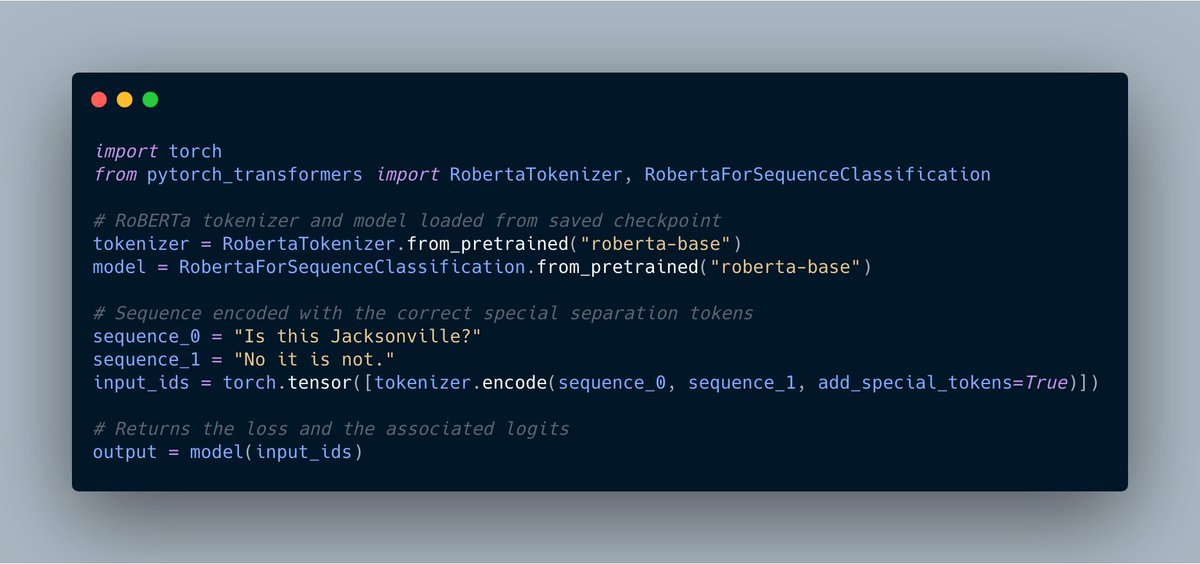

RoBERTa в PyTorch Transformers 🎉

Что ещё нужно для счастья?

https://mobile.twitter.com/huggingface/status/1162346749194903553

Спасибо @someotherusername

Что ещё нужно для счастья?

https://mobile.twitter.com/huggingface/status/1162346749194903553

Спасибо @someotherusername

2019 August 17

DeepMind выпускает подкаст. Пока что доступен только трейлер, но stay tuned.

podcasts.apple.com/ru/podcast/deepmind-the-podcast/id1476316441?l=en

podcasts.apple.com/ru/podcast/deepmind-the-podcast/id1476316441?l=en

Переслано от I Апрельский...

Встречаемся завтра в 12 в ШАДе. Аудитория "Оксфорд".

Вместе с коллегами разберем статьи:

- @AllokyOfficial - https://arxiv.org/abs/1801.04871

- @PaGul - https://arxiv.org/abs/1905.08743

- @artli - https://arxiv.org/abs/1810.09587v1

- @twlvth - https://arxiv.org/abs/1907.00883

А @daLime постарается записать.

Если есть вопросы, то пишите -- помогу.

Вместе с коллегами разберем статьи:

- @AllokyOfficial - https://arxiv.org/abs/1801.04871

- @PaGul - https://arxiv.org/abs/1905.08743

- @artli - https://arxiv.org/abs/1810.09587v1

- @twlvth - https://arxiv.org/abs/1907.00883

А @daLime постарается записать.

Если есть вопросы, то пишите -- помогу.

2019 August 18

SkynetToday интересно ваше мнение насчёт основных DO и DON’T в AI-новостях.

twitter.com/skynet_today/status/1162814692676423680

Прямая ссылка на форму: forms.gle/kx7fLJABetEUnQw59

twitter.com/skynet_today/status/1162814692676423680

Прямая ссылка на форму: forms.gle/kx7fLJABetEUnQw59

Хороший обзор современного состояния transfer learning в NLP от Рудера

ruder.io/state-of-transfer-learning-in-nlp/

ruder.io/state-of-transfer-learning-in-nlp/

2019 August 20

NVIDIA раздаёт стипендии.

blogs.nvidia.com/blog/2019/08/16/graduate-fellowship-awards

TL;DR

Up to $50,000 per student.

We’re looking for students who have completed their first year of Ph.D.-level studies at the time of application. Applicants must also be investigating innovative ways to use GPUs. The deadline for submitting applications is Sept. 13, 2019. An internship at NVIDIA preceding the fellowship year is now mandatory — eligible candidates should be available for the internship in summer 2020.

blogs.nvidia.com/blog/2019/08/16/graduate-fellowship-awards

TL;DR

Up to $50,000 per student.

We’re looking for students who have completed their first year of Ph.D.-level studies at the time of application. Applicants must also be investigating innovative ways to use GPUs. The deadline for submitting applications is Sept. 13, 2019. An internship at NVIDIA preceding the fellowship year is now mandatory — eligible candidates should be available for the internship in summer 2020.

dlinnlp

DeepMind выпускает подкаст. Пока что доступен только трейлер, но stay tuned.

podcasts.apple.com/ru/podcast/deepmind-the-podcast/id1476316441?l=en

podcasts.apple.com/ru/podcast/deepmind-the-podcast/id1476316441?l=en

Вышли первые эпизоды 🎉

2019 August 24

Всем привет!

Кто-то из вас уже знает, что не так давно я закончил свою работу в iPavlov, чтобы начать PhD в massachusetts.edu. В последние несколько дней было мало постов по причине переезда, что я планирую исправить в ближайшее время.

Сейчас для канала готовится новый логотип, плюс новости будут поститься в чуть-чуть другое время из-за разницы в часовых поясах.

Несколько людей простили меня рассказать, как происходило поступление в штаты, получение визы, поиск проживания и первые дни. Наверное, будет не очень хорошо запихивать всё это в один пост, так что разобью на 3-4 части и опубликую их в течение этих выходных.

Всё-таки я не позиционирую этот канал как мой личный, поэтому будет правильным спросить у вас, место ли такому материалу в канале.

Кто-то из вас уже знает, что не так давно я закончил свою работу в iPavlov, чтобы начать PhD в massachusetts.edu. В последние несколько дней было мало постов по причине переезда, что я планирую исправить в ближайшее время.

Сейчас для канала готовится новый логотип, плюс новости будут поститься в чуть-чуть другое время из-за разницы в часовых поясах.

Несколько людей простили меня рассказать, как происходило поступление в штаты, получение визы, поиск проживания и первые дни. Наверное, будет не очень хорошо запихивать всё это в один пост, так что разобью на 3-4 части и опубликую их в течение этих выходных.

Всё-таки я не позиционирую этот канал как мой личный, поэтому будет правильным спросить у вас, место ли такому материалу в канале.

У FAIR неплохой блог, в нём можно почитать объяснения некоторых их статей простым языком.

Например, тут описываются две их статьи:

ai.facebook.com/blog/making-transformer-networks-simpler-and-more-efficient

Adaptive Attention Span in Transformers (arxiv.org/abs/1905.07799)

и

Augmenting Self-attention with Persistent Memory (arxiv.org/abs/1907.01470)

за наводку на пост спасибо @ibelyalov

Например, тут описываются две их статьи:

ai.facebook.com/blog/making-transformer-networks-simpler-and-more-efficient

Adaptive Attention Span in Transformers (arxiv.org/abs/1905.07799)

и

Augmenting Self-attention with Persistent Memory (arxiv.org/abs/1907.01470)

за наводку на пост спасибо @ibelyalov

И, внезапно, статья в их блоге как раз про тему моей магистерской.

Векторные представления слов с опечатками. Правда facebook делают это supervised, что хорошо, но датасеты с исправленными опечатками пока что найти довольно сложно.

ai.facebook.com/blog/-a-new-model-for-word-embeddings-that-are-resilient-to-misspellings-

Векторные представления слов с опечатками. Правда facebook делают это supervised, что хорошо, но датасеты с исправленными опечатками пока что найти довольно сложно.

ai.facebook.com/blog/-a-new-model-for-word-embeddings-that-are-resilient-to-misspellings-

2019 August 27

На выходных совсем не было времени на обещанные посты, но вот хотя бы второй.

telegra.ph/CHast-2-Poluchenie-biznes-vizy-i-pervyj-vizit-v-SSHA-08-27

telegra.ph/CHast-2-Poluchenie-biznes-vizy-i-pervyj-vizit-v-SSHA-08-27

2019 August 28

The HSIC Bottleneck: Deep Learning without Back-Propagation

Kurt Ma et al. Victoria University of Wellington

arxiv.org/abs/1908.01580v1

TL;DR by @vaklyuenkov

Предлагается метод обучения полносвязных и свёрточных сетей

- без обратного распространения ошибки

- без затухающих и взрывающихся градиентов

- позволяющий независимое (в тч параллельное) обучение слоёв

- требующий меньшее число операций

- результаты на бенчмарках MNIST/FashionMNIST/CIFAR10 сравнимы с обучением с обратым распространием

- биологичнее, чем backprop

Вся магия в критерии независимости Гильберта-Шмидта (HSIC) - меры, которая позволяет измерять степень независимости (что сильнее отсутсвия корреляции) между двумя многомерными случайными величинами, такими как парамметры любого скрытого слоя и ожидаемые лейблы на выходе. С помощью критерия для слоёв независимо оптимизируется баланс между независимостью от лишней информации в инпуте, ведущей к переобучению, и зависимости с желаемым результатом на выходе. Скорость сходимости получается даже больше чем у методов с backprop. Для получения state-of-the-art результатов всё-таки обучается один слой посредсвом SGD и авторы с гордостью отмечают это обходится без backprop.

It is more biologically plausible

без гмо и усилителей вкуса

всё натуральное

Kurt Ma et al. Victoria University of Wellington

arxiv.org/abs/1908.01580v1

TL;DR by @vaklyuenkov

Предлагается метод обучения полносвязных и свёрточных сетей

- без обратного распространения ошибки

- без затухающих и взрывающихся градиентов

- позволяющий независимое (в тч параллельное) обучение слоёв

- требующий меньшее число операций

- результаты на бенчмарках MNIST/FashionMNIST/CIFAR10 сравнимы с обучением с обратым распространием

- биологичнее, чем backprop

Вся магия в критерии независимости Гильберта-Шмидта (HSIC) - меры, которая позволяет измерять степень независимости (что сильнее отсутсвия корреляции) между двумя многомерными случайными величинами, такими как парамметры любого скрытого слоя и ожидаемые лейблы на выходе. С помощью критерия для слоёв независимо оптимизируется баланс между независимостью от лишней информации в инпуте, ведущей к переобучению, и зависимости с желаемым результатом на выходе. Скорость сходимости получается даже больше чем у методов с backprop. Для получения state-of-the-art результатов всё-таки обучается один слой посредсвом SGD и авторы с гордостью отмечают это обходится без backprop.

It is more biologically plausible

без гмо и усилителей вкуса

всё натуральное