VD

Size: a a a

2021 January 12

перечитай задание внимательнее

NB

понял, спасибо

N

Ребят, посоветуйте хороший курс на кусейре для начала

N

Сорян прочитал факу, нашел все что мне нужно там

MM

Nikolay

Сорян прочитал факу, нашел все что мне нужно там

Ура!)

i

Отлично

AE

i

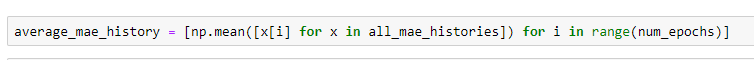

это же list comprehension

i

Вы хотите понять как он работает?

i

Таким строкам потом замучаетесь делать дебагин

A

Я правильно понимаю, что регуляризация нужна для уменьшения дисперсии оценок, поэтому большие значения регрессоров это плохо? но странно все равно - большие значения == высокая дисперсия?

A

в курсе кто-то сказал (Соколов?)что доказывается, что при мультиколл регрессоры растут... но док-ва не было, там жесть какая-то?

SD

В задании:

Линейная регрессия и стохастический градиентный спуск

Предлагают:

Отмасштабируйте столбцы матрицы X, вычтя из каждого значения среднее по соответствующему столбцу и поделив результат на стандартное отклонение

Зачем нам предлагают это сделать?

Это чем-то поможет сделать стохастический градиентный спуск??

Линейная регрессия и стохастический градиентный спуск

Предлагают:

Отмасштабируйте столбцы матрицы X, вычтя из каждого значения среднее по соответствующему столбцу и поделив результат на стандартное отклонение

Зачем нам предлагают это сделать?

Это чем-то поможет сделать стохастический градиентный спуск??

АГ

В задании:

Линейная регрессия и стохастический градиентный спуск

Предлагают:

Отмасштабируйте столбцы матрицы X, вычтя из каждого значения среднее по соответствующему столбцу и поделив результат на стандартное отклонение

Зачем нам предлагают это сделать?

Это чем-то поможет сделать стохастический градиентный спуск??

Линейная регрессия и стохастический градиентный спуск

Предлагают:

Отмасштабируйте столбцы матрицы X, вычтя из каждого значения среднее по соответствующему столбцу и поделив результат на стандартное отклонение

Зачем нам предлагают это сделать?

Это чем-то поможет сделать стохастический градиентный спуск??

АГ

Alexey

в курсе кто-то сказал (Соколов?)что доказывается, что при мультиколл регрессоры растут... но док-ва не было, там жесть какая-то?

Не регрессоры растут, а коэффициенты, веса w

АГ

Регуляризация и масштаб признаков не связаны

ИБ

В задании:

Линейная регрессия и стохастический градиентный спуск

Предлагают:

Отмасштабируйте столбцы матрицы X, вычтя из каждого значения среднее по соответствующему столбцу и поделив результат на стандартное отклонение

Зачем нам предлагают это сделать?

Это чем-то поможет сделать стохастический градиентный спуск??

Линейная регрессия и стохастический градиентный спуск

Предлагают:

Отмасштабируйте столбцы матрицы X, вычтя из каждого значения среднее по соответствующему столбцу и поделив результат на стандартное отклонение

Зачем нам предлагают это сделать?

Это чем-то поможет сделать стохастический градиентный спуск??

Да, поможет

При минимизации функции ошибки без масштабирования будут возникать большие веса, которые плохо влияют на модель и минимизацию в целом

При минимизации функции ошибки без масштабирования будут возникать большие веса, которые плохо влияют на модель и минимизацию в целом

SD

Интуитивно понятно что это может помочь, но авторы пишут в задании к первой неделе, где про это не говорили )

Видимо чтобы мы сами разбирались )

Видимо чтобы мы сами разбирались )

АГ

Суть именно в градиентным спуске, он быстрее сходится, устойчивее модель, вот и все

АГ

Для линейных так