M

Size: a a a

2021 January 04

M

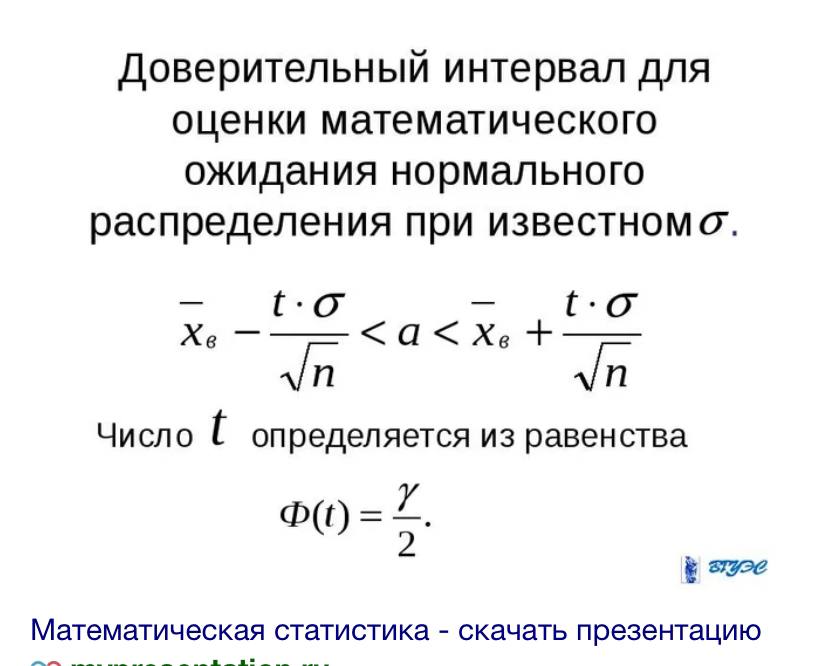

Ну вот - и сигму делим на корень из n 🤷🏻♂️

АГ

Сигму чего?

АГ

Исходной выборки

АГ

А у вас дана сигма уже для статистики(для данной аналогии у вас как бы дана уже сигма делить на корень из n)

АГ

По сути, нижняя граница, к примеру, чему равна? Выборочная статистика минус её стандартное отклонение(которое часто носит название se) * на квантиль

АГ

Только, надо понимать, это все аналогия, сами беты не являются мат ожиданиями, просто статистики от выборки, распределенные, при опред условиях по t распределению. Выборочное средние условные это уже предсказания y hat, которые в идеале условные мат ожидания.

2021 January 05

АГ

ну можно при желании учить модель на разных данных. Просто бутстрэп ообычно предполагает много реплик - поотому учить заново долго. Но вай нот.

Да, что неполный - правда. что можно сделать не стреляя в себе ногу новым способом - это построить бутстрэп распределения для разных моделей и глазами посмотреть). А дальше идет тоже простор для допущений.

Да, что неполный - правда. что можно сделать не стреляя в себе ногу новым способом - это построить бутстрэп распределения для разных моделей и глазами посмотреть). А дальше идет тоже простор для допущений.

Что думаете по поводу следующего подхода: разделить выборку на трейн и тест, затем получить n скоров, обучая n раз модель на бутстрапированных сэмплах из трейн и проверяя на n бутстрапированных сэмплах из тест. Тут есть, наверное, небольшое нарушение iid в связи с пересечение данных, но в связи со случайностью бутстрэпа, оно, вероятно, небольшое, подвыборки всегда разные. Здесь может и т тест зайти ведь на скоры, хотя кажется, что все равно как-то не вариативно... В таком случае, можно повысить вариативность, каждый раз сэмплируя из случайной подвыборки без возвращения размера, скажем, 0.5 от исходной выборки...

K

Артём Глазунов

Что думаете по поводу следующего подхода: разделить выборку на трейн и тест, затем получить n скоров, обучая n раз модель на бутстрапированных сэмплах из трейн и проверяя на n бутстрапированных сэмплах из тест. Тут есть, наверное, небольшое нарушение iid в связи с пересечение данных, но в связи со случайностью бутстрэпа, оно, вероятно, небольшое, подвыборки всегда разные. Здесь может и т тест зайти ведь на скоры, хотя кажется, что все равно как-то не вариативно... В таком случае, можно повысить вариативность, каждый раз сэмплируя из случайной подвыборки без возвращения размера, скажем, 0.5 от исходной выборки...

так вроде те же грабли --нет? Выборка-то исходная одна и та же. Поэтому то что вы как-то ее нарезаете не делает наблюдения i.i.d.

АГ

так вроде те же грабли --нет? Выборка-то исходная одна и та же. Поэтому то что вы как-то ее нарезаете не делает наблюдения i.i.d.

Ну тогда все выборки связаны, они же получены из одно генеральной совокупности. Тогда задача получения случайных и независимых выборок не решаема же?

АГ

Выборки разные, потому что сэмплируются случайно, скоры почти не зависимы, потому что получены на разных выборках.

АГ

Модели разные, потому что обучены на разных данных.

АГ

Или не так?

АГ

При этом трейн и тест не пересекаются, поэтому через модель связи быть не должно

АГ

Всё пока, что смогла выдать моя усталая фантазия в этот поздний час, могу ошибаться..

АГ

Да, тесты между собой пересекаются, как и трейны между собой, но пересечение случайно. Плюс сэмплируем не из целой выборки, а из подвыборки каждый раз.

АГ

Не понизит ли данный подход корреляции метрик, как похожее делается в рэндом форесте с моделями?

K

Артём Глазунов

Что думаете по поводу следующего подхода: разделить выборку на трейн и тест, затем получить n скоров, обучая n раз модель на бутстрапированных сэмплах из трейн и проверяя на n бутстрапированных сэмплах из тест. Тут есть, наверное, небольшое нарушение iid в связи с пересечение данных, но в связи со случайностью бутстрэпа, оно, вероятно, небольшое, подвыборки всегда разные. Здесь может и т тест зайти ведь на скоры, хотя кажется, что все равно как-то не вариативно... В таком случае, можно повысить вариативность, каждый раз сэмплируя из случайной подвыборки без возвращения размера, скажем, 0.5 от исходной выборки...

Что-то у меня, признаться честно, тоже голова сейчас не очень соображает, надо будет утром вернуться :D

Вообще, конечно, все это звучит как совершенно нерабочие вещи на практике. Если так валидировать каждое изменение в модели и при достаточном времени обучении, то никакого времени не хватит

Вообще, конечно, все это звучит как совершенно нерабочие вещи на практике. Если так валидировать каждое изменение в модели и при достаточном времени обучении, то никакого времени не хватит

АГ

Что-то у меня, признаться честно, тоже голова сейчас не очень соображает, надо будет утром вернуться :D

Вообще, конечно, все это звучит как совершенно нерабочие вещи на практике. Если так валидировать каждое изменение в модели и при достаточном времени обучении, то никакого времени не хватит

Вообще, конечно, все это звучит как совершенно нерабочие вещи на практике. Если так валидировать каждое изменение в модели и при достаточном времени обучении, то никакого времени не хватит

Да, для больших моделей явно не подойдёт, нужен скайнет для этого))