K

Size: a a a

2020 July 05

Да эт понятно

ЕТ

Не слышал, чтоб коррекцию просто adjusted p value называли :/

Ну, есть p-value, а есть adjusted p-value. Тип просто p-значения получаем, а тут получаем скорректированные p-значения.

G

Спасибо, использовал недавно уже.

АГ

Helga Lilo

Я правильно понимаю - применить частотное кодирование, но в тех случаях, где частота мизерная - заменить нулем или скинуть в одну категорию .. ?

Но частотное кодирование напрямую может привести к переобучению, нужно разбивать на фолды, частотое описание для одного фолда брать с другого и т.д.

ᎪᏴ

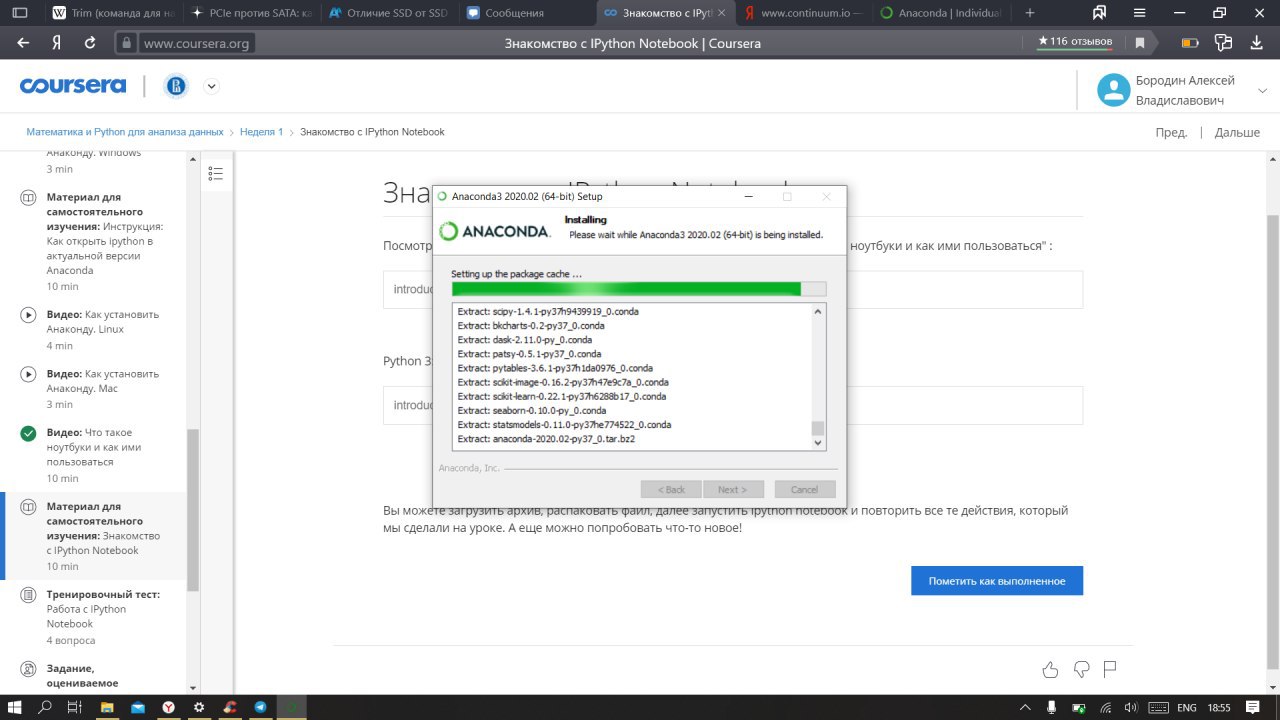

Добрый день! Только начал проходить первый курс в специализации

Подскажите, почему не хочет распаковываться? До этого уже стояла анаконда, но полетел жесткий диск и приходится устанавливать вновь

Подскажите, почему не хочет распаковываться? До этого уже стояла анаконда, но полетел жесткий диск и приходится устанавливать вновь

АГ

Helga Lilo

спасибо, попробую!

Если простую нужно сделать кодировку с меньшим числом признаков, чем в onehot, то это ordinal(но неизвестные категории нужно отдельно обрабатывать) или binary(появятся дополнительные признаки, но их существенно меньше). Но ordinal задаёт несуществующий порядок, а binary покорректней с этой точки зрения.

АГ

Предварительно можно, как было сказано выше, объединить ещё редкие категории, но нужно понимать, что может получиться одна или несколько дополнительных огромных искусственных категорий

SS

Артём Глазунов

Но частотное кодирование напрямую может привести к переобучению, нужно разбивать на фолды, частотое описание для одного фолда брать с другого и т.д.

может, а может и нет, depends on. даже от используемого типа естиматора зависит, на одних это помогает, на других нет. для эксперимента - можно включить в это подможество значений те, у которых y = 1 (если это классификатор)

AT

Всем привет! Кому несложно, проверьте пожалуйста C1W4 https://www.coursera.org/learn/mathematics-and-python/peer/4vN1n/tsientral-naia-priediel-naia-tieoriema-svoimi-rukami/review/Gd8har7bEeqjSRKeFtLiXw

АГ

Sergey Salnikov

может, а может и нет, depends on. даже от используемого типа естиматора зависит, на одних это помогает, на других нет. для эксперимента - можно включить в это подможество значений те, у которых y = 1 (если это классификатор)

Абсолютно согласен, но добавить немного кросс-валидации лишним не будет. Но для бэйзлайна или предварительного отбора, в принципе, можно не заморачиваться и напрямую применить count к трейну, наверное...

АГ

А для соревнования, можно добавить еще тестовую часть при кодировании, и так учесть распределение категорий на тесте

SS

ну самой собой, сравнение моделей - только через cv (мой любимый размер - 3 splits * 3 repeats), и feature engeniring - после baseline

АГ

Sergey Salnikov

ну самой собой, сравнение моделей - только через cv (мой любимый размер - 3 splits * 3 repeats), и feature engeniring - после baseline

Нет, я имел в виду разбиение на фолды при кодировании, не кросс валидация, а просто использование других фолдов при построении частот

АГ

Sergey Salnikov

ну самой собой, сравнение моделей - только через cv (мой любимый размер - 3 splits * 3 repeats), и feature engeniring - после baseline

Имеется в виду 3 разных варианта разбиения на 3 фолда и усреднить? Шафлить каждый раз по-новому? Так?

АГ

И какие варианты инженеринга, если не секрет, предпочитаете? Взаимные произведения, их суммы и прочие комбинации?

SS

да, RepeatedStratifiedKFold.

SS

поведенческие шаблоны, но это просто набор данных специфичный, что-то типа click-prediction

АГ

Sergey Salnikov

да, RepeatedStratifiedKFold.

То есть получаем как бы не 3 фолда, а 9, что точнее даёт mean и упрощает подбор автоматический, как я понимаю

АГ

А медиану вместо mean не используете, чтобы от выбросов защититься?

SS

это примерно тоже, что повторять 3 раза kfold/3 с разными random_state, это не значит 9 фолдов. 3/3 - получилось из экспериментов с различными n_splits/n_repeats, искал наименьшую дисперсию, так что это зависит от данных и используемого алгоритма.