HL

Size: a a a

2020 July 05

Подскажите, кто делал проект Отток клиентов. Строю baseline модели,первая линейная. Как Вы кодировали категориальные признаки? Label encoding нельзя, OneHot из 38 признаков делает 60 тысяч

BM

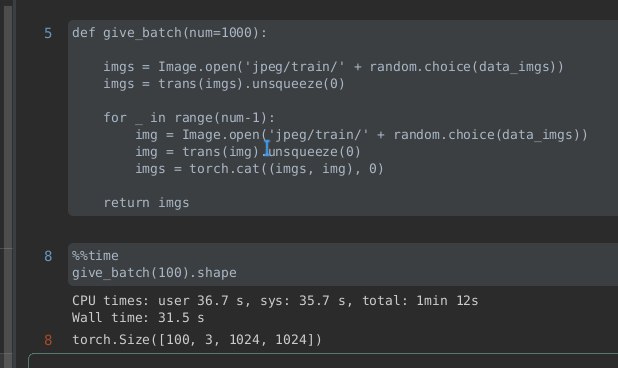

Здравствуйте, любители больших данных, у меня проблема, а именно не могу вместить нужное количество картинок в оперативную память, поэтому создал такую функцию для отбора по n картинок, но хоть у меня и ssd чтение с диска происходит медленно, есть ли способы ускорения формирования батча?

BM

31 секунда для 100 картинок это многовато

АГ

Helga Lilo

Подскажите, кто делал проект Отток клиентов. Строю baseline модели,первая линейная. Как Вы кодировали категориальные признаки? Label encoding нельзя, OneHot из 38 признаков делает 60 тысяч

Обратите внимание на binary encoding, хотя у меня и one hot отработал с бустингом неплохо. Можете попробовать mean encoding, но его непросто применять, можно переобучиться легко.

АГ

Не хотите кодировать, можете catboost использовать

HL

Для baseline нужно 3 решения, в случае с лесом и бустингом ок и label enc., а вот на линейной я задумалась,как закодировать,чтобы так не раздувать базу и имело смысл кодирование

АГ

Helga Lilo

Для baseline нужно 3 решения, в случае с лесом и бустингом ок и label enc., а вот на линейной я задумалась,как закодировать,чтобы так не раздувать базу и имело смысл кодирование

Ordinal, binary, mean( target, leaveoneout), count

АГ

Основные, которые не раздувают

АГ

Но низкую кардинальность лучше все равно one hot

АГ

Но мне кажется, что признаки с таким большим количеством категорий(больше 1000) лучше удалить

АГ

Не так много данных, чтобы они были информативны

HL

Артём Глазунов

Но низкую кардинальность лучше все равно one hot

Низкая кардинальность - это малое количество категорий в столбце?

АГ

Да

HL

Артём Глазунов

Но мне кажется, что признаки с таким большим количеством категорий(больше 1000) лучше удалить

Удаление столбцов с более 1000 категорий- это есть такая практика вообще? Не только касаемо этой задачи

АГ

Надо смотреть на то, насколько удаление признака повлияет на качество

АГ

Поэкспериментировать

HL

Уже с baseline решениями или после?

АГ

Я сразу попробовал

АГ

Там много мусора в признаках

АГ

Просто шумовых