A

Size: a a a

2020 May 12

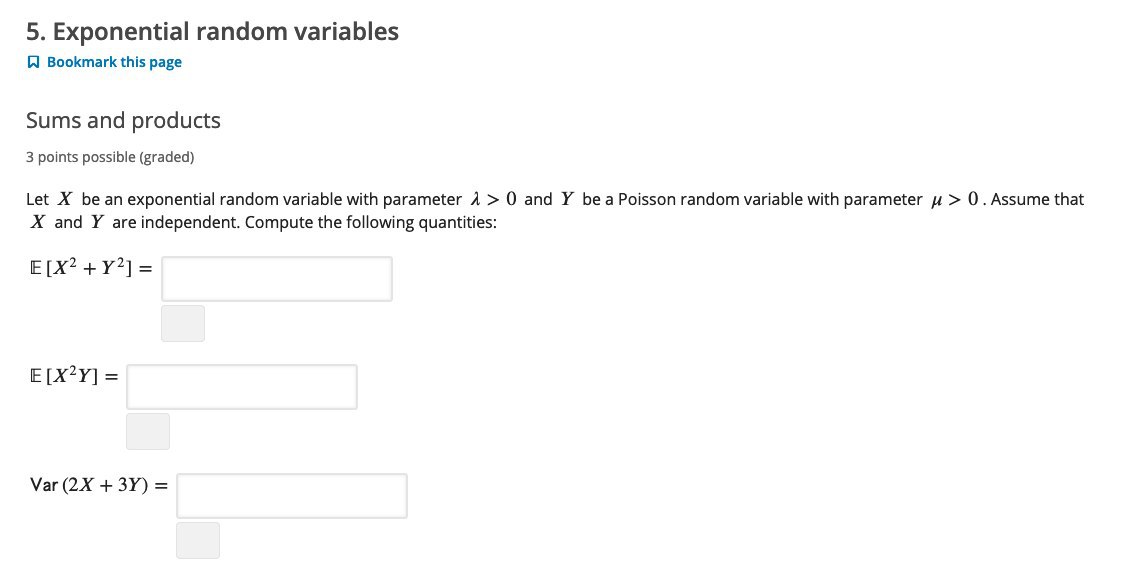

кто хочет мощного курса по статистике - на edx вчера начался MIT Fundamentals of Statistics.. Там сразу на вступительном тесте многое понятно ))

A

RN

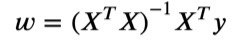

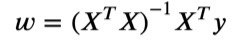

Доброго вечера. У меня назрел вопрос, может кто-то сможет объяснить почему при вычислении оптимальных весов для линейной регрессии по аналитической формуле получается результат, дающий ошибку на исходных данных(пусть и минимальную) ?

Потому что в исходных данных есть погрешность. полностью удовлетворить им невозможно.

К

Доброго вечера. У меня назрел вопрос, может кто-то сможет объяснить почему при вычислении оптимальных весов для линейной регрессии по аналитической формуле получается результат, дающий ошибку на исходных данных(пусть и минимальную) ?

Если не будет ошибки скорее всего ты переобучишь модель

ВЧ

Проверил, жду 7-ю неделю теперь :D

Уже начал делать) скоро будет готово

K

Это по сути система линейных уравнений (просто записана в матричном виде). Если она имеет однозначное решение (т.е. существуют такие корни/веса, при которых все игреки однозначно определяются из данных уравнений), то полученное решение совпадёт и с решением оптимизационной задачи, в которой мы минимизируем норму разности

|X*w - y|. Другое дело, что система уравнений эта может не иметь решений, а вот решение задачи оптимизации всегда будет (но не факт, что единственно)

|X*w - y|. Другое дело, что система уравнений эта может не иметь решений, а вот решение задачи оптимизации всегда будет (но не факт, что единственно)

ИШ

Функционал ошибки минимален когда выполняется равенство y = Xw, далее мы выводим аналитическое уравнение для w. Но в какой момент мы теряем равенство y и Xw я пока не могу понять

ИШ

Спасибо за ответы!

К

Функционал ошибки минимален когда выполняется равенство y = Xw, далее мы выводим аналитическое уравнение для w. Но в какой момент мы теряем равенство y и Xw я пока не могу понять

А у нас нет равенства

К

Мы приводим ошибку к минимуму

К

А не значения

К

Тут почитай)

ИШ

Почитаю, спасибо!

Б

RN

Это по сути система линейных уравнений (просто записана в матричном виде). Если она имеет однозначное решение (т.е. существуют такие корни/веса, при которых все игреки однозначно определяются из данных уравнений), то полученное решение совпадёт и с решением оптимизационной задачи, в которой мы минимизируем норму разности

|X*w - y|. Другое дело, что система уравнений эта может не иметь решений, а вот решение задачи оптимизации всегда будет (но не факт, что единственно)

|X*w - y|. Другое дело, что система уравнений эта может не иметь решений, а вот решение задачи оптимизации всегда будет (но не факт, что единственно)

Как же не единственно? Оно может быть не единственно, только когда меньше двух точек.

K

Как же не единственно? Оно может быть не единственно, только когда меньше двух точек.

Если у нас количество предикторов больше количества объектов в выборке

RN

Если у нас количество предикторов больше количества объектов в выборке

Да, сорри. Почему-то на двумерный случай мысленно смотрел

IL

Всем привет. Помогите с C2W1, пожалуйста. Задание, где нужно реализовывать стохастический градиентный спуск (задание 4). Как там нужно считать градиент? Я попробовал все варианты: и с y.shape[0] в знаменателе, и без.

2020 May 13

ИШ

Сам только что сдал эту задачу. Часа три сидел. Там проблемы с размерностями. Мне помогло создание Y одномерным массивом размерности (200), а не двумерными массивом размерности (200, 1)