КЧ

Size: a a a

2020 August 18

Типо зачем мне создавать этот трехмерный график

NN

Типо для того чтобы посмотреть визуально на кластеры.

VM

Да не, мне моего бакалавра по математике хватает, спасибо

ну ок

КЧ

Типо для того чтобы посмотреть визуально на кластеры.

Короче для красоты наверное

КЧ

А кто-то знает как данные подготовить чтобы засунуть в projector tensorflow ?

AI

Здесь похоже те же участники, что и во втором чате, поэтому спрошу конкретный вопрос - какую топологию сети (число слоев и нейронов) мне выбрать для проверки распознавания рукописных цифр на датасете из входа 8*8 пикселей каждый яркостью от 0 до 16? Если рассматривать простую задачу классификации. Понятно что на входе 64 нейрона а на выходе 10, по максимальному получать ответ. А сколько и какого размера взять промежуточных слоев?

DD

Короче для красоты наверное

Для того, чтобы не скучно было ждать, пока модель учится)

Если штырить просто на график лосса, он не очень интуитивен.

А если видеть, например, как эмбеддинги похожих слов постепенно в кучки собираются, то чувствуешь какое-то особенное удовлетворение)

Если штырить просто на график лосса, он не очень интуитивен.

А если видеть, например, как эмбеддинги похожих слов постепенно в кучки собираются, то чувствуешь какое-то особенное удовлетворение)

DD

Короче для красоты наверное

Ну и иногда можно что-то новое о датасете узнать - про ту же совместную встречаемость слов, например. То есть это можно рассматривать как инструмент разведывательного анализа.

КЧ

Ну и иногда можно что-то новое о датасете узнать - про ту же совместную встречаемость слов, например. То есть это можно рассматривать как инструмент разведывательного анализа.

О, крутой ответ, спасибо ,

Про EDA зашло

Про EDA зашло

DD

Всем привет. Стоит задача классификации текста на письменный/печатный. Уже смог убрать большинство шумов с фотографии и получил вот такие фотографии. Некоторые данные с картинки потерялись (из-за фильтрации), но буквы никуда не делись :D. Квадратики я брал с помощью контуров и вокруг них рисовал квадраты.

Есть ли какие-то мысли по тому, как можно определить, что текст печатный? (мне нужны варианты, что будут работать на печатном тексте 100%) Желательно без нейронки, чтобы максимально ускорить работу программы... Может есть какие-то способы проверить, что большинство линий вертикальны?(или ещё как-то) Пожалуйста, нужна помощь)

Есть ли какие-то мысли по тому, как можно определить, что текст печатный? (мне нужны варианты, что будут работать на печатном тексте 100%) Желательно без нейронки, чтобы максимально ускорить работу программы... Может есть какие-то способы проверить, что большинство линий вертикальны?(или ещё как-то) Пожалуйста, нужна помощь)

NN

Всем привет. Стоит задача классификации текста на письменный/печатный. Уже смог убрать большинство шумов с фотографии и получил вот такие фотографии. Некоторые данные с картинки потерялись (из-за фильтрации), но буквы никуда не делись :D. Квадратики я брал с помощью контуров и вокруг них рисовал квадраты.

Есть ли какие-то мысли по тому, как можно определить, что текст печатный? (мне нужны варианты, что будут работать на печатном тексте 100%) Желательно без нейронки, чтобы максимально ускорить работу программы... Может есть какие-то способы проверить, что большинство линий вертикальны?(или ещё как-то) Пожалуйста, нужна помощь)

Есть ли какие-то мысли по тому, как можно определить, что текст печатный? (мне нужны варианты, что будут работать на печатном тексте 100%) Желательно без нейронки, чтобы максимально ускорить работу программы... Может есть какие-то способы проверить, что большинство линий вертикальны?(или ещё как-то) Пожалуйста, нужна помощь)

Каскады хаара

DD

Каскады хаара

сейчас почитаю, спасибо

I

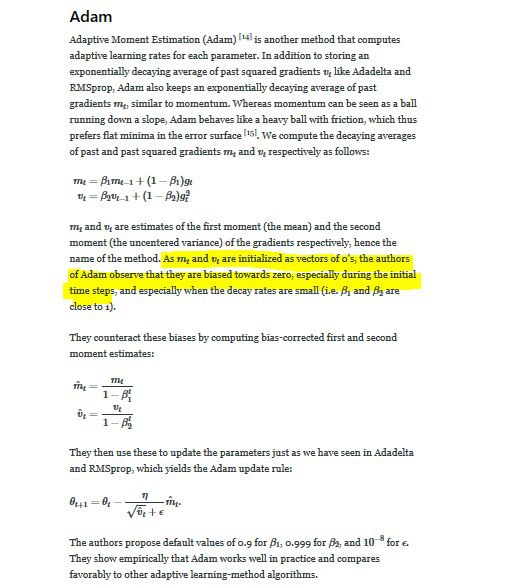

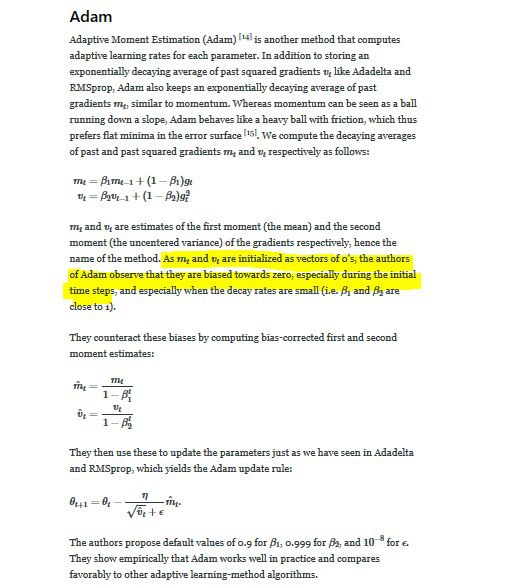

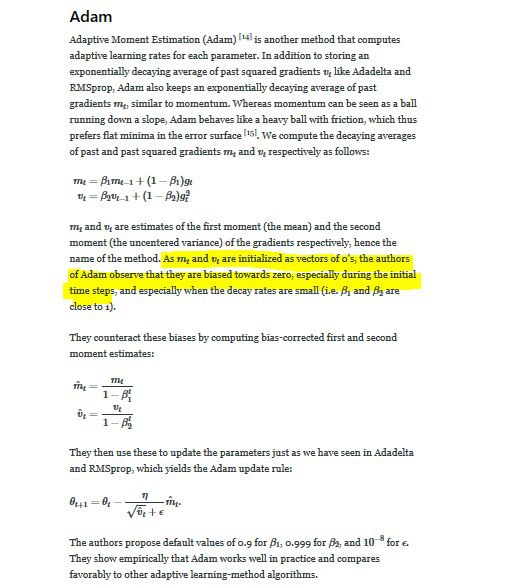

не совсем понимаю, в каком контексте и смысле тут пишется "biased towards zero". К примеру вообще мне понятие bias знакомо из линеарного классификатора, когда это свободное значение которое сдвигает "туда-сюда" относительно какой-либо оси наш hyperplane классификатора.

Что имеется в виду в этом семействе алгоритмов (Ада, Моментум, Адам), когда речь идет о том, что из-за инитиализации 0 их значение "biased toward 0", ну то есть если в прямом смысле типо если бы инитиализировать любым другим значением, допустим 2, то было бы biased towards 2, но чем формулы с дробей как-либо корректируют то изначальное значение, вокруг которого оно biased ?

Или судя по тексту это чисто эмпирическая находка авторов, и с ней просто нужно смирится ?

Что имеется в виду в этом семействе алгоритмов (Ада, Моментум, Адам), когда речь идет о том, что из-за инитиализации 0 их значение "biased toward 0", ну то есть если в прямом смысле типо если бы инитиализировать любым другим значением, допустим 2, то было бы biased towards 2, но чем формулы с дробей как-либо корректируют то изначальное значение, вокруг которого оно biased ?

Или судя по тексту это чисто эмпирическая находка авторов, и с ней просто нужно смирится ?

I

вопрос как бы вокруг этой коррекции, интуиция какая-то у нее есть ?

DD

не совсем понимаю, в каком контексте и смысле тут пишется "biased towards zero". К примеру вообще мне понятие bias знакомо из линеарного классификатора, когда это свободное значение которое сдвигает "туда-сюда" относительно какой-либо оси наш hyperplane классификатора.

Что имеется в виду в этом семействе алгоритмов (Ада, Моментум, Адам), когда речь идет о том, что из-за инитиализации 0 их значение "biased toward 0", ну то есть если в прямом смысле типо если бы инитиализировать любым другим значением, допустим 2, то было бы biased towards 2, но чем формулы с дробей как-либо корректируют то изначальное значение, вокруг которого оно biased ?

Или судя по тексту это чисто эмпирическая находка авторов, и с ней просто нужно смирится ?

Что имеется в виду в этом семействе алгоритмов (Ада, Моментум, Адам), когда речь идет о том, что из-за инитиализации 0 их значение "biased toward 0", ну то есть если в прямом смысле типо если бы инитиализировать любым другим значением, допустим 2, то было бы biased towards 2, но чем формулы с дробей как-либо корректируют то изначальное значение, вокруг которого оно biased ?

Или судя по тексту это чисто эмпирическая находка авторов, и с ней просто нужно смирится ?

Градиентный спуск - это попытка минимизировать суммарный лосс на всей обучающей выборке, и если бы мы знали градиент лосса на всей обучающей выборке, мы бы его точно могли загнать в локальный минимум. Но вместо этого мы делаем выборочную оценку этого градиента на маленьких батчах, и эта оценка - неточная.

"biased towards zero" в этом контексте значит, что оценка градиента на батче по модулю в среднем меньше, чем если бы мы его оценивали на всех наблюдениях сразу.

"biased towards zero" в этом контексте значит, что оценка градиента на батче по модулю в среднем меньше, чем если бы мы его оценивали на всех наблюдениях сразу.

AN

не совсем понимаю, в каком контексте и смысле тут пишется "biased towards zero". К примеру вообще мне понятие bias знакомо из линеарного классификатора, когда это свободное значение которое сдвигает "туда-сюда" относительно какой-либо оси наш hyperplane классификатора.

Что имеется в виду в этом семействе алгоритмов (Ада, Моментум, Адам), когда речь идет о том, что из-за инитиализации 0 их значение "biased toward 0", ну то есть если в прямом смысле типо если бы инитиализировать любым другим значением, допустим 2, то было бы biased towards 2, но чем формулы с дробей как-либо корректируют то изначальное значение, вокруг которого оно biased ?

Или судя по тексту это чисто эмпирическая находка авторов, и с ней просто нужно смирится ?

Что имеется в виду в этом семействе алгоритмов (Ада, Моментум, Адам), когда речь идет о том, что из-за инитиализации 0 их значение "biased toward 0", ну то есть если в прямом смысле типо если бы инитиализировать любым другим значением, допустим 2, то было бы biased towards 2, но чем формулы с дробей как-либо корректируют то изначальное значение, вокруг которого оно biased ?

Или судя по тексту это чисто эмпирическая находка авторов, и с ней просто нужно смирится ?

Что за книга?

I

AN