ИА

Size: a a a

2020 August 17

Использую json с гитхаба Kreozot

S

Добрый вечер, у меня наверно банальный вопрос, но все же: что такое обучение с подкреплением?

GA

Добрый вечер, у меня наверно банальный вопрос, но все же: что такое обучение с подкреплением?

Обучение с подкреплением (англ. reinforcement learning) — один из способов машинного обучения, в ходе которого испытуемая система (агент) обучается, взаимодействуя с некоторой средой. С точки зрения кибернетики, является одним из видов кибернетического эксперимента. Откликом среды (а не специальной системы управления подкреплением, как это происходит в обучении с учителем) на принятые решения являются сигналы подкрепления, поэтому такое обучение является частным случаем обучения с учителем, но учителем является среда или её модель. Также нужно иметь в виду, что некоторые правила подкрепления базируются на неявных учителях, например, в случае искусственной нейронной среды, на одновременной активности формальных нейронов, из-за чего их можно отнести к обучению без учителя.

S

Я читала, но можно как-то своими словами, может на примере даже

S

А то не совсем понятно

DD

Я читала, но можно как-то своими словами, может на примере даже

Пример: ты хочешь научить нейронку играть в крестики-нолики.

Как училась бы нейронка с учителем: смотрела бы на примеры сыгранных людьми игр, и пыталась бы угадать, куда человек сделал следующий ход.

Как училась бы нейронка с подкреплением: играла бы с другим алгоритмом (или сама с собой), и делала бы полу-рандомные ходы, пытаясь при этом максимизировать вероятность выигрыша.

Как училась бы нейронка с учителем: смотрела бы на примеры сыгранных людьми игр, и пыталась бы угадать, куда человек сделал следующий ход.

Как училась бы нейронка с подкреплением: играла бы с другим алгоритмом (или сама с собой), и делала бы полу-рандомные ходы, пытаясь при этом максимизировать вероятность выигрыша.

S

Пример: ты хочешь научить нейронку играть в крестики-нолики.

Как училась бы нейронка с учителем: смотрела бы на примеры сыгранных людьми игр, и пыталась бы угадать, куда человек сделал следующий ход.

Как училась бы нейронка с подкреплением: играла бы с другим алгоритмом (или сама с собой), и делала бы полу-рандомные ходы, пытаясь при этом максимизировать вероятность выигрыша.

Как училась бы нейронка с учителем: смотрела бы на примеры сыгранных людьми игр, и пыталась бы угадать, куда человек сделал следующий ход.

Как училась бы нейронка с подкреплением: играла бы с другим алгоритмом (или сама с собой), и делала бы полу-рандомные ходы, пытаясь при этом максимизировать вероятность выигрыша.

Спасибо, вроде как все понятнее стало!

DD

Пример: ты хочешь научить нейронку играть в крестики-нолики.

Как училась бы нейронка с учителем: смотрела бы на примеры сыгранных людьми игр, и пыталась бы угадать, куда человек сделал следующий ход.

Как училась бы нейронка с подкреплением: играла бы с другим алгоритмом (или сама с собой), и делала бы полу-рандомные ходы, пытаясь при этом максимизировать вероятность выигрыша.

Как училась бы нейронка с учителем: смотрела бы на примеры сыгранных людьми игр, и пыталась бы угадать, куда человек сделал следующий ход.

Как училась бы нейронка с подкреплением: играла бы с другим алгоритмом (или сама с собой), и делала бы полу-рандомные ходы, пытаясь при этом максимизировать вероятность выигрыша.

Соответственно, в чём плюсы обучения с учителем:

- теоретически позволяет выучивать принятие стратегических решений, т.е. на много ходов вперёд

- не требует много размеченных данных, т.к. сама размечает себе данные в ходе обучения

В чём основной минус:

- нужна очень хорошая модель "среды", которая подаёт сигналы и даёт вознаграждение. In real life, такую среду смоделировать очень сложно, а в реальной среде запускать эксперименты - дорого и опасно.

В случае игр типа крестиков-ноликов, шахмат, го, или простых видеоигр типа atari, эта среда полностью описывается правилами игры, и специально моделировать ничего не нужно, поэтому именно в этой области обучение с подкреплением достигло успеха.

- теоретически позволяет выучивать принятие стратегических решений, т.е. на много ходов вперёд

- не требует много размеченных данных, т.к. сама размечает себе данные в ходе обучения

В чём основной минус:

- нужна очень хорошая модель "среды", которая подаёт сигналы и даёт вознаграждение. In real life, такую среду смоделировать очень сложно, а в реальной среде запускать эксперименты - дорого и опасно.

В случае игр типа крестиков-ноликов, шахмат, го, или простых видеоигр типа atari, эта среда полностью описывается правилами игры, и специально моделировать ничего не нужно, поэтому именно в этой области обучение с подкреплением достигло успеха.

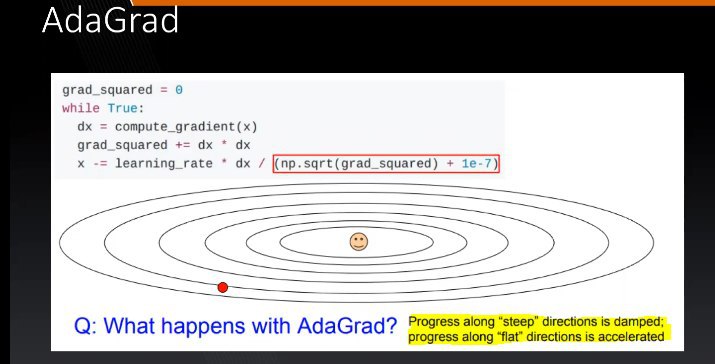

I

пытаюсь понять интуитивно почему выделенные фразы верны. Насколько я понимаю, если в многомерном функции одно из weights дает высокое значение градиента, оно получит относительно большое соотношение к сумме, значит значительнее будет влиять на направление спуска (к минимуму), но почему когда многомерная поверхность более менее прямая будет ускорение, а когда с большими магнитудами, она будет притормаживаться от такой конфигурации этой вариации градиаент десценда, может кто интуицию дать ?

2020 August 18

VC

пытаюсь понять интуитивно почему выделенные фразы верны. Насколько я понимаю, если в многомерном функции одно из weights дает высокое значение градиента, оно получит относительно большое соотношение к сумме, значит значительнее будет влиять на направление спуска (к минимуму), но почему когда многомерная поверхность более менее прямая будет ускорение, а когда с большими магнитудами, она будет притормаживаться от такой конфигурации этой вариации градиаент десценда, может кто интуицию дать ?

Я бы это объяснил как, если у нас раньше по параметру была большая магнитуда, а теперь маленькая, то лучше не сильно менять...

EZ

пытаюсь понять интуитивно почему выделенные фразы верны. Насколько я понимаю, если в многомерном функции одно из weights дает высокое значение градиента, оно получит относительно большое соотношение к сумме, значит значительнее будет влиять на направление спуска (к минимуму), но почему когда многомерная поверхность более менее прямая будет ускорение, а когда с большими магнитудами, она будет притормаживаться от такой конфигурации этой вариации градиаент десценда, может кто интуицию дать ?

Большие градиенты -> g>1 -> dx/g уменьшается

Маленькие -> g<1 -> dx/g увеличивается

Маленькие -> g<1 -> dx/g увеличивается

I

круто, ясно, спасибо

VC

Именно их тезис я бы объяснил как, если у нас постоянно небольшие изменения, то сильно изменяется, но если у нас они резко меняются, то в эта сумма помнит тот большой градиент и соответственно, не даёт параметру сильно увеличиваться, чтобы такой ситуации не было, надо уменьшать равномерно

М

Ребята всем привет, ставится задача убирать китайский/русский и тд акцент и преобразовывать в английский акцент, все это в реал тайме, в какую сторону рыть?

A

Ребята всем привет, ставится задача убирать китайский/русский и тд акцент и преобразовывать в английский акцент, все это в реал тайме, в какую сторону рыть?

В сторону цифровой обработки сигналов

VM

Большие градиенты -> g>1 -> dx/g уменьшается

Маленькие -> g<1 -> dx/g увеличивается

Маленькие -> g<1 -> dx/g увеличивается

Кстати если хочешь подтянуть математику есть такой вот вот канал t.me/ViyshMat

EZ

Vladimir Mironov

Кстати если хочешь подтянуть математику есть такой вот вот канал t.me/ViyshMat

Да не, мне моего бакалавра по математике хватает, спасибо

КЧ

Ребят, а как я могу улучшить точность модели используя

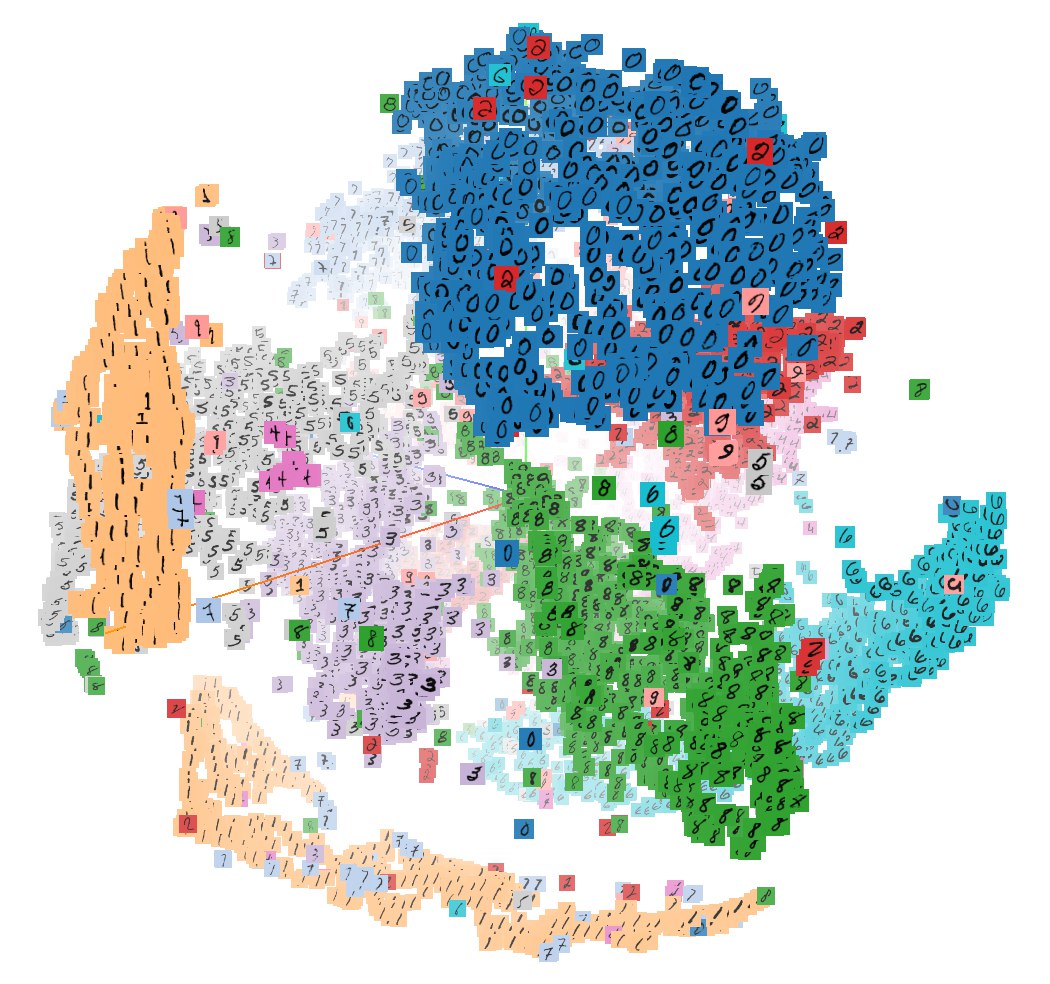

http://projector.tensorflow.org/

http://projector.tensorflow.org/