SM

Size: a a a

2019 December 25

Спасибо за здравые советы.

SM

Каждый день в облако — в те же деньги упирается.

2019 December 26

b

Каждый день в облако — в те же деньги упирается.

В данном случае о деньгах должен беспокоиться заказчик, а не вы. Чудес не бывает.

AN

https://www.vist-spb.ru/articles/346-r5_r6_large_hdd.html

Коллеги не только обоснованно рассчитали реальную надёжность массивов, но и сделали наглядные графики. Спасибо Левенталю за публикацию в ACM, которая привела к реалистичному взгляду на вещи.

Коллеги не только обоснованно рассчитали реальную надёжность массивов, но и сделали наглядные графики. Спасибо Левенталю за публикацию в ACM, которая привела к реалистичному взгляду на вещи.

А господа могут раскрыть тему?

Видел аналогичное исследование лет 6-7 назад, и ещё тогда не мог понять, как авторы так лихо перескакивают с BER, который для одного диска, на общий объем массива.

Видел аналогичное исследование лет 6-7 назад, и ещё тогда не мог понять, как авторы так лихо перескакивают с BER, который для одного диска, на общий объем массива.

VS

А господа могут раскрыть тему?

Видел аналогичное исследование лет 6-7 назад, и ещё тогда не мог понять, как авторы так лихо перескакивают с BER, который для одного диска, на общий объем массива.

Видел аналогичное исследование лет 6-7 назад, и ещё тогда не мог понять, как авторы так лихо перескакивают с BER, который для одного диска, на общий объем массива.

Тервер базовый. Вероятность возникновения двух независимых событий

AN

Я ниумею в тервер на достаточном уровне. Но вроде как оно так не работает - если верить вот этой телеге. https://zen.yandex.ru/media/id/5a3bc6e5256d5ca91fc90afe/300-let-v-iskajennoi-realnosti-5df74a43aad43600affce4d0

Ну и просто из здравого смысла выглядит не очень.

Ну и просто из здравого смысла выглядит не очень.

T

Единственное, в статье не хватает предельного перехода на Пуассона. И ссылки на RAID Reliability Calculator.

Вообще, странно говорить о "смерти" RAID, когда в индустрии, в том числе в SDS, просто ограничивается размер группы дисков/чанков.

Вообще, странно говорить о "смерти" RAID, когда в индустрии, в том числе в SDS, просто ограничивается размер группы дисков/чанков.

S

Для научного обоснования достаточно показателей BER, MTBF, конфигурации системы и знаний теории вероятности и мат. статистики со 2-3 курсов вуза.

А можете показать расчеты с учётом MTBF? Из BER как я понял интересен только UBER

S

Еще добавлю, что "домашнего" железа должного уровня для организации RAID, указанных в статье выше, тупо не существует.

Есть

S

У меня в сохо хранилке единички две и даже непытался 5-6 собирать

У меня 6 на 5 дисках по 3Т, консумерские хитачи, массиву 8 лет аптайма стукнуло, паттерн read most

S

Я поясню свой вопрос. Мы мелким фирмам у кого бюджет в пределах 250к руб за «сервер» ставим md софтверный на линухе. Да, на бытовом железе. Обычно это подфайлопомойку. Она ес-но бекапится в облако. Пока залетов со слетевшим полностью рейдом не было. Но и установок не много. Конечно, я хочу ясного прогноза как часто менять прийдется. Но если есть соображения про неожиданный фейл, то они очень нужны. Вот и интересуюсь.

В статье из DOFH как раз оно

S

За счет чего вылет второго?

В статье об этом сказано - за счёт UBER

S

SLO же никакого. Через даунтайм только.

Что такое SLO?

S

Dmitrii Barsukov

это точно так.

вот оригинал https://www.zdnet.com/article/why-raid-6-stops-working-in-2019/

вот оригинал https://www.zdnet.com/article/why-raid-6-stops-working-in-2019/

Это другая статья, ее русская версия тут уже была, но в основе та же математика

S

То что Вы написали — сценарий в моей голове. Тут же статьи пугают ужасами, мол, даже 6 не спасает. Если это правда, то неделя. Между бекапами.

Не спасет, но шансы на выживание у 6 почти вдвое выше чем у 5

S

Dmitrii Barsukov

меньше объем дисков, больше в штуках, из разных партий и raid5

Согласно методике Левенталя, увеличение суммарного объема или уменьшение скорости вращения шпинделя - ключ к снижению надёжности.

S

А господа могут раскрыть тему?

Видел аналогичное исследование лет 6-7 назад, и ещё тогда не мог понять, как авторы так лихо перескакивают с BER, который для одного диска, на общий объем массива.

Видел аналогичное исследование лет 6-7 назад, и ещё тогда не мог понять, как авторы так лихо перескакивают с BER, который для одного диска, на общий объем массива.

Там все просто. У тебя из UBER вычисляется вероятность успешного прочтения одного бита (пусть это a). Требование одновременного успешного чтения n битов по теорверу даёт перемножение вероятностей чтения одиночных битов, отсюда итог в виде a^n. Для трёх дисков у тебя n втрое больше чем для одного, вот и вся магия.

S

Единственное, в статье не хватает предельного перехода на Пуассона. И ссылки на RAID Reliability Calculator.

Вообще, странно говорить о "смерти" RAID, когда в индустрии, в том числе в SDS, просто ограничивается размер группы дисков/чанков.

Вообще, странно говорить о "смерти" RAID, когда в индустрии, в том числе в SDS, просто ограничивается размер группы дисков/чанков.

Статья, безусловно простая, но в ней есть базис, на основе которого можно многое рассчитать

S

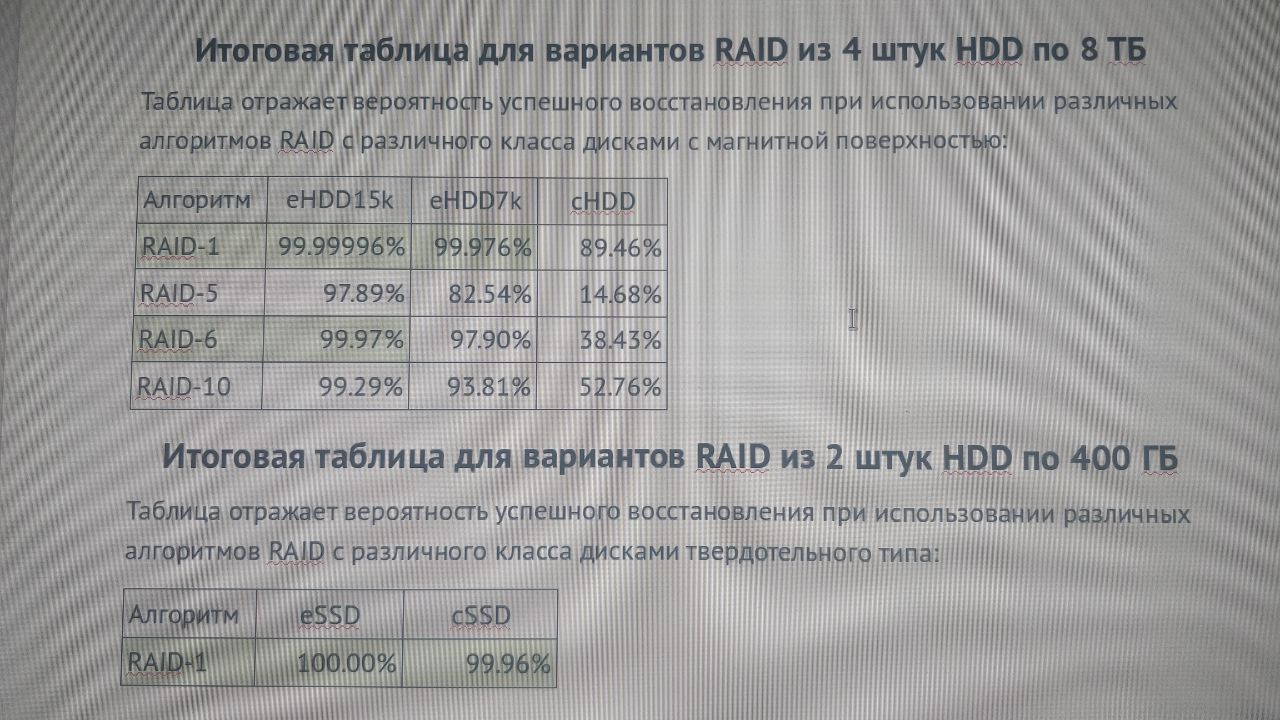

Это пример расчета по этой методике