Вот да)) а так и есть ведь))) в то же время, с парсингом больших и популярных сацтов справляются далеко не все)

Про названия - я тут книгу увидел...

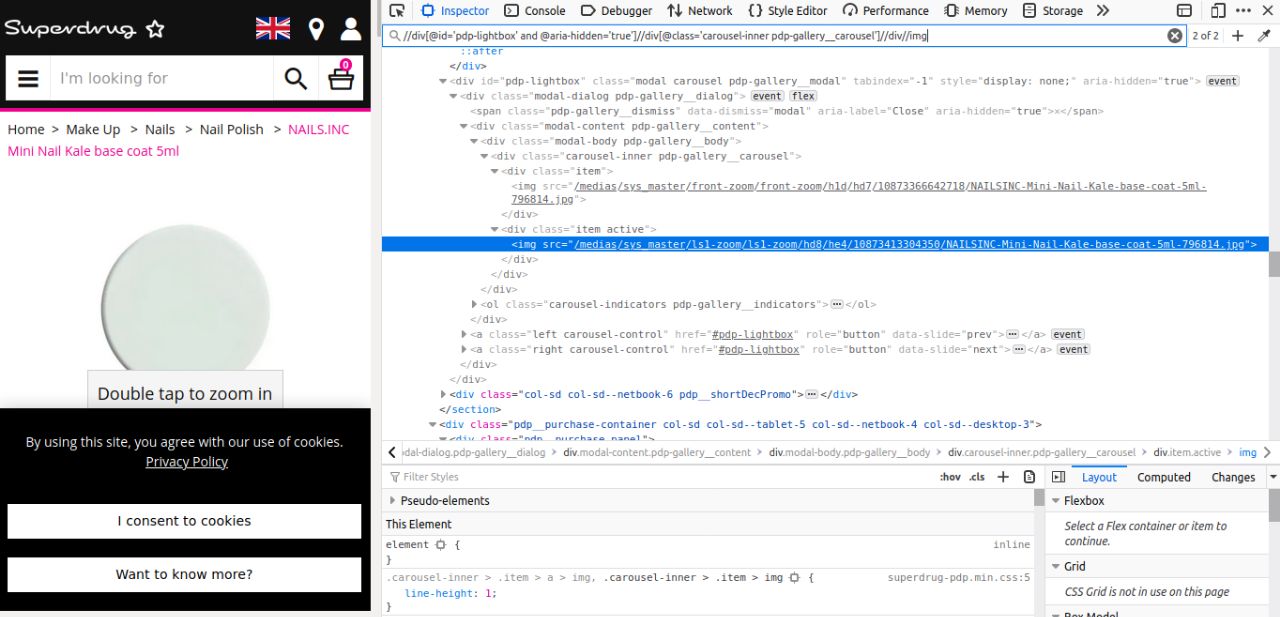

https://www.labirint.ru/books/713541/ - звучит завораживающе)) посмотрел отрывок, а там про ФБ что-то типа "мы предполагаем, что у вас уже есть аккаунт с доступом к апи" и ниже "вы соберете данные только тех аккаунтов, кто установит ваше приложение" ) ...и часть книги про то, как пользоваться гитхабом, докером и Jupiter Notebook ))

Боюсь, про кластеризацию и прочее там все также скудно - но не видел текста полностью.

Вот не покидает часто ощущение, что слова громче реальности) ...смотришь презентации с профильных конференций о применении ИИ в разных бизнесах и "увеличили продажи на 7%" )) я понимаю, если бы на 70% или 700%)) ...а от чат-ботов порой тошно. и т.п.) печалька.