AB

Size: a a a

2019 December 17

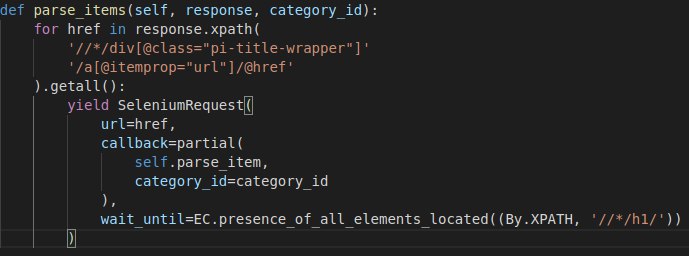

а с SeleniumRequest никто не работал? настроил селениум, делаю с wait_until=EC.presence_of_all_elements_located((By.XPATH, '//*/h1/')), но в итоге все равно не нахожу элемент, при этом никаких timeout эксепшенов нет и 200ки в логах

AB

AB

при этом parse_item не находит элемент

AR

зачем / в конце?

AB

там text() был, ща уберу попробую..

AB

ну не, так же. Не понятно, паук запускается, все ок. В чистом селениум-скрипте выдал бы timeoutException если бы не нашел элемент. как так, не понимаю..

AB

блин, отмена миссии, вроде нашел проблему..ругается уже мой пайплайн, потому что спайдер завершился с itemcount, не знаю почему конечно, но дело уже другое

AB

блин, нет, с пайпом все ок, без ограничения тоже падает.. ну ладно

EV

вернулась.

подходящий пример сайтмапа состоящего из других сайтмапов:

https://parfums.ua/sitemap.xml

пока я добилась того, что он из набора сайтмапов берет 4, и потом в каждом из 4 берет по 4 ссылки.

а мне нужно чтоб взял ВСЕ, и внутри каждого сайтмапа уже взял по 4 ссылки.

подходящий пример сайтмапа состоящего из других сайтмапов:

https://parfums.ua/sitemap.xml

пока я добилась того, что он из набора сайтмапов берет 4, и потом в каждом из 4 берет по 4 ссылки.

а мне нужно чтоб взял ВСЕ, и внутри каждого сайтмапа уже взял по 4 ссылки.