АМ

Size: a a a

2020 January 04

АМ

а в идеале хотелось бы, чтобы основная функция приостанавливалась на время получения списка авторов

АМ

подскажите пожалуйста в какую сторону смотреть

AR

Inline_requests

AR

Код не смотрел

AR

Ну или просто в мете передать, если там не цикл

АМ

Inline_requests

все получилось, спасибо)

2020 January 05

В

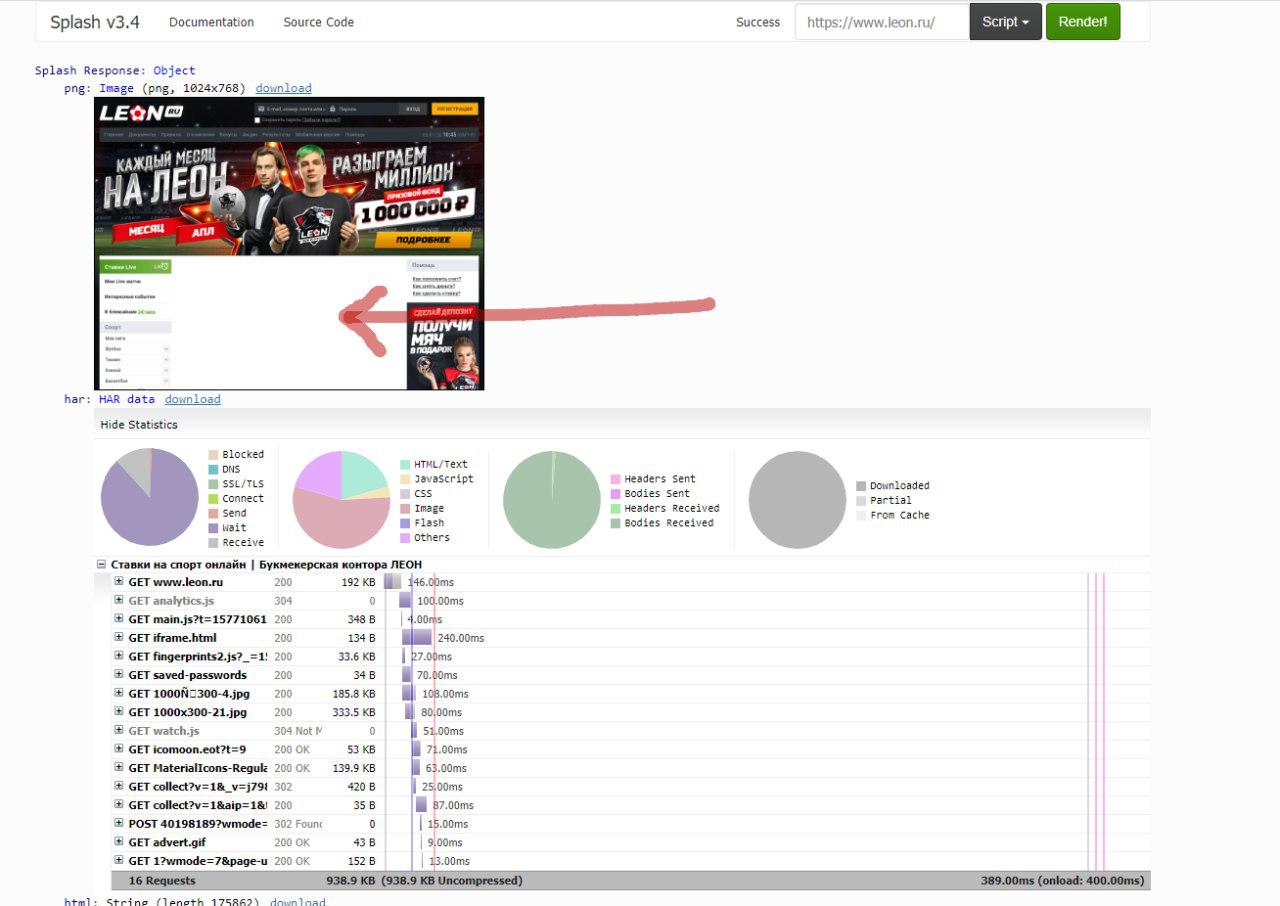

Доброго дня суток. Начал использовать Splash для отображения страниц. Обнаружил, что он отображает далеко не все, что нужно. Попробовал другой вариант - Selenium. Он работает, есть даже реализация scrapy-selenium, но не поддерживает параллельные запросы. Вторая проблема с ним - иногда падает/зависает до окончания работы паука, если нужно пропарсить много страниц. Есть ли у вас другие варианты на примете?

AR

Может просто в сплеше ждать нужного элемента?

AR

МС

народ. скрапи как то позволяет посмотреть количество запланированных запростов?

МС

либо я в логику не раздупляю, либо одно из двух....

на парсинг чуть больше 10 тыс локаций, периодиченость лога 1 минута, через минуту сделано 839 запросов + 2152 дополнительных (запрос доп. данных) на счетчике 25....

это что получается, у меня CONCURRENT_REQUESTS=50, и скрапи берет первые 50 ссылок и пока очередь не очистится, остальные брать не будет?

def start_requests(self):

for ids in self.data:

yield scrapy.Request(....)

self.location_requests += 1

на парсинг чуть больше 10 тыс локаций, периодиченость лога 1 минута, через минуту сделано 839 запросов + 2152 дополнительных (запрос доп. данных) на счетчике 25....

это что получается, у меня CONCURRENT_REQUESTS=50, и скрапи берет первые 50 ссылок и пока очередь не очистится, остальные брать не будет?

AR

да

AR

AR

есть планы это исправить

МС

от жеж, пичаль-тоска.....

ну, придется костылить 😂

ну, придется костылить 😂