AR

Size: a a a

2020 January 03

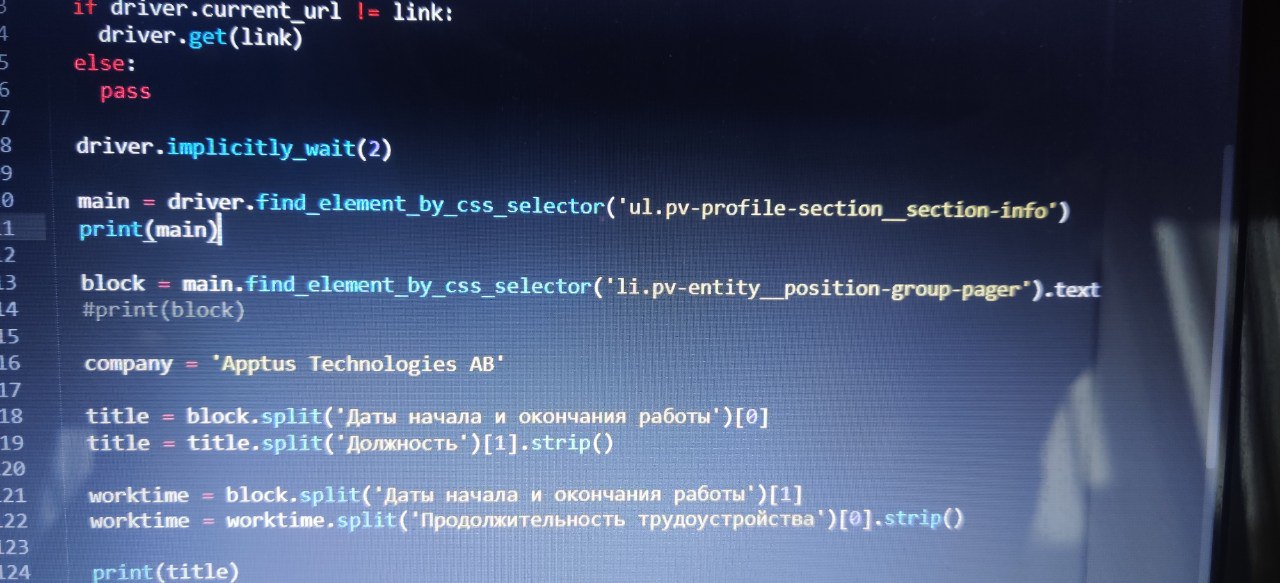

Селектором легко взять первый li, но как взять второй ? 😁

Смешно

J

J

Есть же nth-child в css, а в xpath порядковый номера [n]

Пасиб

АН

Нахера линкедин парсить аписните?

МС

А нахрена фоткать монитор, если существуют скриншоты?

ну, вдруг человеку религия (или СБ) не позволяет поставить телегу на комп :)

МС

Нахера линкедин парсить аписните?

данные людей -> злые спамеры -> деньги

2020 January 04

АМ

я собираю инфу с сайта через сплэш, без него выдает 403, я вытаскиваю оттуда урл, по которому мне надо перейти в процессе скрапинга, чтобы вытащить оттуда инфу, этот урл редиректит на этот же сайт, но уже на конкретную страницу. через шелл попробовал зайти на http://localhost:8050/render.html?url= + исходный урл, выдает 404. код тут https://pastebin.com/rzLY0nhb , подскажите, как формировать запрос чтобы и сплэш не отвалился, и редирект нормально прошел?

BL

я собираю инфу с сайта через сплэш, без него выдает 403, я вытаскиваю оттуда урл, по которому мне надо перейти в процессе скрапинга, чтобы вытащить оттуда инфу, этот урл редиректит на этот же сайт, но уже на конкретную страницу. через шелл попробовал зайти на http://localhost:8050/render.html?url= + исходный урл, выдает 404. код тут https://pastebin.com/rzLY0nhb , подскажите, как формировать запрос чтобы и сплэш не отвалился, и редирект нормально прошел?

во-первых если тупо сделать

то страница загрузится нормально

headers = {'User-agent': 'Mozilla/5.0'}

url = 'https://www.sciencedirect.com/journal/mendeleev-communications/vol/29/issue/6'

r = requests.get(url, headers=headers)то страница загрузится нормально

BL

во-вторых можешь пояснить что дальше нужно выгрузить? список авторов каждой работы или что-то еще?

АМ

да, на первой странице если много авторов, то сокращается несколько авторов посередине в виде "...", а мне нужны все

АМ

чет про юзерагенты не догадался

BL

@Mellolian дальше делаешь что-то типа

from lxml import etree

tree = etree.HTML(r.text)

papers = tree.xpath('//li[@class="js-article-list-item article-item u-padding-xs-top u-margin-l-bottom"]')

for paper in papers:

authors = paper.xpath('.//div[@class="text-s u-clr-grey8 js-article__item__authors"]')

if authors:

if '...' in authors[0].text:

get_all_authors()

BL

и тупо переходишь по ссылке на страницу с более полным описанием, забираешь оттуда полный список авторов и все

АМ

ого, спасибо, попробую разобраться)

BL

спрашивай если чо не ясно, в authors.text лежит строка со списком авторов которую ты видишь на сайте

АМ

спрашивай если чо не ясно, в authors.text лежит строка со списком авторов которую ты видишь на сайте

я внимательно посмотрел, оказалось что примерно это у меня и написано, у меня вот самая проблема get_all_authors() написать. суть в том, чтобы внутри функции parse_authors паука нужно как-то впихнуть articleItem и проапдейтить ее в виде articleItem['authors']=item_authors

АМ

а на выдачу списка авторов скрапи ругается "ERROR: Spider must return Request, BaseItem, dict or None, got 'str' in <GET...>"