Д

Size: a a a

2020 October 27

А в целом на что смотреть нужно. На какие показатели?

I

Щас в процессе как раз...

на хабре есть статья про iops и fio. там основные моменты объяснены.

I

если кратко: нужно сравнить показания иопсов и мб/с. не забыть сравнить и latency.

СГ

В продолжение предыдущей переписки по поводу низкой производительности дисковой системы внутри виртуалки.

Вы порекомендовали fio протестировать.

Нашел в группе ваш предыдущий пост с готовыми тестами bench.sh и bench.fio

Прогнал их на виртуалке на файле в ФС.

Отчеты во вложении.

Как этим пользоваться? На что смотреть?

Гуглил кучу инфы, ничего одназначного не нашел.

Заранее спасибо!

Вы порекомендовали fio протестировать.

Нашел в группе ваш предыдущий пост с готовыми тестами bench.sh и bench.fio

Прогнал их на виртуалке на файле в ФС.

Отчеты во вложении.

Как этим пользоваться? На что смотреть?

Гуглил кучу инфы, ничего одназначного не нашел.

Заранее спасибо!

дайте ссылку на тот пост, там пару раз была ошибка в скриптах.

Д

если кратко: нужно сравнить показания иопсов и мб/с. не забыть сравнить и latency.

Да, я про это читал. Но какие показатели хорошие, какие плохие...

Д

дайте ссылку на тот пост, там пару раз была ошибка в скриптах.

СГ

А в целом на что смотреть нужно. На какие показатели?

latency, iops, и сама производительность

Д

Но какие показатели хорошие, какие плохие... Т.е. на что ориентироваться. Если так, то хорошо, так, то плохо. Так ну сойдет... Я это имею ввиду

I

Но какие показатели хорошие, какие плохие... Т.е. на что ориентироваться. Если так, то хорошо, так, то плохо. Так ну сойдет... Я это имею ввиду

зависит от потребностей и железа.

Д

дайте ссылку на тот пост, там пару раз была ошибка в скриптах.

https://t.me/ru_proxmox/83392 Ссылка. Есть ошибка в этих скриптах?

СГ

https://t.me/ru_proxmox/83392 Ссылка. Есть ошибка в этих скриптах?

в этих нет, но это совсем старая версия. Я после этого делал другую и выкладывал в другой группе (ZFS). Там тестируется на разном кол-ве заданий (имитация множества клиентов). В данном случае проверяется только для одного клиента

Д

в этих нет, но это совсем старая версия. Я после этого делал другую и выкладывал в другой группе (ZFS). Там тестируется на разном кол-ве заданий (имитация множества клиентов). В данном случае проверяется только для одного клиента

Могли бы в чат скинуть? Я протестирую у себя

СГ

Могли бы в чат скинуть? Я протестирую у себя

да, сейчас найду. Только я не до конца понял что вы хотели бы измерить. Мерять скорость внутри ВМ - это можно, но нужно понимать что вы меряете в таком случае скорость "бутерброда": скорость самого устройства + скорость файловой системы хоста + скорость подсистемы виртуализации (virtio) + скорость файловой системы внутри ВМ (ext4/...). Да, так тоже можно мерять - например проверять какое сочетание типа файловой системы хоста + настроек виртуализации даёт наибольший/наилучший эффект для виртуальной машины.

Д

да, сейчас найду. Только я не до конца понял что вы хотели бы измерить. Мерять скорость внутри ВМ - это можно, но нужно понимать что вы меряете в таком случае скорость "бутерброда": скорость самого устройства + скорость файловой системы хоста + скорость подсистемы виртуализации (virtio) + скорость файловой системы внутри ВМ (ext4/...). Да, так тоже можно мерять - например проверять какое сочетание типа файловой системы хоста + настроек виртуализации даёт наибольший/наилучший эффект для виртуальной машины.

Проблема такая: iowait на ВМ в 10Тб очень высокий 40-65%, причем постоянно.

Эта ВМ это сервер резервного копирования UrBackup. Сама ФС внутри ВМ - btrfs. Размер 10Тб, занято почти 100%. Я понимаю, что возможно из-за этого тормозит, но прежде чем расширять диск до 12Тб, я хочу точно понять как максимально повысить производительность диска внутри ВМ. Для этого я хочу выработать правильный подход к решению этой проблемы. Вот и пытаюсь понять как измерять производительность.

Структура диской системы:

На Proxmox 2 mdadm RAID массива:

1. mdadm RAID 1 из 2-х NVMe дисков по 2Tb SSD M.2 2280 Intel SSDPEKNW020T8X1 https://www.xcom-shop.ru/intel_ssdpeknw020t8x1_679766.html. На нем хранятся ВМ, которые требуют очень быстрого отклика диска.

2. mdadm RAID 6 из 4-х дисков WD Original WUH721414ALE6L4 14Tb https://topcomputer.ru/tovary/1212566/.

На рейдах LVM, На LVM файловая система ext4, на ней образы ВМ хранятся в qcow2.

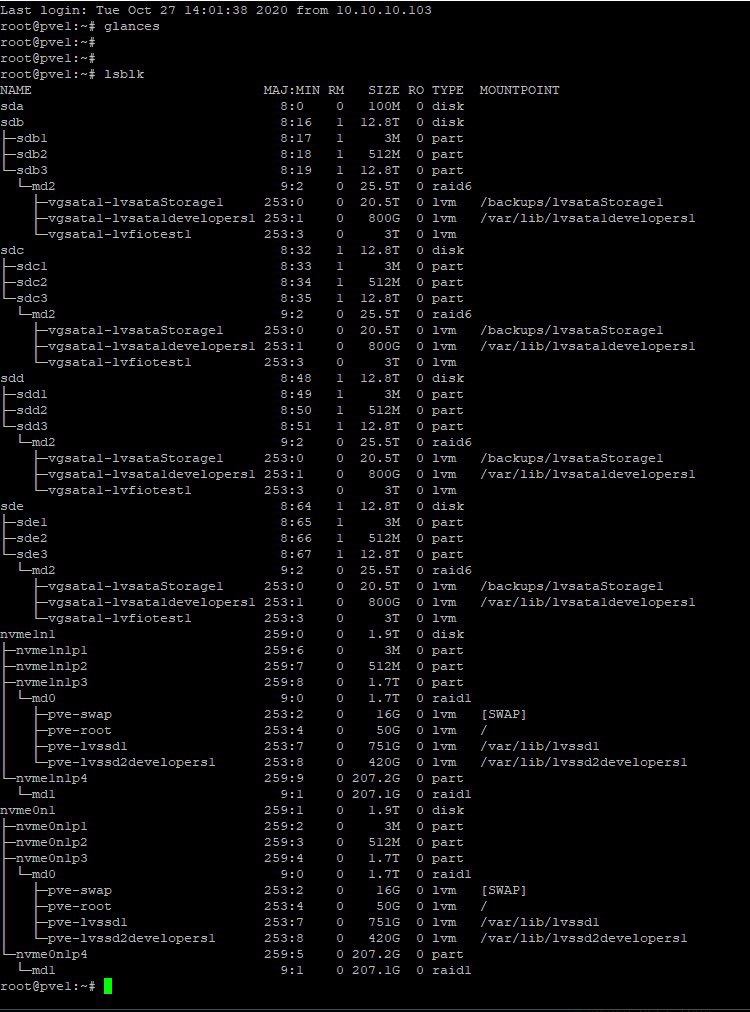

lsblk на скриншоте ниже.

Эта ВМ это сервер резервного копирования UrBackup. Сама ФС внутри ВМ - btrfs. Размер 10Тб, занято почти 100%. Я понимаю, что возможно из-за этого тормозит, но прежде чем расширять диск до 12Тб, я хочу точно понять как максимально повысить производительность диска внутри ВМ. Для этого я хочу выработать правильный подход к решению этой проблемы. Вот и пытаюсь понять как измерять производительность.

Структура диской системы:

На Proxmox 2 mdadm RAID массива:

1. mdadm RAID 1 из 2-х NVMe дисков по 2Tb SSD M.2 2280 Intel SSDPEKNW020T8X1 https://www.xcom-shop.ru/intel_ssdpeknw020t8x1_679766.html. На нем хранятся ВМ, которые требуют очень быстрого отклика диска.

2. mdadm RAID 6 из 4-х дисков WD Original WUH721414ALE6L4 14Tb https://topcomputer.ru/tovary/1212566/.

На рейдах LVM, На LVM файловая система ext4, на ней образы ВМ хранятся в qcow2.

lsblk на скриншоте ниже.

Д

I

Проблема такая: iowait на ВМ в 10Тб очень высокий 40-65%, причем постоянно.

Эта ВМ это сервер резервного копирования UrBackup. Сама ФС внутри ВМ - btrfs. Размер 10Тб, занято почти 100%. Я понимаю, что возможно из-за этого тормозит, но прежде чем расширять диск до 12Тб, я хочу точно понять как максимально повысить производительность диска внутри ВМ. Для этого я хочу выработать правильный подход к решению этой проблемы. Вот и пытаюсь понять как измерять производительность.

Структура диской системы:

На Proxmox 2 mdadm RAID массива:

1. mdadm RAID 1 из 2-х NVMe дисков по 2Tb SSD M.2 2280 Intel SSDPEKNW020T8X1 https://www.xcom-shop.ru/intel_ssdpeknw020t8x1_679766.html. На нем хранятся ВМ, которые требуют очень быстрого отклика диска.

2. mdadm RAID 6 из 4-х дисков WD Original WUH721414ALE6L4 14Tb https://topcomputer.ru/tovary/1212566/.

На рейдах LVM, На LVM файловая система ext4, на ней образы ВМ хранятся в qcow2.

lsblk на скриншоте ниже.

Эта ВМ это сервер резервного копирования UrBackup. Сама ФС внутри ВМ - btrfs. Размер 10Тб, занято почти 100%. Я понимаю, что возможно из-за этого тормозит, но прежде чем расширять диск до 12Тб, я хочу точно понять как максимально повысить производительность диска внутри ВМ. Для этого я хочу выработать правильный подход к решению этой проблемы. Вот и пытаюсь понять как измерять производительность.

Структура диской системы:

На Proxmox 2 mdadm RAID массива:

1. mdadm RAID 1 из 2-х NVMe дисков по 2Tb SSD M.2 2280 Intel SSDPEKNW020T8X1 https://www.xcom-shop.ru/intel_ssdpeknw020t8x1_679766.html. На нем хранятся ВМ, которые требуют очень быстрого отклика диска.

2. mdadm RAID 6 из 4-х дисков WD Original WUH721414ALE6L4 14Tb https://topcomputer.ru/tovary/1212566/.

На рейдах LVM, На LVM файловая система ext4, на ней образы ВМ хранятся в qcow2.

lsblk на скриншоте ниже.

>На рейдах LVM, На LVM файловая система ext4, на ней образы ВМ хранятся в qcow2.

выглядит не очень производительно )

выглядит не очень производительно )

Д

Я готов все полностью переделать. Всю дисковую подсистему, чтобы производительность была максимальной. Только никак не найду самый оптимальный вариант.

Д

Вот именно в этом проблема