GE

Size: a a a

2020 April 12

И может кто-нибудь подскажет, как из даты (гггг-мм-дд чч:мм:сс) можно часы вытаскивать? чтобы отдельно их не экспортировать из базы

Вот так попробуйте Hour(Time(Now()) ) , только вместо Now() ваше поле подставьте в формате дата-время, но лучше сделайте это в скрипте загрузки, что бы измерение уже готове было. Вам бы и дату надо отдельно хранить

SS

Вот так попробуйте Hour(Time(Now()) ) , только вместо Now() ваше поле подставьте в формате дата-время, но лучше сделайте это в скрипте загрузки, что бы измерение уже готове было. Вам бы и дату надо отдельно хранить

О, спасибо. У нас сейчас дата, час заказа и время - три отдельных поля.

SS

Спасибо, ребята, всем!

SS

AVG ( aggr ( count ( заказ ) , день, час) и таблица по часам

👍 то что нужно!

2020 April 13

EI

Коллеги, добрый день всем.

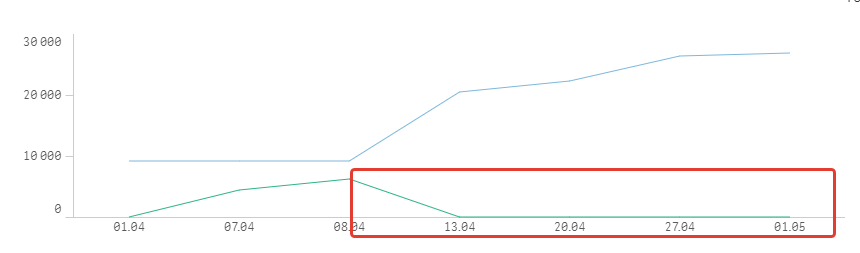

Кто-нибудь уже приступал к "антикризисным" моделям?

Кто-нибудь встречал источники данных сovid тематики по регионам РФ ?

Кто-нибудь уже приступал к "антикризисным" моделям?

Кто-нибудь встречал источники данных сovid тематики по регионам РФ ?

VE

V

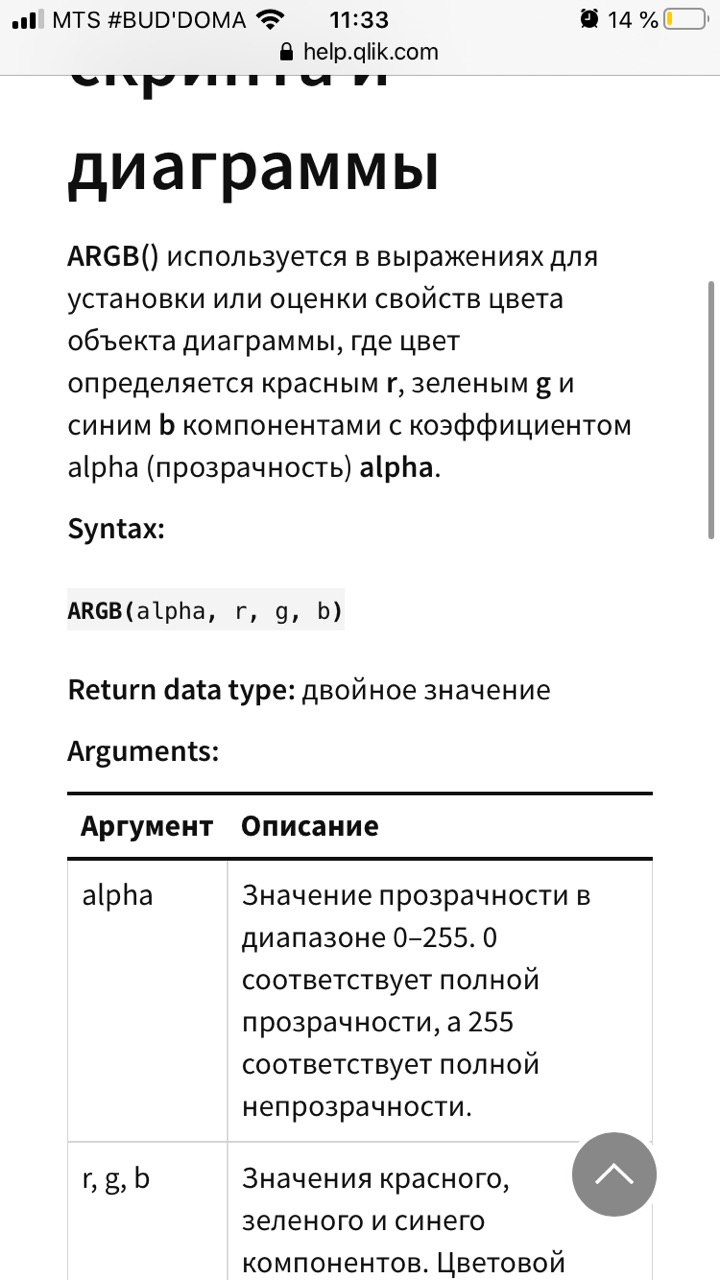

В backgroudgcolor линии можно уловие написать if(date > ?, argb(0,1,1,1), нужный цвет). В argb() первый аргумент это прозрачность 0-255

VE

спасибо за идею!

ЕС

В backgroudgcolor линии можно уловие написать if(date > ?, argb(0,1,1,1), нужный цвет). В argb() первый аргумент это прозрачность 0-255

прозрачность до 127)

V

прозрачность до 127)

V

Почему?) :)

V

Она двух частей состоит? Ну в смысле прозрачность +x?

V

ЕС

Даж не знаю почему я так думал)

V

Даж не знаю почему я так думал)

Потому что это клик и простое часто оказывается ловушкой))

Y

Коллеги, добрый день! Столкнулась с такой проблемой.. У нас временно нет "хранилища" для файлов qvd на сервере и поэтому задача, которая легко бы решилась, будь у нас хранилище, стала проблемой. Дело вот в чем. С сервера с редактора загрузки QS обращается к кликхаусу с задачей выявления новых пользователей за день. Но данных настолько много (включая текстовые поля), что просто "не тянет" - то падает по таймауту, то по memory limit, то банально теряет соединение с базой и выдает ошибку. Если б было хранилище, я бы просто выгружала ежедневно уникальных пользователей за период в квд-файлы, а после в запросе проверяла б if exists и таким образом производилась бы своего рода инкрементальная загрузка. Но теперь мне нужно как-то организовать цикл, где сначала грузятся данные за один период, потом период сдвигается - и все это происходит в теле "SQL-части". Такое вообще возможно? Для примера - упростила максимально запрос. Вот во второй части должна как то сдвигаться дата на заданный промежуток..

Y

ЕС

Коллеги, добрый день! Столкнулась с такой проблемой.. У нас временно нет "хранилища" для файлов qvd на сервере и поэтому задача, которая легко бы решилась, будь у нас хранилище, стала проблемой. Дело вот в чем. С сервера с редактора загрузки QS обращается к кликхаусу с задачей выявления новых пользователей за день. Но данных настолько много (включая текстовые поля), что просто "не тянет" - то падает по таймауту, то по memory limit, то банально теряет соединение с базой и выдает ошибку. Если б было хранилище, я бы просто выгружала ежедневно уникальных пользователей за период в квд-файлы, а после в запросе проверяла б if exists и таким образом производилась бы своего рода инкрементальная загрузка. Но теперь мне нужно как-то организовать цикл, где сначала грузятся данные за один период, потом период сдвигается - и все это происходит в теле "SQL-части". Такое вообще возможно? Для примера - упростила максимально запрос. Вот во второй части должна как то сдвигаться дата на заданный промежуток..

простите, а что случилось с QVD хранилищем?

Y

Вы удивитесь, но его просто не было и пока получаются все разрешения и "находятся" необходимые ресурсы (а в ооочень большой компании это всегда месяц(ы)), приходится извращениями заниматься..

ЕС

Т.е. у вас нет возможности создать в клике подключение с типом Папка, и сохранять QVD на самом сервере клика?