Всем привет.

Подскажите плз по Jmetr’у

Вопрос такой - как организовать сценарий.

Например, требуется выполнять 1-ю операцию 10 раз в минуту, а 2-ю операцию 3 раза в минуту(условно).

Каждая операция завернута в свой TestFragment(это же ок практика?)

Так вот, как при помощи ultimate thread group подать нагрузку так, чтобы операции выполнились с их требуемыми интенсивностями? На сколько я понимаю, в utg можно нстраивать сценарий только для всей тред группы целиком, без разбивки на операции.

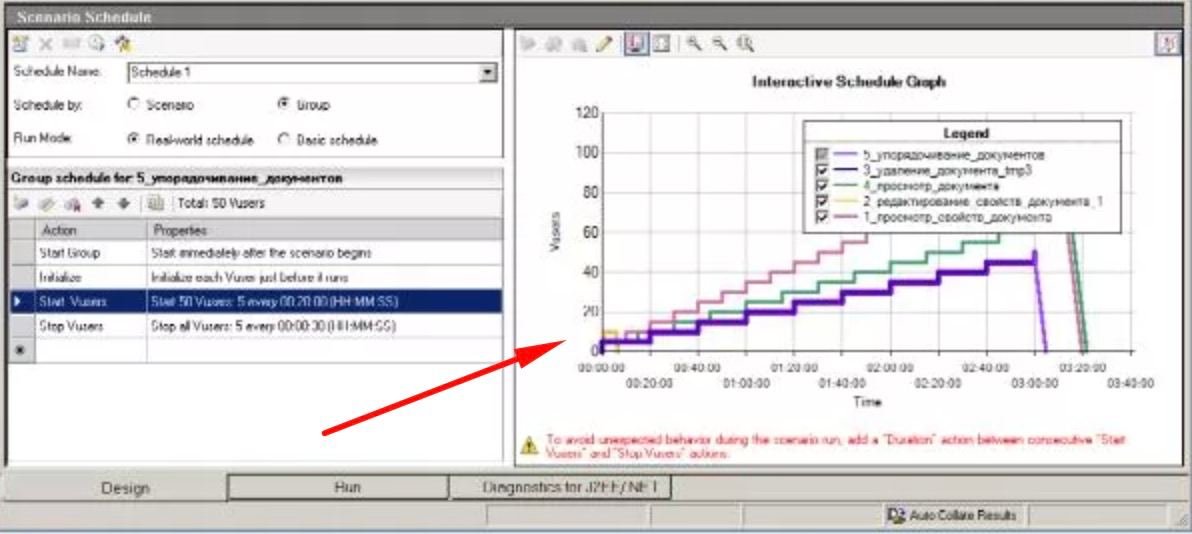

Ну а если короче, как составлять примерно вот такие сценарии(как на скрине) в JMeter, аналогичные HP LR Controller?

варианты следующие:

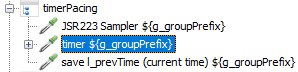

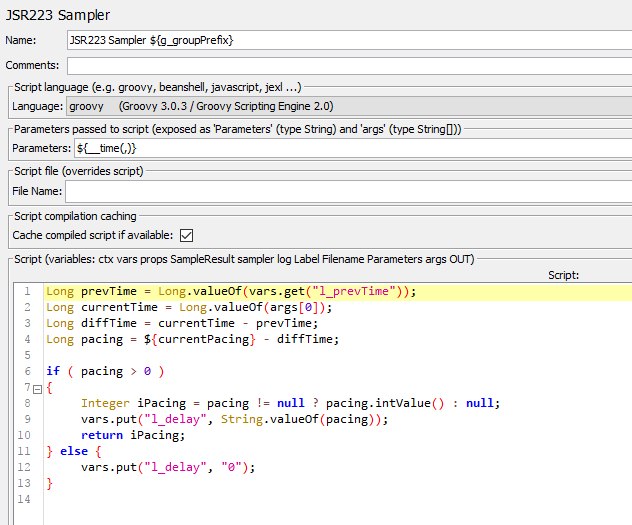

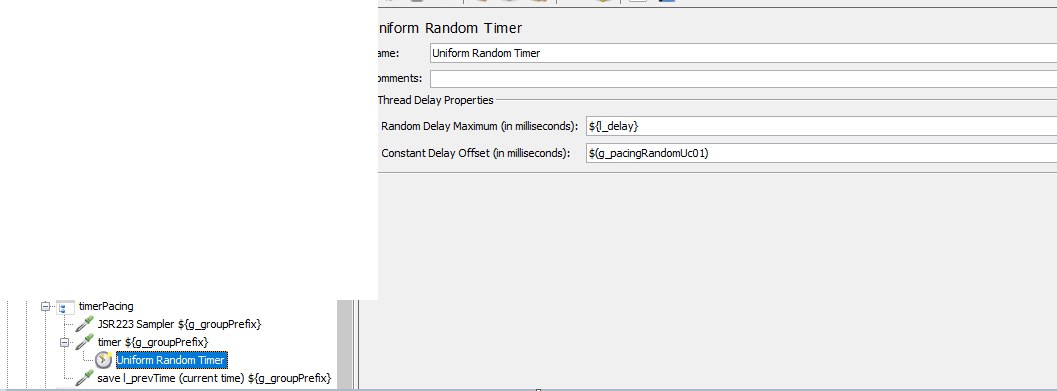

1) наиболее похожий на LR:

Количество пользователей регулируется через *Ultimate Thread Group*

вместо Pacing в самом начале тредгруппы размещается *Flow Control Action* внутри которого лежит *Constant Throughput Timer*

Меня он радует тем, что я всё сам контролирую и бесит крайне неудобным способом настройки Ultimate Thread Group

2) Более удобный вариант:

Используете обычные тредгруппы, количество потоков проставляете с запасом с самого начала теста.

(работать они будут все)

В самом начале тредгруппы размещается *Flow Control Action* внутри которого лежит *Throughput Shaping Timer*

В нём задаёте RPS (не для каждого VU как в LR, а итоговый, который должен подаваться jmeter-ом)

Этот вариант намного более удобен при ручной настройке. Из минусов - некоторые жалуются, что при низкой интенсивности возможны проблемы, но я не поручусь, сам их не видел.

==