VG

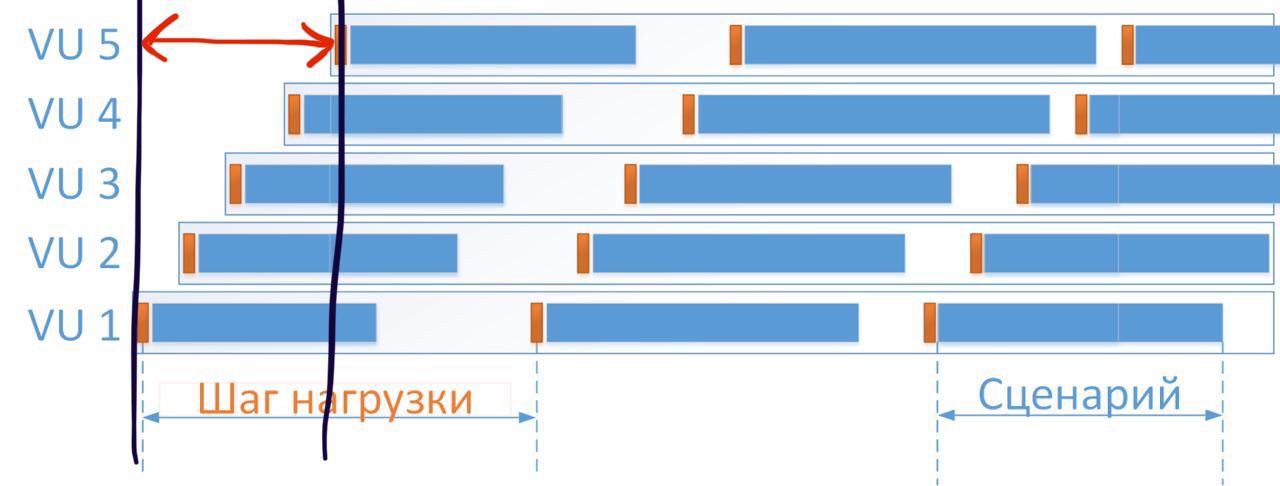

дело в том, что пользователей, которых ты хочешь эмулировать их не существует - это абстракция. для сайта это условно 1 поток с которого идут запросы в каком-то порядке. для концептуально правильной нагрузки необходимо чтобы это запросы просто шли в похожем на прод количестве и всё. а то как это реализовано в jmeter - это абстракция и никакого отношения к концепции нагрузки не имеет, кроме привязок типа "тред" "запрос" и оперирования ими