PZ

Size: a a a

2021 October 14

причем, обсуждения могут длиться неделями

PZ

есть несколько очевидных идей, но хочется таки нахаляву не убиваясь ручной разметкой получить эвристику от тех, кто над этим уже посидел.

IS

это все специфические детали задачи о которой и не спрашивается пока (есть json и т.д.).

есть общее направление — обработка временных событий. Есть ряд технологий.

дальше поехали частности

есть общее направление — обработка временных событий. Есть ряд технологий.

дальше поехали частности

PZ

да надо попроще мыслить) что интересно людям вне банков?

Например исследовательские проекты Телеграмма.

я тоже над этим думал, но поленился размечать.

Например исследовательские проекты Телеграмма.

я тоже над этим думал, но поленился размечать.

IS

при чем здесь проще и банки?

можно вообще не думать.

и зачем со мной спорить?

есть автор задачи — хочет, читает.

не хочет — не читает.

тематика никак от этого не пострадает.

кстати, про телегу ничего сказано не было — просто json.

можно вообще не думать.

и зачем со мной спорить?

есть автор задачи — хочет, читает.

не хочет — не читает.

тематика никак от этого не пострадает.

кстати, про телегу ничего сказано не было — просто json.

PZ

Так просто пытаюсь добавить и свои очевидные соображения по этому поводу.

telegram desktop в json выгружает сообщения. А вот как смысл из них извлечь - уже задача.

telegram desktop в json выгружает сообщения. А вот как смысл из них извлечь - уже задача.

IS

добавляйте автору, спектр мнений полезен.

истина будет на пересечении

json же — это формат. в него выгружает почти любое приложение.

истина будет на пересечении

json же — это формат. в него выгружает почти любое приложение.

PZ

окей, автор. отступление про process minging - ложный путь.

После того как образуются достаточно длинные тексты, можно использовать то что в NLP накопили.

- классический bag of words и кластеризацию типа t-sne.

- специальный модуль для визуализации поинтереснее есть - pyLDAvis

- поскольку короткие сообщения в чате не содержат много информации самой по себе, а подразумевают много контекста,

желательно пропустить через какой-нибудь модный алгоритм преобразующий человеческие слова в embeddings. И снова делать там t-sne.

После того как образуются достаточно длинные тексты, можно использовать то что в NLP накопили.

- классический bag of words и кластеризацию типа t-sne.

- специальный модуль для визуализации поинтереснее есть - pyLDAvis

- поскольку короткие сообщения в чате не содержат много информации самой по себе, а подразумевают много контекста,

желательно пропустить через какой-нибудь модный алгоритм преобразующий человеческие слова в embeddings. И снова делать там t-sne.

AD

Ребята привет. Кто делал прогнозы с Prophet, есть такая проблема, концы прогноза завышенные модель выдает., что делать, чем играть?

m = Prophet(

yearly_seasonality=False, daily_seasonality=False

seasonality_mode='multiplicative' # сейчас стоит multiplicative - не роняет прогноз!

)

IS

Павел, мне нравится Ваш стиль! Возражать всегда и во всем.

есть несколько НО.

1. не было ни примера данных ни слов про телегу. там может быть все, что угодно.

2. еще был вопрос про визуализацию.

3. если говорить про такие чаты, то не reply сообщения могут быть ответом почти на что угодно. на сообщение годичной давности!

можно кубик кидать — примерно такая же вероятность угадать.

4. прежде чем говорить о NLP идет чистка текста регулярками. да-да, толпа регулярок... грусть-тоска.

в целом, стратегия анализа коротких сообщений на практике так себе идея.

в случае всяких смс/твитов или заявок в SD иногда даже человек не может понять, что же там было написано. если говорить про реальный бизнес и реальные задачи.

есть несколько НО.

1. не было ни примера данных ни слов про телегу. там может быть все, что угодно.

2. еще был вопрос про визуализацию.

3. если говорить про такие чаты, то не reply сообщения могут быть ответом почти на что угодно. на сообщение годичной давности!

можно кубик кидать — примерно такая же вероятность угадать.

4. прежде чем говорить о NLP идет чистка текста регулярками. да-да, толпа регулярок... грусть-тоска.

в целом, стратегия анализа коротких сообщений на практике так себе идея.

в случае всяких смс/твитов или заявок в SD иногда даже человек не может понять, что же там было написано. если говорить про реальный бизнес и реальные задачи.

PZ

Все так. Но, очевидно, исследователя манит сама идея и вера в нейротехнологии в целом.

Пробовать надо.

Пробовать надо.

IS

вот именно, пробовать.

почти все задачи похожи в исходной постановке и разнятся в способах решения.

а что, цифры гоняем туда-сюда.

но тут ведь совет был спрошен.

а пробовать чужими руками — это $

почти все задачи похожи в исходной постановке и разнятся в способах решения.

а что, цифры гоняем туда-сюда.

но тут ведь совет был спрошен.

а пробовать чужими руками — это $

PZ

а с возражениями все очевидно : нет смысла вообще сообщать миру информацию не противоречащую общеизвестной.

IS

ну и чудненько.

Данное высказывание — ложно.

Истинно ли это высказывание или нет?

Данное высказывание — ложно.

Истинно ли это высказывание или нет?

PZ

Не известно, но оно наверняка будет использовано при анализе автором разных источников. Причем, вес у источников разный.

sk

всем привет, не могу найти датасет с рейтингами фильмов kinopoisk - кто-то сталкивался и может поделиться?

Р

Могу предложить работенку, кому надо?

VM

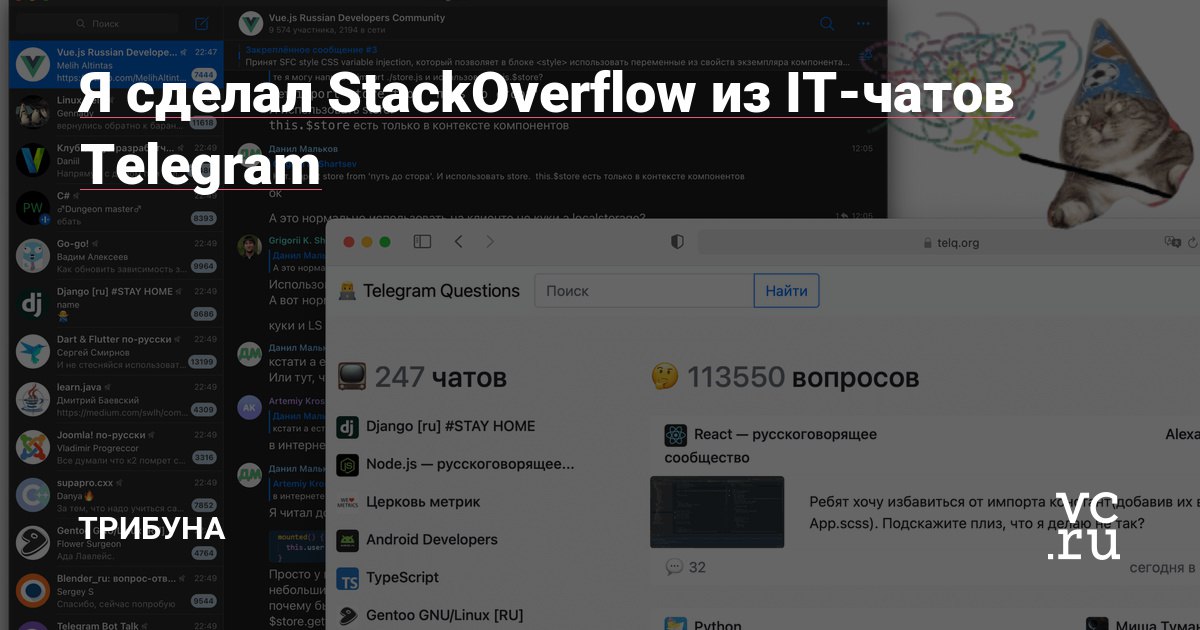

Если это сообщения из телеграма, то вот интересная статья.

https://vc.ru/281922

https://vc.ru/281922

PZ

ну вот самого интересного, сути вопроса там и нет. Просто кто-то любитель попрограммировать на GO. И он надеется что Google сделает все остальное.