SK

Size: a a a

2020 December 20

Если пропаду, то считайте меня коммунистом ⚒

SK

Ресурс-менеджер - это такая компьютерная программа.

SK

http://*ResourceManager

SK

Я про него подумал, но у меня ничего такого нет..

TM

i'll try passing None

A

Ребят, такой вопрос.

Мне нужно несколько обученных питоновских ML и DL моделей закинуть в продакшен чтобы генерировать предсказания. Сначала по запросу (типа curl -X POST ...) а в будущем и в реальном времени. Одна модель написана используя Scikit-learn и ещё несколько на TensorFlow и PyTorch. В будущем планируется планируется также брать данные из HBase и Elasticsearch.

А теперь проблема. Боссы хотят что-бы все модели работали на Спарке и готовы предоставить только спарк-кластер для моих моделей. Пытаюсь теперь понять как лучше это все задеплоить.

1) Первый вариант - это переписать ML модель с Scikit-learn на Spark ML. Что делать с DL правда не понятно. Нужно чтоб работало на GPUs. Нашёл несколько вариантов на гитхабе: elephas (https://github.com/maxpumperla/elephas), TensorFlowOnSpark (https://github.com/yahoo/TensorFlowOnSpark), BigDL (https://github.com/intel-analytics/BigDL) и Analytics Zoo (https://github.com/intel-analytics/analytics-zoo). Но они не поддерживают пока что Spark 3. BigDL и Analytics Zoo ещё вдобавок не поддерживают вычисления на GPUs (в будущем планирует).

2) Второй вариант - это добавить PySpark к коду и добавить UDFs. Но пока я не понял можно ли весь код завернуть в них.

3) У TensorFlow кажется появилась какая-то поддержка Спарка https://github.com/tensorflow/ecosystem/tree/master/spark. Пока не пробовал, но выглядит очень сырым продуктом.

4) Ещё есть Koalas со своими dataframes на Спарке. Но пока я не вижу как она может пригодится.

5) Ещё слышал про форматы PMML, PFA и ONNX. Но не знаю на сколько это актуально.

Что посоветуете в моём случае?

Мне нужно несколько обученных питоновских ML и DL моделей закинуть в продакшен чтобы генерировать предсказания. Сначала по запросу (типа curl -X POST ...) а в будущем и в реальном времени. Одна модель написана используя Scikit-learn и ещё несколько на TensorFlow и PyTorch. В будущем планируется планируется также брать данные из HBase и Elasticsearch.

А теперь проблема. Боссы хотят что-бы все модели работали на Спарке и готовы предоставить только спарк-кластер для моих моделей. Пытаюсь теперь понять как лучше это все задеплоить.

1) Первый вариант - это переписать ML модель с Scikit-learn на Spark ML. Что делать с DL правда не понятно. Нужно чтоб работало на GPUs. Нашёл несколько вариантов на гитхабе: elephas (https://github.com/maxpumperla/elephas), TensorFlowOnSpark (https://github.com/yahoo/TensorFlowOnSpark), BigDL (https://github.com/intel-analytics/BigDL) и Analytics Zoo (https://github.com/intel-analytics/analytics-zoo). Но они не поддерживают пока что Spark 3. BigDL и Analytics Zoo ещё вдобавок не поддерживают вычисления на GPUs (в будущем планирует).

2) Второй вариант - это добавить PySpark к коду и добавить UDFs. Но пока я не понял можно ли весь код завернуть в них.

3) У TensorFlow кажется появилась какая-то поддержка Спарка https://github.com/tensorflow/ecosystem/tree/master/spark. Пока не пробовал, но выглядит очень сырым продуктом.

4) Ещё есть Koalas со своими dataframes на Спарке. Но пока я не вижу как она может пригодится.

5) Ещё слышал про форматы PMML, PFA и ONNX. Но не знаю на сколько это актуально.

Что посоветуете в моём случае?

e

Ребят, такой вопрос.

Мне нужно несколько обученных питоновских ML и DL моделей закинуть в продакшен чтобы генерировать предсказания. Сначала по запросу (типа curl -X POST ...) а в будущем и в реальном времени. Одна модель написана используя Scikit-learn и ещё несколько на TensorFlow и PyTorch. В будущем планируется планируется также брать данные из HBase и Elasticsearch.

А теперь проблема. Боссы хотят что-бы все модели работали на Спарке и готовы предоставить только спарк-кластер для моих моделей. Пытаюсь теперь понять как лучше это все задеплоить.

1) Первый вариант - это переписать ML модель с Scikit-learn на Spark ML. Что делать с DL правда не понятно. Нужно чтоб работало на GPUs. Нашёл несколько вариантов на гитхабе: elephas (https://github.com/maxpumperla/elephas), TensorFlowOnSpark (https://github.com/yahoo/TensorFlowOnSpark), BigDL (https://github.com/intel-analytics/BigDL) и Analytics Zoo (https://github.com/intel-analytics/analytics-zoo). Но они не поддерживают пока что Spark 3. BigDL и Analytics Zoo ещё вдобавок не поддерживают вычисления на GPUs (в будущем планирует).

2) Второй вариант - это добавить PySpark к коду и добавить UDFs. Но пока я не понял можно ли весь код завернуть в них.

3) У TensorFlow кажется появилась какая-то поддержка Спарка https://github.com/tensorflow/ecosystem/tree/master/spark. Пока не пробовал, но выглядит очень сырым продуктом.

4) Ещё есть Koalas со своими dataframes на Спарке. Но пока я не вижу как она может пригодится.

5) Ещё слышал про форматы PMML, PFA и ONNX. Но не знаю на сколько это актуально.

Что посоветуете в моём случае?

Мне нужно несколько обученных питоновских ML и DL моделей закинуть в продакшен чтобы генерировать предсказания. Сначала по запросу (типа curl -X POST ...) а в будущем и в реальном времени. Одна модель написана используя Scikit-learn и ещё несколько на TensorFlow и PyTorch. В будущем планируется планируется также брать данные из HBase и Elasticsearch.

А теперь проблема. Боссы хотят что-бы все модели работали на Спарке и готовы предоставить только спарк-кластер для моих моделей. Пытаюсь теперь понять как лучше это все задеплоить.

1) Первый вариант - это переписать ML модель с Scikit-learn на Spark ML. Что делать с DL правда не понятно. Нужно чтоб работало на GPUs. Нашёл несколько вариантов на гитхабе: elephas (https://github.com/maxpumperla/elephas), TensorFlowOnSpark (https://github.com/yahoo/TensorFlowOnSpark), BigDL (https://github.com/intel-analytics/BigDL) и Analytics Zoo (https://github.com/intel-analytics/analytics-zoo). Но они не поддерживают пока что Spark 3. BigDL и Analytics Zoo ещё вдобавок не поддерживают вычисления на GPUs (в будущем планирует).

2) Второй вариант - это добавить PySpark к коду и добавить UDFs. Но пока я не понял можно ли весь код завернуть в них.

3) У TensorFlow кажется появилась какая-то поддержка Спарка https://github.com/tensorflow/ecosystem/tree/master/spark. Пока не пробовал, но выглядит очень сырым продуктом.

4) Ещё есть Koalas со своими dataframes на Спарке. Но пока я не вижу как она может пригодится.

5) Ещё слышал про форматы PMML, PFA и ONNX. Но не знаю на сколько это актуально.

Что посоветуете в моём случае?

Проверить ТЗ , если в условиях не было что должно работать на Спарке , договорится о том что эту работу вы закрываете и начинаете новый контракт. И его пишете с нуля на Спарке.

e

Первый этап назови пилот с точностью прогноза с использованием правильных инструментов .. второй- вывод на прод с использованием быстрых. Использование результатов с первого этапа как эталон для второго

Д

Ребят, такой вопрос.

Мне нужно несколько обученных питоновских ML и DL моделей закинуть в продакшен чтобы генерировать предсказания. Сначала по запросу (типа curl -X POST ...) а в будущем и в реальном времени. Одна модель написана используя Scikit-learn и ещё несколько на TensorFlow и PyTorch. В будущем планируется планируется также брать данные из HBase и Elasticsearch.

А теперь проблема. Боссы хотят что-бы все модели работали на Спарке и готовы предоставить только спарк-кластер для моих моделей. Пытаюсь теперь понять как лучше это все задеплоить.

1) Первый вариант - это переписать ML модель с Scikit-learn на Spark ML. Что делать с DL правда не понятно. Нужно чтоб работало на GPUs. Нашёл несколько вариантов на гитхабе: elephas (https://github.com/maxpumperla/elephas), TensorFlowOnSpark (https://github.com/yahoo/TensorFlowOnSpark), BigDL (https://github.com/intel-analytics/BigDL) и Analytics Zoo (https://github.com/intel-analytics/analytics-zoo). Но они не поддерживают пока что Spark 3. BigDL и Analytics Zoo ещё вдобавок не поддерживают вычисления на GPUs (в будущем планирует).

2) Второй вариант - это добавить PySpark к коду и добавить UDFs. Но пока я не понял можно ли весь код завернуть в них.

3) У TensorFlow кажется появилась какая-то поддержка Спарка https://github.com/tensorflow/ecosystem/tree/master/spark. Пока не пробовал, но выглядит очень сырым продуктом.

4) Ещё есть Koalas со своими dataframes на Спарке. Но пока я не вижу как она может пригодится.

5) Ещё слышал про форматы PMML, PFA и ONNX. Но не знаю на сколько это актуально.

Что посоветуете в моём случае?

Мне нужно несколько обученных питоновских ML и DL моделей закинуть в продакшен чтобы генерировать предсказания. Сначала по запросу (типа curl -X POST ...) а в будущем и в реальном времени. Одна модель написана используя Scikit-learn и ещё несколько на TensorFlow и PyTorch. В будущем планируется планируется также брать данные из HBase и Elasticsearch.

А теперь проблема. Боссы хотят что-бы все модели работали на Спарке и готовы предоставить только спарк-кластер для моих моделей. Пытаюсь теперь понять как лучше это все задеплоить.

1) Первый вариант - это переписать ML модель с Scikit-learn на Spark ML. Что делать с DL правда не понятно. Нужно чтоб работало на GPUs. Нашёл несколько вариантов на гитхабе: elephas (https://github.com/maxpumperla/elephas), TensorFlowOnSpark (https://github.com/yahoo/TensorFlowOnSpark), BigDL (https://github.com/intel-analytics/BigDL) и Analytics Zoo (https://github.com/intel-analytics/analytics-zoo). Но они не поддерживают пока что Spark 3. BigDL и Analytics Zoo ещё вдобавок не поддерживают вычисления на GPUs (в будущем планирует).

2) Второй вариант - это добавить PySpark к коду и добавить UDFs. Но пока я не понял можно ли весь код завернуть в них.

3) У TensorFlow кажется появилась какая-то поддержка Спарка https://github.com/tensorflow/ecosystem/tree/master/spark. Пока не пробовал, но выглядит очень сырым продуктом.

4) Ещё есть Koalas со своими dataframes на Спарке. Но пока я не вижу как она может пригодится.

5) Ещё слышал про форматы PMML, PFA и ONNX. Но не знаю на сколько это актуально.

Что посоветуете в моём случае?

Пишешь на пайспарке, на все узлы кластера спарк ставишь необходимые библиотеки. Немного прийдется поизвращатся. Но работать будет. Можно даже расспаралелить обучение.

VS

Либо можно завернуть в virtualenv и забрасывать его на спарк-кластер

VS

Видел, у нас DS так делают периодически, тупо в зипку пакуют и пробрасывают

NN

Либо можно завернуть в virtualenv и забрасывать его на спарк-кластер

+, удобна

Д

Да, можно зипку сделать при спарк сабмит.

VS

Только питон и еще пару специфичных либ закинуть надо на кластер

DZ

+, удобна

Если без бинарных зависимостей

AS

Ребят, такой вопрос.

Мне нужно несколько обученных питоновских ML и DL моделей закинуть в продакшен чтобы генерировать предсказания. Сначала по запросу (типа curl -X POST ...) а в будущем и в реальном времени. Одна модель написана используя Scikit-learn и ещё несколько на TensorFlow и PyTorch. В будущем планируется планируется также брать данные из HBase и Elasticsearch.

А теперь проблема. Боссы хотят что-бы все модели работали на Спарке и готовы предоставить только спарк-кластер для моих моделей. Пытаюсь теперь понять как лучше это все задеплоить.

1) Первый вариант - это переписать ML модель с Scikit-learn на Spark ML. Что делать с DL правда не понятно. Нужно чтоб работало на GPUs. Нашёл несколько вариантов на гитхабе: elephas (https://github.com/maxpumperla/elephas), TensorFlowOnSpark (https://github.com/yahoo/TensorFlowOnSpark), BigDL (https://github.com/intel-analytics/BigDL) и Analytics Zoo (https://github.com/intel-analytics/analytics-zoo). Но они не поддерживают пока что Spark 3. BigDL и Analytics Zoo ещё вдобавок не поддерживают вычисления на GPUs (в будущем планирует).

2) Второй вариант - это добавить PySpark к коду и добавить UDFs. Но пока я не понял можно ли весь код завернуть в них.

3) У TensorFlow кажется появилась какая-то поддержка Спарка https://github.com/tensorflow/ecosystem/tree/master/spark. Пока не пробовал, но выглядит очень сырым продуктом.

4) Ещё есть Koalas со своими dataframes на Спарке. Но пока я не вижу как она может пригодится.

5) Ещё слышал про форматы PMML, PFA и ONNX. Но не знаю на сколько это актуально.

Что посоветуете в моём случае?

Мне нужно несколько обученных питоновских ML и DL моделей закинуть в продакшен чтобы генерировать предсказания. Сначала по запросу (типа curl -X POST ...) а в будущем и в реальном времени. Одна модель написана используя Scikit-learn и ещё несколько на TensorFlow и PyTorch. В будущем планируется планируется также брать данные из HBase и Elasticsearch.

А теперь проблема. Боссы хотят что-бы все модели работали на Спарке и готовы предоставить только спарк-кластер для моих моделей. Пытаюсь теперь понять как лучше это все задеплоить.

1) Первый вариант - это переписать ML модель с Scikit-learn на Spark ML. Что делать с DL правда не понятно. Нужно чтоб работало на GPUs. Нашёл несколько вариантов на гитхабе: elephas (https://github.com/maxpumperla/elephas), TensorFlowOnSpark (https://github.com/yahoo/TensorFlowOnSpark), BigDL (https://github.com/intel-analytics/BigDL) и Analytics Zoo (https://github.com/intel-analytics/analytics-zoo). Но они не поддерживают пока что Spark 3. BigDL и Analytics Zoo ещё вдобавок не поддерживают вычисления на GPUs (в будущем планирует).

2) Второй вариант - это добавить PySpark к коду и добавить UDFs. Но пока я не понял можно ли весь код завернуть в них.

3) У TensorFlow кажется появилась какая-то поддержка Спарка https://github.com/tensorflow/ecosystem/tree/master/spark. Пока не пробовал, но выглядит очень сырым продуктом.

4) Ещё есть Koalas со своими dataframes на Спарке. Но пока я не вижу как она может пригодится.

5) Ещё слышал про форматы PMML, PFA и ONNX. Но не знаю на сколько это актуально.

Что посоветуете в моём случае?

Я использую вариант через udf

SK

Привет 👋

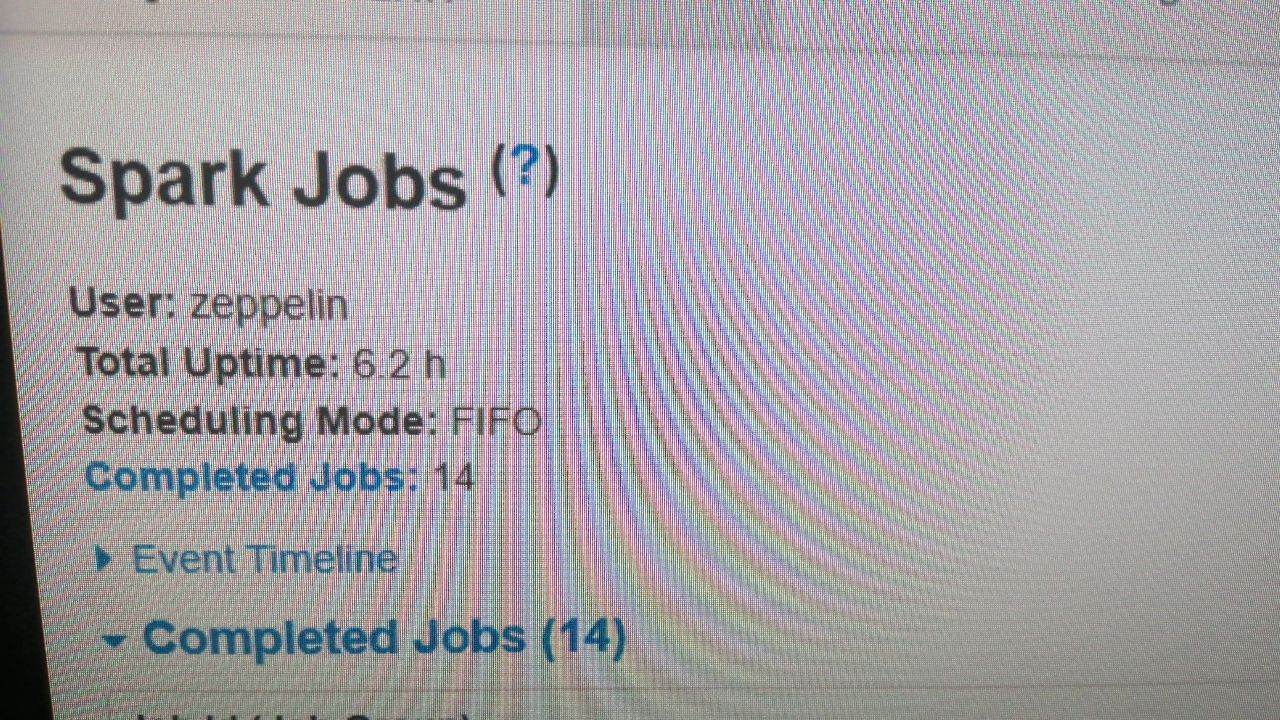

Я переключился на Faire Sheduler, а всё равно в спарке FIFO. Что не так?

Я переключился на Faire Sheduler, а всё равно в спарке FIFO. Что не так?

SK

yarn перегружал после того как включил в yarn-site.xml данный режим.

DT

это же разные планировщики

DT

в ярне и спарке