SK

Size: a a a

2020 December 15

есть еще отличная документация от Arenadata, какая была переведена на русский чтобы мочь быть использованной в чтении

Arenadata - я так понимаю лучшее?

AZ

только чтобы кластер локально гонять?

Ну кластер Терадаты, кластер Кафки, кубер, набегает..

N

А для моей задачи Fair Sheduler лучше?

чтобы понять, что для тебя лучше-нужно про каждый понимать, что он из себя представляет. это как спросить-анальгин мне поможет? ну от головы да, от рака-нет.

N

Arenadata - я так понимаю лучшее?

если не читаешь по английски-то единственная. а так вот тут читай

https://hadoop.apache.org/docs/current/hadoop-yarn/hadoop-yarn-site/FairScheduler.html

https://hadoop.apache.org/docs/current/hadoop-yarn/hadoop-yarn-site/FairScheduler.html

SK

Да у меня пока по простому всё. 2.7.7 hadoop и Zeppelin.

Только сейчас стали задачи появляться, что можно улучшить и как. У меня в команде спецов нет. Есть удалённо хороший спец, но там в мыле от задач.

Только сейчас стали задачи появляться, что можно улучшить и как. У меня в команде спецов нет. Есть удалённо хороший спец, но там в мыле от задач.

SK

А история логов растёт 🌿 и запросы как резиновые растягиваются на год иногда...

ME

А для моей задачи Fair Sheduler лучше?

у самого похожая проблема, пока ещё ничего не менял в конфигах

SK

Ещё подзадача - оптимизировать конфигурацию hadoop.

🦾 А есть варианты, которые отличаются в лучшую сторону от того, что по умолчанию?

🦾 А есть варианты, которые отличаются в лучшую сторону от того, что по умолчанию?

SK

у самого похожая проблема, пока ещё ничего не менял в конфигах

Вот буду изучать - придётся менять.

AZ

Ещё подзадача - оптимизировать конфигурацию hadoop.

🦾 А есть варианты, которые отличаются в лучшую сторону от того, что по умолчанию?

🦾 А есть варианты, которые отличаются в лучшую сторону от того, что по умолчанию?

надо начать с того что смотреть на утилизацию (как со стороны YARN что вы уже делаете, так и на самих узлах в каком-нибудь прометее), понять сколько каким пользователям нужно...

AZ

но вообще, судя по вашему текущему кластеру, мб вернуться к архитектурному вопросу и отказаться от хадупа, если данных сейчас немного и они особенно расти не будут.. управлять данными просто в одном гордом постгресе будет гораздо проще, инструментов больше..

SK

Данных дофигищщааа просто.. Вот в этом как раз и суть. А все запросы все делают под одним пользователем.

SK

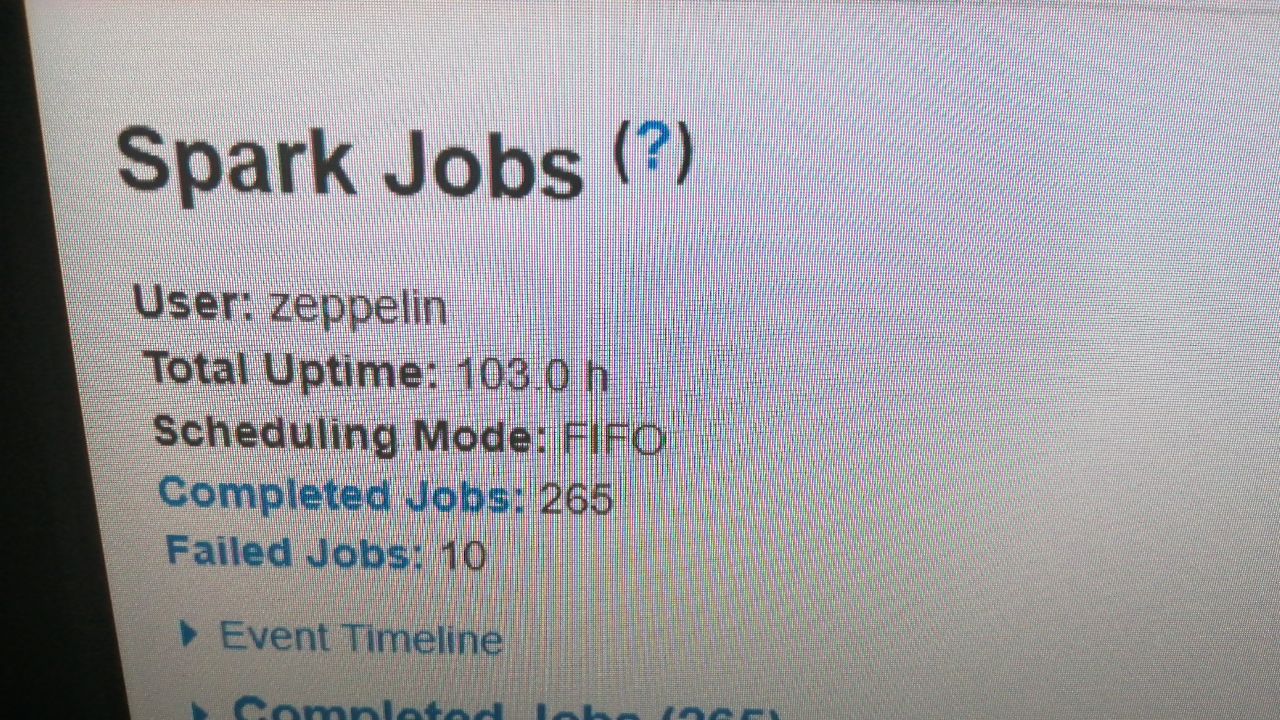

Fifo

AZ

а сколько это, "дофигищщааа"?

SK

Поменял в yarn-site.xml на Fire, перезапустил hadoop

SK

а сколько это, "дофигищщааа"?

На каждой ноде почти по 10Tb

AZ

На каждой ноде почти по 10Tb

70 ТБ? это не так много

SK

Но это за несколько лет

e

360*70*N ? )