AT

Size: a a a

2020 November 03

ну если данных немного, может и классические решения сгодятся? GP там и все такое. я себе плохо представляю сочетание спарк и < 2s

я тоже плохо представляю, но в меня бросили вот этой линкой - говорят все может )) https://www.youtube.com/watch?v=nAX53vQy9AQ

AT

надо проверять будет

AS

Al T

Коллеги, поделитесь пожалуйста своим опытом/мнением что выбрать по таким вводным данным: несколько датасетов ( a few millions each, but can grow up to 50mln, в датасете 50-60 полей в среднем) необходимо слайсить-и-дайсить (фильтр+группировка+лимит) с временем ответа до 2х секунд, нагрузка в пике может быть до 50TPS. Необходима UDF, поэтому не хочет эластик. Есть мнение что Livy+Spark с закешированным датафреймом могут быть решением, но я что-то как-то не уверен насчет 50TPS с кучей разных queries которые во время выполнения тоже будут память есть для группировки например...

а как расшифоровывается TPS?

AT

transactions per second

N

как сериализатор означает что вся работа идет через него, он вроде числа хранит в другом виде?

глобально необязательно. код открыт-берите декодировщики и используйте. я на скалу часть переписал для спарк udf.

AT

количество запросов в секунду в данном контексте

AS

тогда действительно, а почему не какой-нибудь постгре?

AT

рассматриваю такой вариант да...

AT

а 50млн датасет без индекса с группировкой будет меньше 2сек?

AT

можно попробовать конечно на high-cardinality columns все равно повесить индексы чтобы он некоторые queries отрабатывал

AS

я бы индексы вешал бы конечно

N

они будут замедлять вставку.

АА

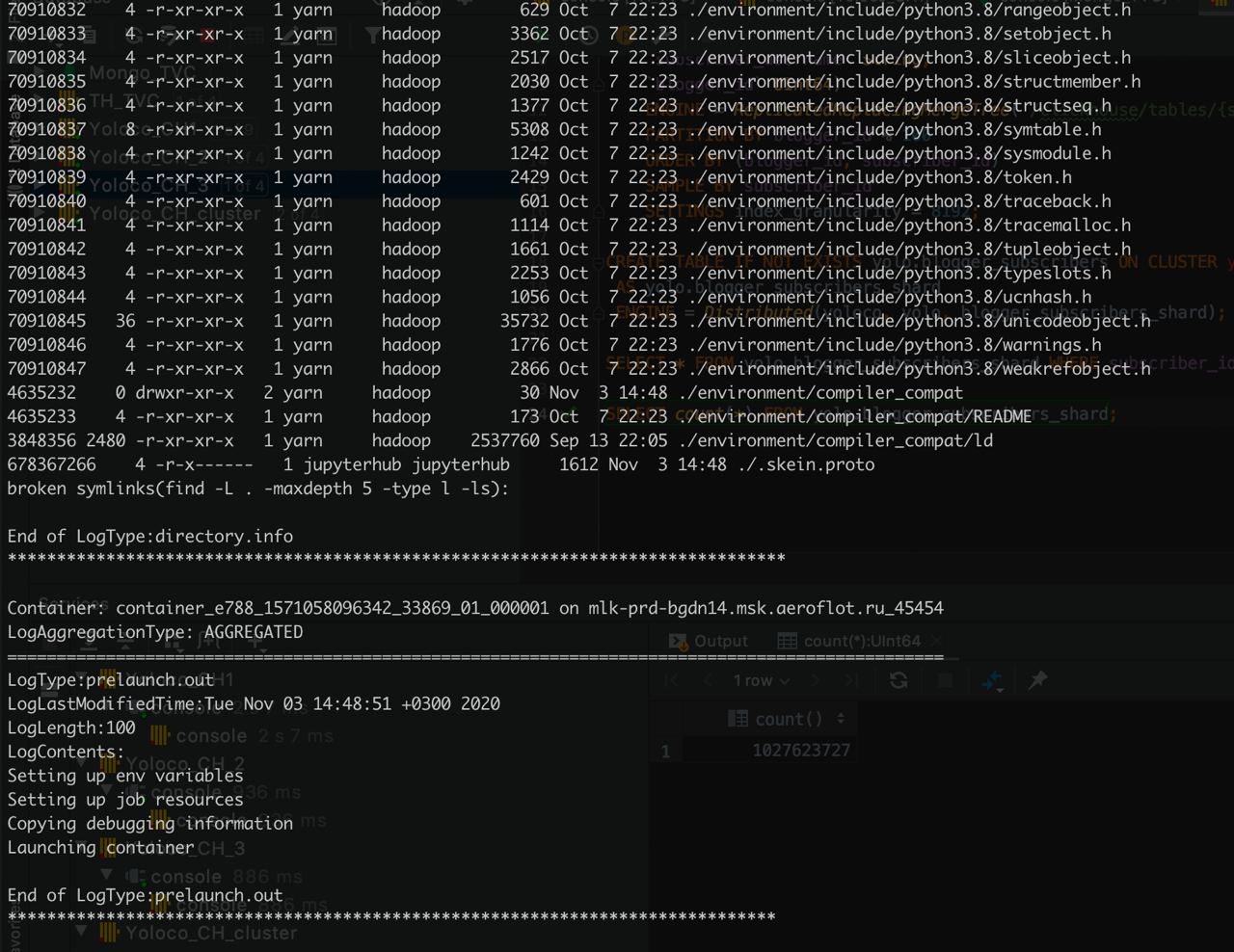

кто-то сталкивался при старте jupyterhub?

АА

Переслано от Алексей Артамонов...

а когда на другой ноде стартует, вообще не понимаю что просиходит

АА

смотрю лог апликейшена

АА

стартует и падает

AZ

Al T

Коллеги, поделитесь пожалуйста своим опытом/мнением что выбрать по таким вводным данным: несколько датасетов ( a few millions each, but can grow up to 50mln, в датасете 50-60 полей в среднем) необходимо слайсить-и-дайсить (фильтр+группировка+лимит) с временем ответа до 2х секунд, нагрузка в пике может быть до 50TPS. Необходима UDF, поэтому не хочет эластик. Есть мнение что Livy+Spark с закешированным датафреймом могут быть решением, но я что-то как-то не уверен насчет 50TPS с кучей разных queries которые во время выполнения тоже будут память есть для группировки например...

Greenplum? Ну или старшие товарищи ;)

AT

а кто постарше будет? ))

AT

я с гринплам не работал - он может быстро-быстро?

AT

типа вот например пивот табличка и ее по всякому в рилтайме обновлять