AE

Size: a a a

2020 November 02

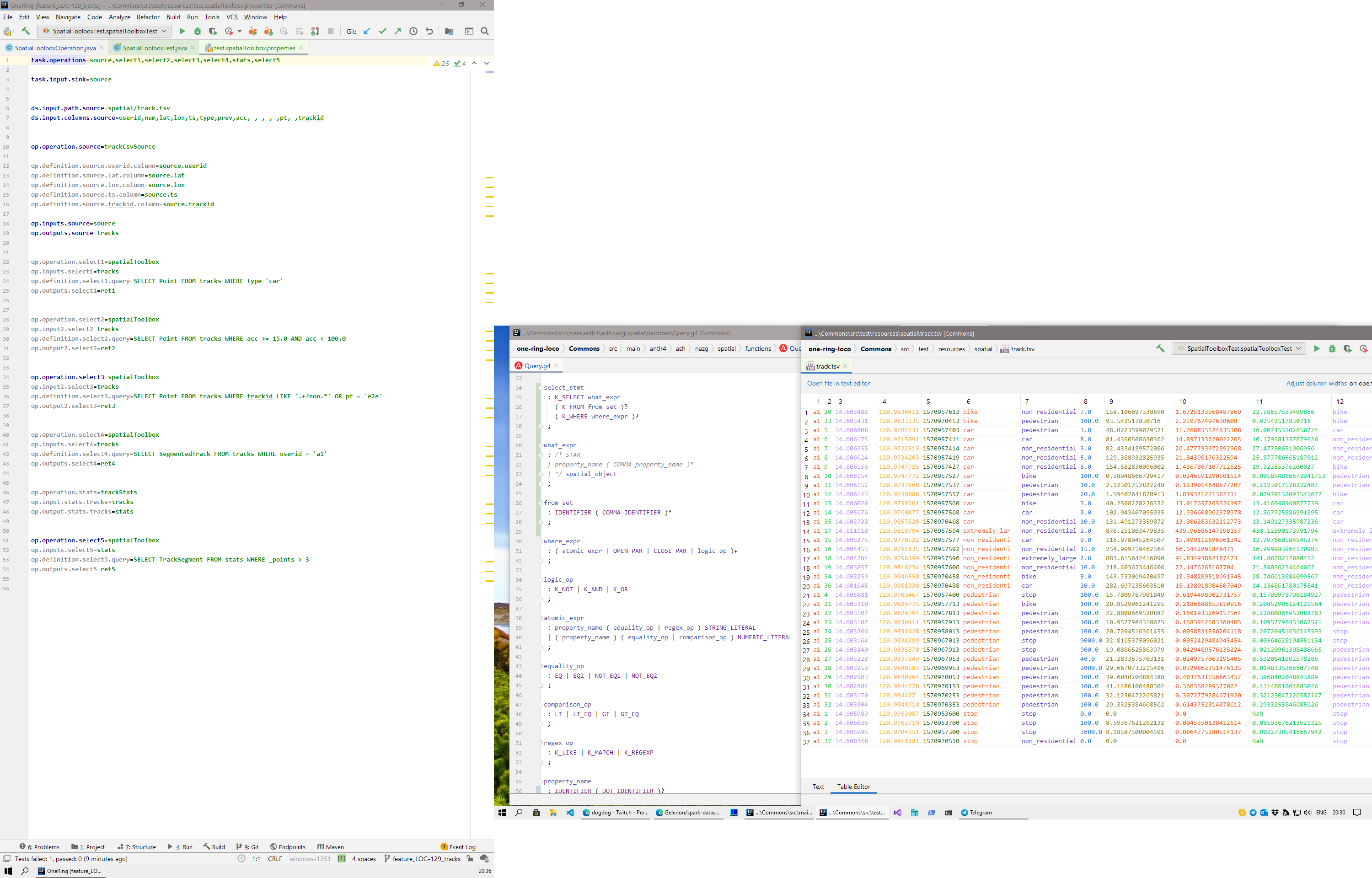

вот как-то так оно получается. как отлажу в приватном форке, выложу у себя на гитхабе. может кто из присутствующих хоть поржёт. знатный велописедищще

AE

АА

@dartov не подскажешь? я на всех воркер нодах поставил jupyterhub-yarnspawner, jupyterhub, notebook. Добавил в yarn-site.yml следующие строки:

на каждой дата ноде после изменений конфига сделал hadoop-daemon.sh stop/start datanode

в итоге:

запускаю под пользователем jupyterhub -f /pat/to/config

получаю ошибку:

как на скрине

<property>

<name>hadoop.proxyuser.jupyterhub.hosts</name>

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.jupyterhub.groups</name>

<value>*</value>

</property>

на каждой дата ноде после изменений конфига сделал hadoop-daemon.sh stop/start datanode

в итоге:

запускаю под пользователем jupyterhub -f /pat/to/config

получаю ошибку:

как на скрине

2020 November 03

AT

Коллеги, поделитесь пожалуйста своим опытом/мнением что выбрать по таким вводным данным: несколько датасетов ( a few millions each, but can grow up to 50mln, в датасете 50-60 полей в среднем) необходимо слайсить-и-дайсить (фильтр+группировка+лимит) с временем ответа до 2х секунд, нагрузка в пике может быть до 50TPS. Необходима UDF, поэтому не хочет эластик. Есть мнение что Livy+Spark с закешированным датафреймом могут быть решением, но я что-то как-то не уверен насчет 50TPS с кучей разных queries которые во время выполнения тоже будут память есть для группировки например...

AT

мой любимый кликхаус тоже скорее всего не подойдет так как апдейты будут необходимы довольно часто и они такие что не покроют кейсы aggregate/replacing merge trees..

G

А почему бы не исползовать HBase

AS

А почему бы не исползовать HBase

а как на каждое поле где будет фильтрация делать индекс?

G

Если не ошибаюсь - Phoenix позволяет вторичное инлексирование.

AS

тогда уж скорее кассандра с ее новыми индексами

s

Al T

мой любимый кликхаус тоже скорее всего не подойдет так как апдейты будут необходимы довольно часто и они такие что не покроют кейсы aggregate/replacing merge trees..

можно еще попробовать CH с MEMORY ENGINE, скорость обработки отличная

AT

спасибо, поля по группировке и фильтрации совершенно произвольные... видимо как ни крути лучше чем columnar storage и максимально быстрые фулсканы не найти

N

Если не ошибаюсь - Phoenix позволяет вторичное инлексирование.

и при этом не гарантирует консистентность данных.

G

и при этом не гарантирует консистентность данных.

Почему?

N

Ну так сделали его.

AS

и при этом не гарантирует консистентность данных.

умеют же люди, из hbase сделать такое

N

Al T

мой любимый кликхаус тоже скорее всего не подойдет так как апдейты будут необходимы довольно часто и они такие что не покроют кейсы aggregate/replacing merge trees..

ну можно копить апдейты. и как-то пакетно их накатывать иногда.

AT

да я вот тож думаю о том чтобы например целиком перезаписывать датасеты периодически как накопятся апдейты, там не так уж много миллионов-то

N

умеют же люди, из hbase сделать такое

ну не надо его за субд принимать. как сериализатор и sql транслятор вполне себе канает.

N

Al T

да я вот тож думаю о том чтобы например целиком перезаписывать датасеты периодически как накопятся апдейты, там не так уж много миллионов-то

ну если данных немного, может и классические решения сгодятся? GP там и все такое. я себе плохо представляю сочетание спарк и < 2s

AS

ну не надо его за субд принимать. как сериализатор и sql транслятор вполне себе канает.

как сериализатор означает что вся работа идет через него, он вроде числа хранит в другом виде?