T

Size: a a a

2020 September 22

сами квоты-то выкручены конечно, я про фичу резерва квоты под операция, таг или скажем роль

Там были не квоты а флаги для jvm

T

так как глю не давал прокидывать флаги и у нас джобы на кодогенерации падали

AT

эт прям для кого-то кроме нетфликса и US gov работало?

это работает в большистве случаев - наверно не так как если бы был нетфликс, но чем больше клиентов хотят фичу тем больше шансов что она появится быстрее... это конечно не так чтобы все фичи делаются прям как кто захочет...

AZ

Al T

это работает в большистве случаев - наверно не так как если бы был нетфликс, но чем больше клиентов хотят фичу тем больше шансов что она появится быстрее... это конечно не так чтобы все фичи делаются прям как кто захочет...

у меня есть пара багов от имени довольно крупных (в своих отраслях) компаний, которые повисели 90 дней, и пришел отлуп - не смогла

AZ

одна прям на IAM есть, там кондишены в определенной комбинации не работали

AZ

я знаю как это работает для супер-мейджор аккаунтов (сам в вендоре работаю), но амазон так велик что нужны или годы, или размер нетфликса чтобы они повернулись

AT

ну надо напоминать АМу все-таки как мне кажется, ибо если ничего не говорить то уж точно ничего не изменится ))

A

а зачем вам в bare-metal hdfs? какая такая в нем функциональность особенная, которой нет в baremetal k8s + s3-like storage?

+ к @dartov насчет схлопывания хадуп-менеджед платформ

+ к @dartov насчет схлопывания хадуп-менеджед платформ

и потом писать регулярно статьи вида

“ну вот сейчас мы точно уже почти догнали yarn и hdfs, осталось совсем чуть-чуть”

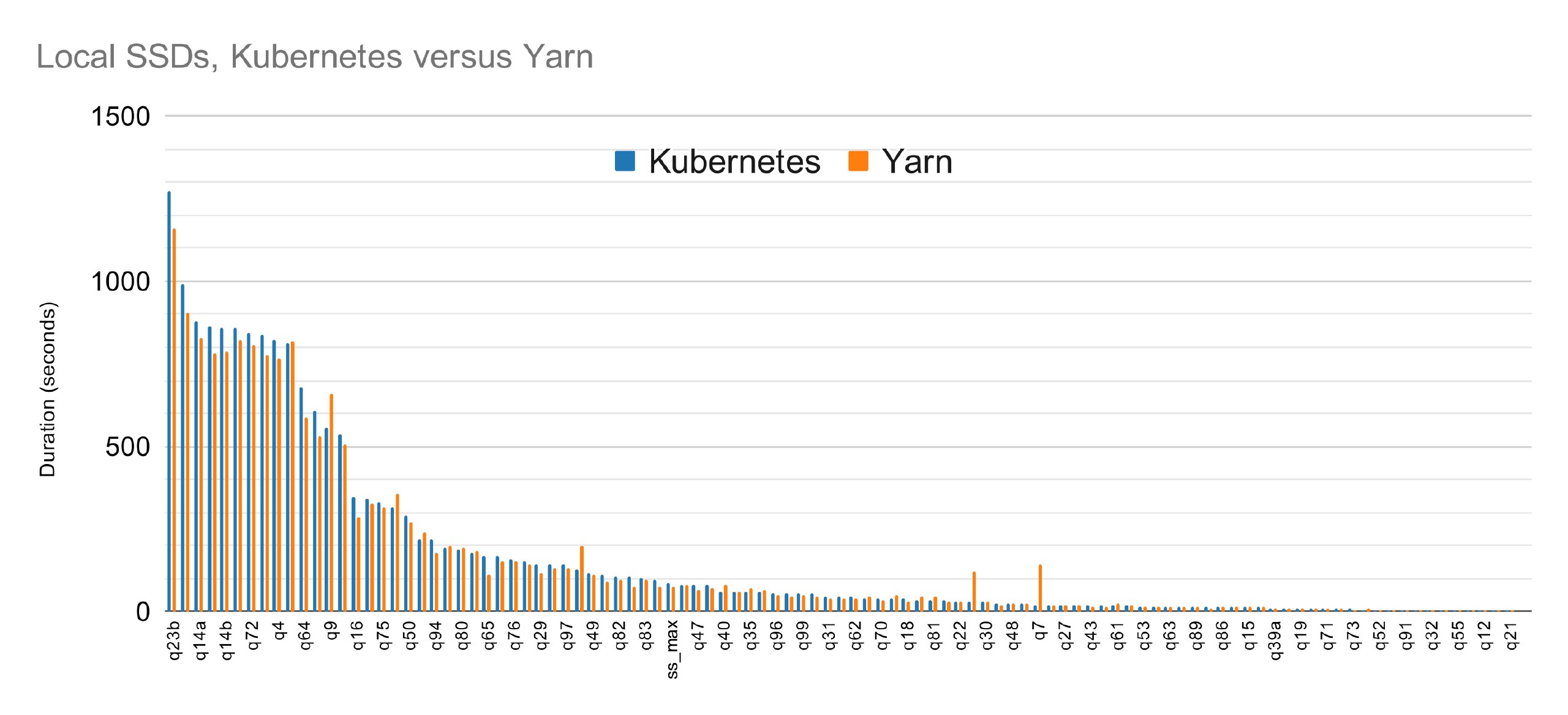

https://www.datamechanics.co/blog-post/apache-spark-performance-benchmarks-show-kubernetes-has-caught-up-with-yarn

“ну вот сейчас мы точно уже почти догнали yarn и hdfs, осталось совсем чуть-чуть”

https://www.datamechanics.co/blog-post/apache-spark-performance-benchmarks-show-kubernetes-has-caught-up-with-yarn

AZ

и потом писать регулярно статьи вида

“ну вот сейчас мы точно уже почти догнали yarn и hdfs, осталось совсем чуть-чуть”

https://www.datamechanics.co/blog-post/apache-spark-performance-benchmarks-show-kubernetes-has-caught-up-with-yarn

“ну вот сейчас мы точно уже почти догнали yarn и hdfs, осталось совсем чуть-чуть”

https://www.datamechanics.co/blog-post/apache-spark-performance-benchmarks-show-kubernetes-has-caught-up-with-yarn

так это нормальная статья: general purpose технология с большой распространенностью уже догоняет специализированную легаси технологию на кейсе родном для этой легаси технологии, ура, скоро выкинем легаси - чем плохо?

A

“скоро выкинем” и “зачем нам сейчас” это разные вещи =)

особенно если по хадуп кластеру 50к+ джобов в день гоняется на петабайтах данных

вот когда догонят и можно будет выкидывать, тогда и можно будет говорить что hdfs/yarn не нужен

пока же “всё сложно"

особенно если по хадуп кластеру 50к+ джобов в день гоняется на петабайтах данных

вот когда догонят и можно будет выкидывать, тогда и можно будет говорить что hdfs/yarn не нужен

пока же “всё сложно"

AZ

“скоро выкинем” и “зачем нам сейчас” это разные вещи =)

особенно если по хадуп кластеру 50к+ джобов в день гоняется на петабайтах данных

вот когда догонят и можно будет выкидывать, тогда и можно будет говорить что hdfs/yarn не нужен

пока же “всё сложно"

особенно если по хадуп кластеру 50к+ джобов в день гоняется на петабайтах данных

вот когда догонят и можно будет выкидывать, тогда и можно будет говорить что hdfs/yarn не нужен

пока же “всё сложно"

то есть ваш довод что есть корнер кейсы где легаси сильно лучше, и мы по ним будем судить о мейнстриме?

A

для большинства кубик в клауде за глаза

тут я согласен

тут я согласен

AS

и потом писать регулярно статьи вида

“ну вот сейчас мы точно уже почти догнали yarn и hdfs, осталось совсем чуть-чуть”

https://www.datamechanics.co/blog-post/apache-spark-performance-benchmarks-show-kubernetes-has-caught-up-with-yarn

“ну вот сейчас мы точно уже почти догнали yarn и hdfs, осталось совсем чуть-чуть”

https://www.datamechanics.co/blog-post/apache-spark-performance-benchmarks-show-kubernetes-has-caught-up-with-yarn

так они сравнивают yarn и k8, файлы то все равно в hdfs в этом тесте, вот если бы они вместо dfsчто-то s3-like тестировали, было бы интереснее

A

там не было про хдфс

вроде как в гугловом сторейдже

так как сама компания занимается предоставлением server less спарка

вроде как в гугловом сторейдже

так как сама компания занимается предоставлением server less спарка

A

что уже потеря многих фишек от даталокалити

S

и потом писать регулярно статьи вида

“ну вот сейчас мы точно уже почти догнали yarn и hdfs, осталось совсем чуть-чуть”

https://www.datamechanics.co/blog-post/apache-spark-performance-benchmarks-show-kubernetes-has-caught-up-with-yarn

“ну вот сейчас мы точно уже почти догнали yarn и hdfs, осталось совсем чуть-чуть”

https://www.datamechanics.co/blog-post/apache-spark-performance-benchmarks-show-kubernetes-has-caught-up-with-yarn

непонятный бенч. я так и не понял что с чем сравнивают. получается, сейчас куб дает забирает 5% перформанса на ровном месте что-ли

тест же на локальных ссд

тест же на локальных ссд

A

про локальные диски там было в контексте оптимизаций

что для шафла лучше использовать их, так как даёт более адекватную прозводительность

но в клауде зачастую подключаются remote, скорость которых пропорциональна размеру

поэтому или используйте локальные

или уже побольше размер для ремоут дисков запрашивайте

As we've shown, local SSDs perform the best, but here's a little configuration gotcha when running Spark on Kubernetes.

Simply defining and attaching a local disk to your Kubernetes is not enough: they will be mounted, but by default Spark will not use them. On Kubernetes, a hostPath is required to allow Spark to use a mounted disk.

то есть в случае кубика доп манипуляции с необходимы

без этого ещё больше разница будет чем 5%

что для шафла лучше использовать их, так как даёт более адекватную прозводительность

но в клауде зачастую подключаются remote, скорость которых пропорциональна размеру

поэтому или используйте локальные

или уже побольше размер для ремоут дисков запрашивайте

As we've shown, local SSDs perform the best, but here's a little configuration gotcha when running Spark on Kubernetes.

Simply defining and attaching a local disk to your Kubernetes is not enough: they will be mounted, but by default Spark will not use them. On Kubernetes, a hostPath is required to allow Spark to use a mounted disk.

то есть в случае кубика доп манипуляции с необходимы

без этого ещё больше разница будет чем 5%

A

@barloc там же линк на их сессию со спарк саммита, где более подробно рассказывают

https://databricks.com/session_na20/running-apache-spark-on-kubernetes-best-practices-and-pitfalls

хотя пару слайдов попахивают булшитом

особенно когда рассказывают про глобальную версию спарка во всём ярн кластере

https://databricks.com/session_na20/running-apache-spark-on-kubernetes-best-practices-and-pitfalls

хотя пару слайдов попахивают булшитом

особенно когда рассказывают про глобальную версию спарка во всём ярн кластере

A

по ней и писалась статья

ну или доклад готовили на основе статьи

=)

ну или доклад готовили на основе статьи

=)

AZ

что уже потеря многих фишек от даталокалити

обмен фишек даталокалити на фишки распределенного масштабируемого объектного стораджа