T

Size: a a a

2019 November 20

да, 10

A

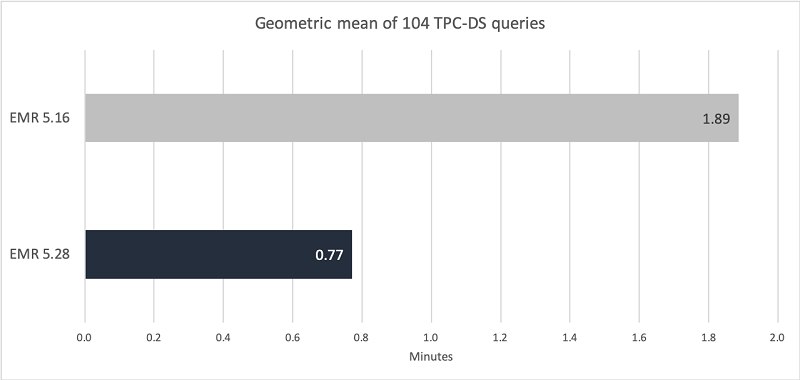

тут aws кстати не давно присылали сылку на то что они рантайм спарка улучшили https://aws.amazon.com/blogs/big-data/amazon-emr-introduces-emr-runtime-for-apache-spark/

список патчей где?

чтобы понимать чем они пожертвовали и где было настолько плохо что ускорение в 30 раз

чтобы понимать чем они пожертвовали и где было настолько плохо что ускорение в 30 раз

T

список патчей где?

чтобы понимать чем они пожертвовали и где было настолько плохо что ускорение в 30 раз

чтобы понимать чем они пожертвовали и где было настолько плохо что ускорение в 30 раз

T

ну остальную часть я думаю они не раскроют

A

Spark

Performance optimizations

Performance optimizations

A

один из лучших списков что я видел =)

AE

осталось выяснить, кто в реальной жизни на таких нодах что-то считает. обычно подешевле берут

T

осталось выяснить, кто в реальной жизни на таких нодах что-то считает. обычно подешевле берут

мы считаем

AS

проведите бенчмарк. сделайте какой-нибудь расчёт, который много читает и много пишет, и убедитесь что времени на общение с с3 тратится во много раз больше, чем на сам расчёт

вот это правильно, мы в свое время проводили такое на своей нагрузке (обычные орк файлы, запись не интенсивная, обработка батчевая) размеры десятки терабайт, s3 проигрывал процентов 20% макс, а по стоимости разница была космическая

T

мы считаем

правда ноды на спотах по этому выходит не так дорого

AE

мы считаем

ну если вы можете себе позволить дорогие ноды, то какая вам разница. вы наверняка и время на латенси имеете неограниченное.

если нет, то бенчмарк и ещё раз бенчмарк

если нет, то бенчмарк и ещё раз бенчмарк

T

один из лучших списков что я видел =)

ну ребятам надо себя както продавать 😉

M

ну если вы можете себе позволить дорогие ноды, то какая вам разница. вы наверняка и время на латенси имеете неограниченное.

если нет, то бенчмарк и ещё раз бенчмарк

если нет, то бенчмарк и ещё раз бенчмарк

Какой-то неочевидный вывод зависимости между деньгами и латенси)

AE

на моём ворклоаде с кластерами он деманд и уникальным обсчётами каждый раз дешевле копировать на хдфс, считать, писать в хдфс и копировать обратно. дешевле по времени раз этак в 30. неудобно, но ждать некогда :/

T

ну если вы можете себе позволить дорогие ноды, то какая вам разница. вы наверняка и время на латенси имеете неограниченное.

если нет, то бенчмарк и ещё раз бенчмарк

если нет, то бенчмарк и ещё раз бенчмарк

Ну да, но подробной инфы от автора вопроса мы так и не дождались. Может у них схожие условия

AE

Mikhail

Какой-то неочевидный вывод зависимости между деньгами и латенси)

у нас заказчик ждать неделю не будет, ему надо прям завтра

AS

на моём ворклоаде с кластерами он деманд и уникальным обсчётами каждый раз дешевле копировать на хдфс, считать, писать в хдфс и копировать обратно. дешевле по времени раз этак в 30. неудобно, но ждать некогда :/

а хдфс хранит данные бесплатно?

A

нет, тут именно обсуждается вопрос:

когда у вас доступ к s3 то вы ограничены скоростью сети + количеством коннектов на сам s3

когда вы скопировали данные на hdfs то высока вероятность гонять/процессить данные в data locality режиме (считайте напрямую с диском работа)

долгосрочное хранение это одно

временное хранилище для файлов которые будут прочитаны много раз это совершенно другое

когда у вас доступ к s3 то вы ограничены скоростью сети + количеством коннектов на сам s3

когда вы скопировали данные на hdfs то высока вероятность гонять/процессить данные в data locality режиме (считайте напрямую с диском работа)

долгосрочное хранение это одно

временное хранилище для файлов которые будут прочитаны много раз это совершенно другое

AE

именно

AE

а хдфс хранит данные бесплатно?

нет, но в случае он деманд кластера ебс волюмы существуют недолго. если кластер перманент, совсем другой коленкор, с3 драматически дешевле