ПП

Size: a a a

2019 December 27

Илья

Эм, это общий подход, питон, математика, sql, и классы-генераторы перекрывают значительную часть моей работы дс. Межсерверное взаимодействие очень пригодилось для микросерверной архитектуры при выходе на продакшн

А я то думал там девопсы мутят

И

У нас с этим сложнее, поэтому после прототипирования и исследований сразу продумывать по варианту реализации нужно, так то я и с докером работаю =)

2019 December 28

R

По работе много публикуют в сообществе ods.ai в слаке. Это вообще маст хев место для датасатанистов

D🐈

#правила

Здесь действует одно правило:

правило адекватного, профессионального общения, релевантного теме нашей группы.

Полезные ресурсы:

▫️Большая подборка материалов по AI & ML

▫️Список Демидовой Кати: статьи и примеры по AI и ML

▫️Книги из официального списка рекомендаций ШАДа

▫️Книги по AI и ML

▫️Список каналов и групп для программистов

Пожалуйста, не задавайте мета-вопросов в чате: https://nometa.xyz/

Вакансии здесь: @datasciencejobs

Здесь действует одно правило:

правило адекватного, профессионального общения, релевантного теме нашей группы.

Полезные ресурсы:

▫️Большая подборка материалов по AI & ML

▫️Список Демидовой Кати: статьи и примеры по AI и ML

▫️Книги из официального списка рекомендаций ШАДа

▫️Книги по AI и ML

▫️Список каналов и групп для программистов

Пожалуйста, не задавайте мета-вопросов в чате: https://nometa.xyz/

Вакансии здесь: @datasciencejobs

2019 December 29

КБ

ребят, что делать, если разбираешь пример из книги https://github.com/jakevdp/PythonDataScienceHandbook

и там нужно просто установить пакеты, но

miniconda пишет, что:

PackagesNotFoundError: The following packages are not available from current channels

Я боюсь, что если я найду альтернатинвные каналы и скачаю какие-то другие версии этих пакетов, то потом когда буду запускать примеры из книги, они сломаются и работать не будут и мне придется исправлять много ошибок..(

Что делать в этом случае ?

и там нужно просто установить пакеты, но

miniconda пишет, что:

PackagesNotFoundError: The following packages are not available from current channels

Я боюсь, что если я найду альтернатинвные каналы и скачаю какие-то другие версии этих пакетов, то потом когда буду запускать примеры из книги, они сломаются и работать не будут и мне придется исправлять много ошибок..(

Что делать в этом случае ?

U

Все нормально думают будет с альтернативными пакетами

U

Если что пофиксишь сам - опыт как никак)

КБ

AP

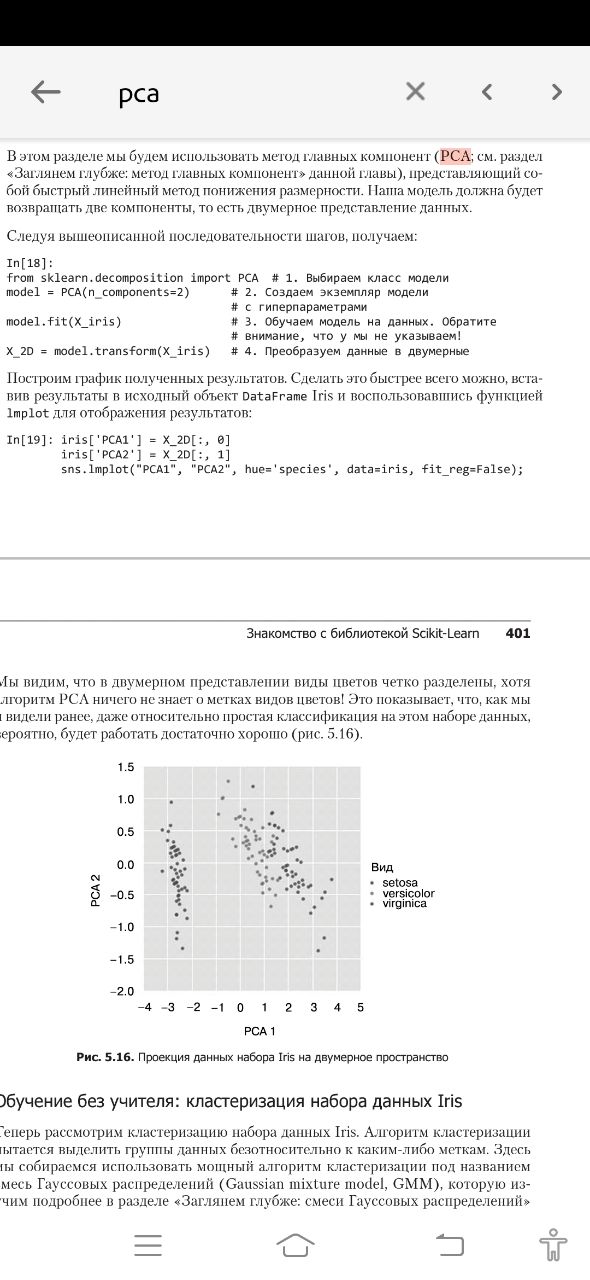

Где вы видели реальное использование PCA?

V

В гусенице

КБ

Andrey Parasich

Где вы видели реальное использование PCA?

Когда фильтрация данных

2019 December 30

GP

Andrey Parasich

Где вы видели реальное использование PCA?

например https://www.asprs.org/wp-content/uploads/pers/1987journal/dec/1987_dec_1649-1658.pdf (это просто в довесок комментам выше)

D

Message from E Y O B 火炎焱燚 deleted. Reason: new user and external link (?)

R

Че за книжка? Рашка?

AG

Че за книжка? Рашка?

2019 December 31

A

Ребят, у меня здесь NLP задача и я был бы очень благодарен если бы подсказал в каком направлении двигаться!

Есть значит у меня телефонные разговоры операторов с абонентами (речь уже преобразована в текст , и уже произведена классификация того что говорит абонент, и то что говорит оператор). Задача выявить чем абонент разочарован, чтобы при последующим звонке того же абонента, оператор выдел на экране в чём разочарование состояло.

Сейчас все реализовано следующим образом: с помощью regular expressions ведётся поиск отрицательных слов, типа "разочарован", "зол", и т.д. Далее от каждого такого слова отчитывается десять слов в право и десять в лево (пунктуации в тексте нету, поэтому нельзя просто выбрать интересуемое предложение). Получаем кусок текста который потенциально несет negative sentiment. Если в одном разговоре таких слов много, то будет создано много кусков текста. Далее используется Vader из NLTK для скоринга каждого такого куска текста. Выбирается наиболее негативный кусок и он и показывается оператору, когда этот же абонент звонит в следующий раз.

Алгоритм не идеальный по многим причинам. Основная:

Vader приписывает значительный отрицательный скор, обрывкам теста, которые по сути являются набором бессвязных слов. Понятно что Vader не особо в этом виноват, так как такое качество исходного текста. К слову, я не могу повлиять на способ преобразования звука в текст :(

Есть значит у меня телефонные разговоры операторов с абонентами (речь уже преобразована в текст , и уже произведена классификация того что говорит абонент, и то что говорит оператор). Задача выявить чем абонент разочарован, чтобы при последующим звонке того же абонента, оператор выдел на экране в чём разочарование состояло.

Сейчас все реализовано следующим образом: с помощью regular expressions ведётся поиск отрицательных слов, типа "разочарован", "зол", и т.д. Далее от каждого такого слова отчитывается десять слов в право и десять в лево (пунктуации в тексте нету, поэтому нельзя просто выбрать интересуемое предложение). Получаем кусок текста который потенциально несет negative sentiment. Если в одном разговоре таких слов много, то будет создано много кусков текста. Далее используется Vader из NLTK для скоринга каждого такого куска текста. Выбирается наиболее негативный кусок и он и показывается оператору, когда этот же абонент звонит в следующий раз.

Алгоритм не идеальный по многим причинам. Основная:

Vader приписывает значительный отрицательный скор, обрывкам теста, которые по сути являются набором бессвязных слов. Понятно что Vader не особо в этом виноват, так как такое качество исходного текста. К слову, я не могу повлиять на способ преобразования звука в текст :(

A

Какие есть идеи на сегодняшний день:

1) Попробовать другие pre-trained модели (какие порекомендуете?).

2) Попробовать отследить где начинается предложение с негативным словом и где оно заканчивается (есть ли разработанные модели для этого?).

3) Модель которая бы говорила что-то вроде "этот кусок текста мусор и его оценивать не надо, его выкидываем".

4) Topic modeling. То есть все негативные куски текста классифицировать по топикам.

5) Выкинуть этап с regular expressions.

6) Сделать тестовые данные для модели, а не использовать pre-trained модель

1) Попробовать другие pre-trained модели (какие порекомендуете?).

2) Попробовать отследить где начинается предложение с негативным словом и где оно заканчивается (есть ли разработанные модели для этого?).

3) Модель которая бы говорила что-то вроде "этот кусок текста мусор и его оценивать не надо, его выкидываем".

4) Topic modeling. То есть все негативные куски текста классифицировать по топикам.

5) Выкинуть этап с regular expressions.

6) Сделать тестовые данные для модели, а не использовать pre-trained модель

A

Если честно, то мне кажется 1) не получится реализовать адекватно.

Так как мусора в кусках текста на столько много, то реализовать 2) тоже будет проблематично.

3) - не решение проблемы на 100% и опять же вопрос как реализовывать.

4) - не знаю как реализовывать, но наверное это лучшее что можно было бы предложить. Оператор будет видеть не какой-то неструктурированный набор текста, а осмысленное словосочетание ("дорогие услуги", "неудобный сервис", и т.д.).

5) У меня сомнения на счёт этого. Regular expressions находят хотя бы негативные слова из тонны мусора, без этого мне кажется любой последующий алгоритм будет плохо работать. То что успел понять точно - выкидывание regular expressions ведёт к значительному замедлению расчётов.

6) Думаю это не повредит и например способ 4) не будет без этого работать. На это уйдут месяцы, и хорошо бы знать, что они были потрачены не зря и есть общая идея как улучшить результаты.

В общем, спасибо что дочитали до конца и я открыт к любым вашим идеям.

Так как мусора в кусках текста на столько много, то реализовать 2) тоже будет проблематично.

3) - не решение проблемы на 100% и опять же вопрос как реализовывать.

4) - не знаю как реализовывать, но наверное это лучшее что можно было бы предложить. Оператор будет видеть не какой-то неструктурированный набор текста, а осмысленное словосочетание ("дорогие услуги", "неудобный сервис", и т.д.).

5) У меня сомнения на счёт этого. Regular expressions находят хотя бы негативные слова из тонны мусора, без этого мне кажется любой последующий алгоритм будет плохо работать. То что успел понять точно - выкидывание regular expressions ведёт к значительному замедлению расчётов.

6) Думаю это не повредит и например способ 4) не будет без этого работать. На это уйдут месяцы, и хорошо бы знать, что они были потрачены не зря и есть общая идея как улучшить результаты.

В общем, спасибо что дочитали до конца и я открыт к любым вашим идеям.