DP

Size: a a a

2020 September 11

А как же гугловский и яндексовский переводчики работают?

так же

DP

и такой же шанс ошибки

RK

Нормально они переводят! Вряд ли там высок процент ошибки

DP

ну, спроси любого человека который знает 2 языка посмотреть 10 предложений переведенных гуглопереводом

DP

неточности будут. и в твоем случае (написать документацию языка) их можно считать ошибками.

RK

то о чем ты думаешь (символьные системы) перестали развиваться после 1990

Почему это я о символьных системах? Я считал что я о семантических. Анализ то я предполагаю не по буквам, а по блокам, словам.

DP

Почему это я о символьных системах? Я считал что я о семантических. Анализ то я предполагаю не по буквам, а по блокам, словам.

это все еще символы

RK

Может это просто я невнятно объясняю чего я хочу?

DP

методы в которых ты думаешь, то как ты описываешь ии, намекают что ты в этот момент думаешь о символьных системах (когда ИИ по твоему считает "так, это существительное, это прилагательное к нему ...")

DP

а нейронки гугла, GPT и все прочее сегодня - не работает на символьных системах. там нет нигде четкого разделения на существительные и прилагательные (наверное?), просто куча весов нейронки. все данные "грязные", и с высоким шансом ошибки.

этот метод называют коннективизмом (веса, соединения нейронов)

этот метод называют коннективизмом (веса, соединения нейронов)

RK

такое ощущение что сказанное означает что если нейронки использовать для анализа программного кода, то они выявят все конструкции языка. А вот если нейронку применить к описанию языка, то она не сможет выделить конструкции языка.

DP

такое ощущение что сказанное означает что если нейронки использовать для анализа программного кода, то они выявят все конструкции языка. А вот если нейронку применить к описанию языка, то она не сможет выделить конструкции языка.

потому что программного кода можно собрать 100гб

а описания языка всего 100кб

а описания языка всего 100кб

DP

нейронки требуют очень много данных чтобы уменьшить шанс ошибки (т.е. чтобы они начали выдавать что-то полезное хотя бы иногда)

RK

Но в моём случае я же дам нейронке взамен более четкое описание чем различаются в тексте конструкции языка

DP

Но в моём случае я же дам нейронке взамен более четкое описание чем различаются в тексте конструкции языка

нейронке пофиг, насколько я знаю. Она не может быстро обучаться, даже на хороших данных

символьные системы могут. но они почти не развивались последнее время. и я о них не знаю

символьные системы могут. но они почти не развивались последнее время. и я о них не знаю

RK

Однако, спасибо за помощь :) Буду думать и дальше копать.

2020 September 12

/

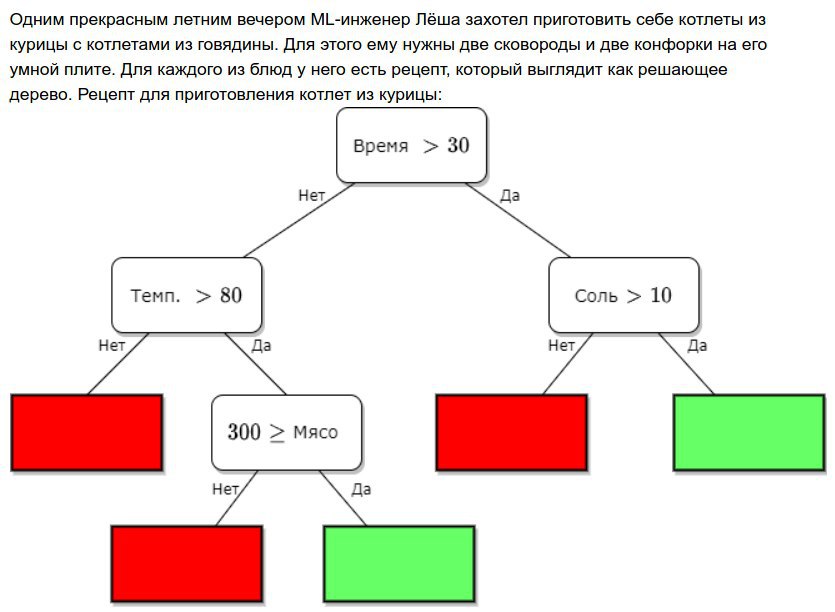

Вы всегда так готовите?)

2020 September 13

NL

Любопытный способ...

DD

Уточняю. Мне нужно, чтобы программа перебрала все команды языка программирования и произвела семантический анализ языка, поместив результат в базу данных. Входные данные как я здесь полагаю - список команд языка или просто текст, содержащий описание всех команд и параметров языка.

Не знаю, нужны ли тебе именно нейронки, но возможно, задача, которую ты решаешь, называется

Грамматика - это довольно удобный инструмент формального описания языков, похожий на то, что ты хочешь получить.

А

automatic grammar induction, и по этой фразе можно гуглить статьи и алгоритмы. Грамматика - это довольно удобный инструмент формального описания языков, похожий на то, что ты хочешь получить.

А

grammar induction - это построение грамматик по корпусам текстов. Я не видел статей, в которых это удавалось сделать прям хорошо для естественных языков - слишком уж они разнообразны. Но, возможно, как раз для языков программирования этот подход окажется в самый раз. Тем более что синтаксис многих из них как раз грамматиками описывают и парсят. Вот, например, грамматика языка Python.RK

А инструмент есть, чем анализировать?