Size: a a a

2020 June 06

2020 August 09

BUSTLE: Bottom-up program-Synthesis Through Learning-guided Exploration

https://arxiv.org/pdf/2007.14381v1.pdf

🍭️️️ В чем понт

Человечество давно находится в поисках универсального джина-программиста, которому можно показать ртуть и золото и попросить выработать универсальный способ получать из первого второе, не вникая в детали реализации. Исследователи из Google Brain предложили новый способ генерировать программы по набору входов и выходов. Основная идея — последовательно искать подпрограммы, приводящие к валидным промежуточным результатам. Способ превосходит предыдущие решения.

💻 Подробности

🏋️️ Алгоритм

Генерировать программы нужно итеративно — наша задача постепенно получать небольшие подпрограммы, из промежуточных результатов которых строить следующие подпрограммы, и так далее до финального результата. В самом простом и невозможно долгом варианте мы перебираем все комбинации подпрограмм. Однако, хочется отранжировать промежуточные результаты по вероятности того, что они входят в финальную истинную программу. Итак, наша задача — по паре вход-выход и паре промежуточное значение-выход давать оценку на вероятность того, что взятое промежуточное значение — это часть итогового решения задачи.

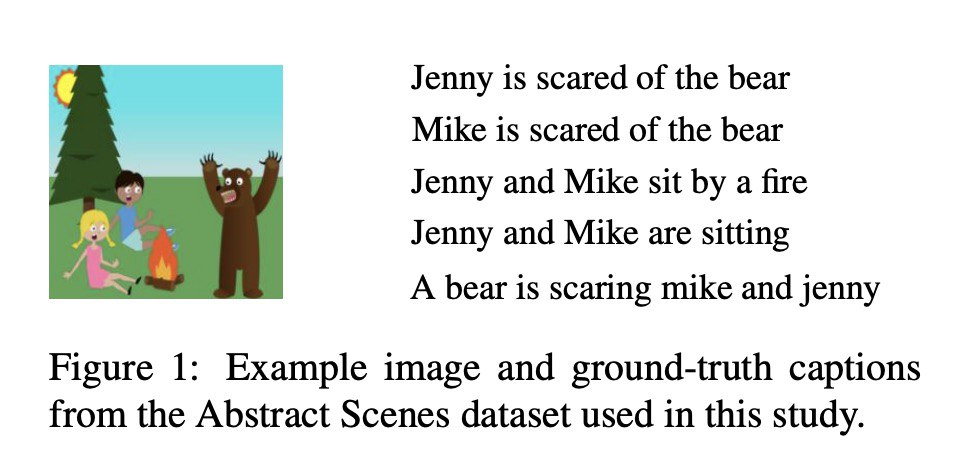

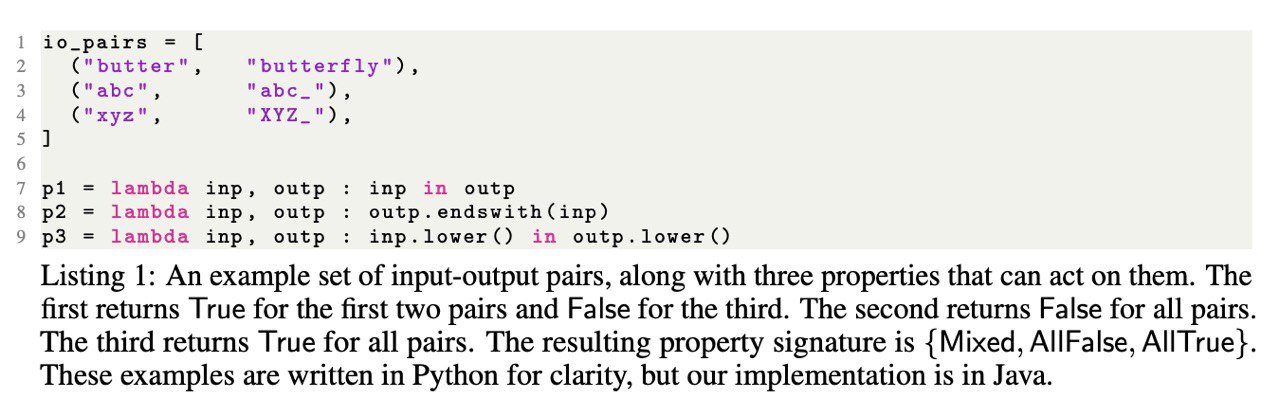

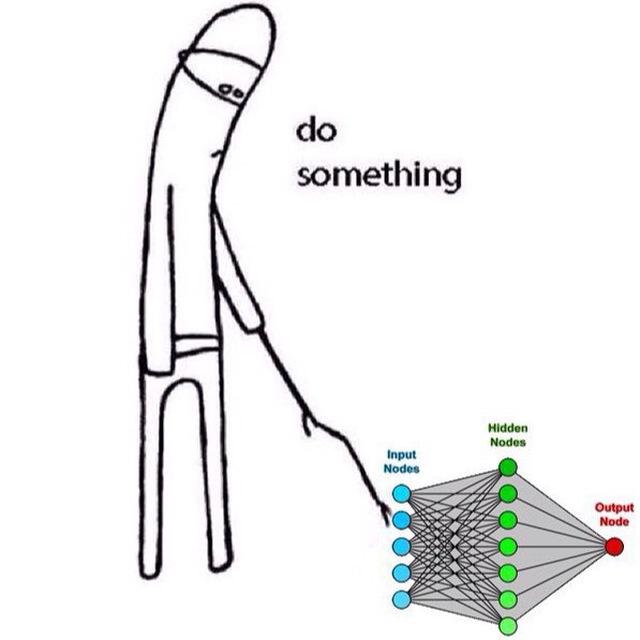

Сначала определим набор преобразований над входами и выходами. Пример команд — взять строку, прибавить число, перемножить переменные, обьединить результат других операций с помощью оператора ”ИЛИ”. Затем из этих команд предлагается составить свойства — набор-комбинацию команд, которые берут на вход набор входов и выходов и выдают значения True или False. Пример свойств можно найти на картинке под постом.

Далее для всех промежуточных результатов-выходов и свойств мы выписываем вектор истинности свойства для пары. Аналогично делаем для пары вход-выход и всех заданных свойств. Соединяем эти вектора, получаем единые вектор значений True-False. Обучаем модель по этому вектору предсказывать, принадлежит ли промежуточное решение истинной программе. Таким образом, мы нашли способ по паре вход-выход и паре промежуточное значение-выход оценивать вероятность того, что взятое промежуточное значение — это часть итогового решения задачи. Это позволит нам качественно улучшить перебор.

🔎 Эксперименты

Авторы сравнивали число операций и время, которое надо затратить для успешной генерации программ с помощью разных способов ранжирования промежуточных результатов. Один из способов — алгоритм машинного обучения, другой — эвристики, написанные человеком, еще один — эвристическое ранжирование промежуточных результатов по длине программы, в результате исполнения которой они получены. Сравнение производилось на написанном людьми датасете из программ. Например, для успешной генерации 70% программ из датасета способу с алгоритмом машинного обучения потребовалось в 10 раз меньше времени, чем алгоритмам с эвристиками, а 100% успешных генераций программ с помощью эвристического перебора за сколь нибудь разумное время достичь не представляется возможным.

🧐 Что в итоге

Авторы интересным образом скрестили алгоритмический перебор с машинным обучением, значительно ускорив и качественно улучшив финальный алгоритм. Также при ранжировании кандидатов учитывается контекст и семантические свойства прошлых подпрограмм. Такой способ напоминает декомпозицию задачи и дальнейшее копирование подпрограмм со StackOverflow программистом) Надеемся, что и дальше будут появляться такие же интересные и успешные примеры соединения ML с алгоритмами поиска.

https://arxiv.org/pdf/2007.14381v1.pdf

🍭️️️ В чем понт

Человечество давно находится в поисках универсального джина-программиста, которому можно показать ртуть и золото и попросить выработать универсальный способ получать из первого второе, не вникая в детали реализации. Исследователи из Google Brain предложили новый способ генерировать программы по набору входов и выходов. Основная идея — последовательно искать подпрограммы, приводящие к валидным промежуточным результатам. Способ превосходит предыдущие решения.

💻 Подробности

🏋️️ Алгоритм

Генерировать программы нужно итеративно — наша задача постепенно получать небольшие подпрограммы, из промежуточных результатов которых строить следующие подпрограммы, и так далее до финального результата. В самом простом и невозможно долгом варианте мы перебираем все комбинации подпрограмм. Однако, хочется отранжировать промежуточные результаты по вероятности того, что они входят в финальную истинную программу. Итак, наша задача — по паре вход-выход и паре промежуточное значение-выход давать оценку на вероятность того, что взятое промежуточное значение — это часть итогового решения задачи.

Сначала определим набор преобразований над входами и выходами. Пример команд — взять строку, прибавить число, перемножить переменные, обьединить результат других операций с помощью оператора ”ИЛИ”. Затем из этих команд предлагается составить свойства — набор-комбинацию команд, которые берут на вход набор входов и выходов и выдают значения True или False. Пример свойств можно найти на картинке под постом.

Далее для всех промежуточных результатов-выходов и свойств мы выписываем вектор истинности свойства для пары. Аналогично делаем для пары вход-выход и всех заданных свойств. Соединяем эти вектора, получаем единые вектор значений True-False. Обучаем модель по этому вектору предсказывать, принадлежит ли промежуточное решение истинной программе. Таким образом, мы нашли способ по паре вход-выход и паре промежуточное значение-выход оценивать вероятность того, что взятое промежуточное значение — это часть итогового решения задачи. Это позволит нам качественно улучшить перебор.

🔎 Эксперименты

Авторы сравнивали число операций и время, которое надо затратить для успешной генерации программ с помощью разных способов ранжирования промежуточных результатов. Один из способов — алгоритм машинного обучения, другой — эвристики, написанные человеком, еще один — эвристическое ранжирование промежуточных результатов по длине программы, в результате исполнения которой они получены. Сравнение производилось на написанном людьми датасете из программ. Например, для успешной генерации 70% программ из датасета способу с алгоритмом машинного обучения потребовалось в 10 раз меньше времени, чем алгоритмам с эвристиками, а 100% успешных генераций программ с помощью эвристического перебора за сколь нибудь разумное время достичь не представляется возможным.

🧐 Что в итоге

Авторы интересным образом скрестили алгоритмический перебор с машинным обучением, значительно ускорив и качественно улучшив финальный алгоритм. Также при ранжировании кандидатов учитывается контекст и семантические свойства прошлых подпрограмм. Такой способ напоминает декомпозицию задачи и дальнейшее копирование подпрограмм со StackOverflow программистом) Надеемся, что и дальше будут появляться такие же интересные и успешные примеры соединения ML с алгоритмами поиска.

2020 November 09

Neural Databases

https://arxiv.org/pdf/2010.06973v1.pdf

Когда - 14 октября 2020

🍭️️️ В чем понт

Залог и фундамент любой успешной работы с данными - уметь их хранить и извлекать. Традиционные базы данных имеют заранее заданную структуру, и для работы с ними нужно знать языки по типу SQL. Таким образом и хранение и извлечение данных требует экпертизы, часто недешевой. Авторы из FacebookAI предлагают базу данных, которую можно наполнять обычным текстом и обращаться к ней предложениями на естественном языке.

📄 Постановка задачи

Для задачи авторы сгенерировали базу предложений из обьекта, субьекта и отношения между ними. Например: “Джон женат на Мэри”. Джон это субьект, женат - отношение, Мэри - объект. Такими предложениями можно заполнять предложенную базу. Допустимые операции - это select (извлечение строки) project (извлечени столбца) и join (слияние). Например вопрос “Кто женат на Мери?” будет соответствовать операции select. А если добавить к предложению “Джон женат на Мэри” предложение “Мэри работает программистом”, то вопрос “Кто женат на программисте?” уже потребует операции join. Таким образом наша задача по набору фактов-предложений и вопроса сгенерировать ответ.

🔥 Подробности

Первый подход - сконкатенировать все факты и вопрос и научить transformer предсказывать ответ. Авторы пробовали смотреть, как сеть учится предсказывать ответ, если давать ей минимальный необходимый набор фактов и более широкий набор фактов. И в первом и во втором случае сеть может выучить представление. Однако агрегировать все факты до того, как отдать их в Transformer - вычислительно дорого. А если производить агрегацию уже после выхода из энкодера, то качество сети получается крайне низким.

Поэтому авторы предложили следующий вариант: сначала сеть подбирает различные варианты кандидатов предложений, которые могут оказаться полезными при ответе на вопрос, а затем по признакам этих кандидатов предсказывает ответ на вопрос. Плюс такого подхода также в том, что он параллелится.

🔎 Что в итоге

В результате авторы получили алгоритм, который может работать с базами данных на естественных языках и не требует специализированных аналитических навыков. При этом он может работать с большим текстом, в отличие от суммаризации текста. Интересно распространить этот алгоритм например на изображения, или даже на смешанные данные “изображения + тексты”. Например, у вас есть набор фотографий с конференции и описание спикеров, к такой базе можно будет задать вопрос “Что было на слайдах у спикера из МФТИ?”

Ждем когда статьи начнут превращаться в аналитические инструменты будущего!

https://arxiv.org/pdf/2010.06973v1.pdf

Когда - 14 октября 2020

🍭️️️ В чем понт

Залог и фундамент любой успешной работы с данными - уметь их хранить и извлекать. Традиционные базы данных имеют заранее заданную структуру, и для работы с ними нужно знать языки по типу SQL. Таким образом и хранение и извлечение данных требует экпертизы, часто недешевой. Авторы из FacebookAI предлагают базу данных, которую можно наполнять обычным текстом и обращаться к ней предложениями на естественном языке.

📄 Постановка задачи

Для задачи авторы сгенерировали базу предложений из обьекта, субьекта и отношения между ними. Например: “Джон женат на Мэри”. Джон это субьект, женат - отношение, Мэри - объект. Такими предложениями можно заполнять предложенную базу. Допустимые операции - это select (извлечение строки) project (извлечени столбца) и join (слияние). Например вопрос “Кто женат на Мери?” будет соответствовать операции select. А если добавить к предложению “Джон женат на Мэри” предложение “Мэри работает программистом”, то вопрос “Кто женат на программисте?” уже потребует операции join. Таким образом наша задача по набору фактов-предложений и вопроса сгенерировать ответ.

🔥 Подробности

Первый подход - сконкатенировать все факты и вопрос и научить transformer предсказывать ответ. Авторы пробовали смотреть, как сеть учится предсказывать ответ, если давать ей минимальный необходимый набор фактов и более широкий набор фактов. И в первом и во втором случае сеть может выучить представление. Однако агрегировать все факты до того, как отдать их в Transformer - вычислительно дорого. А если производить агрегацию уже после выхода из энкодера, то качество сети получается крайне низким.

Поэтому авторы предложили следующий вариант: сначала сеть подбирает различные варианты кандидатов предложений, которые могут оказаться полезными при ответе на вопрос, а затем по признакам этих кандидатов предсказывает ответ на вопрос. Плюс такого подхода также в том, что он параллелится.

🔎 Что в итоге

В результате авторы получили алгоритм, который может работать с базами данных на естественных языках и не требует специализированных аналитических навыков. При этом он может работать с большим текстом, в отличие от суммаризации текста. Интересно распространить этот алгоритм например на изображения, или даже на смешанные данные “изображения + тексты”. Например, у вас есть набор фотографий с конференции и описание спикеров, к такой базе можно будет задать вопрос “Что было на слайдах у спикера из МФТИ?”

Ждем когда статьи начнут превращаться в аналитические инструменты будущего!

2020 December 14

Scaling down Deep Learning

https://arxiv.org/pdf/2011.14439v2.pdf

Когда - 1 декабря 2020

🎄В чем понт

В любых исследованиях решающее значение играют усилия и сроки, за которые можно сделать открытие и выявить закономерность. Именно по этой причине в генетике огромное количество исследований проводится на Дрозофилле - мухе, которая быстро размножается. Исследования можно производить быстро и дешево, а найденные закономерности затем переносить на человека.

В своей статье автор предлагает такой модельный датасет для изучения глубоких моделей - MNIST-1d, и демонстрирует на нем проверку трудоемких гипотез за считанные часы и даже минуты. Кроме этого он делает ряд новых, фундаментально полезных наблюдений. Код исследований доступен для проверки.

🥂 Описание датасета

Как утверждают авторы, MNIST хорошо бы подошел нам для исследований, но он имеет три заметных недостатка, которые устранены в MNIST-1d:

1) MNIST плохо различает линейные, нелинейные и трансляционно-инвариантные модели. Например, тесты logistic, MLP и CNN дают точность 94, 99+ и 99+%. Это затрудняет измерение вклада пространственных приоров CNN или оценку относительной эффективности различных схем регуляризации.

2) MNIST сслишком большой для модельного набора данных. Каждый входной пример представляет собой 784-мерный вектор, и поэтому требуется нетривиальное количество вычислений для выполнения поиска гиперпараметров или отладки цикла metalearning.

3) MNIST трудно модифицировать. Идеальный набор модельных данных должен быть процедурно сгенерирован, чтобы исследователи могли плавно менять такие параметры, как например фоновый шум и разрешение.

Набор данных MNIST-1d решает эти проблемы: он генерируется процедурно, но все же допускает аналогии с классификацией цифр реального мира. Как и MNIST, цель классификатора состоит в том, чтобы определить, какая цифра присутствует во входных данных. В отличие от MNIST, каждый пример представляет собой одномерную последовательность точек. Чтобы создать пример, автор заполняет, переводит и преобразует набор шаблонных цифр, чтобы получить одномерные последовательности.

🎁 Примеры исследований

С помощью датасета авторы исследуют различные эффекты. Например, deep double descent - когда с увеличением параметров сети лосс сначала падает, затем растет, затем снова падает. Этот эффект сильно влияет на способы и стратегию обучения сетей. Автор пронаблюдал этот эффект, а также вывел новую интересную закономерность - количество параметров модели, на котором лосс после роста начинает падать, в случае использования mse выражается, как K*n, где K- количество выходов сети, а n - количество примеров, а если использовать negative log likelihood, то количество параметров модели, на котором лосс после роста начинает падать, выражается как n. Это демонстрирует преимущество negative log likelihood loss перед mse loss.

На примере MNIST-1d в статье рассматривается, насколько пулинг эффективно работает в зависимости от обьемов выборки. Можно пронаблюдать, как эффект от добавления пулинга снижается с ростом данных.

Также авторы наблюдают на своем датасете “поиск лотерейного билета” и влияние индуктивного байеса в этом процессе - внутри большой сети можно найти такую оптимальную подсеть, которая при обучении даст качество выше оригинальной. Еще в статье можно прочитать о gradient-based metalearning и metalearning an activation function и воспроизвести все эксперименты автора в браузере за несколько часов или даже минут.

🎅Что в итоге

Чем дальше, тем важнее искать новые закономерности и особенности поведения сетей в краевых случаях. Очень важно делать это в сжатые сроки. В своей статье авторы исследоуют около 5 эффектов с помощью своеего датасета и приходят к очень интересным результатам.

Я уверена, что применение подобных модельных датасетов и глубокое изучение сетей станет common practice очень скоро и разнообразит интенсивный фон инженерных статей.

https://arxiv.org/pdf/2011.14439v2.pdf

Когда - 1 декабря 2020

🎄В чем понт

В любых исследованиях решающее значение играют усилия и сроки, за которые можно сделать открытие и выявить закономерность. Именно по этой причине в генетике огромное количество исследований проводится на Дрозофилле - мухе, которая быстро размножается. Исследования можно производить быстро и дешево, а найденные закономерности затем переносить на человека.

В своей статье автор предлагает такой модельный датасет для изучения глубоких моделей - MNIST-1d, и демонстрирует на нем проверку трудоемких гипотез за считанные часы и даже минуты. Кроме этого он делает ряд новых, фундаментально полезных наблюдений. Код исследований доступен для проверки.

🥂 Описание датасета

Как утверждают авторы, MNIST хорошо бы подошел нам для исследований, но он имеет три заметных недостатка, которые устранены в MNIST-1d:

1) MNIST плохо различает линейные, нелинейные и трансляционно-инвариантные модели. Например, тесты logistic, MLP и CNN дают точность 94, 99+ и 99+%. Это затрудняет измерение вклада пространственных приоров CNN или оценку относительной эффективности различных схем регуляризации.

2) MNIST сслишком большой для модельного набора данных. Каждый входной пример представляет собой 784-мерный вектор, и поэтому требуется нетривиальное количество вычислений для выполнения поиска гиперпараметров или отладки цикла metalearning.

3) MNIST трудно модифицировать. Идеальный набор модельных данных должен быть процедурно сгенерирован, чтобы исследователи могли плавно менять такие параметры, как например фоновый шум и разрешение.

Набор данных MNIST-1d решает эти проблемы: он генерируется процедурно, но все же допускает аналогии с классификацией цифр реального мира. Как и MNIST, цель классификатора состоит в том, чтобы определить, какая цифра присутствует во входных данных. В отличие от MNIST, каждый пример представляет собой одномерную последовательность точек. Чтобы создать пример, автор заполняет, переводит и преобразует набор шаблонных цифр, чтобы получить одномерные последовательности.

🎁 Примеры исследований

С помощью датасета авторы исследуют различные эффекты. Например, deep double descent - когда с увеличением параметров сети лосс сначала падает, затем растет, затем снова падает. Этот эффект сильно влияет на способы и стратегию обучения сетей. Автор пронаблюдал этот эффект, а также вывел новую интересную закономерность - количество параметров модели, на котором лосс после роста начинает падать, в случае использования mse выражается, как K*n, где K- количество выходов сети, а n - количество примеров, а если использовать negative log likelihood, то количество параметров модели, на котором лосс после роста начинает падать, выражается как n. Это демонстрирует преимущество negative log likelihood loss перед mse loss.

На примере MNIST-1d в статье рассматривается, насколько пулинг эффективно работает в зависимости от обьемов выборки. Можно пронаблюдать, как эффект от добавления пулинга снижается с ростом данных.

Также авторы наблюдают на своем датасете “поиск лотерейного билета” и влияние индуктивного байеса в этом процессе - внутри большой сети можно найти такую оптимальную подсеть, которая при обучении даст качество выше оригинальной. Еще в статье можно прочитать о gradient-based metalearning и metalearning an activation function и воспроизвести все эксперименты автора в браузере за несколько часов или даже минут.

🎅Что в итоге

Чем дальше, тем важнее искать новые закономерности и особенности поведения сетей в краевых случаях. Очень важно делать это в сжатые сроки. В своей статье авторы исследоуют около 5 эффектов с помощью своеего датасета и приходят к очень интересным результатам.

Я уверена, что применение подобных модельных датасетов и глубокое изучение сетей станет common practice очень скоро и разнообразит интенсивный фон инженерных статей.

2021 March 28

Directive explanations for actionable explainability in machine learning applications

https://arxiv.org/pdf/2102.02671v1.pdf

🔎В чем понт

Все чаще на нашу жизнь влияют модели машинного обучения, которые по нашим характеристикам решают, что нам делать можно, а где нужно доработать. Примеров много: от классического кредитного скоринга до системы социального рейтинга в Китае.

Часто решение алгоритма не обьясняется, а если и обьясняется, то без конкретных действий, которые стоит предпринять для перелома ситуации. Однако, очень важно обьяснять людям решение алгоритма, и более того, обьяснять что нужно сделать, чтобы поменять ситуацию. В статье авторы исследуют обьясняющие методы машинного обучения и отношение людей к обьяснениям разного типа.

👌Как обьяснить людям решение модели

Для обьяснения результатов скоринга существует 2 подхода: контрфактуалы и директивы. Контрфактуалы описывают то, почему кредит не дали (низкий доход, наличие прошлых задолжностей). Проблема в том, что не всегда понятно, как сделать так, чтобы признаки достигали удовлетворительных значений, плюс некоторые признаки поменять в моменте могут не все. Эта проблема обычно решается путем предложения нескольких контрфактических объяснений.

В директивном объяснении рекомендуются конкретные действия, которые человек может предпринять для достижения контрфактического состояния (например, погасите свой автокредит).

🧷Как встроить обьяснения в модели

Обычно контрфактуалы-это близкие возможные миры с другим исходом. То есть, учитывая признаки x и соответствующий выход модели машинного обучения f, контрфактическое объяснение представляет собой возмущение входного сигнала x, таким образом, что модель производит другой выход, y,. Концептуально для каждого с мы хотим сформировать политику действий, переходящих из начального состояния х в контрфактическое состояние с. Решение, данное для задачи планирования π, является директивным объяснением.

⚔️Как проводили эксперимент

Авторы предоставили участникам эксперимента различные типы объяснений по тому, почему им не дали кредит, из которых одно было недирективным, а два-директивными. Недирективное объяснение содержало информацию о контрфактическом состоянии, но не включало действий (например, ваш доход должен быть больше 42000 долларов). Директивно-общее объяснение рекомендовало общий класс действий (уменьшить общий долг), чтобы указать человеку виды действий, которые могут быть предприняты для достижения контрфактического состояния, но в целом так, чтобы люди все еще имели некоторую автономию. Для каждого сценария участники ранжировали три объяснения от наиболее предпочтительных до наименее предпочтительных и подробно описывали причины своего выбора. Авторы провели исследование Amazon MTurk с 54 участниками и обнаружили, что существует значительная поддержка директивных объяснений (р = 0,001). Примерно 50% участников выбрали директивные объяснения, 26% выбрали директивные общие объяснения и 24% выбрали недирективные объяснения в качестве наиболее предпочтительного объяснения. Однако анализ также показал, что директивы были нежелательны для некоторых объяснений и что предпочтения участников зависели как от конкретного сценария, так и от индивидуальных предпочтений. Также стало понятно, что выбор также зависит от социальных факторов и от того, воспринимаются ли действия как осуществимые.

🧿Что в итоге

Машинное обучение не просто должно решать, как нам жить, но и помогать жить лучше. Авторы поняли, что в случае негативного вердикта, людям важно понимать, как изменить ситуацию, а не только то, что именно пошло не так.

Но для некоторых людей и признаков обьяснения не работают. Это открывает новые мысли и вызовы для ML - помимо хорошего предсказания скоринга, нужно думать над персонализированными обьяснениями и call to action результатами.

https://arxiv.org/pdf/2102.02671v1.pdf

🔎В чем понт

Все чаще на нашу жизнь влияют модели машинного обучения, которые по нашим характеристикам решают, что нам делать можно, а где нужно доработать. Примеров много: от классического кредитного скоринга до системы социального рейтинга в Китае.

Часто решение алгоритма не обьясняется, а если и обьясняется, то без конкретных действий, которые стоит предпринять для перелома ситуации. Однако, очень важно обьяснять людям решение алгоритма, и более того, обьяснять что нужно сделать, чтобы поменять ситуацию. В статье авторы исследуют обьясняющие методы машинного обучения и отношение людей к обьяснениям разного типа.

👌Как обьяснить людям решение модели

Для обьяснения результатов скоринга существует 2 подхода: контрфактуалы и директивы. Контрфактуалы описывают то, почему кредит не дали (низкий доход, наличие прошлых задолжностей). Проблема в том, что не всегда понятно, как сделать так, чтобы признаки достигали удовлетворительных значений, плюс некоторые признаки поменять в моменте могут не все. Эта проблема обычно решается путем предложения нескольких контрфактических объяснений.

В директивном объяснении рекомендуются конкретные действия, которые человек может предпринять для достижения контрфактического состояния (например, погасите свой автокредит).

🧷Как встроить обьяснения в модели

Обычно контрфактуалы-это близкие возможные миры с другим исходом. То есть, учитывая признаки x и соответствующий выход модели машинного обучения f, контрфактическое объяснение представляет собой возмущение входного сигнала x, таким образом, что модель производит другой выход, y,. Концептуально для каждого с мы хотим сформировать политику действий, переходящих из начального состояния х в контрфактическое состояние с. Решение, данное для задачи планирования π, является директивным объяснением.

⚔️Как проводили эксперимент

Авторы предоставили участникам эксперимента различные типы объяснений по тому, почему им не дали кредит, из которых одно было недирективным, а два-директивными. Недирективное объяснение содержало информацию о контрфактическом состоянии, но не включало действий (например, ваш доход должен быть больше 42000 долларов). Директивно-общее объяснение рекомендовало общий класс действий (уменьшить общий долг), чтобы указать человеку виды действий, которые могут быть предприняты для достижения контрфактического состояния, но в целом так, чтобы люди все еще имели некоторую автономию. Для каждого сценария участники ранжировали три объяснения от наиболее предпочтительных до наименее предпочтительных и подробно описывали причины своего выбора. Авторы провели исследование Amazon MTurk с 54 участниками и обнаружили, что существует значительная поддержка директивных объяснений (р = 0,001). Примерно 50% участников выбрали директивные объяснения, 26% выбрали директивные общие объяснения и 24% выбрали недирективные объяснения в качестве наиболее предпочтительного объяснения. Однако анализ также показал, что директивы были нежелательны для некоторых объяснений и что предпочтения участников зависели как от конкретного сценария, так и от индивидуальных предпочтений. Также стало понятно, что выбор также зависит от социальных факторов и от того, воспринимаются ли действия как осуществимые.

🧿Что в итоге

Машинное обучение не просто должно решать, как нам жить, но и помогать жить лучше. Авторы поняли, что в случае негативного вердикта, людям важно понимать, как изменить ситуацию, а не только то, что именно пошло не так.

Но для некоторых людей и признаков обьяснения не работают. Это открывает новые мысли и вызовы для ML - помимо хорошего предсказания скоринга, нужно думать над персонализированными обьяснениями и call to action результатами.

2021 May 16

Безопасность и интерпретируемость моделей

https://www.arthur.ai/product

https://www.robustintelligence.com

https://arxiv.org/pdf/2010.10596.pdf

🔎В чем понт

В прошлом посте я писала про модели машинного обучения, которые по нашим характеристикам решают, как нам можно поступать, а где нужно доработать: кредитный скоринг, персонализированное ценообразование и тд. Авторы говорили, что очень важно делать модели интерпретируемыми, понимать, когда что-то идет не так, и не менее важно обьяснять людям решение ML. Кажется это следующий виток в области: с тем, что делать разобрались, теперь нужно контролировать качество, следить за безопасностью и понимать, как это работает (хаха). В этом посте я расскажу про 2 молодых стартапа, которые уже поднимают деньги на теме безопасного и интерпретируемого AI и помогают крупным компаниям.

🦄Что за компании, где я их нашла, сколько денег подняли

В последнее время часто смотрю CBInsights - это аггрегатор информации про компании, стартапы. Там выходят классные, новости, аналитика. Ребята каждый год несколько раз обновляют подборку AI-100 - туда они включают самые promising AI-компании. Выбирают по количеству поднятых инвестиций, профилю инвестора, анализу новостей, рыночному потенциалу, конкурентам, силе команды и новизне в технологиях. Из 100 компаний 2021 года подборки 2 было про интерпретируемость AI: Robust Intellegence и Arthur. На A-round (привлечение денег на начальных этапах, инвесторы требуют масштабируемости, обычно не требуют прибыли) подняли 14 и 12 млн$. Это достаточно много для этого раунда, хотя бывает и больше (китайский стартап грузоперевозок из той же подборки на A-round поднял 220 млн$). Компании основаны в 2018 и 2019 году, то есть совсем молодые.

🍒 Что они делают?

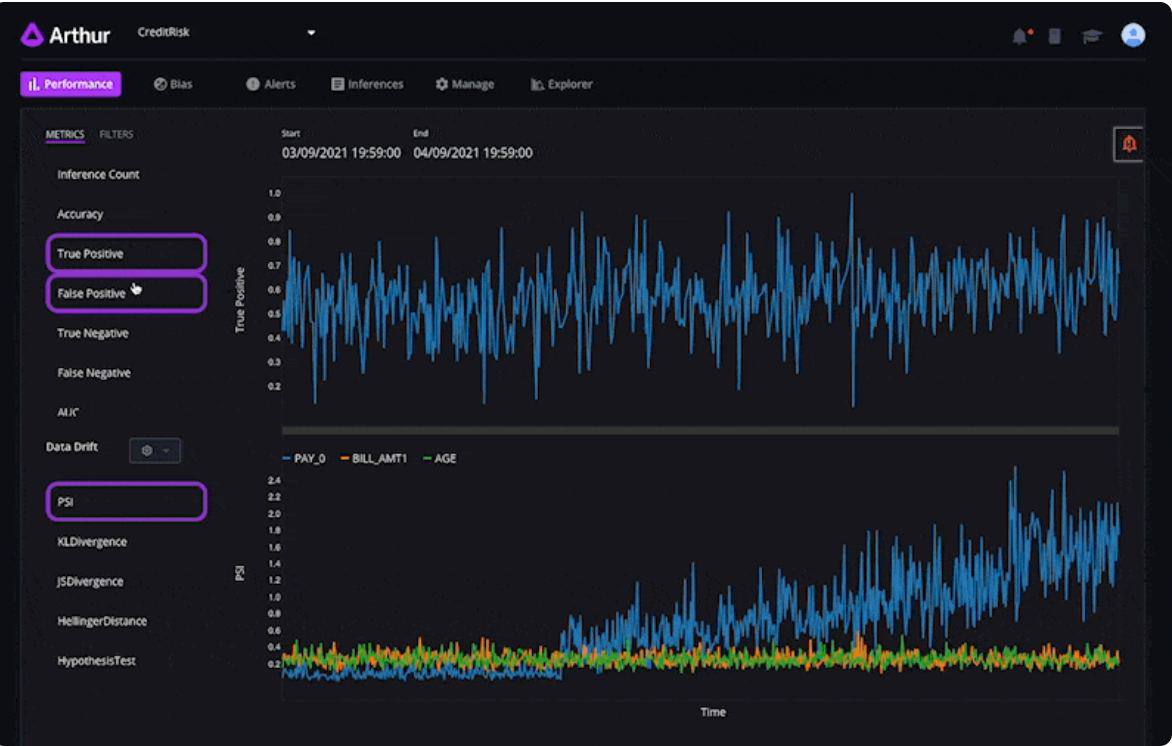

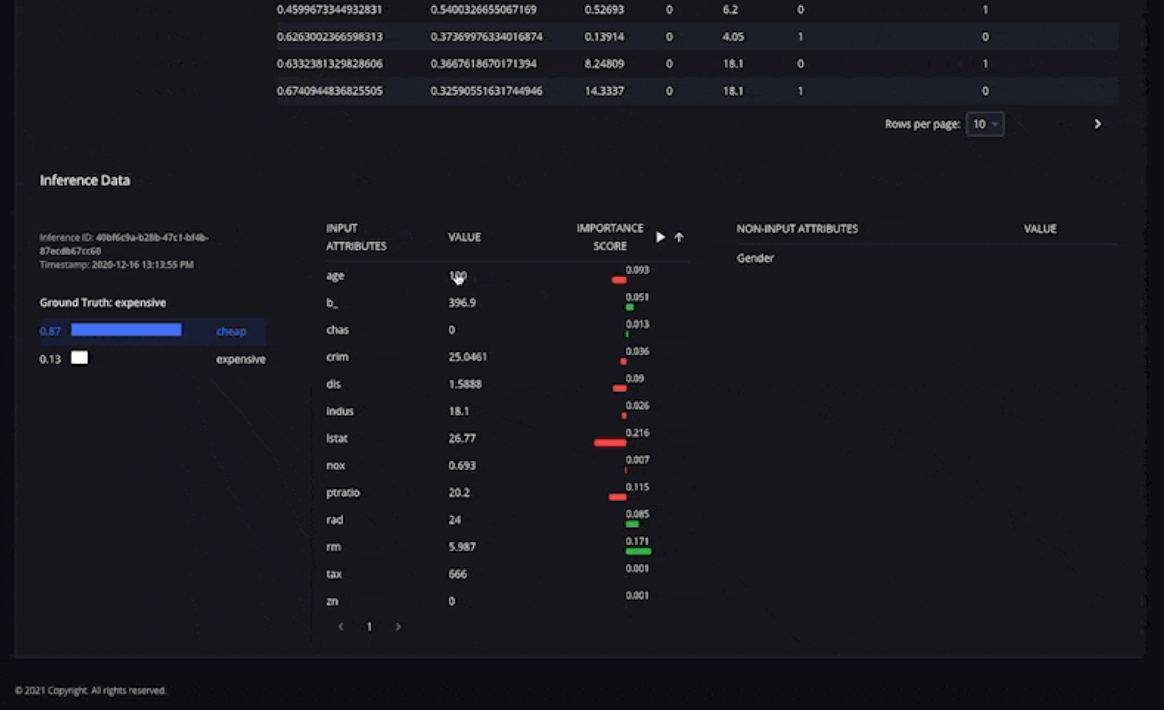

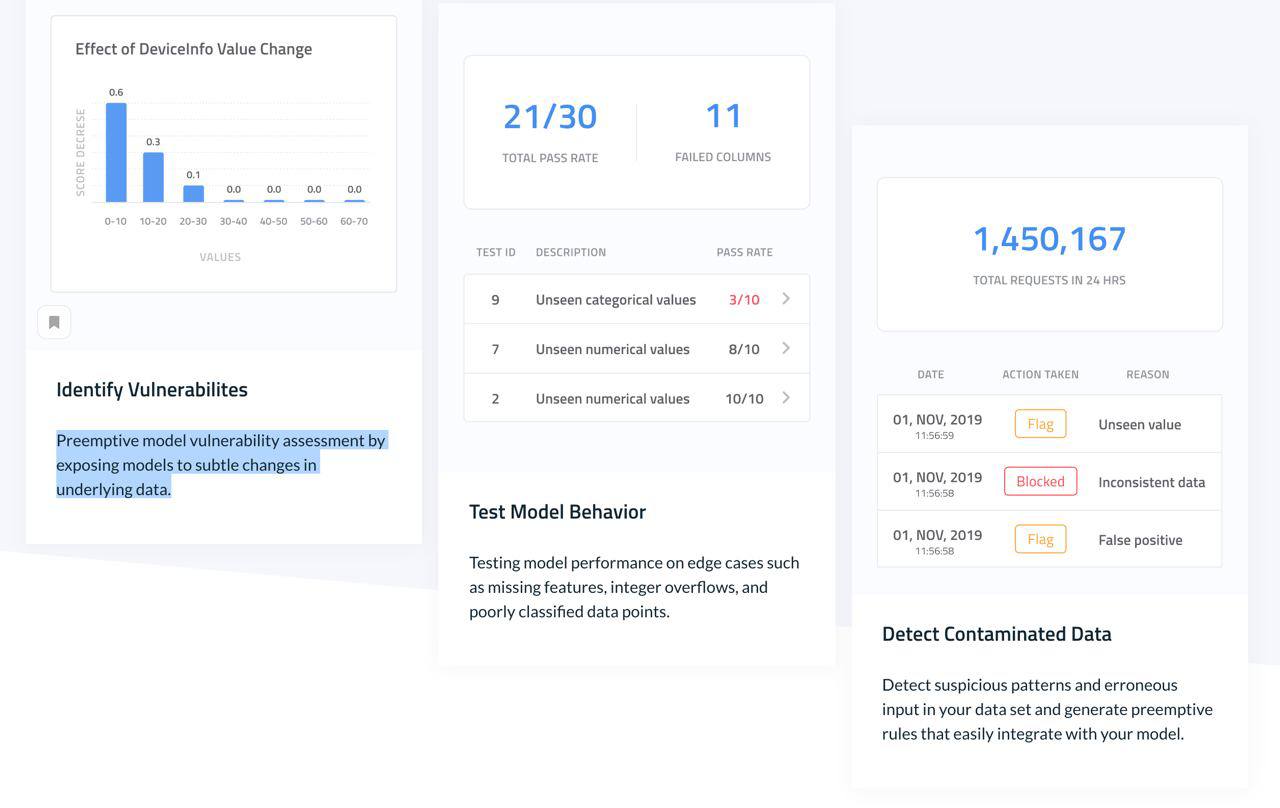

Arthur состоит из трех частей: мониторинги моделей, их аналитика и улучшатель моделей. Все 3 вещи можно смотреть и настраивать в их интерфейсе, к посту прикреплены скрины вкладок в максимально доступном качестве :). На этапе мониторинга Arthur смотрит на производительность модели, аллертит, если что-то изменяется, подсвечивает дрейф данных (если распределение в данных изменилось относительно истории). На втором этапе аналитики тулза выделяет bias, понимает, какие фичи и как влияют на итоговое предсказание и подбирает наиболее информативную метрику для оценки модели. Далее предлагается модель для починки поломок в модели (очень было бы интересно узнать как конкретнее он работает), экспорт отчетов, плюс можно моделировать для пользователя контрфактуалы (не просто информирование о том, что кредит не выдали, а обьяснение, что сделать по-другому в следующий раз, чтобы кредит дали). Arthur выпустил статью-обзор на эту тему, в ссылках наверху.

Robust Intellegence больше сфокусирован на безопасности, а не интерпретируемости (скрин с описанием работы системы в прикрепе). В тулзе есть модуль "профилактического” выявления уязвимости: в данные вносятся небольшие изменения и наблюдается поведение моделей. Также через модель прогоняются потециально проблемные данные: из которых признаки выкинуты или заполнены странными значениями, плохо классифицирующиеся обьекты. Также Robust Intellegence ищет проблемные данные и создают правило, которое помогает избежать ошибок модели на этом срезе.

🥂Что в итоге

Интересное и новое направление в исследованиях и стартапах. Оптимистично настраивает относительного будущего ML: data science не умрет, решив все задачи, а выйдет на новую ступень развития, где появляются все более глубокие проблемы и вызовы.

https://www.arthur.ai/product

https://www.robustintelligence.com

https://arxiv.org/pdf/2010.10596.pdf

🔎В чем понт

В прошлом посте я писала про модели машинного обучения, которые по нашим характеристикам решают, как нам можно поступать, а где нужно доработать: кредитный скоринг, персонализированное ценообразование и тд. Авторы говорили, что очень важно делать модели интерпретируемыми, понимать, когда что-то идет не так, и не менее важно обьяснять людям решение ML. Кажется это следующий виток в области: с тем, что делать разобрались, теперь нужно контролировать качество, следить за безопасностью и понимать, как это работает (хаха). В этом посте я расскажу про 2 молодых стартапа, которые уже поднимают деньги на теме безопасного и интерпретируемого AI и помогают крупным компаниям.

🦄Что за компании, где я их нашла, сколько денег подняли

В последнее время часто смотрю CBInsights - это аггрегатор информации про компании, стартапы. Там выходят классные, новости, аналитика. Ребята каждый год несколько раз обновляют подборку AI-100 - туда они включают самые promising AI-компании. Выбирают по количеству поднятых инвестиций, профилю инвестора, анализу новостей, рыночному потенциалу, конкурентам, силе команды и новизне в технологиях. Из 100 компаний 2021 года подборки 2 было про интерпретируемость AI: Robust Intellegence и Arthur. На A-round (привлечение денег на начальных этапах, инвесторы требуют масштабируемости, обычно не требуют прибыли) подняли 14 и 12 млн$. Это достаточно много для этого раунда, хотя бывает и больше (китайский стартап грузоперевозок из той же подборки на A-round поднял 220 млн$). Компании основаны в 2018 и 2019 году, то есть совсем молодые.

🍒 Что они делают?

Arthur состоит из трех частей: мониторинги моделей, их аналитика и улучшатель моделей. Все 3 вещи можно смотреть и настраивать в их интерфейсе, к посту прикреплены скрины вкладок в максимально доступном качестве :). На этапе мониторинга Arthur смотрит на производительность модели, аллертит, если что-то изменяется, подсвечивает дрейф данных (если распределение в данных изменилось относительно истории). На втором этапе аналитики тулза выделяет bias, понимает, какие фичи и как влияют на итоговое предсказание и подбирает наиболее информативную метрику для оценки модели. Далее предлагается модель для починки поломок в модели (очень было бы интересно узнать как конкретнее он работает), экспорт отчетов, плюс можно моделировать для пользователя контрфактуалы (не просто информирование о том, что кредит не выдали, а обьяснение, что сделать по-другому в следующий раз, чтобы кредит дали). Arthur выпустил статью-обзор на эту тему, в ссылках наверху.

Robust Intellegence больше сфокусирован на безопасности, а не интерпретируемости (скрин с описанием работы системы в прикрепе). В тулзе есть модуль "профилактического” выявления уязвимости: в данные вносятся небольшие изменения и наблюдается поведение моделей. Также через модель прогоняются потециально проблемные данные: из которых признаки выкинуты или заполнены странными значениями, плохо классифицирующиеся обьекты. Также Robust Intellegence ищет проблемные данные и создают правило, которое помогает избежать ошибок модели на этом срезе.

🥂Что в итоге

Интересное и новое направление в исследованиях и стартапах. Оптимистично настраивает относительного будущего ML: data science не умрет, решив все задачи, а выйдет на новую ступень развития, где появляются все более глубокие проблемы и вызовы.

2021 June 13

AI в Финтехе - какими будут банки будущего

В последнее время у меня разыгрался интерес к тому, какие тренды AI задает в нашей настоящей и будущей жизни.

Это очень затягивает, потому что определяет, к каким исследованиям будет приковано внимание в дальнейшем, и как вообще наша с вами жизнь поменяется. Например, большое количество статей по NLP и CV появилось во многом благодаря распознаванию лиц на камерах, поисковым движкам и рекомендательным системам социальных сетей.

Одна из областей, которая очень сильно влияет на мир - это финтех. Банки будущего: какими они будут? Откуда мы будем брать деньги? Как искусственный интллект будет влиять на то, как мы расплачиваемся, тратим деньги, на финансовые потоки в целом?

Достаточно обьективный показатель трендов будущего - это обьем инвестиций в конкретные стартапы. Я посмотрела топ-компаний по количеству инвестированных в них денег на CB Insights в AI-Финтехе.

Ниже короткий обзор 4 характерных представителей AI-финтех, сколько в них вложили, почему и как они могут изменить нашу жизнь.

🤑 Affirm (1.78 млрд $): бери сейчас, плати потом

https://affirm.com/

Сервис продает товары в бесплатную рассрочку - сначала платишь одну часть, потом другую. При бесплатной рассрочке, продавец переводит Affirm 3-5% своего дохода. Еще есть возможность купить в персонализированный с помощью AI кредит - в таком случае деньги берут не с продавца, а с покупателя. Сервис вышел на IPO, капитализация составила 23,6 млрд $

🧍 Avant (1.73 млрд $): у каждого сои персонализированные кредиты и ипотеки

https://avant.com/

Аvant применяет ML-алгоритмы для определения индивидуальной ставки, суммы и продолжительности займа, чтобы снизить риск дефолта и мошенничества. Это онлайн-сервис, он устраняет необходимость в физических филиалах и сильно ускоряет взятие кредита, поскольку основная часть проверки занятости и финансирования осуществляется черезсеть.

🌐 Dataminr (1.04 млрд $): соцсети - наша визитка, каждый твит и история влияет на персонализированный процент по ипотеке

https://dataminr.com/

Dataminr - это компания по анализу данных, которая разрабатывает технологию для выявление скрытой ценности в общедоступных данных соц сетей в режиме реального времени. Компания обслуживает финансовые фирмы на стороне покупки и на стороне продажи и госкомпании. Главная ценность — компания выделяет из аккаунта в соцсети максимум полезной для финтеха информации в онлайне и продает компаниям для скорингов.

🤖 Datarobot (0.57 млрд $): экономика будеет белой, отмывать деньги — трудно, возникнут унифицированные для всех платформенные ML-решения

https://www.datarobot.com/

Сейчас развиваются универсальные ML-платформы, на которые можно регулярно подгружать данные из разных баз, настраивать и обучать модели. Datarobot - одна из таких платформ. С помощью нее 4 из 5 крупных северных американских банков поднимают свой compliance - процесс выявления подозрительных транзакций, чтобы бороться с отмывом денег. Там есть готовые туториалы по тому, как выбирать таргет, какие фичи жгут в этой задаче, плюсс по результату обучения и обновления моделей формируется comliance отчет по тому, как именно обучена модель. Такие отчеты убирают вопросы от государственных служб по неинтерпретируемости моделей.

🥂 Что в итоге?

Если подводить итоги - финтех должен стать более гибким и белым, плюс, так как отодвинется момент от приобритения товара до платежа, фактических средств у нас станет больше. Разумеется, если эти технологии применять этично 🙂

В последнее время у меня разыгрался интерес к тому, какие тренды AI задает в нашей настоящей и будущей жизни.

Это очень затягивает, потому что определяет, к каким исследованиям будет приковано внимание в дальнейшем, и как вообще наша с вами жизнь поменяется. Например, большое количество статей по NLP и CV появилось во многом благодаря распознаванию лиц на камерах, поисковым движкам и рекомендательным системам социальных сетей.

Одна из областей, которая очень сильно влияет на мир - это финтех. Банки будущего: какими они будут? Откуда мы будем брать деньги? Как искусственный интллект будет влиять на то, как мы расплачиваемся, тратим деньги, на финансовые потоки в целом?

Достаточно обьективный показатель трендов будущего - это обьем инвестиций в конкретные стартапы. Я посмотрела топ-компаний по количеству инвестированных в них денег на CB Insights в AI-Финтехе.

Ниже короткий обзор 4 характерных представителей AI-финтех, сколько в них вложили, почему и как они могут изменить нашу жизнь.

🤑 Affirm (1.78 млрд $): бери сейчас, плати потом

https://affirm.com/

Сервис продает товары в бесплатную рассрочку - сначала платишь одну часть, потом другую. При бесплатной рассрочке, продавец переводит Affirm 3-5% своего дохода. Еще есть возможность купить в персонализированный с помощью AI кредит - в таком случае деньги берут не с продавца, а с покупателя. Сервис вышел на IPO, капитализация составила 23,6 млрд $

🧍 Avant (1.73 млрд $): у каждого сои персонализированные кредиты и ипотеки

https://avant.com/

Аvant применяет ML-алгоритмы для определения индивидуальной ставки, суммы и продолжительности займа, чтобы снизить риск дефолта и мошенничества. Это онлайн-сервис, он устраняет необходимость в физических филиалах и сильно ускоряет взятие кредита, поскольку основная часть проверки занятости и финансирования осуществляется черезсеть.

🌐 Dataminr (1.04 млрд $): соцсети - наша визитка, каждый твит и история влияет на персонализированный процент по ипотеке

https://dataminr.com/

Dataminr - это компания по анализу данных, которая разрабатывает технологию для выявление скрытой ценности в общедоступных данных соц сетей в режиме реального времени. Компания обслуживает финансовые фирмы на стороне покупки и на стороне продажи и госкомпании. Главная ценность — компания выделяет из аккаунта в соцсети максимум полезной для финтеха информации в онлайне и продает компаниям для скорингов.

🤖 Datarobot (0.57 млрд $): экономика будеет белой, отмывать деньги — трудно, возникнут унифицированные для всех платформенные ML-решения

https://www.datarobot.com/

Сейчас развиваются универсальные ML-платформы, на которые можно регулярно подгружать данные из разных баз, настраивать и обучать модели. Datarobot - одна из таких платформ. С помощью нее 4 из 5 крупных северных американских банков поднимают свой compliance - процесс выявления подозрительных транзакций, чтобы бороться с отмывом денег. Там есть готовые туториалы по тому, как выбирать таргет, какие фичи жгут в этой задаче, плюсс по результату обучения и обновления моделей формируется comliance отчет по тому, как именно обучена модель. Такие отчеты убирают вопросы от государственных служб по неинтерпретируемости моделей.

🥂 Что в итоге?

Если подводить итоги - финтех должен стать более гибким и белым, плюс, так как отодвинется момент от приобритения товара до платежа, фактических средств у нас станет больше. Разумеется, если эти технологии применять этично 🙂

2021 July 31

Infermedica

https://infermedica.com/

Меня очень вдохновляет связка технологий и медицины. Особенно решения, которые с помощью технологий могут оказывать помощь здесь и сейчас.

🧑

Сейчас 18 млрд долларов тратится на визиты к врачу, которые были не нужны. Плюс многие люди не получают помощь достаточно быстро. Это я сильно прочувствовала на этой неделе, когда заказывала скорую, мне 5 минут задавали странные вопросы и время ожидания было непонятное и потенциально долгое. Так что стало удобней вызвать такси в клинику рядом, а после оказания первой помощи уже из нее вызвать скорую в другую клинику. К тому же, мои жалобы врачу никак не систематизируются. От того, что человек с симптомами, как у меня, вчера умер от того, что не получил быструю помощь, скорая сегодня ко мне быстрее не приедет.

💊Понт

Хочу вам рассказать о компании, которая делает софт для решения этих проблем. Это помощники для коллцентра и предварительных консультаций, которые помогают понять, нужна ли пациенту онлайн-помощь, вообще не нужна консульация, что им надо записаться к врачу или уехать на скорой. Плюс дают операторам контакт-центров подсказки, какие вопросы задавать пациентам. Все это основано на 44000 часовом анализе медицинских статей и дообучении на данных прошлых пациентов.

Компании для которых Intermedica делает решения - страховые и медицинские. В компании работает 50-100 человек, у нее 3.5 млн пользователей и 10 млн$ инвестиций.

Они делают 3 продукта - первый это помощник для человека, который записывается к врачу, ранжировщик пациентов в контакт-центре и апи к системе.

Помощник для записи к врачу

Я почувствовала недомогание и хочу записаться к врачу. Я открываю сайт-приложение, система задает мне вопросы про мое состояние. Я на них отвечаю, система подбирает следующие релевантные вопросы с помощью ml-алгоритмов. Дальше дает рекомендации по тому, к кому обратится, а введеные мною данные пересылает в клинику.

Помощник операторам контакт-центра

Плюс есть помощник для контакт центров. Человек звонит за помощью, ему отвечает оператор. У оператора есть рабочее место, на котором он смотрит подсказки, которые ему дает алгоритм, на тему того, какие вопросы задать. Оператор записывает ответы пациента на вопросы, а затем задает новые. Алгоритм подсказывает ему следующий вопрос. Дальше алгоритм ранжирует срочность обращения пациента, насколько быстро ему нужна помощь относительно других пациентов

Открытое апи

У страховой компании может быть своя специфика и правила. Или изменения в мире, которые требуют быстрого внесения правил. Например, компания хочет всегда отправлять скорую за пациентами с потерей запаха, потому что случился ковид. Для этого придумали открытое апи к системе - можно менять текущие сценарии обработки жалобы пациента и дописывать свои.

💉Почему это круто, и что хочется еще

Healthtech - это важнейшая тема. А если есть решения, которые рещают боль сейчас, а не через 20 лет (что то же нужно) - это вообще суперкруто. В области есть сложности с внедрением ML решений - ответсвенность должна быть на враче. Intermedica интересно обходит этот момент - они всего лишь делают софт, но выбор остается за специалистом. Здорово, что знания про заболевания и фидбек собирается в одном месте и используется, чтобы будущие пациенты получали более хорошее лечение.

Было бы круто, если бы апи системы развилось, и стали появляться, например, kaggle соревнования по тому, чтобы предсказывать диагноз еще лучше. В общем, не хватает движения к open-source.

https://infermedica.com/

Меня очень вдохновляет связка технологий и медицины. Особенно решения, которые с помощью технологий могут оказывать помощь здесь и сейчас.

🧑

⚕ПроблемаСейчас 18 млрд долларов тратится на визиты к врачу, которые были не нужны. Плюс многие люди не получают помощь достаточно быстро. Это я сильно прочувствовала на этой неделе, когда заказывала скорую, мне 5 минут задавали странные вопросы и время ожидания было непонятное и потенциально долгое. Так что стало удобней вызвать такси в клинику рядом, а после оказания первой помощи уже из нее вызвать скорую в другую клинику. К тому же, мои жалобы врачу никак не систематизируются. От того, что человек с симптомами, как у меня, вчера умер от того, что не получил быструю помощь, скорая сегодня ко мне быстрее не приедет.

💊Понт

Хочу вам рассказать о компании, которая делает софт для решения этих проблем. Это помощники для коллцентра и предварительных консультаций, которые помогают понять, нужна ли пациенту онлайн-помощь, вообще не нужна консульация, что им надо записаться к врачу или уехать на скорой. Плюс дают операторам контакт-центров подсказки, какие вопросы задавать пациентам. Все это основано на 44000 часовом анализе медицинских статей и дообучении на данных прошлых пациентов.

Компании для которых Intermedica делает решения - страховые и медицинские. В компании работает 50-100 человек, у нее 3.5 млн пользователей и 10 млн$ инвестиций.

Они делают 3 продукта - первый это помощник для человека, который записывается к врачу, ранжировщик пациентов в контакт-центре и апи к системе.

Помощник для записи к врачу

Я почувствовала недомогание и хочу записаться к врачу. Я открываю сайт-приложение, система задает мне вопросы про мое состояние. Я на них отвечаю, система подбирает следующие релевантные вопросы с помощью ml-алгоритмов. Дальше дает рекомендации по тому, к кому обратится, а введеные мною данные пересылает в клинику.

Помощник операторам контакт-центра

Плюс есть помощник для контакт центров. Человек звонит за помощью, ему отвечает оператор. У оператора есть рабочее место, на котором он смотрит подсказки, которые ему дает алгоритм, на тему того, какие вопросы задать. Оператор записывает ответы пациента на вопросы, а затем задает новые. Алгоритм подсказывает ему следующий вопрос. Дальше алгоритм ранжирует срочность обращения пациента, насколько быстро ему нужна помощь относительно других пациентов

Открытое апи

У страховой компании может быть своя специфика и правила. Или изменения в мире, которые требуют быстрого внесения правил. Например, компания хочет всегда отправлять скорую за пациентами с потерей запаха, потому что случился ковид. Для этого придумали открытое апи к системе - можно менять текущие сценарии обработки жалобы пациента и дописывать свои.

💉Почему это круто, и что хочется еще

Healthtech - это важнейшая тема. А если есть решения, которые рещают боль сейчас, а не через 20 лет (что то же нужно) - это вообще суперкруто. В области есть сложности с внедрением ML решений - ответсвенность должна быть на враче. Intermedica интересно обходит этот момент - они всего лишь делают софт, но выбор остается за специалистом. Здорово, что знания про заболевания и фидбек собирается в одном месте и используется, чтобы будущие пациенты получали более хорошее лечение.

Было бы круто, если бы апи системы развилось, и стали появляться, например, kaggle соревнования по тому, чтобы предсказывать диагноз еще лучше. В общем, не хватает движения к open-source.

2021 August 12

Всем привет!) Это Таня, автор канала

Наверное подписчики заметили, что последние полгода посты выходят реже. Дело в том, что мы с командой в Яндексе в поте лица поднимаем российские клиентские сервисы с помощью ИИ. Чтобы любая ваша проблема решалась быстро, чтобы Такси заказывалось даже в новый год, в Лавке все приезжало вовремя, а водителей и курьеров нанимали еще активней.

За последние полгода доделали платформу для оптимизации сервиса. Делаем автоматические коммуникаций для банков, телекомов, ритейлов и образования. Вышли за границы Яндекса.

Собрались и написали об этом пост, даже не верится.

За лайк - отдельное сердечко.

https://vc.ru/280385

Наверное подписчики заметили, что последние полгода посты выходят реже. Дело в том, что мы с командой в Яндексе в поте лица поднимаем российские клиентские сервисы с помощью ИИ. Чтобы любая ваша проблема решалась быстро, чтобы Такси заказывалось даже в новый год, в Лавке все приезжало вовремя, а водителей и курьеров нанимали еще активней.

За последние полгода доделали платформу для оптимизации сервиса. Делаем автоматические коммуникаций для банков, телекомов, ритейлов и образования. Вышли за границы Яндекса.

Собрались и написали об этом пост, даже не верится.

За лайк - отдельное сердечко.

https://vc.ru/280385

2021 September 25

NFT, музеи и стартапы

В последнее время часто слышу про NFT в новостях о селебрити, искусстве и сфере IT.

А еще прошлой неделе 2 спорт-стартапа в области NFT подняли 900 млн $

Пришло время поделиться.

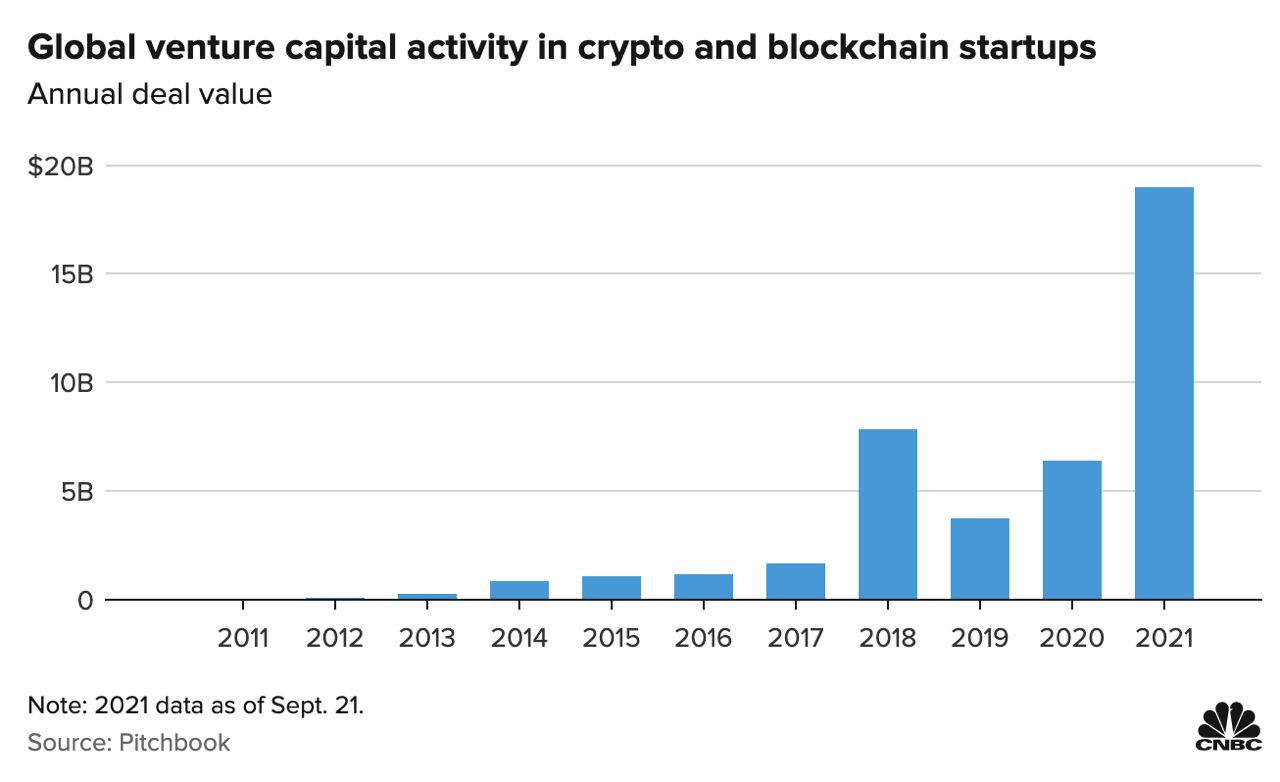

Для скептиков, которые говорят, что хайп на всю эту вашу крипту уже прошел, прикладываю картинку. В 2021 году в крипту вложили больше в три раза, чем в 2020, и в 2.5 раза больше, чем в хайповом 2018. Так что тема актуальней актуальности.

🧐Что такое NFT

NFT - non fungible token. Его, в отличие от биткоина нельзя просто обменять на другой такой же биткоин, поэтому это не валюта.

Когда ты вы закупате NFT на картинку с пингвином, информация о том, что вы — владелец пингвина, записывается в блокчейн Ethereum. По сути это права на цифровой обьект.

Можно продать или купить картинку-видео-музыку за миллионы долларов. Например, в марте 2021 фаундер Твиттера продал свой первый твит за 3 миллиона баксов. Продать и купить NFT можно в маркетплейсах: OpenSea, Rarible или Nifty Gateway, который любит my favorite artist Grimes.

🎮NFT как билет или собственность в игре

Кроме этого можно использовать картинку с NFT в своих продутках без нарушения авторских прав. Есть и еще более прикольные механики. Например использовать NFT в качестве билета: просмотр серивла Stoned cats можно купить за NFT картинки котика.

Сам сериал удивляет киберпанком, который мы заслужили: сюжет рассказывает о бабушке, которая уронила марихуанну в камин, в итоге ее накуренные кошки разговаривают о жизни друг с другом. Кошек озвучивают Виталик Бутерин (создатель крипты Ethereum), Мила Кунис, Эштон Катчер и Джейн Фонда.

Еще можно использовать NFT в играх - покупать и продавать шлемы, медальки, одежду для персонажей. А в игре CryptoKitties перепродают котят.

🖼NFT и Британский музей

Тренд на NFT поддерживают не только гики, но и музейные сотрудники - буквально вчера вышла новость о том, что Британский музей запускает продажи NFT-открыток Хокусая.

NFT в таком случае можно назвать акциями художника - если вы верите, что популярность художника будет только расти, разумно вложить в цифровые права на его произведения. По сути это это способ заработать на своих знаниях об искусстве.

🏀Спорт и NFT

NFT проникает даже в спорт - на прошлой неделе 2 спорт-стартапа в области NFT: Dapper Labs и Sorare подняли 900 млн $.

Платформа NBA Top Shot от Dapper Labs позволяет пользователям торговать и собирать основные моменты баскетбольных матчей в форме NFT. Моменты лицензированы NBA, которая получает гонорары за каждую транзакцию.

В Sorare - игре с виртульными командами футболистов, теперь можно покупать NFT-карточки игроков. Карточки можно перепродавать, а также результаты реальных матчей могут влиять на виртуальную команду и игроков.

👌NFT - интересно

В последнее время часто слышу про NFT в новостях о селебрити, искусстве и сфере IT.

А еще прошлой неделе 2 спорт-стартапа в области NFT подняли 900 млн $

Пришло время поделиться.

Для скептиков, которые говорят, что хайп на всю эту вашу крипту уже прошел, прикладываю картинку. В 2021 году в крипту вложили больше в три раза, чем в 2020, и в 2.5 раза больше, чем в хайповом 2018. Так что тема актуальней актуальности.

🧐Что такое NFT

NFT - non fungible token. Его, в отличие от биткоина нельзя просто обменять на другой такой же биткоин, поэтому это не валюта.

Когда ты вы закупате NFT на картинку с пингвином, информация о том, что вы — владелец пингвина, записывается в блокчейн Ethereum. По сути это права на цифровой обьект.

Можно продать или купить картинку-видео-музыку за миллионы долларов. Например, в марте 2021 фаундер Твиттера продал свой первый твит за 3 миллиона баксов. Продать и купить NFT можно в маркетплейсах: OpenSea, Rarible или Nifty Gateway, который любит my favorite artist Grimes.

🎮NFT как билет или собственность в игре

Кроме этого можно использовать картинку с NFT в своих продутках без нарушения авторских прав. Есть и еще более прикольные механики. Например использовать NFT в качестве билета: просмотр серивла Stoned cats можно купить за NFT картинки котика.

Сам сериал удивляет киберпанком, который мы заслужили: сюжет рассказывает о бабушке, которая уронила марихуанну в камин, в итоге ее накуренные кошки разговаривают о жизни друг с другом. Кошек озвучивают Виталик Бутерин (создатель крипты Ethereum), Мила Кунис, Эштон Катчер и Джейн Фонда.

Еще можно использовать NFT в играх - покупать и продавать шлемы, медальки, одежду для персонажей. А в игре CryptoKitties перепродают котят.

🖼NFT и Британский музей

Тренд на NFT поддерживают не только гики, но и музейные сотрудники - буквально вчера вышла новость о том, что Британский музей запускает продажи NFT-открыток Хокусая.

NFT в таком случае можно назвать акциями художника - если вы верите, что популярность художника будет только расти, разумно вложить в цифровые права на его произведения. По сути это это способ заработать на своих знаниях об искусстве.

🏀Спорт и NFT

NFT проникает даже в спорт - на прошлой неделе 2 спорт-стартапа в области NFT: Dapper Labs и Sorare подняли 900 млн $.

Платформа NBA Top Shot от Dapper Labs позволяет пользователям торговать и собирать основные моменты баскетбольных матчей в форме NFT. Моменты лицензированы NBA, которая получает гонорары за каждую транзакцию.

В Sorare - игре с виртульными командами футболистов, теперь можно покупать NFT-карточки игроков. Карточки можно перепродавать, а также результаты реальных матчей могут влиять на виртуальную команду и игроков.

👌NFT - интересно

2021 November 27

💻Зачем покупать цифровую недвижимость за 5 млн долларов, и причем тут фейсбук

Вчера утром инвесторы купили кусок виртуальной земли на платформе метавселленной Axie Infinity за 550 эфиров (2.3 млн долларов).

Чуть раньше на этой неделе был куплен цифровой участок земли в другой вселенной Decentralized за 2.4 миллиона долларов.

Сделки побили прошлые рекорды по покупке цифровой недвижимости в 2 раза.

Ниже расскажу, что люди делают на платформе Axie Infinity, почему кому-то нужно покупать цифровую землю, почему это важно, что за метавселенная Axie и причем тут фейсбук.

🦄Что люди делют на платформах метавселенных на примере Axie Infinity?

Axie Infinity от вьетнамской студии Sky Mavis — одна из самых популярных блокчейн-игр. В cентябре 2021 года объём торговых операций в ней превысил $2 млрд.

В этой игре люди покупают и управляют персонажами, похожими на покемонов. Игровые предметы и персонажи - это NFT, покупаются за криптовалюту. Их можно перепродавать. Они являются уникальными. Люди покупают не просто предметы - они покупают токены игры, и таким образом права владения на часть игры.

В игре Axie Infinity можно сражаться с другими игроками, проходить задания и получать за это валюту игры - SLP (Sweet Love Potion), которую можно обменивать на реальные деньги. Многие люди в развивающихся странах зарабатывают в этой игре себе на жизнь и бросают работу.

На Филиппинах валюту SLP уже принимают в магазинах. Власти задумываются о регулировании.

🌎Зачем покупать там цифровую землю?

Очень просто - ее можно сдавать в аренду, строить на ней обьекты, с помощью которых можн зарабатывать валюту. Если мы верим в рост игры и оборотов в ней - вложиться в недвижимсть там очень логично, и с большой вероятность помогает заработать денег.

💶 Причем тут фейсбук

В публичном поле понятие метавселенная сейчас ассоциируется с ребрендингом Фейсбук от Цукерберга - хотя метавселенные Decentralized и Axie Infinity появились заметно раньше. (Примерно месяц назад Марк Цукерберг заанонсировал новый вектор компании — на метавселенную и ребрендинг — теперь группа компаний Facebook (+ Инстаграмм+ ещё куча стартапов) называется Meta.)

Facebook технологическими фантазиями пошел дальше Axie Infinity - подразумевается, что в действительно продвинутую метавселенную, которая создасться Facebook, люди будут заходить в VR и AR очках.

Уже сейчас в подразделит Фейсбука Real labs, которое занимается vr и метавселенными, работе 10 тысяч человек и ближайшее время планирует нанять в 2 раза больше. Мета хочет проинвестировать 10 млрд долларов в развитие VR и AR технологий, сделать вселенную, где люди смогут получать образвание, строить бизнес и общаться, не покидая квартиру.

Многие думают, что Цукерберг делает ребрендинг, чтобы привлечь молодую аудиторию и хайпа к компании, которая все меньше воcпринимает стареющий Фейсбук и Инстаграмм, отвязаться от сторов гугла и апла, отойти от пристального внимания регуляторов, которые пока не смотрят в сторону vr. Есть сомнения, что компания, основная сильная сторона которой заключается в копировании чужих фич и поглощении других компаний, может построить метавселенную, продуктово более крутую, чем текущие Axie и Deceentralized, в которой все захотят сидеть.

И несмотря на то, что вокруг мотивов Марка и способностей компании сделать заявленное, много оправданного скепсиса, это значит что инвестиции в компании, которые занимаются метавселенными, вырастут. А значит новостей про покупку недвижимости в виртуальном мире должно становиться больше.

🖤Что в итоге

Метавселенные и инвестиции туда - горячая и интересная тема, которая дальше будет только подогреваться. А что бы купил ты - реальную квартиру или кусок земли в игре?

Вчера утром инвесторы купили кусок виртуальной земли на платформе метавселленной Axie Infinity за 550 эфиров (2.3 млн долларов).

Чуть раньше на этой неделе был куплен цифровой участок земли в другой вселенной Decentralized за 2.4 миллиона долларов.

Сделки побили прошлые рекорды по покупке цифровой недвижимости в 2 раза.

Ниже расскажу, что люди делают на платформе Axie Infinity, почему кому-то нужно покупать цифровую землю, почему это важно, что за метавселенная Axie и причем тут фейсбук.

🦄Что люди делют на платформах метавселенных на примере Axie Infinity?

Axie Infinity от вьетнамской студии Sky Mavis — одна из самых популярных блокчейн-игр. В cентябре 2021 года объём торговых операций в ней превысил $2 млрд.

В этой игре люди покупают и управляют персонажами, похожими на покемонов. Игровые предметы и персонажи - это NFT, покупаются за криптовалюту. Их можно перепродавать. Они являются уникальными. Люди покупают не просто предметы - они покупают токены игры, и таким образом права владения на часть игры.

В игре Axie Infinity можно сражаться с другими игроками, проходить задания и получать за это валюту игры - SLP (Sweet Love Potion), которую можно обменивать на реальные деньги. Многие люди в развивающихся странах зарабатывают в этой игре себе на жизнь и бросают работу.

На Филиппинах валюту SLP уже принимают в магазинах. Власти задумываются о регулировании.

🌎Зачем покупать там цифровую землю?

Очень просто - ее можно сдавать в аренду, строить на ней обьекты, с помощью которых можн зарабатывать валюту. Если мы верим в рост игры и оборотов в ней - вложиться в недвижимсть там очень логично, и с большой вероятность помогает заработать денег.

💶 Причем тут фейсбук

В публичном поле понятие метавселенная сейчас ассоциируется с ребрендингом Фейсбук от Цукерберга - хотя метавселенные Decentralized и Axie Infinity появились заметно раньше. (Примерно месяц назад Марк Цукерберг заанонсировал новый вектор компании — на метавселенную и ребрендинг — теперь группа компаний Facebook (+ Инстаграмм+ ещё куча стартапов) называется Meta.)

Facebook технологическими фантазиями пошел дальше Axie Infinity - подразумевается, что в действительно продвинутую метавселенную, которая создасться Facebook, люди будут заходить в VR и AR очках.

Уже сейчас в подразделит Фейсбука Real labs, которое занимается vr и метавселенными, работе 10 тысяч человек и ближайшее время планирует нанять в 2 раза больше. Мета хочет проинвестировать 10 млрд долларов в развитие VR и AR технологий, сделать вселенную, где люди смогут получать образвание, строить бизнес и общаться, не покидая квартиру.

Многие думают, что Цукерберг делает ребрендинг, чтобы привлечь молодую аудиторию и хайпа к компании, которая все меньше воcпринимает стареющий Фейсбук и Инстаграмм, отвязаться от сторов гугла и апла, отойти от пристального внимания регуляторов, которые пока не смотрят в сторону vr. Есть сомнения, что компания, основная сильная сторона которой заключается в копировании чужих фич и поглощении других компаний, может построить метавселенную, продуктово более крутую, чем текущие Axie и Deceentralized, в которой все захотят сидеть.

И несмотря на то, что вокруг мотивов Марка и способностей компании сделать заявленное, много оправданного скепсиса, это значит что инвестиции в компании, которые занимаются метавселенными, вырастут. А значит новостей про покупку недвижимости в виртуальном мире должно становиться больше.

🖤Что в итоге

Метавселенные и инвестиции туда - горячая и интересная тема, которая дальше будет только подогреваться. А что бы купил ты - реальную квартиру или кусок земли в игре?

2022 January 08

🦕Кто и почему делает стартап на свои деньги?

Почти каждый день читаю новость о том, как кто-то привлек много денег в свой стартап. Инвестируют в продукты с готовым mvp, а иногда просто в идею. Недавно видела, как стартап, делающий яйцеклетки из клеток кожи, привлек инвестиции. Звучит космически. При более внимательном прочтении можно заметить, что у стартапа единственный сотрудник — PhD студент, а продукт представляет собой простенький сайт, на котором вместе с идеей стартапа хранятся домашки по коду на python.

Какое-то время назад мне, как корпоративному предпринимателю, стало очень интересно — бывает ли такое что люди делают что-то за свои деньги? И если да, то зачем, если можно взять инвестиции под сайт с описанием выдуманной прорывной технологии?

Ниже расскажу аггрегированную мотивацию не привлекать инвестиции, и приведу примеры успешных компаний.

Что-то на основе статей, что-то из личных разговоров со знакомыми основателями.

*Кстати, у стартапа, который делается на свои деньги, даже есть специальное название — bootstraping, дальше буду использовать его.

💶 Стартап на свои деньги — мотивация, плюсы и минусы

Так зачем люди делают компанию за свои деньги, когда инвестиции можно получить за идею? Во-первых, даже несмотря на кейсы привлечения денег студентами за идею, инвестиции дают не всем. Во-вторых, вместе с инвестициями приходят третьи люди, которые контролируют деятельность компании - перед ними надо отчитываться и согласовывать решения. В-третьих, если дела у компании пойдут хорошо, то вероятность, что изначальные фаундеры продолжат руководить компанией на горизонте 10 лет в сллучае привлечения инвестиций на начальной стадии, равна примерно нулю. Плюс, создание такой компании - очень крутой опыт, который учит делать только то, что действительно нужно (потому что денег нет). Плюс всегда можно привлечь большие инвестиции с лучшими условиями на более поздней стадии.

Минусы - нет денег на масштабный маркетинг, прибыль стоит показывать за год-два. Нет денег на найм дорогих специалистов, их нужно завлекать как-нибудь еще или выполнять их функции самостоятельно. К этому списку добавляются постоянные нервы, потраченные на проект, риск потерять все вложенные деньги.

🎉 Примеры успешных bootstrap компаний

К успешным компаниям, которые долгое время не привлекали инвестиции, относятся такие ребята, как например Apple и Microsoft. Нельзя делать вывод, что корпорации делаются только бутстрепом. Есть связь со временем - раньше конкуренции за информационное пространство было меньше, без инвестиций сделать бизнес было проще, а чтобы стать корпорацией нужно время.

Есть примеры и менее больших, но очень влиятельных компаний:

- GoPro была сделана 26-летним предпринимателем, который пошел серфить и не нашел удобнуую камеру, чтобы это запечатлеть. В 2014 году GoPro вышла на IPO со стоимостью 2,96 миллиарда долларов

- Github изначально был придуман тремя программистами как petproject, запускался и развивался без внешних вложений. По состоянию на ноябрь 2021 года более 73 миллионов разработчиков по всему миру используют платформу. В октябре 2018 года Microsoft заплатила за приобретение GitHub 7,5 миллиарда долларов.

- Игровая студия, которая придумала Minecraft - еще один пример такой компании. Они были основаны в 2010 году и базируются в Стокгольме. В 2014 году они были приобретены Microsoft за 2,1 миллиарда евро. До того, как их приобрели, они не привлекали инвестиций.

- Mailchimp - сервис, с которого вам вероятно отсылают письма разные компании, сделал выручку $700 M на 100% принадлежит основателю.

🥂 Что в итоге

Сделать компании за свои деньги - надежный вариант, чтобы в случае успеха через 10 лет сохранить контроль над происходящим с компанией, и заработать много денег. Мои знакомые и предприниматели и люди из интернета говорят, что о такие вещи нервно изматывают и требуют большего числа времени и скиллов. В то же время, жестче прокачивают эти скиллы. Круто что в обоих вариантах есть успешные примеры.

Почти каждый день читаю новость о том, как кто-то привлек много денег в свой стартап. Инвестируют в продукты с готовым mvp, а иногда просто в идею. Недавно видела, как стартап, делающий яйцеклетки из клеток кожи, привлек инвестиции. Звучит космически. При более внимательном прочтении можно заметить, что у стартапа единственный сотрудник — PhD студент, а продукт представляет собой простенький сайт, на котором вместе с идеей стартапа хранятся домашки по коду на python.

Какое-то время назад мне, как корпоративному предпринимателю, стало очень интересно — бывает ли такое что люди делают что-то за свои деньги? И если да, то зачем, если можно взять инвестиции под сайт с описанием выдуманной прорывной технологии?

Ниже расскажу аггрегированную мотивацию не привлекать инвестиции, и приведу примеры успешных компаний.

Что-то на основе статей, что-то из личных разговоров со знакомыми основателями.

*Кстати, у стартапа, который делается на свои деньги, даже есть специальное название — bootstraping, дальше буду использовать его.

💶 Стартап на свои деньги — мотивация, плюсы и минусы

Так зачем люди делают компанию за свои деньги, когда инвестиции можно получить за идею? Во-первых, даже несмотря на кейсы привлечения денег студентами за идею, инвестиции дают не всем. Во-вторых, вместе с инвестициями приходят третьи люди, которые контролируют деятельность компании - перед ними надо отчитываться и согласовывать решения. В-третьих, если дела у компании пойдут хорошо, то вероятность, что изначальные фаундеры продолжат руководить компанией на горизонте 10 лет в сллучае привлечения инвестиций на начальной стадии, равна примерно нулю. Плюс, создание такой компании - очень крутой опыт, который учит делать только то, что действительно нужно (потому что денег нет). Плюс всегда можно привлечь большие инвестиции с лучшими условиями на более поздней стадии.

Минусы - нет денег на масштабный маркетинг, прибыль стоит показывать за год-два. Нет денег на найм дорогих специалистов, их нужно завлекать как-нибудь еще или выполнять их функции самостоятельно. К этому списку добавляются постоянные нервы, потраченные на проект, риск потерять все вложенные деньги.

🎉 Примеры успешных bootstrap компаний

К успешным компаниям, которые долгое время не привлекали инвестиции, относятся такие ребята, как например Apple и Microsoft. Нельзя делать вывод, что корпорации делаются только бутстрепом. Есть связь со временем - раньше конкуренции за информационное пространство было меньше, без инвестиций сделать бизнес было проще, а чтобы стать корпорацией нужно время.

Есть примеры и менее больших, но очень влиятельных компаний:

- GoPro была сделана 26-летним предпринимателем, который пошел серфить и не нашел удобнуую камеру, чтобы это запечатлеть. В 2014 году GoPro вышла на IPO со стоимостью 2,96 миллиарда долларов

- Github изначально был придуман тремя программистами как petproject, запускался и развивался без внешних вложений. По состоянию на ноябрь 2021 года более 73 миллионов разработчиков по всему миру используют платформу. В октябре 2018 года Microsoft заплатила за приобретение GitHub 7,5 миллиарда долларов.

- Игровая студия, которая придумала Minecraft - еще один пример такой компании. Они были основаны в 2010 году и базируются в Стокгольме. В 2014 году они были приобретены Microsoft за 2,1 миллиарда евро. До того, как их приобрели, они не привлекали инвестиций.

- Mailchimp - сервис, с которого вам вероятно отсылают письма разные компании, сделал выручку $700 M на 100% принадлежит основателю.

🥂 Что в итоге

Сделать компании за свои деньги - надежный вариант, чтобы в случае успеха через 10 лет сохранить контроль над происходящим с компанией, и заработать много денег. Мои знакомые и предприниматели и люди из интернета говорят, что о такие вещи нервно изматывают и требуют большего числа времени и скиллов. В то же время, жестче прокачивают эти скиллы. Круто что в обоих вариантах есть успешные примеры.