B[

Чем можно эффективно перенести большое количество (1-1.5ТБ) относительно небольших файликов между двумя серваками под CentOS 8?

Сейчас юзается

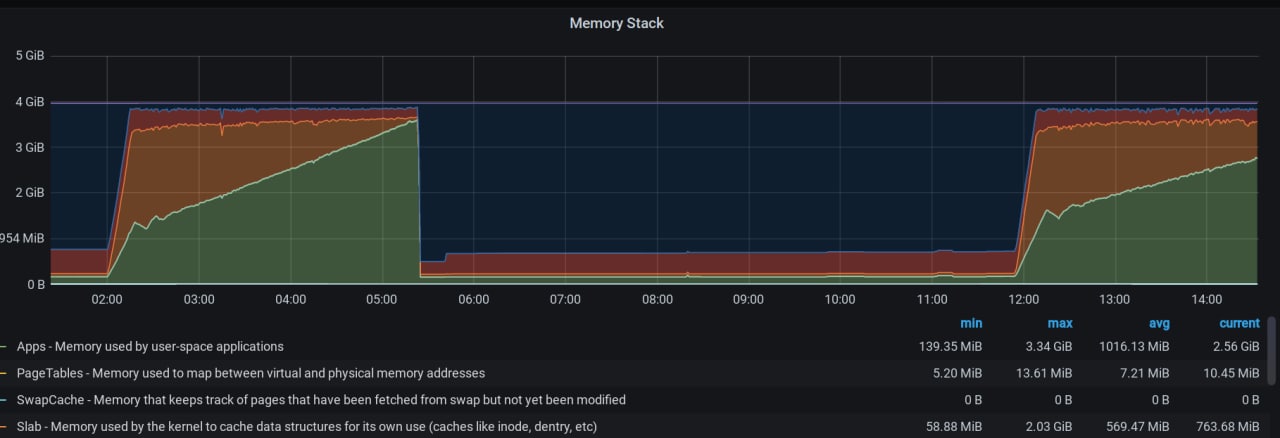

rsync --archive --verbose --compress --delete -e "ssh -p 1234" <server> <localdir> Но, оно медленное и на одном из серверов иногда вылетает с out of memory.