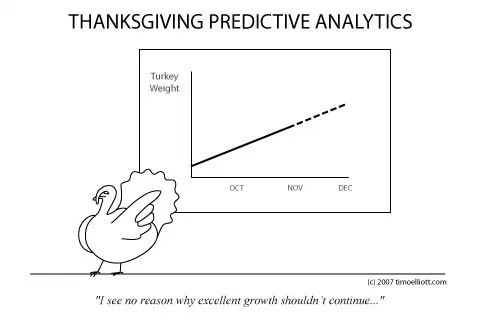

#startupanalytcs Часть 2

3️⃣ (20-50 сотрудников): обычно данный этап наступает после 2х лет тяжелой работы. Также у вас появляются инвесторы и появляются дополнительные деньги на развитие. Сейчас самое время, использовать качественные решения для аналитики и создания решения DW/ETL/BI и нанять на работу профессионала в этой области.

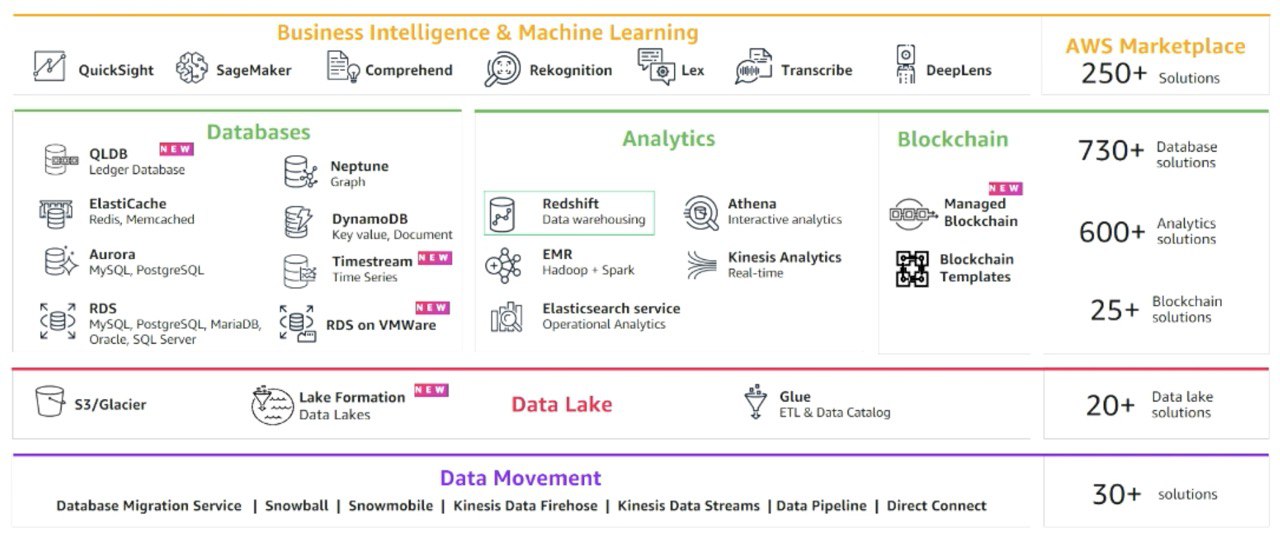

🧰Инструменты: Облачные решения идеальный вариант (Snowflake, Redshift, Big Query, Azure Cloud, Tableau, Power BI, Looker и тп). Облако дает нам несколько преимуществ: скорость развертывания, гибкая цена, мы платим только за то, что используем и простота масштабирования. Вам необходимо нанять человека или консультанта, который сможет быстро создать такое решение.

❌Чего не делать: еще рано использовать Machine Learning (если это не основа вашего продукта), не тратьте время на скрипты для ETL, используйте готовые решения (Pentaho DI, Talend, Azure Data Factory, AWS Glue и тп). Не используйте Enterprise BI (SAP BO, MicroStrategy, IBM, Oracle) они дорогие и не гибкие. Не используйте open source базы данных Postgres/MySQL, они плохо масштабируются и не подходят в качестве аналитической БД.

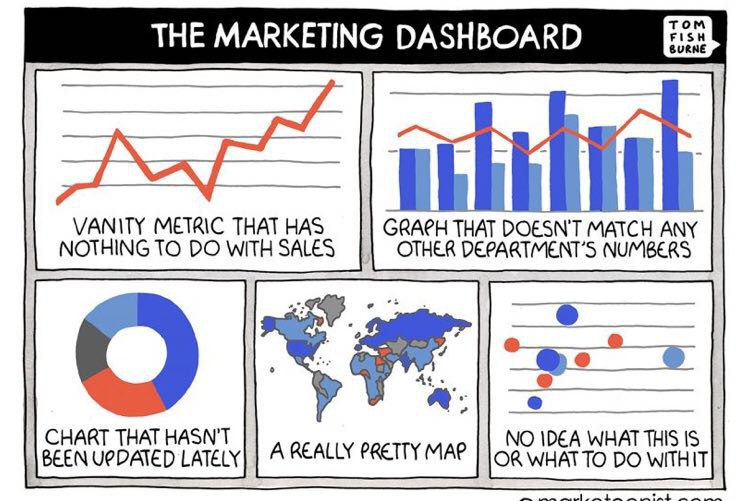

4️⃣(50-150): Эта фаза считается самой сложной. У вас все еще не очень большая команда и недостаточно ресурсов. Но есть потребность у бизнеса в качественной аналитике. На данном этапе аналитика должна помогать управлять бизнесом и добавлять ценность как никогда ранее. Необходимо задуматься о создании модели данных, чтобы лучше трансформировать бизнес логику в данные. Модель нужна, чтобы синхронизировать бизнес пользователей и создать так называемый Single Point of Truth (единую точку правды), иначе каждый департаменты будем иметь свою прибыль. Необходимо развивать свою команду аналитики и расширять штат, основные скилы это SQL, BI, ETL. Также вы начинает использовать статистику и data mining, например для бюджетирования или строите модель оттока. Ну и, конечно, стоит пересмотреть подход с атрибуцией.

🧰Инструменты: DBT, Erwin, Mysql Workbench, все они позволяет рисовать модель данных, она должна отражать бизнес-процессы и все необходимые показатели. Необходимо использовать версионность (Git, SVN). Возможно стоит подумать и переходе на GA Premium или использовать любую другую система аналитики, в которой нет ограничений и которые не забирает ваши данные. Например, Snowplow, Tealium. Стоит добавить в арсенал Jupyter Notebook или Rstudio.

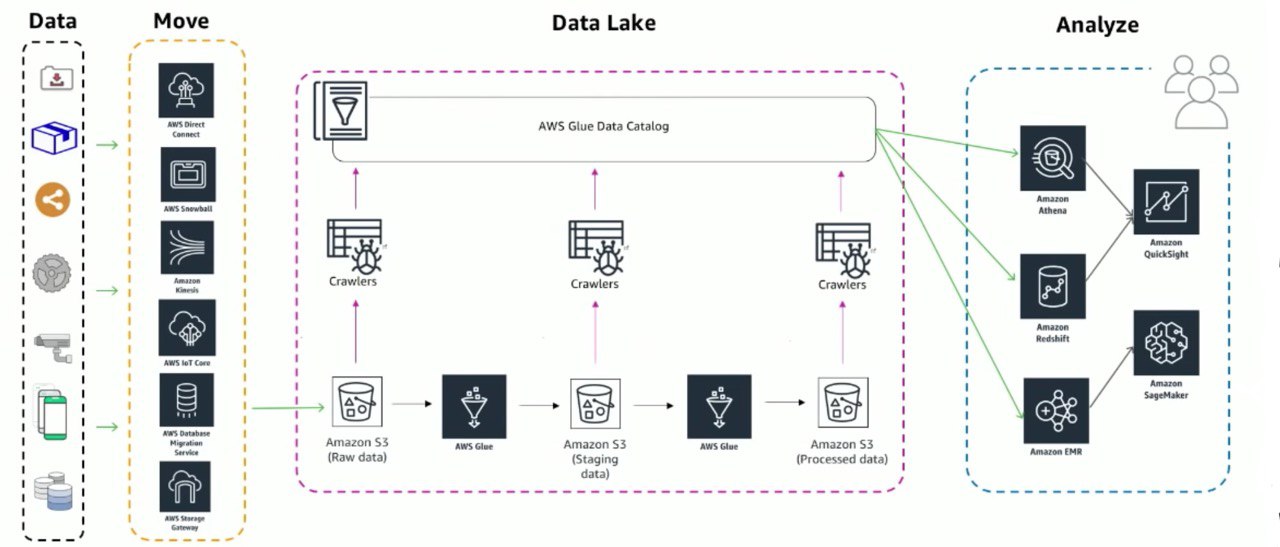

❌Чего не делать: вы все еще может обойтись относительно недорогими решениями или open source, нет смысла «стрелять из пушки по воробьям». Big Data решения (Hadoop, Spark, Data Lake, Real time streaming) пока еще подождут.

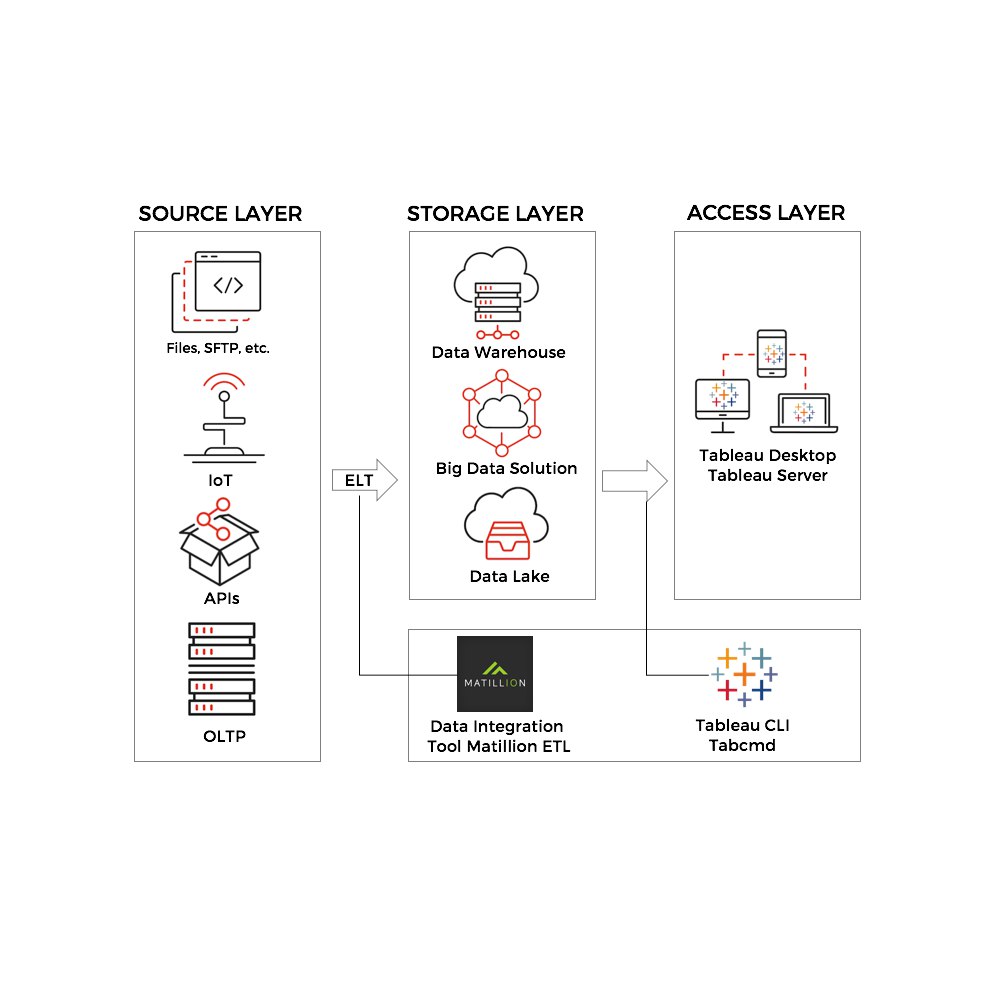

5️⃣ (150-500 сотрудников): на данном этапе мы должны создавать аналитическое решение, которое может быть легко масштабируемо. Обычно на 150 сотрудников, BI команда состоит из 3-6 человек, при 500 сотрудниках, команда вырастает до 30 человек. Очень важно управлять ростом, иначе производительность команды при ее росте будет падать (я прошел через такой рост, и наблюдал это). Необходимо задуматься о качестве данных (QA), о управление данными и их безопасности. Например, работая в lamoda, все имели доступ к клиентской базе (3млн+ клиентов) и этот доступ никак не отслеживался. Для повышения надежности решения аналитики, необходимо делать ревью всех изменений (BI, DW, ETL). Очень важно наладить процесс документации и тренингов, и процесс передачи знаний. Никто из команды не должен быть узким местом. Так же у вас есть выбор в метода организации аналитики. Например, может быть отдельная BI команда, а могут быть распределенные ресурсы, которые обслуживают свою команду (BI Champions)

🧰Инструменту: Аналитическое хранилище данных (Redshift, Big Query, Azure, Snowflake), надежное решение ETL, BI (Tableau, Looker), решения Big Data (Hadoop, Spark), решения Machine Learning. В принципе можно посмотреть Gartner или Forrestert и использовать решения лидеры.

❌Чего не делать: никаких поблажек, аналитика на данном уровне занятие не простое и требует хороших скилов и опыта. Необходимо четко следовать правилам (QA, code review, data governance, documentation и тп)